深度学习(一):引言(结合花书,吴恩达课程总结)

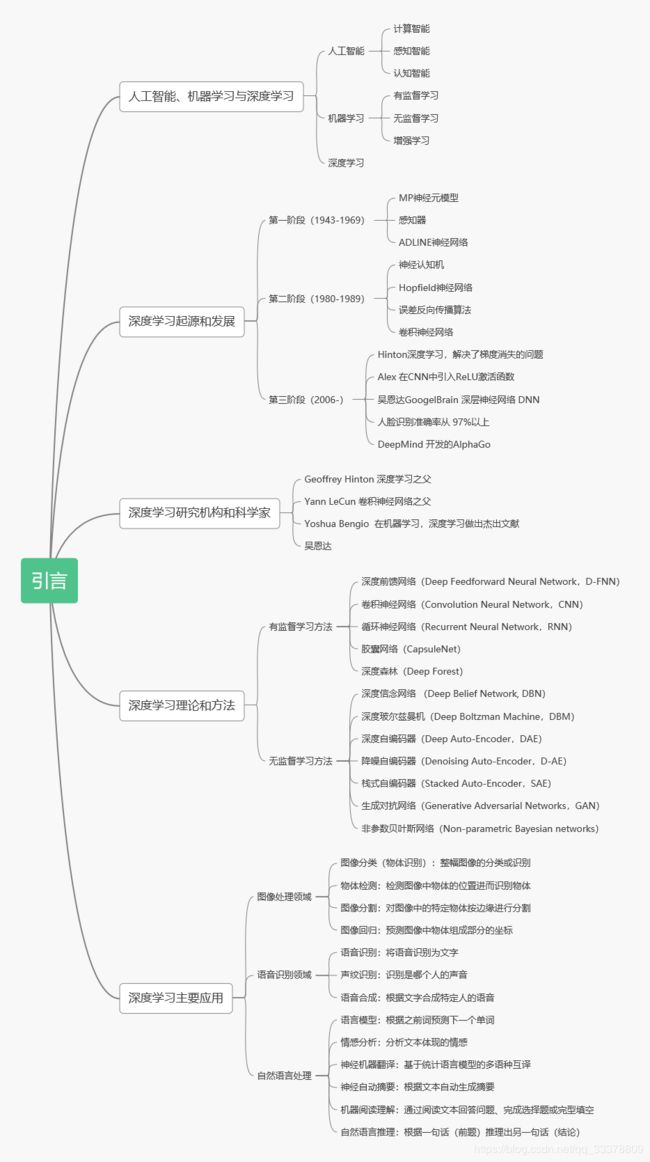

深度系列主要为 我在国科大研一期间,在《深度学习》课程中所学知识概述,根据PPT制作思维导图。

补充内容来源:深度学习(花书),吴恩达深度学习课程

-------------------------------------------------------------------------------------------------------------------------------------------------------------------

创造人工智能自古以来就是人类的梦想。

可形式化描述:对人类来说难,对机器来说简单(IBM的深蓝国际象棋系统)

难形式化描述:对人类来说简单,对机器来说难(图像识别,语音识别等)

1.形式化的语言进行硬编码,人工智能的知识库方法,无法取得巨大成功

2.自己获取知识的能力(机器学习)——>依赖于数据的表示——>设计特征

3.机器自己发掘数据的表示(表示学习)——>自编码器——>用于学习特征的算法

设计特征或设计用于学习特征的算法时的目的是分离出能够解释观察数据的变差因素(factors of variation)(高层次,抽象的特征,不能被直接观察到)

4.深度学习:简单的表示来表示复杂的结构——>前馈深度网络或多层感知机。

让计算机从经验中学习,并根据层次化的概念体系来理解世界。

将大千世界表示为嵌套的层次概念体系(由较简单的概念间的联系定义复杂概念,从一般抽象概括到高级抽象表示)。

两种度量模型深度的方法,①计算图的深度,基于评估框架所需执行的顺序指令的数据。②概率模型图的深度,将描述概念彼此如何关联的图的深度视为模型深度

1.1 本书面向的读者

1.2 深度学习的历史趋势

1.2.1 神经网络的众多名称和命运变迁

深度学习有着悠久而丰富的历史,但随着许多不同哲学观点的渐渐消逝,与之对应的名称也渐渐尘封。

【控制论】生物学历理论的发展(MP神经元)和第一个模型的实现(感知机)

从神经科学的角度除法的简单线性模型

1.MP神经元:模型的权重由操作人员设定

2.感知器:第一个能根据每个类别的输入样本来学习权重的模型

3.自适应线性单元(adaptive linear element, ADALINE): 随机梯度下降训练权重

局限:无法学习异或函数(线性不可分)

现在,神经科学被视为深度学习研究的一个重要灵感来源,但它已不再是该领域的主要指导。

灵感1:依靠单一深度学习算法可解决许多不同任务

灵感2:通过计算单元之间的相互作用而变得智能

从应用数学(线性代数、概率论、信息论、数值优化)等领域获得更多的灵感

【联结主义】反向传播训练具有一两个隐藏层的神经网络

联结主义的核心思想是,当网络将大量简单的计算单元连接在一起时可以实现智能行为。

1.分布式表示:系统的每一个输入都应该由多个特征表示,并且每一个特征都应该参与参与到多个可能输入的表示。(本书核心)

2.反向传播算法:训练具有内部表示的深度神经网络中的成功和算法的普及

3.长短时记忆LSTM网络:序列建模方面的重要进展

衰退原因:①创业公司野心勃勃不切实际,投资者失望。②核方法,图模型取得很好的效果。③计算代价高,当时的硬件难以满足要求。

【深度学习】2006年开始

“深度信念网络”的神经网络可以使用一种称为“贪婪逐层预训练”的策略来有效的训练。同样的策略可以被用来训练许多其他类型的深度网络,并能系统地帮助提高泛化能力。

1.2.2 与日俱增的数据量

随着可用的训练数据量不断增加,深度学习变得更加有用。

1.2.3 与日俱增的模型规模

随着时间的推移,针对深度学习的计算机软硬件基础设施都有所改善,深度学习模型的规模也随之增长。

1.2.4 与日俱增的精度、复杂度和对现实世界的冲击

随着时间的推移,深度学习已经解决日益复杂的应用,并且精度不断提高。

问题:问什么深度学习会兴起?

与日俱增的的数据量:训练集较小时,各种机器学习算法性能排名不一定;当训练集较大时,深度学习稳定领先于其他机器学习方法。

计算能力的提升:随着计算能力的提升,可以训练更深,更复杂的网络,拥有更好的性能。

算法的创新:算法创新更多也是为了加快网络训练的速度。训练网络参数时间减少,则可设计训练更大的网络,可在合理的时间内完成计算,提高实验速度以更好的获得更适合数据的网络结构。