Windows单机jdk + scala + spark + hadoop + pycharm开发环境的搭建

安装步骤

折腾好久,主要是网上教程太散了有的地方还没说全

版本

jdk 1.8

scala 2.10.7

spark 1.6.0(依赖hadoop 2.6)

hadoop 2.6.5

spark 1.6还是比较稳定好用的,下载链接自己找

放一下hadoop相关的链接吧链接: https://pan.baidu.com/s/1IU0GDJtvo70rwm7srRmr9A 提取码: 9c68 这是不知道转发哪位网友的。这里面的hadoop是完全配制好的

Jdk

这个就安装完配置环境变量

系统变量

新建JAVA_HOME C:\PROGRA~1\Java\jdk1.8.0_181

新建CLASSPATH .;%JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar

编辑Path 末尾加入 ;%JAVA_HOME%\bin;%JAVA_HOME%\jre\bin

完了之后在cmd 里用 java -version javac -version试试

Scala

这个就安装完配置环境变量

系统变量,看你自己装在哪了

新建SCALA_HOME C:\Program Files (x86)\scala

编辑Path 末尾加入 ;%SCALA_HOME%\bin;%SCALA_HOME%\jre\bin

完了之后在cmd 里用 scala试试

Hadoop

上面的网盘里的下载解压就可以了,如果网盘失效自己去找找怎么配置hadoop文件吧,不难

我这有个hadoop windows工具类链接http://download.csdn.net/detail/wuxun1997/9841472 但是是hadoop 2.7的

网盘里的hadoop解压后在C盘新建tmp文件夹 ,tmp里新建hive文件夹

系统变量,看你自己装在哪了

新建HADOOP_HOME D:\hadoop-2.6.5

编辑Path 末尾加入 ;%HADOOP_HOME%\bin

用管理员身份运行cmd %HADOOP_HOME%\bin\winutils.exe chmod 777 \tmp\hive

%HADOOP_HOME%就是你的安装目录你可以替换

完了之后在%HADOOP_HOME%\sbin 目录里安装shift+鼠标右键,在此处打开cmd,执行 start-all.cmd ,jps命令看看效果,stop-all.cmd结束

Spark

下载解压之后(spark和hadoop随便找个盘放就可以)

系统变量,看你自己装在哪了

新建SPARK_HOME D:\spark-1.6.0-bin-hadoop2.6

编辑Path 末尾加入 ;%SPARK_HOME%\bin

完了之后在cmd 里用 spark-shell试试,应该是没异常

Pycharm

先把spark里自带的pyspark 和 py4j(这个需要解压)放到你的python的site-packages里

我的目录是下面的,你对着找你的

D:\soft\spark-1.6.0-bin-hadoop2.6\python (pyspark在这里)

D:\soft\spark-1.6.0-bin-hadoop2.6\python\lib (py4j压缩包在这里)

C:\Program Files\Python35\Lib\site-packages

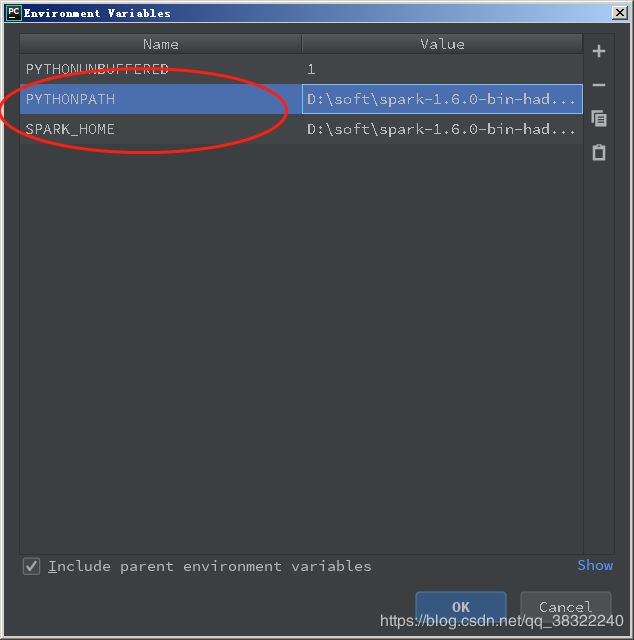

然后你打开pycharm,配置一下Configurations

然后你就编辑Environment variables那个值,新建一个PYTHONPATH 和 SPARK_HOME

我的目录是下面的,你对着找你的

PYTHONPATH D:\soft\spark-1.6.0-bin-hadoop2.6\python

SPARK_HOME D:\soft\spark-1.6.0-bin-hadoop2.6

你也可以在代码里写这些,os那个包

最后

自己网上找个程序跑一下吧,我这个是自己当日记写的,没帮到你也别抱怨。