大数据hadoop 集群搭建(三个节点)

hadoop集群的搭建分为两部分

前提要有--- 》

1. 准备编译好的hadoop-2.6.0-cdh5.14.0 和jdk -8u 144-linux-64

2. 在linux的根目录下创建export目录 ,目录下分别创建两个同等级目录softwares ,servers, softwares 存放文件的压缩包 ,servers 存放解压后的文件

3. 准备好三个节点

第一部分(准备工作,每个节点都要做到任务)

1.关闭防火墙

2.把 /etc/selinux/config 关闭掉

3.改主机名

4.将主机名和ip地址对应上

5.配置jkd 1.8

6.远程免密登录(主节点无密码登录,每个从节点,每个从节点没必要免密登录主节点)

注意:

自做一个局域仓库在主节点,不要再让每个节点配置本地仓库了,让从节点直接访问局域仓库,对文件的下载

第二部分(hadoop搭建)

-

上传Hadoop包上传到 export/softwares 目录下 cd /export/softwares/ 上传密令 rz

-

将上传的hadoop 包解压到 export/servers 目录下 tar -zxvf hadoop-2.6.0-cdh5.14.0.tar.gz -C …/servers/

-

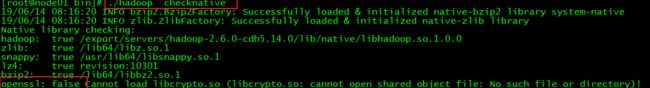

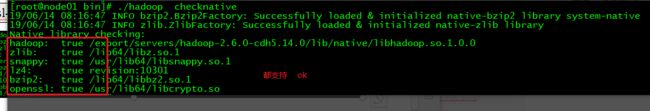

查看本地是否支持hadoop哪些库 进入 bin目录下 cd /export/servers/hadoop-2.6.0-cdh5.14.0

执行 ./hadoop checknative

出现oipenssl 为false 这时需要下载 openssl-devel yum -y install openssl-devel

下载 openssl-devel 后

每个节点都需要下载 yum -y install openssl-devel*** -

修改配置文件

先进入 cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

第一个配置文件 vim core-site.xml

vim core-site.xml

---------------------------------------------------------------------------------

fs.defaultFS

hdfs://node01:8020 //改主机名

hadoop.tmp.dir // 改路径

/export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/tempDatas

io.file.buffer.size

4096

fs.trash.interval

10080

第二个配置文件

vim hdfs-site.xml

vim hdfs-site.xml

---------------------------------------------------------------------------------

dfs.namenode.secondary.http-address

node01:50090 //改主机名

dfs.namenode.http-address

node01:50070 //改主机名

dfs.namenode.name.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/namenodeDatas

dfs.datanode.data.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/datanodeDatas

dfs.namenode.edits.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/edits

dfs.namenode.checkpoint.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/snn/name

dfs.namenode.checkpoint.edits.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/snn/edits

dfs.replication

2

dfs.permissions

false

dfs.blocksize

134217728

第三个配置文件

vim hadoop-env.sh

添加一行代码

export JAVA_HOME=/export/servers/jdk1.8.0_141

第四个配置文件

vim mapred-site.xml

vim mapred-site.xml

-----------------------------------------------------------------------------

mapreduce.framework.name

yarn

mapreduce.job.ubertask.enable

true

mapreduce.jobhistory.address

node01:10020

mapreduce.jobhistory.webapp.address

node01:19888

第五个配置文件

vim slaves (把工作者写入)

管理者也可以作为工作者可以写入

在这里插入代码片

node01

node02

node03

第六个配置文件

vim yarn-site.xml

vim yarn-site.xml

-----------------------------------------------------------------------------

yarn.resourcemanager.hostname

node01

yarn.nodemanager.aux-services

mapreduce_shuffle

- 每个节点都创建这几个目录(存放数据)

在这里插入代码片

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/tempDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/namenodeDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/datanodeDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/edits

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/snn/name

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/snn/edits

- 配置好后进入 cd /export/servers/

把配置好的hadoop进行分发给每个从节点

scp -r hadoop-2.6.0-cdh5.14.0/ node02:$PWD

scp -r hadoop-2.6.0-cdh5.14.0/ node03:$PWD

8.环境变量的配置

在/etc/profile.d/ 创建好一个 hadoop.sh

vim /etc/profile.d/hadoop.sh

在这里插入代码片

export HADOOP_HOME=/export/servers/hadoop-2.6.0-cdh5.14.0

export PATH=:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

hadoop 环境配置好后,分发给每个从节点

scp /etc/profile.d/hadoop.sh node02: /etc/profile.d/hadoop.sh

scp /etc/profile.d/hadoop.sh node03: /etc/profile.d/hadoop.sh

每个节点配置完成后,每个节点都 执行 source /etc/profile

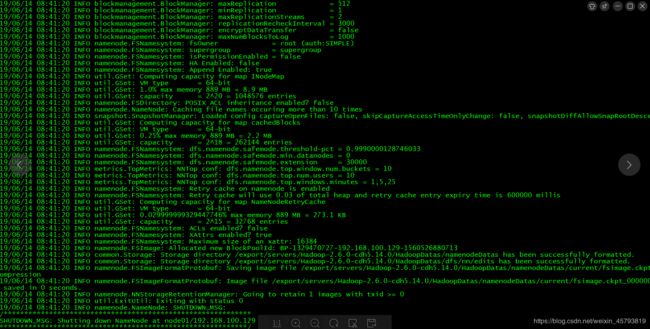

9.进入 cd /export/servers/hadoop-2.6.0-cdh5.14.0/bin 格式化集群

在这里插入代码片

bin/hdfs namenode -format或者bin/Hadoop namenode –format

- 进入到 cd /export/servers/hadoop-2.6.0-cdh5.14.0/

启动集群

sbin/start-dfs.sh

sbin/start-yarn.sh

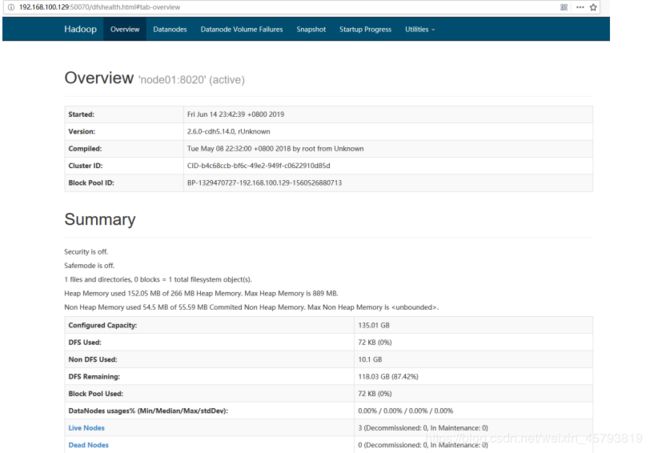

11 .检测是否搭建成功

第一种方式: 主节点的ip + 50070 进入hdfs 的web也面

第二种方式

使用 hadoop密令 创建一个文件 是否成功