Hadoop 优化及新特性

文章目录

- Hadoop 优化及新特性

- 一、Hadoop 数据压缩

- 1.1 概述

- 1.2 MR支持的压缩编码

- 1.3 压缩方式选择

- 1.3.1Gzip压缩

- 1.3.2 Bzip2压缩

- 1.3.3 Lzo压缩

- 1.3.4 Snappy压缩

- 1.4 压缩位置选择

- 1.5 压缩参数配置

- 1.6 压缩实操案例

- 1.6.1 数据流的压缩和解压缩

- 1.6.2 Map输出端采用压缩

Hadoop 优化及新特性

一、Hadoop 数据压缩

1.1 概述

1.2 MR支持的压缩编码

| 压缩格式 | hadoop自带? | 算法 | 文件扩展名 | 是否可切分 | 换成压缩格式后,原来的程序是否需要修改 |

|---|---|---|---|---|---|

| DEFLATE | 是,直接使用 | DEFLATE | .deflate | 否 | 和文本处理一样,不需要修改 |

| Gzip | 是,直接使用 | DEFLATE | .gz | 否 | 和文本处理一样,不需要修改 |

| bzip2 | 是,直接使用 | bzip2 | .bz2 | 是 | 和文本处理一样,不需要修改 |

| LZO | 否,需要安装 | LZO | .lzo | 是 | 需要建索引,还需要指定输入格式 |

| Snappy | 是,直接使用 | Snappy | .snappy | 否 | 和文本处理一样,不需要修改 |

为了支持多种压缩/解压缩算法,Hadoop引入了编码/解码器,如下表所示。

| 压缩格式 | 对应的编码/解码器 |

|---|---|

| DEFLATE | org.apache.hadoop.io.compress.DefaultCodec |

| gzip | org.apache.hadoop.io.compress.GzipCodec |

| bzip2 | org.apache.hadoop.io.compress.BZip2Codec |

| LZO | com.hadoop.compression.lzo.LzopCodec |

| Snappy | org.apache.hadoop.io.compress.SnappyCodec |

压缩性能的比较

| 压缩算法 | 原始文件大小 | 压缩文件大小 | 压缩速度 | 解压速度 |

|---|---|---|---|---|

| gzip | 8.3GB | 1.8GB | 17.5MB/s | 58MB/s |

| bzip2 | 8.3GB | 1.1GB | 2.4MB/s | 9.5MB/s |

| LZO | 8.3GB | 2.9GB | 49.3MB/s | 74.6MB/s |

http://google.github.io/snappy/

Snappy is a compression/decompression library. It does not aim for maximum compression, or compatibility with any other compression library; instead, it aims for very high speeds and reasonable compression. For instance, compared to the fastest mode of zlib, Snappy is an order of magnitude faster for most inputs, but the resulting compressed files are anywhere from 20% to 100% bigger.On a single core of a Core i7 processor in 64-bit mode, Snappy compresses at about 250 MB/sec or more and decompresses at about 500 MB/sec or more.

1.3 压缩方式选择

1.3.1Gzip压缩

1.3.2 Bzip2压缩

1.3.3 Lzo压缩

1.3.4 Snappy压缩

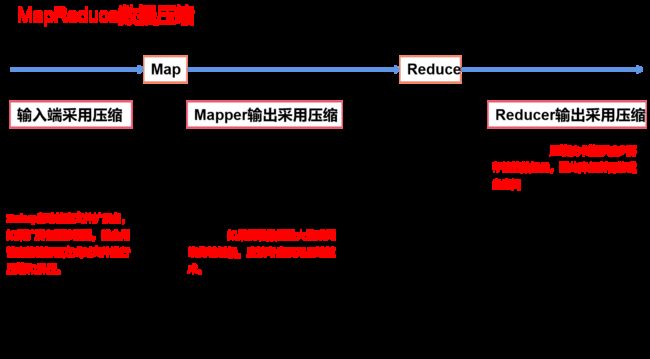

1.4 压缩位置选择

1.5 压缩参数配置

要在Hadoop中启用压缩,可以配置如下参数:

| 参数 | 默认值 | 阶段 | 建议 |

|---|---|---|---|

| io.compression.codecs (在core-site.xml中配置) | 无,这个需要在命令行输入hadoop checknative查看 | 输入压缩 | Hadoop使用文件扩展名判断是否支持某种编解码器 |

| mapreduce.map.output.compress(在mapred-site.xml中配置) | false | mapper输出 | 这个参数设为true启用压缩 |

| mapreduce.map.output.compress.codec(在mapred-site.xml中配置) | org.apache.hadoop.io.compress.DefaultCodec | mapper输出 | 企业多使用LZO或Snappy编解码器在此阶段压缩数据 |

| mapreduce.output.fileoutputformat.compress(在mapred-site.xml中配置) | false | reducer输出 | 这个参数设为true启用压缩 |

| mapreduce.output.fileoutputformat.compress.codec(在mapred-site.xml中配置) | org.apache.hadoop.io.compress. DefaultCodec | reducer输出 | 使用标准工具或者编解码器,如gzip和bzip2 |

| mapreduce.output.fileoutputformat.compress.type(在mapred-site.xml中配置) | RECORD | reducer输出 | SequenceFile输出使用的压缩类型:NONE和BLOCK |

1.6 压缩实操案例

1.6.1 数据流的压缩和解压缩

测试一下如下压缩方式:

| DEFLATE | org.apache.hadoop.io.compress.DefaultCodec |

|---|---|

| gzip | org.apache.hadoop.io.compress.GzipCodec |

| bzip2 | org.apache.hadoop.io.compress.BZip2Codec |

public class TestCompress {

public static void main(String[] args) throws IOException {

compress("D:\\input\\inputcompression\\JaneEyre.txt"

,"org.apache.hadoop.io.compress.BZip2Codec");

//decompress("D:\\input\\inputcompression\\JaneEyre.txt.bz2");

}

//压缩

private static void compress(String filename, String method) throws IOException {

//1 获取输入流

FileInputStream fis = new FileInputStream(new File(filename));

//2 获取输出流

//获取压缩编解码器codec

CompressionCodecFactory factory = new CompressionCodecFactory(new Configuration());

CompressionCodec codec = factory.getCodecByName(method);

//获取普通输出流,文件后面需要加上压缩后缀

FileOutputStream fos = new FileOutputStream(new File(filename + codec.getDefaultExtension()));

//获取压缩输出流,用压缩解码器对fos进行压缩

CompressionOutputStream cos = codec.createOutputStream(fos);

//3 流的对拷

IOUtils.copyBytes(fis,cos,new Configuration());

//4 关闭资源

IOUtils.closeStream(cos);

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

}

//解压缩

private static void decompress(String filename) throws IOException {

//0 校验是否能解压缩

CompressionCodecFactory factory = new CompressionCodecFactory(new Configuration());

CompressionCodec codec = factory.getCodec(new Path(filename));

if (codec == null) {

System.out.println("cannot find codec for file " + filename);

return;

}

//1 获取输入流

FileInputStream fis = new FileInputStream(new File(filename));

CompressionInputStream cis = codec.createInputStream(fis);

//2 获取输出流

FileOutputStream fos = new FileOutputStream(new File(filename + ".decodec"));

//3 流的对拷

IOUtils.copyBytes(cis,fos,new Configuration());

//4 关闭资源

IOUtils.closeStream(fos);

IOUtils.closeStream(cis);

IOUtils.closeStream(fis);

}

}

1.6.2 Map输出端采用压缩

即使你的 MapReduce 的输入输出文件都是未压缩的文件,你仍然可以对Map任务的中间结果输出做压缩,因为它要写在硬盘并且通过网络传输到 Reduce 节点,对其压缩可以提高很多性能,这些工作只要设置两个属性即可,我们来看下代码怎么设置。

1)Hadoop 源码支持的压缩格式有:BZip2Codec 、DefaultCodec

public class WordCountDriver {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

Configuration configuration = new Configuration();

// 开启map端输出压缩

configuration.setBoolean("mapreduce.map.output.compress", true);

// 设置map端输出压缩方式

configuration.setClass("mapreduce.map.output.compress.codec", BZip2Codec.class,CompressionCodec.class);

Job job = Job.getInstance(configuration);

job.setJarByClass(WordCountDriver.class);

job.setMapperClass(WordCountMapper.class);

job.setReducerClass(WordCountReducer.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.setInputPaths(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

boolean result = job.waitForCompletion(true);

System.exit(result ? 1 : 0);

}

}

2)Mapper 保持不变

public class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable>{

Text k = new Text();

IntWritable v = new IntWritable(1);

@Override

protected void map(LongWritable key, Text value, Context context)throws IOException, InterruptedException {

// 1 获取一行

String line = value.toString();

// 2 切割

String[] words = line.split(" ");

// 3 循环写出

for(String word:words){

k.set(word);

context.write(k, v);

}

}

}

3)Reducer保持不变

public class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable>{

IntWritable v = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values,

Context context) throws IOException, InterruptedException {

int sum = 0;

// 1 汇总

for(IntWritable value:values){

sum += value.get();

}

v.set(sum);

// 2 输出

context.write(key, v);

}

}

1.6.3 Reduce输出端采用压缩

基于WordCount案例处理。

1)修改驱动

public class WordCountDriver {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

Configuration configuration = new Configuration();

Job job = Job.getInstance(configuration);

job.setJarByClass(WordCountDriver.class);

job.setMapperClass(WordCountMapper.class);

job.setReducerClass(WordCountReducer.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.setInputPaths(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

// 设置reduce端输出压缩开启

FileOutputFormat.setCompressOutput(job, true);

// 设置压缩的方式

FileOutputFormat.setOutputCompressorClass(job, BZip2Codec.class);

// FileOutputFormat.setOutputCompressorClass(job, GzipCodec.class);

// FileOutputFormat.setOutputCompressorClass(job, DefaultCodec.class);

boolean result = job.waitForCompletion(true);

System.exit(result?1:0);

}

}

2)Mapper和Reducer保持不变(详见1.6.2)