导语 | 大数据及人工智能飞速发展的今天,法律法规和信任问题严重阻碍了企业之间的数据流通,数据孤岛问题像一只无形的手挡在了企业之间,因为缺乏有价值的数据合作,各行业用户获取成本居高不下。为了满足企业间数据安全共享、释放数据价值,助力业务创新,腾讯“神盾-联邦计算”平台应运而生!

面向数据安全与隐私保护的多方计算技术研究最早可追溯到上世纪70年代,而新兴的联邦学习概念在国内从2019年开始蓬勃发展。

“神盾-联邦计算”平台的成型也正是这个时期,经过2-3个月系统评测、安全算法评测及现场答辩,2019年12月“神盾-联邦计算”代表腾讯获得了信通院颁发的基于多方安全计算的数据流通产品证书,全国首批获得该证书的团队只有5家。目前神盾正在主导信通院联邦学习标准制定。

腾讯“神盾-联邦计算”平台应运而生

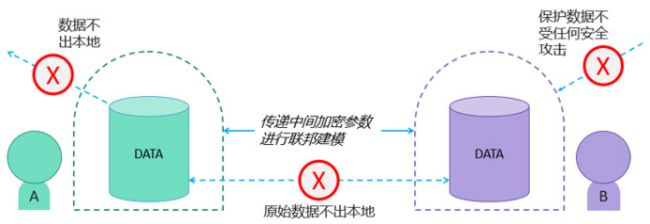

大数据及人工智能飞速发展的今天,法律法规和信任问题严重阻碍了企业之间的数据流通,数据孤岛问题像一只无形的手挡在了企业之间,因为缺乏有价值的数据合作,各行业用户获取成本居高不下,银行信用卡不良用户占比全面上升,金融信贷审核成本陡增,AI发展也遭遇前所未有的瓶颈,为了让这些企业在合法合规、安全、高效无损的基础上进行数据合作,腾讯“神盾-联邦计算”平台应运而生!

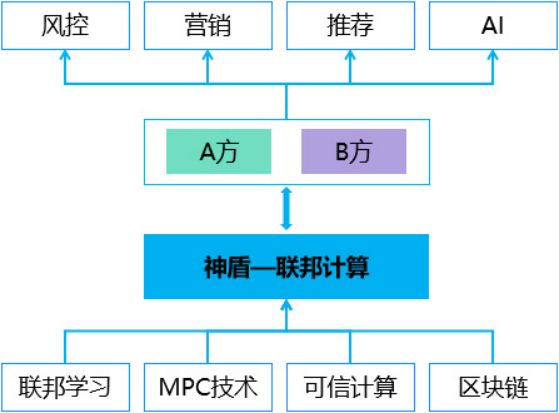

这是一个主要基于联邦学习、多方安全计算(MPC)、区块链、可信计算等安全技术的分布式计算平台,产品针对机器学习算法进行定制化的隐私保护改造,保证数据不出本地即可完成联合建模,最大化各个合作企业的数据价值:

根据合作双方的实际场景需求,其上层可以覆盖风控、营销、推荐、AI等主流业务,同时“神盾-联邦计算”也将扮演业务与数据之间桥梁的角色,撮合有数据需求的业务方和有价值变现的数据方之间展开合作。

产品首先在联合建模的数据格式规范、安全求交、特征工程、算法参数调试等细节进行了细致的打磨,然后在处于联邦底层核心地位的数据安全与隐私保护技术相关领域做了深入的基础研究,取得了多项突破性的成就,处于行业领先地位。

这其中包含非对称联邦概念的首创及落地、安全信息检索方案的首创及落地 ,涵盖同态加密、不经意传输、隐私集合求交在内的多项MPC技术的创新及应用、主流联邦学习协议的效率优化、精度提升及可信中间方的剥离改造、单向联邦网络策略的推进等,下面将简要介绍其中几项重要突破。

首创非对称联邦学习框架

在纵向联邦学习的标准流程中,两个跨特征的参与方需要执行以下两个操作:

1. ID对齐

主要依托隐私求交 [2,3] (Private Set Intersection, PSI) 技术 ,在各参与方处输出所有输入的样本ID集合的交集。

2. 加密模型训练

各参与方以前文提到的输出交集为基础,计算、通信基于原始数据集计算的加密中间变量。

在前沿的联邦学习圈,大量的研究工作投入到加密模型训练中,包括新联邦协议的设计[4]、联邦通信机制的优化[5, 6]、联邦激励系统的设计[7],却鲜有对 ID对齐的系统性研究。

实际的纵向联邦学习的场景中,我们发现,往往其中一方的ID集合较少,并且具有较强的业务属性,是ID拥有方希望保护的信息。但是ID较少的参与方却不得不在ID对齐操作中暴露出这些ID,显得较为“弱势”。

例如,联盟中的信贷公司为了实现风控预测,需要将其客户的违约记录输入联邦学习系统中,而每一条这种违约记录的获取都是该类公司以巨额的经济损失作为交换,属于最高等级的商业机密。

为了解决这个问题,将ID、特征、标签三要素的全方位隐私保护放在产品第一要位,彻底解除高敏感领域的数据安全担忧,我们在联邦学习领域首创非对称联邦学习概念,首度发明Asymmetrical-PSI、Genuine-with-Dummy等技术,支撑起一条完整的非对称加密实体对齐 + 非对称加密特征工程 + 非对称加密模型训练联邦学习数据链路。我们将在FL-IJCAI20国际会议上展示部分相关工作[8]。

首创面向联邦成果分享的安全信息检索技术

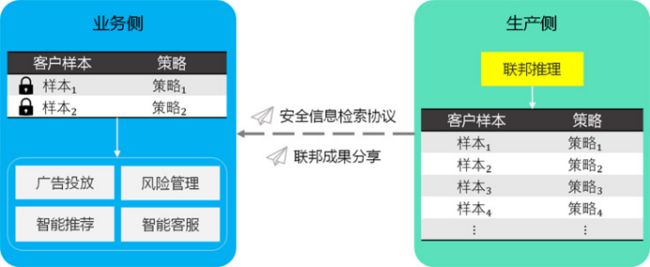

非对称联邦解决了训练过程中样本ID泄漏的问题,但在生产线上查询环节依然会因查询行为泄漏用户清单。若通过返回全量预测分数来保护查询方用户清单,则不便于按量计费,商业上存在障碍。

神盾联邦计算平台深度结合业务场景和需求,首创面向联邦成果分享的安全信息检索技术,解决联邦学习应用的重要隐私性问题,做到样本预处理-数据挖掘-联邦推理-联邦成果安全分享的完整、新型安全信息流。安全信息检索技术解决了联邦学习工程实践中的多方成果共享问题,填补联邦学习系统运行的最后一块短板。

安全信息检索协议基于Pohlig-Hellman交换加密技术和MPC中的不经意传输 (Oblivious Transfer) 技术,强有力保障联邦成果发送方精准分享目标客户群推理结果,全方位保护联邦成果接收方的目标客户群隐私。神盾联邦计算平台已凭借该项成果递交多项国家专利申请。

首创具语义安全性高性能同态加密技术

初次使用联邦学习系统的用户可以明显感知到,联邦学习与Spark MLlib, Tensorflow等面向扩展性的传统分布式机器学习框架的性能差异,从而对如此“低效”的联邦服务产生一些疑惑。

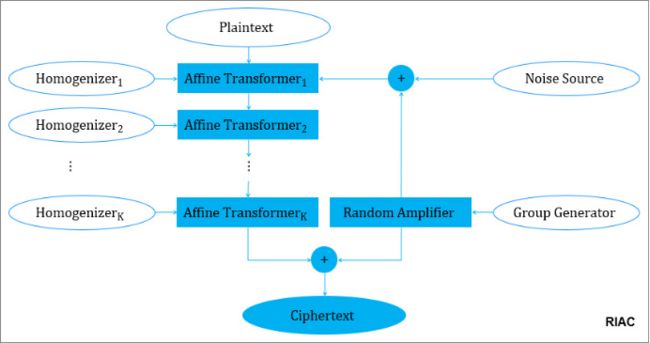

神盾联邦计算平台从联邦学习的核心隐私保护技术——同态加密入手优化联邦服务的性能,首创了具有语义安全性的高性能同态加密技术。在单元测试中,我们的成果计算效率相比现有的同态加密提升千倍以上;整个模型的训练耗时也可以节省87%以上。

同态加密是当前工业界广为应用的若干联邦协议中最为通用和便携的安全多方计算技术之一,它能够在保护隐私的前提下,轻易解耦数据提供方角色和计算方角色,完美契合联邦学习的面向隐私保护的分布式计算本质。

同态加密的研究吸引了广泛学者,大量的工作投入到支持运算层数深、运算类型多、安全等级高的各类同态密码研究中[9-11]。然而,受限于现代计算机处理器的性能和实际业务场景的高时效、低时延要求,即使大幅提升服务器配置的前提下,许多完备却复杂的同态密码并不能在令人满意的时间内、在足够大的数据集上、完成足够多轮的联邦建模训练,这是用户感知联邦学习与传统分布式建模系统性能差异较大的核心因素。

为了通过改进底层同态加密的方式提速联邦学习,我们借鉴了经典的对称密码Affine Cipher的群运算类型和非对称密码ElGamal的多元组密文混淆思想,全球首创随机化迭代型仿射密码 (Randomized Iterative Affine Cipher, RIAC)。我们的成果RIAC在保留了经典同态密码的运算次数隐蔽性和语义安全性的前提下,大幅提升同态运算效率,处于国内相关技术的领先梯队。神盾联邦计算平台已凭借该项成果递交多项国家专利申请。

首创地位对等的分布式安全聚合技术

在一个联邦学习系统中,数据隐私的保护依赖于其内部的各种安全子协议,例如对加法、乘法、聚合等操作的联邦子协议[13, 14]。其中,聚合技术能够在保护各参与方数据隐私的前提下,完成对分布在各方的模型更新所需参数(如梯度、残差等)、模型估计(如权重)和模型预测值等中间变量的中心化。

安全求和 (Secure Summation) 协议是聚合协议最为直观的实现之一,也是众多安全聚合技术的基准测试方案之一。

目前在学业界广泛流行的安全求和实现方案包括高效安全求和协议[15]、同态加密[10, 11]、秘密分享[16]、面向隐私保护的共识协议[17, 18]等,但在联邦协议的应用中,这些已有协议存在各种问题,包括共谋的威胁[15]、计算复杂较高[10,11,18]、精度损失[17]、完全去中心化 (full decentralization) 问题[10, 11]、动态环境问题[19]等。

遗憾的是,几乎没有求和协议针对联邦学习的这类要求做深入研究。我们首创面向隐私保护的演化式求和协议[12],以完全去中心化的结构,于无限时间内,在参与方设备频繁登入、登出的动态环境中,执行安全性好、准确率高、恢复力强的安全求和服务,作为联邦学习系统中的可靠子程序,适用于联邦学习协议中的各类安全聚合需求。在2020年4月,我们的该项成果发表在IEEE Intelligent Systems期刊上。

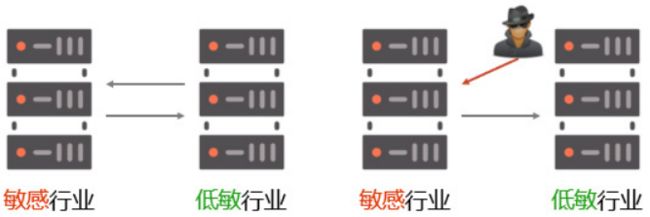

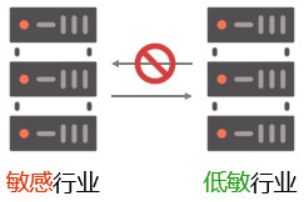

首创单向联邦网络策略

市面主流联邦学习产品及开源框架,均需要建模双方的网络双向互通,但这在银行等数据安全极度敏感的行业会引来网络安全担忧,如果开放了外界访问银行内部网络的入口,***就有可能通过扫描开放端口,伪造数据包来源IP等手段发起恶意***。

因此,如果能够只开放出口权限而不开放入口权限,则能让数据和网络环境的安全性大大增强。基于此特性,银行、互金等敏感行业可以通过动态出口IP,动态端口映射等手段让***无从下手,保护网络及数据安全。同时,也让数据合作容易通过合规审查,合作更容易开展。

腾讯“神盾-联邦计算”平台首创联邦单向网络架构,合作双方中对安全更为敏感的一方可以使用单向模式,即只开放网络出口权限而不开放入口权限。神盾提供的单向联通架构经测试,对运行效果和性能无任何影响,同时能够大大提高数据安全性。

腾讯神盾携手PowerFL、FATE

PowerFL是腾讯TEG出品的无需可信第三方的联邦学习平台,在开源的智能学习平台Angel之上构建,其中包括但不仅限于纵向联邦学习的系统框架和各类算法,神盾和PowerFL是腾讯“联邦学习”开源协同Oteam的合作伙伴,一开始就在在基础框架、联邦算法、应用研究等不同方向进行合作研究。

作为联邦学习全球首个工业级开源项目,FATE在同一时期也很快就进入神盾团队的视野,经过大半年在联邦技术和应用上的合作探讨,双方在2019年9月成立联合项目组,基于联邦学习进行了一系列的产品共同研发和迭代优化,在技术研究及行业应用标准方面双方也开展了深度合作,使得隐私保护下的数据合作不再困难。

基于同PowerFL、FATE的共同研究,神盾重新设计基于联邦学习、MPC及区块链等技术的联邦产品架构并沉下心来打磨细节。在现在的腾讯“神盾-联邦计算”上,一个略懂算法的新手用户不需要编写任何脚本,也可以通过简单设置轻松完成整个联邦建模过程。

除此之外,前文提到的众多神盾高价值工作还同时贡献到FATE开源社区,团队核心成员也在2019年成为FATE开源社区首位一级贡献者。

腾讯神盾引入重量级数据合作伙伴TalkingData

神盾首先承载了一个联邦计算平台的使命,它能满足有数据合作需求的企业之间安全地完成联合建模,但是大家都知道有价值的数据才是这一切的关键,银行有优质用户样本及资金流数据特征,游戏发行商有优质玩家的样本,线上教育机构有分类教育用户样本及特征,互联网巨头有巨量用户行为特征,怎样撮合这些企业进行有价值的数据合作成了神盾的又一个使命。

简单来说就是在神盾这个平台上任何数据需求方都能快速地找到高价值的合作伙伴,而任何进行数据合作的企业都能通过神盾-联邦计算平台完成安全的数据合作。

TalkingData是中国领先的数据智能服务商,产品负责人闫辉跟腾讯大数据团队有不解的渊源,在精准营销、EMR、ES、统计分析、BI精细化运营、企业画像等多个产品上都有深入的探讨和合作,当然联邦学习这个大数据前沿领域也不例外。

双方一致认同联邦学习的价值,于2020年初达成战略合作伙伴关系,TalkingData愿和腾讯“神盾-联邦计算”一起为客户提供丰富、安全、多维度的联邦数据服务。

这些都只是一个开始,腾讯“神盾-联邦计算”团队任重道远,在其愿景“让企业之间的数据合作不再困难!”上还有很远的路要走,但为了给各行各业带来更好的数据合作环境、为了给企业带来更高的市场增长空间、为了给用户更好的服务,团队将不畏艰险勇往直前。

参考文献:

[1] Yang, Qiang, et al. "Federated machine learning: Concept and applications." ACM Transactions on Intelligent Systems and Technology (TIST) 10.2 (2019): 1-19.

[2] Pohlig, Stephen, and Martin Hellman. "An improved algorithm for computing logarithms over GF (p) and its cryptographic significance (Corresp.)." IEEE Transactions on Information Theory 24.1 (1978): 106-110.

[3] De Cristofaro, Emiliano, and Gene Tsudik. "Practical private set intersection protocols with linear complexity." International Conference on Financial Cryptography and Data Security. Springer, Berlin, Heidelberg, 2010.

[4] Cheng, Kewei, et al. "Secureboost: A lossless federated learning framework." arXiv preprint arXiv:1901.08755 (2019).

[5] Liu, Yang, et al. "A Communication Efficient Vertical Federated Learning Framework." arXiv preprint arXiv:1912.11187 (2019).

[6] Zhuo, Hankz Hankui, et al. "Federated reinforcement learning." arXiv preprint arXiv:1901.08277 (2019).

[7] Wang, Tengyun, et al. "A revenue-maximizing bidding strategy for demand-side platforms." IEEE Access 7 (2019): 68692-68706.

[8] Liu, Yang, Xiong Zhang, and Libin Wang. "Asymmetrically Vertical Federated Learning." arXiv preprint arXiv:2004.07427(2020).

[9] Rivest, Ronald L., Len Adleman, and Michael L. Dertouzos. "On data banks and privacy homomorphisms." Foundations of secure computation 4.11 (1978): 169-180.

[10] Paillier, Pascal. "Public-key cryptosystems based on composite degree residuosity classes." International conference on the theory and applications of cryptographic techniques. Springer, Berlin, Heidelberg, 1999.

[11] Gentry, Craig. "Fully homomorphic encryption using ideal lattices." Proceedings of the forty-first annual ACM symposium on Theory of computing. 2009.

[12] Liu, Yang, et al. "Distributed Privacy Preserving Iterative Summation Protocols." arXiv preprint arXiv:2004.06348(2020).

[13] Bonawitz, Keith, et al. "Practical secure aggregation for privacy-preserving machine learning." Proceedings of the 2017 ACM SIGSAC Conference on Computer and Communications Security. 2017.

[14] McMahan, H. Brendan, et al. "Federated learning of deep networks using model averaging." (2016).

[15] Clifton, Chris, et al. "Tools for privacy preserving distributed data mining." ACM Sigkdd Explorations Newsletter 4.2 (2002): 28-34.

[16] Damgård, Ivan, et al. "Multiparty computation from somewhat homomorphic encryption." Annual Cryptology Conference. Springer, Berlin, Heidelberg, 2012.

[17] Mo, Yilin, and Richard M. Murray. "Privacy preserving average consensus." IEEE Transactions on Automatic Control 62.2 (2016): 753-765.

[18] Ruan, Minghao, Huan Gao, and Yongqiang Wang. "Secure and privacy-preserving consensus." IEEE Transactions on Automatic Control 64.10 (2019): 4035-4049.

[19] Wang, Jianyu, and Gauri Joshi. "Adaptive communication strategies to achieve the best error-runtime trade-off in local-update SGD." arXiv preprint arXiv:1810.08313 (2018).

![]()

关注“腾讯云大数据”公众号,技术交流、最新活动、服务专享一站Get~