【简述与推导】似然函数,最大似然估计,条件概率,全概率,贝叶斯概率

目录

1. 似然(likehood)与最大似然估计

2. 条件概率(conditional probability),全概率(total probability),和贝叶斯概率(Bayes probability)

2.1 联合概率==>条件概率:

2.2 联合概率==>全概率公式:

2.3 条件概率+联合概率==>贝叶斯概率公式:

1. 似然(likehood)与最大似然估计

似然从字面很难理解什么意思,这里借助了知乎https://www.zhihu.com/question/54082000和quora上的一个回答 What is the difference between probability and likelihood?的回答。不仅回答了似然是什么还指出了似然和概率的区别。

这里作简短概括:

似然和概率同宗同源,像一个双胞胎一样,所以很容易搞混:

链接中给了一个不错的比喻,将概率密度函数和似然函数之间的关系,类比成 幂函数和 指数函数之间的关系。假设一个函数为 ![]() ,这个函数包含两个变量,a,b。如果你令b=2,这样你就得到了一个关于a的二次幂函数,即

,这个函数包含两个变量,a,b。如果你令b=2,这样你就得到了一个关于a的二次幂函数,即 ![]() 。当你令a=2时,你将得到一个关于b的指数函数,即

。当你令a=2时,你将得到一个关于b的指数函数,即 ![]() 。

。

如此似然和概率他们俩又性格各异(互逆):

1.1 似然是知道事件结果推参数。举个栗子:如历史上,美国数学家Feller为了得知抛硬币正反的概率参数,一口气抛了10000次硬币,得到结果是4972次正面和5021次反面(事件结果),由此可得到一个硬币正反的概率参数的简单结果:正面概率约0.497,反面约为0.502。

.1.2 概率是知道参数推事件结果。举个栗子:小明知道了Feller大神的实验结果(概率参数),想要算一下抛硬币连续两次正再连续两次反面额概率,那么就是0.497*0.497*0.502*0.502 概率约为0.062(事件结果)。

那么最大似然估计又是什么呢:

回到上面的1.1例子中。令Feller的抛硬币实验次数为N次,其中事件结果是m次为正面,n次为反面(这里有N=m+n):

那么得到了该次抛硬币实验的似然函数:

![]() (式1.1)

(式1.1)

其中x代表这次抛硬币N次的事件的已知结果,![]() 为正面朝上的概率参数。求这个似然函数得最大值就是最大似然估计,它代表了有怎样的参数才最有可能复现这次已知事件。Feller抛硬币次数太多,不便于计算,我们取其中10次抛硬币结果:

为正面朝上的概率参数。求这个似然函数得最大值就是最大似然估计,它代表了有怎样的参数才最有可能复现这次已知事件。Feller抛硬币次数太多,不便于计算,我们取其中10次抛硬币结果:

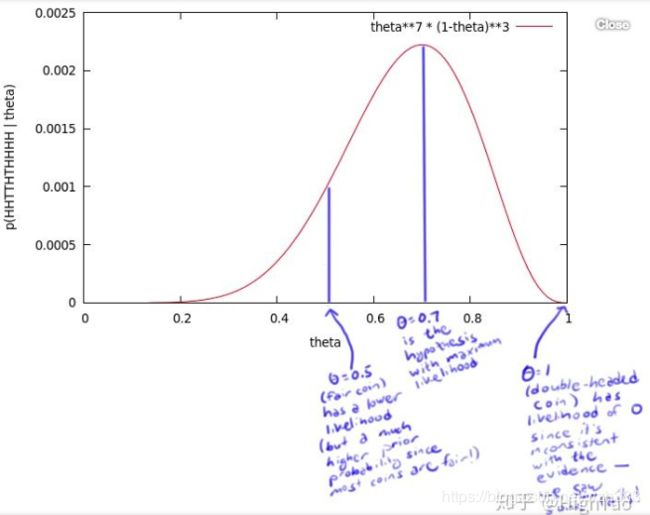

x=HHTTHTHHHH,这是一个正反序列,套用(式1.1),可得![]() ,这是一个一元多次幂函数,绘制如图1.1函数图:

,这是一个一元多次幂函数,绘制如图1.1函数图:

图1.1 抛硬币似然函数

这个曲线就是θ的似然函数,通过了解在某一假设下(假设参数),已知事件数据发生的可能性,来评价哪一个假设更接近θ的真实值。如图1.1所示,最有可能的假设是在θ=0.7的时候取到。常识告诉我们θ=0.5应该是最合理的,但是,0.7却是最大似然估计的取值。因为这里仅仅试验了一次,得到的样本太少,所以最终求出的最大似然值偏差较大,如果经过多次试验,扩充样本空间,则最终求得的最大似然估计将接近真实值0.5。在这篇博客中有详细的过程,就不再赘述。

2. 条件概率(conditional probability),全概率(total probability),和贝叶斯概率(Bayes probability)

巧了,这三个哥们也是同宗同源,三者都是由联合概率一步一步推导出来的。

2.1 联合概率==>条件概率:

我们知道:

A和B是两个独立事件,有如下AB同时发生的概率公式(即联合概率公式):![]()

![]()

这叫做在B事件发生条件下,A事件的发生概率。

2.2 联合概率==>全概率公式:

联合概率变一下:![]() 和

和![]() 是两个独立事件,其中

是两个独立事件,其中![]() 是由一系列小事件组成

是由一系列小事件组成![]() ,,这里引入概念完备事件组:

,,这里引入概念完备事件组:

![]() ,即

,即![]() 是这次实验的完整的样本空间

是这次实验的完整的样本空间![]() ,那么整体看

,那么整体看![]() ,B虽然由很多小事件组成,但是不管此刻哪件小事件发生,此刻必有唯一的

,B虽然由很多小事件组成,但是不管此刻哪件小事件发生,此刻必有唯一的![]() 发生。满足完备事件组的条件为:

发生。满足完备事件组的条件为:

n个事件两两互斥,且这n个事件的并是Ω,则称这n个事件为完备事件组。

那么此时联合概率公式如下:

![]() ,由于

,由于![]() ,则公式左边为可以写作

,则公式左边为可以写作![]() ,于是有全概率公式:

,于是有全概率公式:

![]() (式2.2)

(式2.2)

全概率公式的意义在于,当直接计算![]() 较为困难,而

较为困难,而![]() 的计算较为简单时,可以利用全概率公式计算

的计算较为简单时,可以利用全概率公式计算![]() 。思想就是,将事件

。思想就是,将事件![]() 分解成几个小事件,通过求小事件的概率,然后相加从而求得事件

分解成几个小事件,通过求小事件的概率,然后相加从而求得事件![]() 的概率,而将事件

的概率,而将事件![]() 进行分割的时候,不是直接对

进行分割的时候,不是直接对![]() 进行分割,而是先找到样本空间为

进行分割,而是先找到样本空间为![]()

![]() 的完备事件组

的完备事件组![]() ,对

,对![]() 进行划分:

进行划分:![]() 。

。

举个栗子:

发报台分别以概率0.6和0.4发出信号“0”和“1”。由于通信系统受到干扰,当发出信号“0”时,收报台分别以概率0.8和0.2受到信号“0”和“1”;又当发出信号“1”时,收报台分别以概率0.9和0.1收到信号“1”和“0”。求:

1.收报台收到信号“0”的概率?

2. 当收报台收到信号“0”时,发报台确系发出“0”的概率?

第一个问题是全概率问题,求得是某事件发生概率,这里电报台发电报事件为完备事件组![]() ,其中

,其中![]() ,

,![]() 分别为0.6和0.4。关系的问题为收报台收到信号“0”的概率,令为事件

分别为0.6和0.4。关系的问题为收报台收到信号“0”的概率,令为事件![]() ,套用(式2.2),可得:

,套用(式2.2),可得:

![]()

第二个问题是贝叶斯问题,是已知事件发生,求事件发生原因的概率,这两个问题互逆。

2.3 条件概率+联合概率==>贝叶斯概率公式:

与全概率公式解决的问题相反,贝叶斯公式是建立在条件概率的基础上寻找事件发生的原因(即事件A已经发生的条件下,分割其中的小事件![]() 发生的概率),

发生的概率),![]() 是样本空间Ω的完备事件组,则对任一事件

是样本空间Ω的完备事件组,则对任一事件![]() (

(![]() ),由 条件概率公式(式2.1)和全概率公式(式2.2)有某事件

),由 条件概率公式(式2.1)和全概率公式(式2.2)有某事件![]() 前提下的事件

前提下的事件![]() 的:

的:

等式最右边的分子是![]() 的联合概率,分母是

的联合概率,分母是![]() ,而等式左边这个“条件概率”就是贝叶斯概率。通俗解释就是,事件

,而等式左边这个“条件概率”就是贝叶斯概率。通俗解释就是,事件![]() 的诱因是

的诱因是![]() 的概率为

的概率为![]() 和

和![]() 同时发生概率除以事件

同时发生概率除以事件![]() 的发生概率,这就是贝叶斯概率公式(式2.3)。

的发生概率,这就是贝叶斯概率公式(式2.3)。