Competitive Collaboration:Joint Learning of Depth, Motion, Optical Flow and Motion Segmentation

代码:https://github.com/anuragranj/cc

摘要

在low-level视觉中使用无监督学习解决一下问题:单目深度估计、相机运动估计、光流、并将视频分割为静态场景和移动区域。并使用几何约束来解决这几个问题。并引入Competitive Collaboration解决网络之间的协调问题,其工作原理与expectation-maximization相似,既可以解释静态或运动区域相应像素,又协调将像素分配为静态或独立运动。

图1:左侧从上到下: 采样图片、运动分割的mask、深度图

右侧从上到下: 静态场景光流、运动区域的分割流、结合的光流

1 介绍

问题

之前的方法,不是所有未标记训练集中的数据符合模型假设。 例如,深度和相机运动的训练数据不应包含独立移动的对象。 同样,对于光流来讲,数据中不应包含遮挡物,这会破坏光度损失。

想法

真实世界包含静态场景和移动物体。已知深度和相机运动可以推断出视频序列的静态场景;相反,光流可以推断出场景中所有部分;运动分割将场景分为静态和移动区域。我们认为这些问题与场景的几何结构和运动有关,因此同时进行处理。

方法

为了解决联合无监督学习的问题,引入了Competitive Collaboration (CC),网络可以学习协作和竞争,从而实现特定的目标。CC是一种三人游戏,由两名玩家竞争由第三名玩家管理的资源。

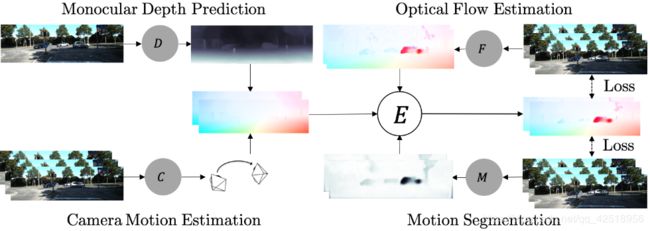

Figure 2 引入了2个玩家,静态场景重建器:R = (D, C);使用深度D、相机运动C、以及运动重建器F推出静态场景的像素。这两个玩家通过推出静态场景和移动区域像素来竞争训练数据。这项竞争由运动分割网络M组织,并分割出静态和运动区域,并需要合理分配数据来创造公平竞争。因此,玩家R、F协同训练M,使其在训练周期交替阶段正确地划分静态、移动区域。其总体框架类似于expectation-maximization(EM),但它是为神经网络训练制定的

图2:网络R =(D,C)通过使用深度D和相机运动C估算静态区域光流来估计场景。光流网络F估算整个图像上的流。 运动分割网络M从F中移除静态场景像素,以在整个图像上产生合成光流。 使用合成流的损失E应用于相邻框架,以共同训练所有这些模型

贡献

- 引入Competitive Collaboration,作为网络竞争者和协调者达到目的

- 使用CC框架同时训练能提高效果

- 第一个使用像深度、相机运动、光流这些低级信息,在没有任何监督情况下解决分割

- 实现了深度和相机运动估计方面的好效果。 提高了光流性能,并推出了场景几何,并引入了运动分割的第一个baseline

- 我们分析了本方法的收敛性,并通过在MNIST和SVHN数字上的混合域学习进行推广

2 相关工作

·modertor担当评论员的角色,两个竞争对手合作训练modertor。合作的想法可以被看做是神经元期待最大化,也就是其中一个模型训练后给另一个模型分发数据。

- Zhou [37]:从多帧无标注图像对自运动和深度进行学习,利用explainablity mask计算运动物体,还能捕获深度不连续处的遮挡问题,因此对于运动分割没有用处。

- Mahjourian [22]:使用几何损失从固定场景中学习深度和自运动

- Yin [36]:在Zhou基础加入优化网络估计残差光流,并用来计算移动区域,其残差流使用一个级联优化网络从而防止其他网络使用流信息增强效果。

我们添加的关键部分是同时学习从场景分割出静态和独立运动区域。

竞争性协作(CC)可以推广到模型具有相交目标的问题,使他们可以竞争和协作。 例如,可以使用我们的框架来完成对多模式分布的建模,从而使每个竞争者都可以学习某个模式下的分布。 实际上,在计算机视觉中使用期望最大化(EM)始于光流问题,然后将场景划分为“层” [15],然后广泛应用于其他视觉问题

3 Competitive Collaboration

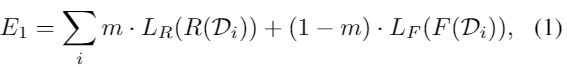

如Figure 3所示,考虑一组无标注训练数据集![]() 分为两个不想交的数据集,两个玩家{R,F}竞争来获取数据,并且每个竞争者都尝试对D进行分区以最大程度减少其loss。分区由moderator的输出结果

分为两个不想交的数据集,两个玩家{R,F}竞争来获取数据,并且每个竞争者都尝试对D进行分区以最大程度减少其loss。分区由moderator的输出结果![]() 管理,Ω是竞争者分区的结果。竞争的参与者分别将其损失函数

管理,Ω是竞争者分区的结果。竞争的参与者分别将其损失函数![]() 最小化,使每个参与者对自身优化,而不对团队进行优化。 我们的培训周期包括两个阶段。

最小化,使每个参与者对自身优化,而不对团队进行优化。 我们的培训周期包括两个阶段。

第一阶段,通过固定moderator网络M训练竞争者并减少

其中 · 代表元素级产物。然而M需要被训练。这发生在训练的第二阶段,竞争者{R,F}达成共识并训练M,使其在训练下一阶段正确分发数据。 在合作阶段,我们固定竞争者训练M来最小化以下式子:

![]() 表示竞争对手{R,F}之间的共识的loss。 竞争性协作可以应用于训练多个特定任务网络的更普遍的问题。 在附录A.1中,以MNIST和SVHN数字的混合域学习为例展示了该方法的一般化,并分析了其收敛性

表示竞争对手{R,F}之间的共识的loss。 竞争性协作可以应用于训练多个特定任务网络的更普遍的问题。 在附录A.1中,以MNIST和SVHN数字的混合域学习为例展示了该方法的一般化,并分析了其收敛性

图3:竞争性协作训练周期:Moderator M驱使两个竞争者{R,F}(第一阶段,左)。 之后,竞争对手合作训练协调者M,以确保在下一个迭代中公平竞争(第二阶段,右)。

在共同学习深度,相机运动,光流、运动分割的情况下,第一玩家R =(D,C)由深度和相机运动网络组成,并推断场景中的静态区域。 第二参与者F是光流网络,其推断出运动区域。为了训练竞争者,运动分割网络M选择网络R(D,C)处理静态像素,选择网络F处理运动区域像素。在训练的第二阶段,竞争者R、F合作推理出静态场景和运动区域来训练协调者M。

Notation(符号)

使用![]() 分别表示估计的深度、相机运动、光流、运动分割。下标

分别表示估计的深度、相机运动、光流、运动分割。下标![]() 为网络参数。考虑连续图像

为网络参数。考虑连续图像![]() ,在实行上使用帧连续图像来计算

,在实行上使用帧连续图像来计算![]() 和

和 ![]() ,这里简单用三帧介绍方法。

,这里简单用三帧介绍方法。

估计目标图像深度为:

![]()

根据相应图像I- I+来估计相机运动:

相似的静态场景的光流只需要相机运动和深度,一般与场景结构有关,移动区域有着单独的运动。每对目标的相关图像的分割mask定义如下:

其中![]() 是在空间像素领域Ω中静态区域的概率。最终网络

是在空间像素领域Ω中静态区域的概率。最终网络![]() 估计其光流,

估计其光流,![]() 以此输入两帧图像,并且在估计前向反向

以此输入两帧图像,并且在估计前向反向![]() 时共享其权重,

时共享其权重,

Loss

![]()

其中![]() 是权重。

是权重。![]() 和

和![]() 分别是两个竞争者重建静态和运动区域的最小化目标。竞争的数据由

分别是两个竞争者重建静态和运动区域的最小化目标。竞争的数据由![]() 决定,大型的权重

决定,大型的权重![]() 会将更多像素送入静态场景重建区。

会将更多像素送入静态场景重建区。![]() 管理合作部分,

管理合作部分,![]() 管理平滑度。静态场景部分中,

管理平滑度。静态场景部分中,![]() 最小化静态场景的广度损失:

最小化静态场景的广度损失:

其中Ω是空间像素领域,![]() 是鲁棒误差函数,

是鲁棒误差函数,![]() 将相应图像根据深度d和相机运动e变换到目标图像。同样的,

将相应图像根据深度d和相机运动e变换到目标图像。同样的,![]() 最小化运动区域光度损失:

最小化运动区域光度损失:

其中![]() 使用光流u变换相关图像,其中

使用光流u变换相关图像,其中![]() ,

,![]() 在附录A.2,A.3。计算鲁棒损失

在附录A.2,A.3。计算鲁棒损失![]() 为:

为:

其中![]() 是一个固定值,以及

是一个固定值,以及 ![]() 。第二部分是结构相似性损失(structure similarity loss),

。第二部分是结构相似性损失(structure similarity loss),![]() 是像素周围的局部均值和方差,其中

是像素周围的局部均值和方差,其中![]() ,

,![]()

损失![]() 用来减小在Mask和由

用来减小在Mask和由![]() 管理的单元向量之间的交叉熵

管理的单元向量之间的交叉熵

较大的![]() 更偏向于静态场景重构器R,使场景偏向静态。

更偏向于静态场景重构器R,使场景偏向静态。

让![]() 表示由相机运动

表示由相机运动![]() 和深度

和深度![]() 生成的光流,如附录A.2。其中一致性损失

生成的光流,如附录A.2。其中一致性损失![]() 来驱使合作并约束这些mask,并通过对由

来驱使合作并约束这些mask,并通过对由![]() 产生的静态场景流和由

产生的静态场景流和由![]() 估计的光流之间的一致性,来分割运动物体,定义如下:

估计的光流之间的一致性,来分割运动物体,定义如下:

其中![]() 是一个指示函数,如果下标的条件正确时值为1。第一个指示器函数是对竞争者分配mask,并通过比较

是一个指示函数,如果下标的条件正确时值为1。第一个指示器函数是对竞争者分配mask,并通过比较 ![]() 和

和 ![]() 来比较同一像素的光度损失。在第二个指示器函数中,阈值

来比较同一像素的光度损失。在第二个指示器函数中,阈值![]() 使

使![]() ,如果静态场景流

,如果静态场景流![]() 与光流u相近,那么就是静态场景。符号

与光流u相近,那么就是静态场景。符号![]() 指的是指示器函数间的局部OR。如果

指的是指示器函数间的局部OR。如果![]() 的光度损失比

的光度损失比![]() 低或者

低或者![]() 的光流与

的光流与![]() 的相似,那么一致性损失

的相似,那么一致性损失![]() 用来将像素标记为静态,最终光滑度项

用来将像素标记为静态,最终光滑度项![]() 用来对深度、分割、和光流进行约束。

用来对深度、分割、和光流进行约束。

其中 ![]() 和

和 ![]() 是空间方向的一阶导数,

是空间方向的一阶导数,![]() 保证平滑度由图像边缘决定。

保证平滑度由图像边缘决定。

推理

深度和相机运动直接从网络输出,运动分割![]() 由mask网络

由mask网络![]() 以及从

以及从![]() 估计的场景流和光流一致性输出,

估计的场景流和光流一致性输出,

第一项使用前后向相应帧图像,并结合从![]() 推出mask概率。第二项使用从

推出mask概率。第二项使用从![]() 和

和![]() 推出的光流之间的一致性来矫正mask。最后,在

推出的光流之间的一致性来矫正mask。最后,在![]() 间完整的光流

间完整的光流![]() ,是由静态场景和单独移动物体光流结合得到

,是由静态场景和单独移动物体光流结合得到

Eq(7)的损失是最小化邻帧图像的重建损失。两个竞争者,静态场景重建器![]() 和移动区域重建器

和移动区域重建器![]() 最小化loss。重建器R使用Eq(8)推处静态场景,重建器F由Eq(9)推出,调节器使用Eq(11)对mask网络Mx操作,R、F合作由Eq(12)训练网络Mx得到。

最小化loss。重建器R使用Eq(8)推处静态场景,重建器F由Eq(9)推出,调节器使用Eq(11)对mask网络Mx操作,R、F合作由Eq(12)训练网络Mx得到。

如果场景是完全静态,只有相机在移动,mask会使![]() 重建整个场景。然而

重建整个场景。然而![]() 对单独移动物体不生效,这些区域用

对单独移动物体不生效,这些区域用![]() 来重建。调节器Mx通过训练使用

来重建。调节器Mx通过训练使用![]() 和

和![]() 一致性对静态和运动区域进行分割,如Eq(12).训练分为两段,第一段,调节器Mx使Eqs(8,9)让两个模型

一致性对静态和运动区域进行分割,如Eq(12).训练分为两段,第一段,调节器Mx使Eqs(8,9)让两个模型![]() 和

和![]() 竞争。第二段,使用Eqs(11,12)对

竞争。第二段,使用Eqs(11,12)对![]() 和

和![]() 联合训练调节器

联合训练调节器