上置信界算法(the-upper-confidence-bound-algorithm,UCB)

这是一个multi-armed bandit problem action选择的一个算法以及概率误差界证明

原文: the-upper-confidence-bound-algorithm

补充:Subgaussian random variables:An expository note

我们现在描述著名的上置信界(UCB)算法,它克服了基于exploration的策略的所有局限性,包括了解水平和次优性差距。根据噪声的分布假设,该算法有多种不同的形式。

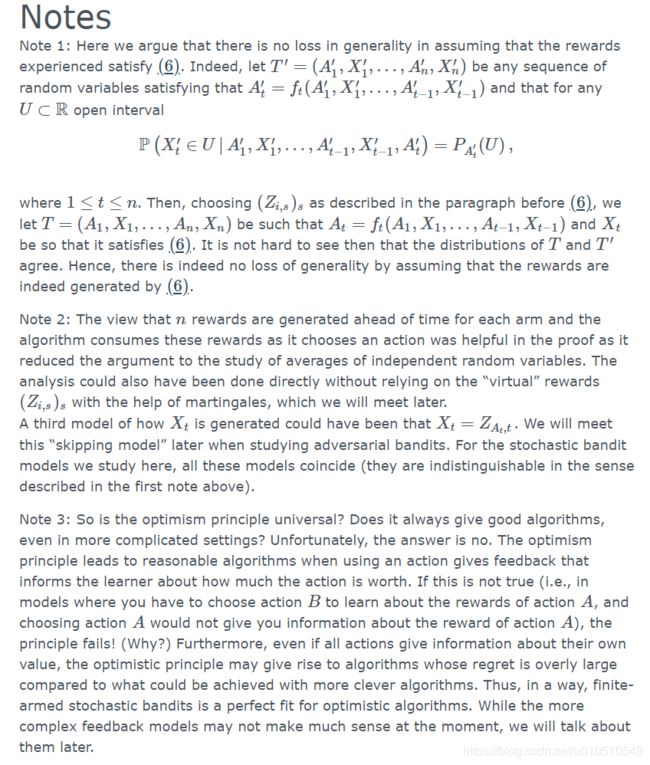

该算法基于面对不确定性时的乐观原则,选择行动就像环境(在本例中是老虎机)尽可能好似的。我们的意思是,根据观察到的数据,假定每只臂的未知平均收益尽可能大(没有根据的乐观主义不会有任何作用 ——见下图!)

这样做的直观原因是,当乐观地行动时,两件事中的一件会发生。要么乐观是正当的,在这种情况下,学习者的行为是最佳的,要么乐观是不正当的。在后一种情况下,智能体(agent)采取了一些行动,并相信可能会给予现实可能并没有的更大的报酬。如果这种情况经常发生,那么学习者将了解这种行为的真正回报,并且在将来不选择它。细心的读者可能会注意到,这解释了为什么这条规则最终会得到正确的结果(在某种意义上它是“一致的”),但这个论点并不能很好地解释为什么乐观算法实际上应该是所有一致算法中的一个好算法。然而,在讨论这个问题之前,让我们先澄清一下我们所说的“尽可能好”(plausible)是什么意思。

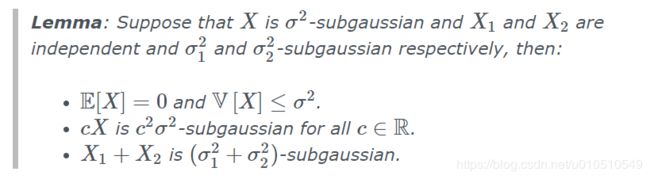

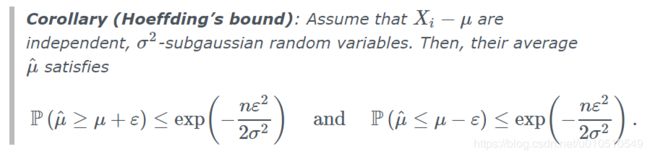

回想一下,如果 X 1 , X 2 , … , X n X_1,X_2,\dots,X_n X1,X2,…,Xn为独立1-subgaussian变量(这意味着, E [ X i ] = 0 ) , μ ^ = ∑ t = 1 n X t / n \mathbb{E}[X_i] = 0),\hat{\mu} = \sum_{t=1}^n X_t / n E[Xi]=0),μ^=∑t=1nXt/n,则(译者注:直接由定义就得到,见下面)

P ( μ ^ ≥ ε ) ≤ exp ( − n ε 2 / 2 ) \mathbb{P}(\hat{\mu} \ge \varepsilon) \le \exp\left(-n\varepsilon^2 / 2 \right) P(μ^≥ε)≤exp(−nε2/2)

令右边部分为 δ ∈ ( 0 , 1 ) \delta \in (0,1) δ∈(0,1)则

P ( μ ^ ≥ n 2 log ( 1 δ ) ) ≤ δ \mathbb{P}\left(\hat{\mu} \ge \sqrt{\frac{n}{2}\log\left(\frac{1}{\delta}\right) }\right) \le \delta P(μ^≥2nlog(δ1))≤δ

(补充:b-subgaussian随机变量指的是对 ∀ t ∈ R \forall t\in R ∀t∈R满足 E ( e t X ) ≤ e b 2 t 2 / 2 \mathbb{E} \left(e^{tX}\right) \le e^{b^2t^2/2} E(etX)≤eb2t2/2 的随机变量,它类似高斯变量的一些分布,比如伯努利分布

)

假设在t回合已经观测到了第i个臂的 T i ( t − 1 ) T_i(t - 1) Ti(t−1)个样本,平均回报为 μ ^ i ( t − 1 ) \hat{\mu}_i(t - 1) μ^i(t−1),根据上式臂i最大可信均值的一个选择为(译者注:因为reward不是均值为0 的,第一项是分布均值的无偏估计,第二项是 μ ˉ − m u ^ \bar{\mu} - \hat{mu} μˉ−mu^ 上界估计,有 1 − δ 1 - \delta 1−δ的概率成立 μ ˉ = μ ^ + μ ˉ − μ ^ ≤ u p p e r b o u n d \bar{\mu} =\hat{\mu} + \bar{\mu} - \hat{\mu} \le upper bound μˉ=μ^+μˉ−μ^≤upperbound ):

μ ^ i ( t − 1 ) + 2 T i ( t − 1 ) log ( 1 δ ) \hat{\mu}_i(t - 1)+\sqrt{\frac{2}{T_i(t - 1)}\log\left( \frac{1}{\delta}\right)} μ^i(t−1)+Ti(t−1)2log(δ1)

则可以根据最大化上式选择action。如果 δ \delta δ选择小,那么算法比较乐观,如果 δ \delta δ选择大,那么算法就不那么确定了。 1 − δ 1-\delta 1−δ称作置信水平,选择不同将导致算法不同,有不同的利弊。现在我们选择为时间相关的

![]()

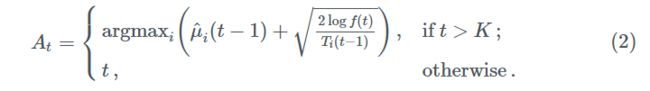

δ \delta δ比 1 / t 1/t 1/t更快地随时间趋于0。在步骤 t t t,UCB 选择Action的准则是

第一轮对所有action选择一遍,避免分母为0。在UCB中,这个指数是经验报酬平均值和所谓的exploration奖励的总和,也称为置信宽度。

除了我们之前给出的有点模糊的“乐观主义保证了最佳性”直觉之外,还值得探索其他选择这个指数的直觉。在基本直觉上,我们应该选择1)之前获得了很多回报 μ i ( t − 1 ) \mu_i(t-1) μi(t−1)的臂。2)还没怎么探索的臂(即 T i ( t − 1 ) T_i(t - 1) Ti(t−1)很小)。直觉上可以这么看待UCB准则,然而这样并没有告诉我们为什么函数长这样。

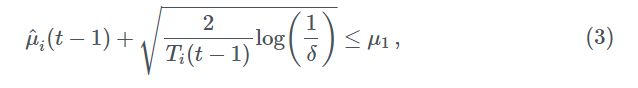

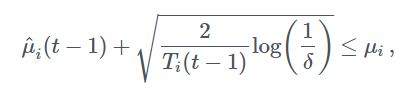

另一种解释来自于我们对任何合理算法的期望。假设在某些回合中,我们比其他回合更频繁地选择了一些臂(比如说臂1)。所以我们可以期望 μ ^ 1 ( t − 1 ) \hat{\mu}_1(t-1) μ^1(t−1) 更接近 μ 1 \mu_1 μ1。为了确信臂1确实是最好的,我们必须有很高的置信水平保证其他比这个差。

这个式子保证了有 1 − δ 1 - \delta 1−δ的置信水平使得 μ i ≤ μ 1 \mu_i \le \mu_1 μi≤μ1成立。而如果上式不成立,则就不会更多的选择臂1。所以这个准则保证了最终的最优性。但是如何选择 δ \delta δ呢,如果不幸的事情发生

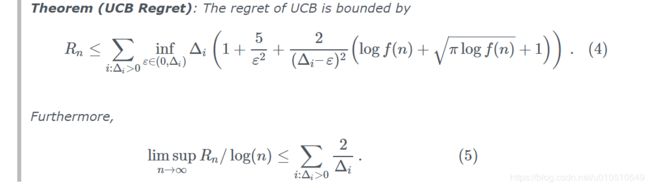

那么即使i是最优的也可能不会被选到。在这种情况下算法的regret线性于 n n n(译者注:指的损失的期望回报),所以最好是将失败次数控制和 1 / n 1/n 1/n相当,这样就能保证期望regret是常数。所以我们选择了(2)的 f ( t ) f(t) f(t)。结论就是(译者注:其中 Δ i = μ ∗ − μ i \Delta_i = \mu^* - \mu_i Δi=μ∗−μi为最佳回报期望和第i个臂回报期望的差)

第一个式子中

![]()

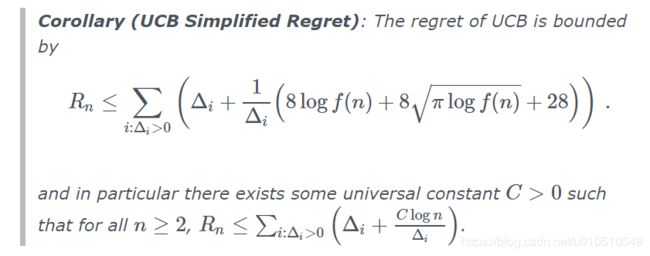

因此,我们可以看到,这个界限与水平长度成对数比例,并且能够产生和ETC(explore then commit)中 K = 2 K=2 K=2时一样的结果(当我们根据 Δ 2 \Delta_2 Δ2的知识调整勘探时间时)。我们将在后面更详尽地讨论,现在我们关注一个简化的版本,去掉 ε \varepsilon ε和下界操作,使式子更易懂。选择 ε = Δ i / 2 \varepsilon=\Delta_i / 2 ε=Δi/2,得到

注意到,上式两边除以 l o g n logn logn并取极限得到的系数和前面的并不一样,这是因为这放宽了限制,去掉了 v a r ϵ var\epsilon varϵ。事实上我们将看到一个从(4)导出的regret的渐进界(5),通过设 ε = log 1 / 4 ( n ) \varepsilon=\log^{1/4}(n) ε=log1/4(n)而得到。这在很大程度上是不能再改进的了。

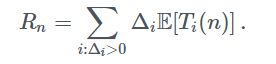

定理的证明依赖于basic regret decomposition identity,该式将期望regret表示为选择次优动作的期望次数的加权和。所以为什么对于次优action, E [ T i ( n ) ] \mathbb{E}[T_i(n)] E[Ti(n)]会很小呢?这基于一些事实:首先,除了初始轮外,只有当UCB指数比其他高的时候才会选择它。这只有当它的UCB指数太高 ( μ ∗ − ε > μ i ) (\mu^∗−\varepsilon > \mu_i) (μ∗−ε>μi),或者最优action的指数太低( μ ∗ − ε < μ ∗ \mu^∗−\varepsilon < \mu^* μ∗−ε<μ∗)(应该是 μ − ε > μ ∗ μ−ε>μ* μ−ε>μ∗)。由于UCB指数在很高概率上是臂均值的一个上界,我们不能指望所有的所有臂的指数都小于它的均值。因此,总的最优的臂出现过低的次数期望上可以忽略不计。另外,次优臂i选择的次数足够多,则它的eploreation奖励将变得更小,同时均值的经验估计将更趋于正确的均值,这使得它的指数高于 μ ∗ − ε \mu^* - \varepsilon μ∗−ε的期望比较小。

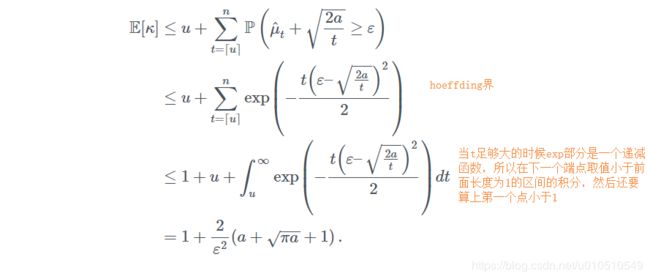

我们从一个有用的引理开始,这帮助我们确信最后一点的论证

因为X_i是独立1-subgaussian变量我们有 E [ μ ^ t ] = 0 \mathbb{E}[\hat{\mu}_t] = 0 E[μ^t]=0,所以我们不能期望 μ ^ t + 2 a / t < ε \hat{\mu}_t+\sqrt{2a/t} < \varepsilon μ^t+2a/t<ε,除非t达到了 2 a / ε 2 2a/\varepsilon^2 2a/ε2,引理证实了这确实是 E [ κ ] \mathbb{E}[\kappa] E[κ]正确的估计顺序。

证明:

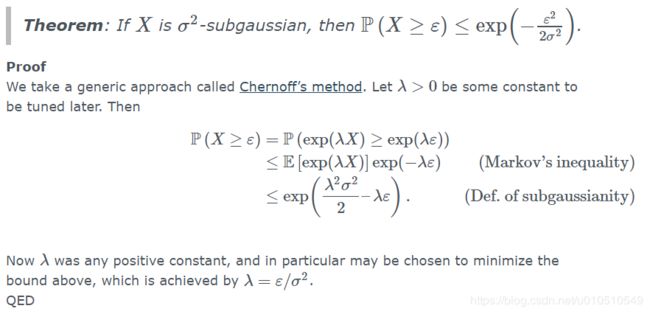

令 u = 2 a ε − 2 u=2a\varepsilon^{-2} u=2aε−2,根据次高斯随机变量的集中理论(concentration theorem)(就是利用下面的hoeffding界)

在证明UCB regret 定理之前,我们需要稍微回顾一下bandit model。我们定义 μ ^ i ( t ) \hat{\mu}_i(t) μ^i(t)为第i个臂第t回合以后的经验均值,对于explore-then-commit来说已经足够了。然而对于UCB来说,定义第i个臂观测s次后的经验均值 μ ^ i , s \hat{\mu}_{i,s} μ^i,s是很有用的,它的发生时间是随机的。为了严格定义它,不失一般性,我们可假设第t回合的reward, X t X_t Xt是从reward序列 ( Z i , s ) 1 ≤ s ≤ n \left(Z_{i,s}\right)_{1\le s\le n} (Zi,s)1≤s≤n中选择其中的第 T i ( t ) T_i(t) Ti(t)个。 ( Z i , s ) s \left(Z_{i,s}\right)_s (Zi,s)s是服从分布 Z i , s Z_{i,s} Zi,s的独立序列,自然就有

X t = Z A t , T A t ( t ) X_t=Z_{A_t,T_{A_t}(t)} Xt=ZAt,TAt(t)引入Z是为了让定义更简洁(如果没有Z那么当T_i(n) \le s时,怎么定义 μ ^ i , s \hat{\mu}_{i,s} μ^i,s).根据Z的定义,就可以定义

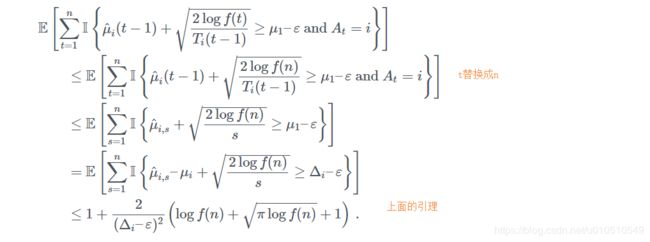

下面证明UCB regret定理。

证明:

首先和explore-then-commit策略一样,先写出regret分解(就是损失的期望回报)

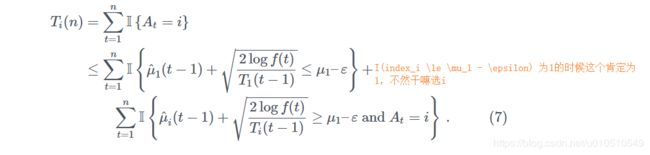

剩下的就是界定 E [ T i ( n ) ] \mathbb{E}[T_i(n)] E[Ti(n)],令i为某个次优臂(有 Δ i > 0 \Delta_i > 0 Δi>0)。我们将 T i ( n ) T_i(n) Ti(n)分成两部分,第一部分衡量最优臂指数小于 μ 1 − ε \mu_1 - \varepsilon μ1−ε的次数。第二部分衡量 A t = i A_t = i At=i且指数大于 μ 1 − ε \mu_1 - \varepsilon μ1−ε的次数

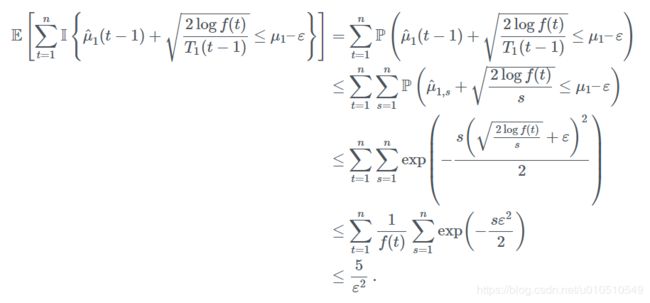

定理的第一部分就是分别界定这两个部分的期望。使用concentration 理论(前面),第一部分有

(译者注:最后一个不等式是这么来的,都是利用积分放缩,第二个求和式和上面hoeffding界最后一步一样得到这部分 ≤ 2 ε 2 \le \frac{2}{\varepsilon^2} ≤ε22,而第一个求和 ∑ n = 1 k 1 n + n log 2 n ≤ ∑ n = 1 ∞ 1 n + n log 2 n = 1 + ∑ n = 2 ∞ 1 n + n log 2 n ≤ 1 + ∫ 1 ∞ 1 1 + x log 2 x d x = 1 + ∫ 0 ∞ e t 1 + e t t 2 d t ≤ 1 + 1 2 + ∫ 1 ∞ 1 e − t + t 2 d t ≤ 3 2 + ∫ 1 ∞ 1 t 2 d t = 5 2 \begin{aligned}\sum_{n=1}^k \frac{1}{n+n\log^2n} &\le \sum_{n=1}^\infty \frac{1}{n+n\log^2n} =1 + \sum_{n=2}^\infty \frac{1}{n+n\log^2n} \\ &\le 1 + \int_1^\infty \frac{1}{1 + x\log^2x} dx = 1 + \int_0^\infty \frac{e^t}{1+e^tt^2} dt\\ &\le 1 + \frac{1}{2} + \int_1^\infty \frac{1}{e^{-t}+t^2} dt\\ &\le \frac{3}{2} + \int_1^\infty \frac{1}{t^2} dt = \frac{5}{2} \end{aligned} n=1∑kn+nlog2n1≤n=1∑∞n+nlog2n1=1+n=2∑∞n+nlog2n1≤1+∫1∞1+xlog2x1dx=1+∫0∞1+ett2etdt≤1+21+∫1∞e−t+t21dt≤23+∫1∞t21dt=25

而定理的后面部分取 ε = l o g 1 / 4 n \varepsilon = log^{1/4}n ε=log1/4n然后取极限得到

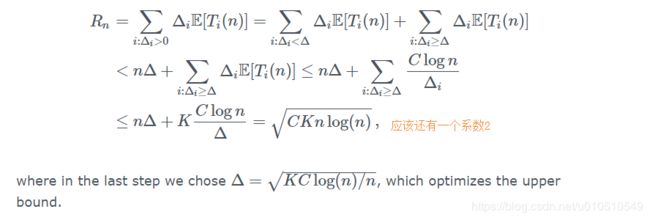

下周我们将看到UCB在几个方面接近最佳状态。与“explore-and-commit”策略一样,当间隙 Δ i \Delta_i Δi很小时,上一个定理中给出的界限没有意义。像那种算法一样,可以通过区别对待 Δ i \Delta_i Δi小的臂来证明UCB的分布无关的边界。固定 Δ > 0 \Delta > 0 Δ>0 ,从bound on the regret of UCB的证明得到 n ≥ 2 n \ge 2 n≥2时,存在某个常数C使得

![]()

则可以得到和次优界限 Δ i \Delta_i Δi无关的regret界

存在很多的方向去提高或者推广这个结果。例如除了次高斯性以外可以知道噪声模型的更多信息,那么通常可以提升这个界限。主要的例子是Bernoulli 情形,可以利用均值趋近于0或1时当方差很小的事实。另一个方向就是改善最坏情况下的regret以匹配下限 Ω ( K N ) \Omega({\sqrt{KN}}) Ω(KN),这将在下周看到。这需要修改置信水平和更复杂的分析。