Hadoop完全分布式高可用集群搭建

Hadoop完全分布式高可用集群搭建

1、 环境准备

certOS7, JDK1.8, 三台机器分别如下

Hostname IP Nn1 Nn2 Dn Zk Zkfc jnn

prd-ecs-3 172.18.48.129 * * * * *

prd-ecs-4 172.18.48.130 * * * * *

test-ecs-2 172.18.96.146 * * *

关闭SELINUX,关闭防火墙,关闭iptables,或者设置对应端口或内网IP可互相通信。

-A INPUT -m state --state RELATED,ESTABLISHED -j ACCEPT

-A INPUT -p icmp -j ACCEPT

-A INPUT -i lo -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 22 -j ACCEPT

-A INPUT -s 172.18.0.0/16 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 80 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 88 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 89 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 99 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 9443 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 9876 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 443 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 18080 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 9870 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 8088 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 19888 -j ACCEPT

-A INPUT -p tcp -m state --state NEW -m tcp --dport 16010 -j ACCEPT

设置各台机器的hostname

vi /etc/hostname

#设置成对应的名称

设置各台机器的 hosts, 将ip和hostname对应关系设置好

vi /etc/hosts

172.18.48.129 prd-ecs-3

172.18.48.130 prd-ecs-4

172.18.96.146 test-ecs-2

2、 linux ssh免密登陆配置

hadoop节点之间的通讯是通过ssh进行的,SSH默认都是需要密码的,开启免密钥登录会减少很多麻烦。操作很简单,两步(三步)就可以完成。

2.1 首先在本地生成公钥和私钥。分别在所有节点上执行:

ssh-keygen -t rsa

#后面都按回车跳过即可(三次)

# 运行结束后在 ~/.ssh/下生成两个新文件: id_rsa.pub和id_rsa

#设置本机ssh免密

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

2.2 将公钥拷贝到本机和远程主机

ssh-copy-id root@ prd-ecs-4

or

ssh-copy-id prd-ecs-4

ssh-copy-id test-ecs-2

……

# username是用户名 host是主机的地址

#远程主机将用户的公钥保存在 ~/.ssh/authorized_keys文件中

#或者直接手动复制也可以

2.3 测试能否免密登陆:

ssh prd-ecs-4

3、 安装JDK

下载jdk1.8, 解压安装

tar -xzvf jdk-8u211-linux-x64.tar.gz -C /home/data/

配置环境变量

vi /etc/profile

在最后面添加如下配置

# java setting

export JAVA_HOME=/home/data/jdk1.8.0_131

export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$CLASSPATH

export PATH=$PATH:$JAVA_HOME/bin

将JDK分发到其它节点安装好

4、 安装hadoop

下载hadoop, 解压安装

tar -xzvf hadoop-3.1.2.tar.gz -C /home/data/big/

配置环境变量

vi /etc/profile

在最后面添加如下配置

# Hadoop setting

export HADOOP_HOME=/home/data/big/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

5、 安装zookeeper

下载 zookeeper 并解压安装

tar -xzvf zookeeper-3.4.13.tar.gz -C /home/data/big/

配置环境变量

vi /etc/profile

在最后面添加如下配置

export ZK_HOME=/home/data/big/zookeeper

export PATH=$PATH:$ZK_HOME/bin

将 /etc/profile 复制到其它节点

rsync -av /etc/profile root@hostname:/etc/

# 生效环境变量

source /etc/profile

修改zookeeper配置文件

cp /home/data/big/zookeeper/conf/zoo_sample.cfg /home/data/big/zookeeper/conf/zoo.cfg

vi /home/data/big/zookeeper/conf/zoo.cfg

#修改 dataDir配置

dataDir=/home/data/big/data/zookeeper

#在最后添加配置

server.1=prd-ecs-3:2888:3888

server.2=prd-ecs-4:2888:3888

server.3=test-ecs-2:2888:3888

#按上述配置序号将数字添加到对应dataDir的myid文件中,如server.1添加如下

echo 1 > /home/data/big/data/zookeeper/myid

复制zookeeper到其它各节点

cd /home/data/big

rsync -av zookeeper root@hostname:`pwd`

在其它各节点配置 /home/data/big/data/zookeeper/myid 文件,内容为对应的数字

启动3台zookeeper服务测试

cd /home/data/big

zookeeper/bin/zkServer.sh start

zookeeper/bin/zkServer.sh status

6、 修改hadoop配置

修改 hadoop-env.sh

cd /home/data/big

vi hadoop/etc/hadoop/hadoop-env.sh

#加入如下内容

export JAVA_HOME=/home/data/jdk1.8.0_131

# hdfs 用户

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HDFS_JOURNALNODE_USER=root

export HDFS_ZKFC_USER=root

# yarn 用户

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

修改workers

vi hadoop/etc/hadoop/workers

#内容如下,三个数据节点

prd-ecs-3

prd-ecs-4

test-ecs-2

修改 core-site.xml

vi hadoop/etc/hadoop/core-site.xml

# 内容如下

修改 hdfs-site.xml

vi hadoop/etc/hadoop/hdfs-site.xml

# 内容如下

将hadoop分发到其他节点

cd /home/data/big

rsync -av hadoop root@hostname:`pwd`

7、 Hadoop HDFS HA集群的启动步骤

7.1 按照前面的启动方式启动zookeeper集群

7.2 启动journalnode(分别在各个节点上执行)

hdfs --daemon start journalnode

[root@node01 /]# jps

2444 JournalNode

2493 Jps

出现JournalNode则表示journalnode启动成功。

7.3 格式化 HDFS

在nn1主节点上执行命令:

hdfs namenode -format

倒数第几行左右的地方,出现这一句就表示成功

common.Storage: Storage directory /…/dfs/name has been successfully formatted.

7.4 复制 hadoop.tmp.dir 配置下的文件到nn2中

cd /home/data/big

rsync -av data/hadoop/full root@nn2-hostname: /home/data/big/data/hadoop/

7.5格式化ZKFC(在nn1主节点上执行一次即可)

hdfs zkfc -formatZK

在倒数第3行提示如下内容表示成功

ha.ActiveStandbyElector: Successfully created /hadoop-ha/bi in ZK.

此时在zookeeper集群中可以查看

zkCli.sh

get /hadoop-ha/hadoop-test

7.6启动HDFS

start-dfs.sh

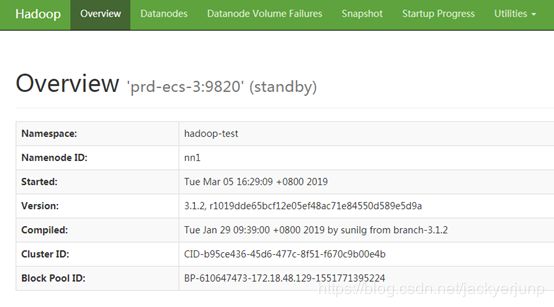

访问 http://172.18.48.129:9870 http:// 172.18.48.130:9870

8、 Hadoop MapReduce、YARN 高可用集群搭建

前面搭建好HDFS后,继续在此基础上完成MapReduce、YARN的配置。

Hostname IP Nn1 Nn2 Dn Zk Zkfc jnn RM NM

prd-ecs-3 172.18.48.129 * * * * * *

prd-ecs-4 172.18.48.130 * * * * * * *

test-ecs-2 172.18.96.146 * * * * *

修改 mapred-site.xml

vi hadoop/etc/hadoop/mapred-site.xml

# 内容如下 :

修改yarn-site.xml

vi hadoop/etc/hadoop/yarn-site.xml

# 内容如下 :

将以上修改文件分发到其他节点相同目录。

启动yarn

先启动zookepper:zkServer.sh start

再启动hdfs:start-dfs.sh

启动yarn:start-yarn.sh

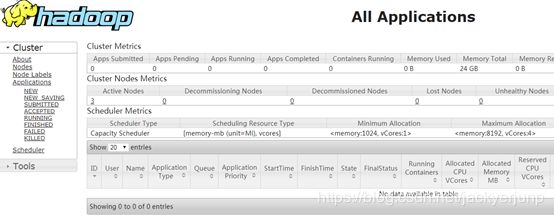

查看yarn群集 http://172.18.48.130:8088 http://172.18.96.146:8088

全部搭建成功!