BloomFilter 布隆过滤器原理分析

我们知道,在用户和DB之间加入缓存可以有效缓解DB存取数据的性能瓶颈。就以Redis为例,缓存可以把DB中的数据以一个key-value的形式放入内存以便降低请求的平均延时,然而在流量洪峰之后很可能出现大范围key失效的缓存雪崩问题,除了设置key存活时间的偏移量,还可以通过BloomFilter布隆过滤器来解决缓存雪崩问题。

一、查询原理

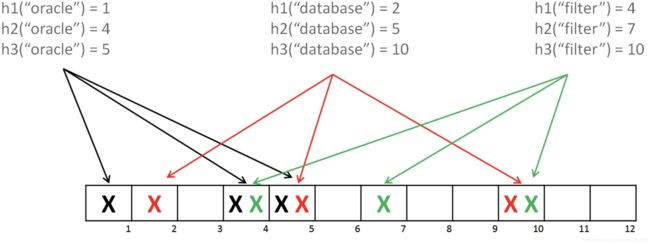

布隆过滤器,可以说是一个二进制向量和一系列随机映射函数实现。 可以用于检索一个元素是否在一个集合中。下面来看看布隆过滤器是如何判断元素在一个集合中,如下图:

有三个hash函数和一个位数组,oracle经过三个hash函数,得到第1、4、5位为1,database同理得到2、5、10位1,这样如果我们需要判断oracle是否在此位数组中,则通过hash函数判断位数组的1、4、5位是否均为1,如果均为1,则判断oracle在此位数组中,database同理。这就是布隆过滤器判断元素是否在集合中的原理。

是的,这里还有一个问题,如果bloom经过三个hash算法,需要判断 1、5、10位是否为1,恰好因为位数组中添加oracle和database导致1、5、10为1,则布隆过滤器会判断bloom会判断在集合中,导致误判。但是,如果位数组size足够大并且hash次数足够多,就可以将误判率控制在一个极低的范围内;另外,可以保证的是,如果布隆过滤器判断一个元素不在一个集合中,那这个元素一定不会再集合中。

而常用的数据结构,如HashMap、Set都能用来测试一个元素是否存在于一个集合中,相对于这些数据结构,BloomFilter有什么方面的优势呢?

- 对于hashmap,其本质上是一个指针数组,一个指针的开销是sizeof(void*),在64bit的系统上是64个bit,如果采用开链法处理冲突的话,又需要额外的指针开销,而对于BloomFilter来讲,返回可能存在的情况中,如果允许有1%的错误率的话,每个元素大约需要10bit的存储空间,整个存储空间的开销大约是hashmap的15%左右

- 对于set,如果采用hashmap方式实现,情况同上;如果采用平衡树方式实现,一个节点需要一个指针存储数据的位置,两个指针指向其子节点,因此开销相对于hashmap来讲是更多的

所以,BloomFilter的优势就很明显了,因为采用了位数组的存储方式,它的空间利用率非常高;采用hash()和位比较,它的查询效率也非常高。

二、代码实现

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.ObjectInputStream;

import java.io.ObjectOutputStream;

import java.io.Serializable;

import java.util.BitSet;

import java.util.concurrent.atomic.AtomicInteger;

public class BloomFileter implements Serializable {

private static final long serialVersionUID = -5221305273707291280L;

private final int[] seeds;

private final int size;

private final BitSet notebook;

private final MisjudgmentRate rate;

private final AtomicInteger useCount = new AtomicInteger(0);

private final Double autoClearRate;

/**

* 默认中等程序的误判率:MisjudgmentRate.MIDDLE 以及不自动清空数据(性能会有少许提升)

*

* @param dataCount

* 预期处理的数据规模,如预期用于处理1百万数据的查重,这里则填写1000000

*/

public BloomFileter(int dataCount) {

this(MisjudgmentRate.MIDDLE, dataCount, null);

}

/**

*

* @param rate

* 一个枚举类型的误判率

* @param dataCount

* 预期处理的数据规模,如预期用于处理1百万数据的查重,这里则填写1000000

* @param autoClearRate

* 自动清空过滤器内部信息的使用比率,传null则表示不会自动清理,

* 当过滤器使用率达到100%时,则无论传入什么数据,都会认为在数据已经存在了

* 当希望过滤器使用率达到80%时自动清空重新使用,则传入0.8

*/

public BloomFileter(MisjudgmentRate rate, int dataCount, Double autoClearRate) {

long bitSize = rate.seeds.length * dataCount;

if (bitSize < 0 || bitSize > Integer.MAX_VALUE) {

throw new RuntimeException("位数太大溢出了,请降低误判率或者降低数据大小");

}

this.rate = rate;

seeds = rate.seeds;

size = (int) bitSize;

notebook = new BitSet(size);

this.autoClearRate = autoClearRate;

}

public void add(String data) {

checkNeedClear();

for (int i = 0; i < seeds.length; i++) {

int index = hash(data, seeds[i]);

setTrue(index);

}

}

public boolean check(String data) {

for (int i = 0; i < seeds.length; i++) {

int index = hash(data, seeds[i]);

if (!notebook.get(index)) {

return false;

}

}

return true;

}

/**

* 如果不存在就进行记录并返回false,如果存在了就返回true

*

* @param data

* @return

*/

public boolean addIfNotExist(String data) {

checkNeedClear();

int[] indexs = new int[seeds.length];

// 先假定存在

boolean exist = true;

int index;

for (int i = 0; i < seeds.length; i++) {

indexs[i] = index = hash(data, seeds[i]);

if (exist) {

if (!notebook.get(index)) {

// 只要有一个不存在,就可以认为整个字符串都是第一次出现的

exist = false;

// 补充之前的信息

for (int j = 0; j <= i; j++) {

setTrue(indexs[j]);

}

}

} else {

setTrue(index);

}

}

return exist;

}

private void checkNeedClear() {

if (autoClearRate != null) {

if (getUseRate() >= autoClearRate) {

synchronized (this) {

if (getUseRate() >= autoClearRate) {

notebook.clear();

useCount.set(0);

}

}

}

}

}

public void setTrue(int index) {

useCount.incrementAndGet();

notebook.set(index, true);

}

private int hash(String data, int seeds) {

char[] value = data.toCharArray();

int hash = 0;

if (value.length > 0) {

for (int i = 0; i < value.length; i++) {

hash = i * hash + value[i];

}

}

hash = hash * seeds % size;

// 防止溢出变成负数

return Math.abs(hash);

}

public double getUseRate() {

return (double) useCount.intValue() / (double) size;

}

public void saveFilterToFile(String path) {

try (ObjectOutputStream oos = new ObjectOutputStream(new FileOutputStream(path))) {

oos.writeObject(this);

} catch (Exception e) {

throw new RuntimeException(e);

}

}

public static BloomFileter readFilterFromFile(String path) {

try (ObjectInputStream ois = new ObjectInputStream(new FileInputStream(path))) {

return (BloomFileter) ois.readObject();

} catch (Exception e) {

throw new RuntimeException(e);

}

}

/**

* 清空过滤器中的记录信息

*/

public void clear() {

useCount.set(0);

notebook.clear();

}

public MisjudgmentRate getRate() {

return rate;

}

/**

* 分配的位数越多,误判率越低但是越占内存

*

* 4个位误判率大概是0.14689159766308

*

* 8个位误判率大概是0.02157714146322

*

* 16个位误判率大概是0.00046557303372

*

* 32个位误判率大概是0.00000021167340

*

* @author lianghaohui

*

*/

public enum MisjudgmentRate {

// 这里要选取质数,能很好的降低错误率

/**

* 每个字符串分配4个位

*/

VERY_SMALL(new int[] { 2, 3, 5, 7 }),

/**

* 每个字符串分配8个位

*/

SMALL(new int[] { 2, 3, 5, 7, 11, 13, 17, 19 }), //

/**

* 每个字符串分配16个位

*/

MIDDLE(new int[] { 2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53 }), //

/**

* 每个字符串分配32个位

*/

HIGH(new int[] { 2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73, 79, 83, 89, 97,

101, 103, 107, 109, 113, 127, 131 });

private int[] seeds;

private MisjudgmentRate(int[] seeds) {

this.seeds = seeds;

}

public int[] getSeeds() {

return seeds;

}

public void setSeeds(int[] seeds) {

this.seeds = seeds;

}

}

public static void main(String[] args) {

BloomFileter fileter = new BloomFileter(7);

System.out.println(fileter.addIfNotExist("1111111111111"));

System.out.println(fileter.addIfNotExist("2222222222222222"));

System.out.println(fileter.addIfNotExist("3333333333333333"));

System.out.println(fileter.addIfNotExist("444444444444444"));

System.out.println(fileter.addIfNotExist("5555555555555"));

System.out.println(fileter.addIfNotExist("6666666666666"));

System.out.println(fileter.addIfNotExist("1111111111111"));

fileter.saveFilterToFile("C:\\Users\\john\\Desktop\\1111\\11.obj");

fileter = readFilterFromFile("C:\\Users\\john\\Desktop\\111\\11.obj");

System.out.println(fileter.getUseRate());

System.out.println(fileter.addIfNotExist("1111111111111"));

}

}

代码转载于JAVA实现较完善的布隆过滤器