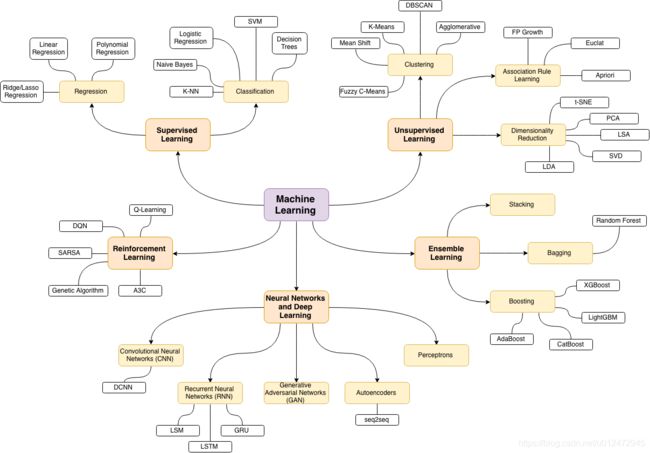

机器学习算法分类-总览

目录

一、机器学习算法类型

1. 监督学习(Supervised Learning)

2.无监督学习(Unsupervised Learning)

3.强化学习(Reinforcement Learning)

4.神经网络与深度学习(Neural Networks and Deep Learning)

5.集成学习(Ensemble Learning)

二、分类、回归、聚类、降维的区别

1.分类&回归(Classification & Regression)

2.聚类(Clustering)

3.降纬(Dimensionality Reduction)

一、机器学习算法类型

1. 监督学习(Supervised Learning)

该算法由一个目标/结果变量(或因变量)组成,该变量将从给定的一组预测变量(自变量)中预测。使用这些变量集,我们生成一个将输入映射到所需输出的函数。训练过程继续进行,直到模型在训练数据上达到所需的准确度。

-

回归(Regression)

-

线性回归(Linear Regression)

-

多项式回归(Polnomial Regression)

-

岭/Lasson回归(Ridge/Lasson Regression)

-

-

分类(Classfication)

-

K近邻(K-NN)

-

朴素贝叶斯(Naive Bayes)

-

逻辑回归(Logistic Regression)

-

支持向量机(SVM)

-

决策树(Decision Trees)

-

2.无监督学习(Unsupervised Learning)

在此算法中,我们没有任何目标或结果变量来进行预测/估计。它用于将人群进行聚类到不同群体中,广泛用于将客户划分到不同的群体中去并进行具体的干预。

-

聚类(Clustering)

-

模糊C均值聚类(Fuzzy C-Means)

-

均值偏移(Mean Shift)

-

K均值聚类(K-Means)/K中心点聚类(K-Core)

-

密度聚类(DBSCAN)

-

层次聚类(Agglomerative)

-

-

关联规则(Association Rules)

-

FP-Growth

-

深度优先(Euclat)

-

挖掘关联规则的频繁项集算法(Apriori)

-

-

降维(Dimensionality Reduction)

-

t-分布领域嵌入算法(t-sne)

-

主成分分析(PCA)-无监督的数据降维

-

潜在语义分析(LSA)

-

奇异值分解(SVD)

-

LDA-有监督的数据降维

-

3.强化学习(Reinforcement Learning)

使用这种算法,机器经过培训,可以做出具体决策。它的工作原理是这样的:机器暴露在一个环境中,在这个环境中,它通过反复试验不断地训练自己。机器从过去的经验中学习,并尝试获取尽可能好的知识,以做出准确的业务决策。

4.神经网络与深度学习(Neural Networks and Deep Learning)

- 神经网络:一种可以通过观测数据使计算机学习的仿生语言范例

深度学习:一组强大的神经网络学习技术

-

卷积神经网络(Convolutional Neural Networks)(CNN)

-

基于深度卷积神经网络(D-CNN)

-

-

循环神经网络(Recurrent Neural Networks)(RNN)

-

LSM(Log Structured Merge Trees)

-

GRU

-

LSTM

-

-

生成对抗网络(Generative Adversarial Networks)

-

自编码器(Autoencoders)

-

图神经网络

-

GNN

-

Louvain

-

最小生成树(Kruskal算法和Prim算法)

-

PageRank

-

LPA(标签传播算法)

-

5.集成学习(Ensemble Learning)

二、分类、回归、聚类、降维的区别

![]()

机器学习主要分为四大块,分别是:

Classification (分类),Regression (回归), Clustering (聚类), Dimensionality Reduction (降维)。

给定一个样本特征 , 我们希望预测其对应的属性值 , 如果是离散的, 那么这就是一个分类问题,反之,如果 是连续的实数, 这就是一个回归问题。

如果给定一组样本特征 , 我们没有对应的属性值 , 而是想发掘这组样本在维空间的分布, 比如分析哪些样本靠的更近,哪些样本之间离得很远, 这就是属于聚类问题。

如果我们想用维数更低的子空间来表示原来高维的特征空间, 那么这就是降维问题。

1.分类&回归(Classification & Regression)

无论是分类还是回归,都是想建立一个预测模型 ,给定一个输入 , 可以得到一个输出 , 不同的只是在分类问题中, 是离散的; 而在回归问题中 是连续的。所以总得来说,两种问题的学习算法都很类似。所以在这个图谱上,我们看到在分类问题中用到的学习算法,在回归问题中也能使用。分类问题最常用的学习算法包括 SVM (支持向量机) , SGD (随机梯度下降算法), Bayes (贝叶斯估计), Ensemble, KNN 等。而回归问题也能使用 SVR, SGD, Ensemble 等算法,以及其它线性回归算法。

2.聚类(Clustering)

聚类也是分析样本的属性, 有点类似classification, 不同的就是classification 在预测之前是知道 的范围, 或者说知道到底有几个类别, 而聚类是不知道属性的范围的。所以 classification 也常常被称为 supervised learning, 而clustering就被称为unsupervised learning。

clustering 事先不知道样本的属性范围,只能凭借样本在特征空间的分布来分析样本的属性。这种问题一般更复杂。而常用的算法包括 k-means (K-均值), GMM (高斯混合模型) 等。

3.降纬(Dimensionality Reduction)

降维是机器学习另一个重要的领域, 降维有很多重要的应用, 特征的维数过高, 会增加训练的负担与存储空间, 降维就是希望去除特征的冗余, 用更加少的维数来表示特征.降维算法最基础的就是PCA了, 后面的很多算法都是以PCA为基础演化而来。