LVS介绍及其应用

文章目录

- 1. 概述

- 2. 体系架构

- 2.1 工作过程

- 2.2 体系架构

- 2.3 调度算法

- (1)算法说明

- 应用环境选择

- (2)工作原理

- (3)术语介绍

- 3. LVS集群模式

- 3.1 LVS-NAT

- (1)实现原理

- (2)模式特性

- 3.2 LVS-DR

- (1)实现原理

- (2)模式特性

- 3.3 LVS-TUN

- (1) 实现原理

- (2)模式特性

- 4. LVS核心组件与模块

- 4.1 ipvsadm组件

- (1)组件介绍

- (2)安装

- (3)基本介绍

- 5. LVS示例搭载

- 5.1 LVS-DR配置及运用

- (1)基础环境准备

- 1)节点规划

- 2)配置主机名(四个节点)

- 3) 配置防火墙(四个节点)

- 4)同步时钟源(四个节点)

- (2)配置NFS数据共享服务器

- 1)配置服务端

- 2)配置exports文件

- 3)启动服务

- 3)本地挂载测试

- 4)在rs1,rs2上配置nfs客户端:rs2执行相同操作

- (3)配置web服务器

- 1)安装服务

- 2)启动服务

- 3)挂在网页共享目录

- 4)创建测试目录:nfs服务器上

- 5)网页测试

- (4)配置负载均衡服务器

- 1)下载ipvs管理工具

- 2)配置lvs

- 3)在rs1,rs2上绑定ip到回环网卡上

- 4)调整内核参数,关闭arp相应:rs1,rs2

- (5)集群功能测试

- 5.2 LVS-NAT的配置及运用

- (1)基础环境准备

- 1)节点规划

- 2)处理防火墙

- 3)同步时钟源

- 4)配置网络

- 5)测试网络连通性

- (2)配置nfs-server数据共享服务器

- (3)配置web服务器

- (4)配置LVS负载调度服务器

- 1)配置LVS

- 2)重新配置nfs服务器

- 3)重新挂在共享文件

- (5)集群功能测试

- 5.3 构建LVS集群注意事项

1. 概述

LVS(Linux Virtual Server)即Linux虚拟服务器,是由章文嵩博士主导的开源负载均衡项目,目前LVS已经被集成到Linux内核模块中。该项目在Linux内核中实现了基于IP的数据请求负载均衡调度方案。

2. 体系架构

2.1 工作过程

(1)终端互联网用户从外部访问公司的外部负载均衡服务器,终端用户的Web请求会发送给LVS调度器,调度器根据自己预设的算法决定将该请求发送给后端的某台Web服务器。

(2)终端用户访问LVS调度器虽然会被转发到后端真实的服务器,但如果真实服务器连接的是相同的存储,提供的服务也是相同的服务,最终用户不管是访问哪台真实服务器,得到的服务内容都是一样的,整个集群对用户而言都是透明的。

(3)根据LVS工作模式的不同,真是服务器会选择不同的方式将用户需要的数据发送到终端用户,LVS工作模式分为NAT模式,TUN模式,DR模式。

2.2 体系架构

(1)最前端的负载均衡层(Loader Balancer)

由负载调度器组成,LVS模块就安装在负载调度器上,同时也可能是一个真实的server。

作用:类似于一个路由器,含有完成LVS功能所设定的路由表,通过这些路由表把用户的请求分发给服务器集群层的应用服务器上

类似于一个路由器,含有完成LVS功能所设定的路由表,通过这些路由表把用户的请求分发给服务器集群层的应用服务器上

(2)中间的服务器群组层,用Server Array表示

由一组实际运行应用服务的机器组成,真实服务器可以是WEB服务器、MAIL服务器、FTP服务器、DNS服务器、视频服务器中的一个或者多个,每个Real Server之间通过高速的LAN或分布在各地的WAN相连接。几乎可以是所有的系统平台,Linux、windows、Solaris、AIX、BSD系列都能很好的支持。

(3)最底层的数据共享存储层,用Shared Storage表示

是为所有Real Server提供共享存储空间和内容一致性的存储区域,在物理上,一般有磁盘阵列设备组成,为了提供内容的一致性,一般可以通过网络共享文件系统实现。

在用户看来所有的应用都是透明的,用户只是在使用一个虚拟服务器提供的额高性能服务。

2.3 调度算法

LVS的调度算法决定了如何在集群节点之间分布工作负荷,当director调度器收到来自客户端访问VIP的集群服务的入栈请求时,director调度器必须决定那个集群节点应该处理请求。

(1)算法说明

Director调度器用的调度方法分类:

固定调度算法:rr,wrr,dh,sh…

动态调度算法:wlc,lc,lblc,lblcr

| 算法名称 | 说明 |

|---|---|

| rr | 轮询调度(Round-Robin),将请求一次分配给不同的RS,也就是均摊,适用于处理真是服务器性能相差不大的情况 |

| wrr | 加权轮询调度(Weighted Round-Robin),根据不同RS的权值分配任务,权值较高的RS将优先获取任务,分配的连接数比权值低的RS更多,相同权值的RS获得相同数目的连接数 |

| dh | 目的哈希调度(Destination Hashing),以目的地址为关键词查找一个静态hash表来获得需要的RS |

| sh | 源地址哈希调度(source hashing)以源地址为关键字查找一个静态hash表来获得需要的RS。 |

| wlc | 加权最小连接数调度(weighted leastconnection),会根据连接数和权值的不比值来算,最小比值的真实服务器将会获取下一个链接。 |

| lc | 最小连接数调度(Least-Connection),IPVS表存储了所有的活动的连接。把新的连接请求发送到当前连接数最小的RS。 |

| lblc | 基于地址的最小连接数调度(locality-Based Least-Connection),将来自同一目的地址的请求分配给同一台RS(此服务器当前还未满负荷),若此服务器当前已经满负荷,则之后的链接将分配给当前连接数最小的RS,并下一次优先考虑此台服务器。 |

| lblcr | 基于地址带重复最小连接数调度(Locality-Based Least-Connection with Replication),每个目的地址对应一个RS子集,对于次地址请求,为他分配子集中连接数最小的RS,如果服务器中所有子集均已满负荷,则从集群中选择一个连接数较小的服务器,将他加入到此子集中并分配链接;若一定时间内,违背做任何修改,则子集中负载最大的节点将会从子集中删除。 |

| SED | 最短期望的延迟(shortest expected delay scheduling SED),基于wlc算法。动态的wlc算法:若ABC三台服务器的权重分别为1,2,3,此时的连接数也是1,2,3。那么基于wlc算法的话,此时新来一个链接会随机给ABC服务器其中的一台;而SED则是动态的算出最小的比值,即A:(1+1)/1; B:(1+2)/2; C:(1+3)/3,此时可以算出C服务器的比值最小,将会将新的连接交给服务器C。 |

| NQ | 最小队列调度(Never Queue Scheduling NQ),即按照目前所有服务器的连接数来比较,最小的连接数将会分配下一个链接 |

应用环境选择

一般的网络服务,如http,mail,mysql等常用的LVS调度算法为

基本轮询调度rr

加权最小连接调度wlc

加权轮询调度wrc

基于局部性的最小连接lblc和带复制的给予局部性最小连接lblcr主要适用于web cache和DB cache

源地址散列调度SH和目标地址散列调度DH可以结合使用在防火墙集群中,可以保证整个系统的出入口唯一

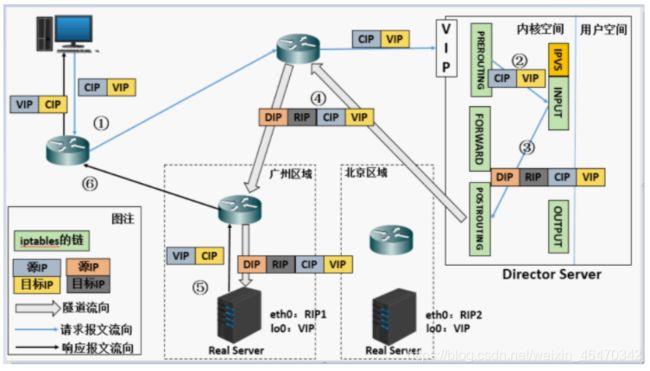

(2)工作原理

用户向负载均衡器(Director Server)发送请求时,调度器会将请求发送到内核空间

PREROUTING链首先会接收到用户请求,判断目标IP确定是本机IP,将数据包发往INPUT链

INPUT链上的IPVS会将请求与自己定义好的集群服务进行对比,如果用户请求的就是定义的集群服务,那么IPVS就会强行修改数据包里的IP地址及端口,并将新的数据发送POSTROUTING链

POSTROUTING链收到数据包后发现IP地址刚好是自己的后端服务器,通过选路将数据包最终发送给后端服务器

(3)术语介绍

DS: Director Server。指的是前端负载均衡器节点。

RS:Real Server。后端真实的工作服务器。

VIP:向外部直接面向客户端用户请求,作为用户请求的目标的IP地址。

DIP:Director Server IP,主要用于和内部主机通讯的IP地址。面向真实服务器的IP

RIP:Real Server IP,后端服务器的IP地址。

CIP:Client IP,访问客户端的IP地址

3. LVS集群模式

3.1 LVS-NAT

NAT(Network Address Translation)即网络地址转换

作用:通过数据报头的修改,使得位于企业内部私有IP地址可以访问外网,以及外部用户可以访问位于公司内部的私有IP主机

(1)实现原理

通过将请求报文中的目标IP地址与目标端口修改,来实现报文的传送

当用户请求到达Director Server,此时请求的数据报文会先到内核空间PREROUTING链。 此时报文的源IP为CIP,目标IP为VIP

PREROUTING检查发现数据包的目标IP是本机,将数据包送至INPUT链

IPVS比对数据包请求的服务是否为集群服务,若是,修改数据包的目标IP地址为后端服务器IP,后将数据包发至POSTROUTING链。 此时报文的源IP为CIP,目标IP为RIP

POSTROUTING链通过选路,将数据包发送给Real Server

Real Server比对发现目标为自己的IP,开始构建响应报文发回给Director Server。 此时报文的源IP为RIP,目标IP为CIP

Director Server在响应客户端前,此时会将源IP地址修改为自己的VIP地址,然后响应给客户端。 此时报文的源IP为VIP,目标IP为CIP

(2)模式特性

RS应该和DIP应该使用私网地址,且RS的网关要指向DIP;

请求和响应报文都要经由director转发;极高负载的场景中,director可能会成为系统瓶颈;

支持端口映射;

RS可以使用任意OS;

RS的RIP和Director的DIP必须在同一IP网络;

缺陷:对Director Server压力会比较大,请求和响应都需经过director server,director往往会成为系统的性能瓶颈

3.2 LVS-DR

(1)实现原理

通过为请求报文重新封装一个MAC首部进行转发,源MAC是DIP所在的接口的MAC,目标MAC是某挑选出的RS的RIP所在接口的MAC地址;源IP/PORT,以及目标IP/PORT均保持不变。

当用户请求到达Director Server,此时请求的数据报文会先到内核空间的PREROUTING链。 此时报文的源IP为CIP,目标IP为VIP

PREROUTING检查发现数据包的目标IP是本机,将数据包送至INPUT链

IPVS比对数据包请求的服务是否为集群服务,若是,将请求报文中的源MAC地址修改为DIP的MAC地址,将目标MAC地址修改RIP的MAC地址,然后将数据包发至POSTROUTING链。 此时的源IP和目的IP均未修改,仅修改了源MAC地址为DIP的MAC地址,目标MAC地址为RIP的MAC地址

由于DS和RS在同一个网络中,所以是通过二层来传输。POSTROUTING链检查目标MAC地址为RIP的MAC地址,那么此时数据包将会发至Real Server。

RS发现请求报文的MAC地址是自己的MAC地址,就接收此报文。处理完成之后,将响应报文通过lo接口传送给eth0网卡然后向外发出。 此时的源IP地址为VIP,目标IP为CIP

响应报文最终送达至客户端

(2)模式特性

确保前端路由器将目标IP为VIP的请求报文发往Director:

在前端网关做静态绑定;

在RS上使用arptables;

在RS上修改内核参数以限制arp通告及应答级别;修改RS上内核参数(arp_ignore和arp_announce)将RS上的VIP配置在lo接口的别名上,并限制其不能响应对VIP地址解析请求。

RS的RIP可以使用私网地址,也可以是公网地址;RIP与DIP在同一IP网络;RIP的网关不能指向DIP,以确保响应报文不会经由Director;

RS跟Director要在同一个物理网络;

请求报文要经由Director,但响应不能经由Director,而是由RS直接发往Client;

缺陷:

RS和DS必须在同一机房中,因为它是由二层进行转发的根据MAC地址来进行匹配。

3.3 LVS-TUN

(1) 实现原理

在原有的IP报文外再次封装多一层IP首部,内部IP首部(源地址为CIP,目标IIP为VIP),外层IP首部(源地址为DIP,目标IP为RIP)

当用户请求到达Director Server,此时请求的数据报文会先到内核空间的PREROUTING链。 此时报文的源IP为CIP,目标IP为VIP 。

PREROUTING检查发现数据包的目标IP是本机,将数据包送至INPUT链

IPVS比对数据包请求的服务是否为集群服务,若是,在请求报文的首部再次封装一层IP报文,封装源IP为为DIP,目标IP为RIP。然后发至POSTROUTING链。 此时源IP为DIP,目标IP为RIP

POSTROUTING链根据最新封装的IP报文,将数据包发至RS(因为在外层封装多了一层IP首部,所以可以理解为此时通过隧道传输)。 此时源IP为DIP,目标IP为RIP

RS接收到报文后发现是自己的IP地址,就将报文接收下来,拆除掉最外层的IP后,会发现里面还有一层IP首部,而且目标是自己的lo接口VIP,那么此时RS开始处理此请求,处理完成之后,通过lo接口送给eth0网卡,然后向外传递。 此时的源IP地址为VIP,目标IP为CIP

响应报文最终送达至客户端

(2)模式特性

当用户请求到达Director Server,此时请求的数据报文会先到内核空间的PREROUTING链。 此时报文的源IP为CIP,目标IP为VIP 。

PREROUTING检查发现数据包的目标IP是本机,将数据包送至INPUT链

IPVS比对数据包请求的服务是否为集群服务,若是,在请求报文的首部再次封装一层IP报文,封装源IP为为DIP,目标IP为RIP。然后发至POSTROUTING链。 此时源IP为DIP,目标IP为RIP

POSTROUTING链根据最新封装的IP报文,将数据包发至RS(因为在外层封装多了一层IP首部,所以可以理解为此时通过隧道传输)。 此时源IP为DIP,目标IP为RIP

RS接收到报文后发现是自己的IP地址,就将报文接收下来,拆除掉最外层的IP后,会发现里面还有一层IP首部,而且目标是自己的lo接口VIP,那么此时RS开始处理此请求,处理完成之后,通过lo接口送给eth0网卡,然后向外传递。 此时的源IP地址为VIP,目标IP为CIP

响应报文最终送达至客户端

4. LVS核心组件与模块

LVS已经集成到了linux内核模块中,但在整个LVS环境又分为内核层和用户层,内核层负责内核算法的

实现,用户层需要安装ipsadm工具,通过命令将管理员需要的工作模式与实现算法传递给内核。

4.1 ipvsadm组件

(1)组件介绍

LVS工作在ISO模型中的第四层,和iptables类似,必须工作在内核空间上,叫ipvs;主流的linux发行版默认集成了ipvs,因此只需要安装一个管理工具ipvsadm即可

(2)安装

先查看组件

[root@master ~]# grep -i 'ip_vs' /boot/config-3.10.0-957.el7.x86_64

CONFIG_IP_VS=m

CONFIG_IP_VS_IPV6=y

# CONFIG_IP_VS_DEBUG is not set

CONFIG_IP_VS_TAB_BITS=12

CONFIG_IP_VS_PROTO_TCP=y

CONFIG_IP_VS_PROTO_UDP=y

CONFIG_IP_VS_PROTO_AH_ESP=y

CONFIG_IP_VS_PROTO_ESP=y

CONFIG_IP_VS_PROTO_AH=y

CONFIG_IP_VS_PROTO_SCTP=y

CONFIG_IP_VS_RR=m

CONFIG_IP_VS_WRR=m

CONFIG_IP_VS_LC=m

CONFIG_IP_VS_WLC=m

CONFIG_IP_VS_LBLC=m

CONFIG_IP_VS_LBLCR=m

CONFIG_IP_VS_DH=m

CONFIG_IP_VS_SH=m

CONFIG_IP_VS_SED=m

CONFIG_IP_VS_NQ=m

CONFIG_IP_VS_SH_TAB_BITS=8

CONFIG_IP_VS_FTP=m

CONFIG_IP_VS_NFCT=y

CONFIG_IP_VS_PE_SIP=m

#注:若是没有输出内容,很有可能是内核模块没有加载

#加载命令

[root@master ~]# modprobe ip_vs

#安装

yum install ipvsadm -y

(3)基本介绍

ipvsadm组件定义规则的格式

# 定义

ipvsadm -A|E -t|u|f service-address [-s scheduler]

[-p [timeout]] [-M netmask]

-A: 表示添加一个新的集群服务

-E: 编辑一个集群服务

-t: 表示tcp协议

-u: 表示udp协议

-f: 表示firewall-Mark,防火墙标记

service-address: 集群服务的IP地址,即VIP

-s 指定调度算法

-p 持久连接时长,如#ipvsadm -Lcn ,查看持久连接状态

-M 定义掩码

ipvsadm -D -t|u|f service-address 删除一个集群服务

ipvsadm -C 清空所有的规则

ipvsadm -R 重新载入规则

ipvsadm -S [-n] 保存规则

ipvsadm -a|e -t|u|f service-address -r server-address

# 添加

ipvsadm -a|e -t|u|f service-address -r server-address

[-g|i|m] [-w weight]

-a 添加一个新的realserver规则

-e 编辑realserver规则

-g 表示定义为LVS-DR模型

-i 表示定义为LVS-TUN模型

-m 表示定义为LVS-NAT模型

-w 定义权重,后面跟具体的权值

# 查看

ipvsadm -L|l [options]

常用选项[options]如下:

-n: 数字格式显示主机地址和端口

--stats:统计数据

--rate: 速率

--timeout: 显示tcp、tcpfin和udp的会话超时时长

-c: 显示当前的ipvs连接状况

# 清除所有

ipvsadm -C

# 保存规则

(1)手动保存

ipvsadm -S|--save > /etc/sysconfig/ipvsadm

ipvsadm -R < /etc/sysconfig/ipvsadm

(2)修改配置文件

# Unload modules on restart and stop

# Value: yes|no, default: yes

# This option has to be 'yes' to get to a sane state for a ipvs

# restart or stop. Only set to 'no' if there are problems unloading ipvs

# modules.

IPVS_MODULES_UNLOAD="yes"

# Save current ipvs rules on stop.

# Value: yes|no, default: no

# Saves all ipvs rules to /etc/sysconfig/ipvsadm if ipvsadm gets stopped

# (e.g. on system shutdown).

# 若ipvsadm服务停止,所有的规则将会保存在/etc/sysconfig/ipvsadm文件内

IPVS_SAVE_ON_STOP="yes"

# Save current ipvs rules on restart.

# Value: yes|no, default: no

# Saves all ipvs rules to /etc/sysconfig/ipvsadm if ipvsadm gets

# restarted.

# 重启时保存当前规则

IPVS_SAVE_ON_RESTART="yes"

# Numeric status output

# Value: yes|no, default: yes

# Print IP addresses and port numbers in numeric format in the status output.

IPVS_STATUS_NUMERIC="yes"

:wq

此时重启服务,然后设置的规则将会在重启,停止服务时保存,且在正常开启服务时加载。

5. LVS示例搭载

5.1 LVS-DR配置及运用

(1)基础环境准备

LVS调度器只作为WEB访问入口;Web访问出口由各个节点服务器分别承担

1)节点规划

| 节点名称 | ip | 角色 | 说明 |

|---|---|---|---|

| DS | IP:192.168.10.23; VIP:192.168.10.200 | LVS负载调度器 | VIP为LVS的浮动IP |

| RS1 | 192.168.10.11 | 真实服务器1 | 提供web服务 |

| RS2 | 192.168.10.12 | 真实服务器2 | 提供web服务 |

| NFS-server | 192.168.10.61 | 数据共享服务器 | 提供网页共享数据 |

注:web服务器选择appache,数据共享服务器选择nfs

2)配置主机名(四个节点)

hostnamectl set-hostname 主机名

su -l

3) 配置防火墙(四个节点)

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

4)同步时钟源(四个节点)

yum -y install ntp ntpdate

ntpdate cn.pool.ntp.org

hwclock --systohc

(2)配置NFS数据共享服务器

1)配置服务端

[root@nfs-server ~]# yum install nfs-utils rpcbind

[root@nfs-server ~]# rpm -qa nfs-utils rpcbind

rpcbind-0.2.0-49.el7.x86_64

nfs-utils-1.3.0-0.66.el7.x86_64

2)配置exports文件

[root@nfs-server ~]# cat /etc/exports

/data 192.168.10.0/24(rw,sync)

3)启动服务

[root@nfs-server ~]# systemctl restart nfs

[root@nfs-server ~]# grep nfs /etc/passwd

rpcuser:x:29:29:RPC Service User:/var/lib/nfs:/sbin/nologin

nfsnobody:x:65534:65534:Anonymous NFS User:/var/lib/nfs:/sbin/nologin

[root@nfs-server ~]# mkdir /data

[root@nfs-server ~]# chown -R nfsnobody:nfsnobody /data/

[root@nfs-server ~]# ll -d /data/

drwxr-xr-x. 2 nfsnobody nfsnobody 6 8月 5 12:04 /data/

3)本地挂载测试

[root@nfs-server ~]# mount 192.168.10.61:/data /mnt/data

[root@nfs-server ~]# df -Th

文件系统 类型 容量 已用 可用 已用% 挂载点

192.168.10.61:/data nfs4 10G 1.4G 8.7G 14% /mnt/data

[root@nfs-server ~]# ls /data/

[root@nfs-server ~]# ls /mnt/data/

[root@nfs-server ~]# touch /data/a

[root@nfs-server ~]# ll /data/

总用量 0

-rw-r--r--. 1 root root 0 8月 5 12:07 a

[root@nfs-server ~]# ll /mnt/data/

总用量 0

-rw-r--r--. 1 root root 0 8月 5 12:07 a

4)在rs1,rs2上配置nfs客户端:rs2执行相同操作

# (1)安装软件

[root@rs1 ~]# yum install nfs-utils -y

#(2)本地测试

[root@rs1 ~]# showmount -e 192.168.10.61

Export list for 192.168.10.61:

/data 192.168.10.0/24

(3)配置web服务器

1)安装服务

[root@rs1 ~]# yum install httpd -y

2)启动服务

[root@rs1 ~]# systemctl start httpd

[root@rs1 ~]# systemctl enable httpd

3)挂在网页共享目录

[root@rs1 ~]# mount -t nfs 192.168.10.61:/data /var/www/html/

[root@rs1 ~]# vim /etc/fstab

192.168.10.61:/data /var/www/html nfs default 0 0

[root@rs1 ~]# mount -a

4)创建测试目录:nfs服务器上

[root@nfs-server ~]# vim /data/index.html

<HTML>

<head>

<title>NFS_test</title>

</head>

<body>

<h1>This is a test</h1>

</body>

</HTML>

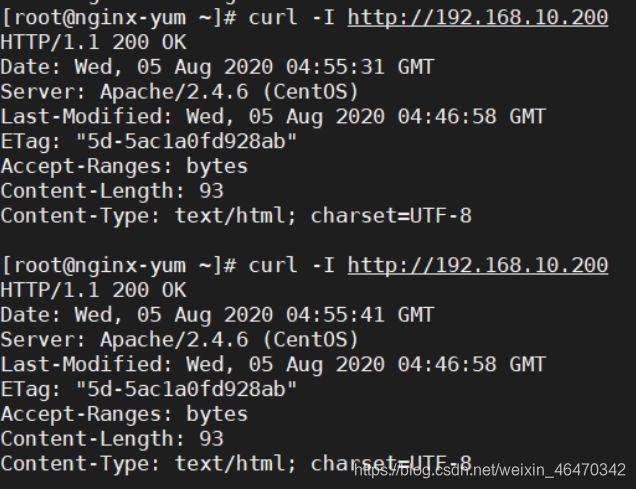

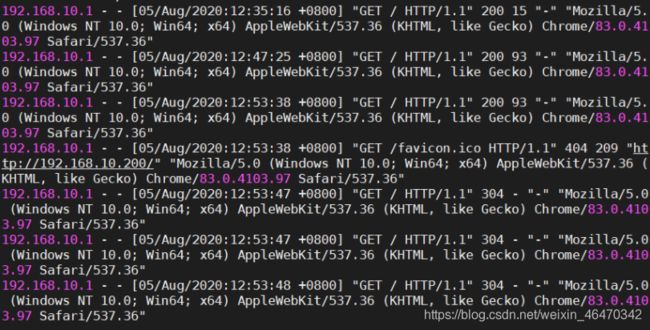

5)网页测试

(4)配置负载均衡服务器

1)下载ipvs管理工具

[root@ds ~]# yum install ipvsadm -y

2)配置lvs

# 绑定浮动IP

[root@ds ~]# nmcli conn show

NAME UUID TYPE DEVICE

ens33 16900176-7f16-4273-b386-84c47666f2bb ethernet ens33

[root@ds ~]# nmcli conn mod ens33 +ipv4.addr 192.168.10.200/24

[root@ds ~]# systemctl restart network

# 添加规则

[root@ds ~]# ipvsadm -A -t 192.168.10.200:80 -s rr

[root@ds ~]# ipvsadm -a -t 192.168.10.200:80 -r 192.168.10.11 -g

[root@ds ~]# ipvsadm -a -t 192.168.10.200:80 -r 192.168.10.12 -g

# 查看规则

[root@ds ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.10.200:80 rr

-> 192.168.10.11:80 Route 1 0 0

-> 192.168.10.12:80 Route 1 0 0

# 设置缓存时间

[root@ds ~]# ipvsadm --set 1 2 1

3)在rs1,rs2上绑定ip到回环网卡上

[root@rs1 ~]# cd /etc/sysconfig/network-scripts/

[root@rs1 network-scripts]# vim ifcfg-lo:10

CE=lo:10

IPADDR=192.168.10.200

NETMASK=255.255.255.255

ONBOOT=yes

[root@rs1 network-scripts]# systemctl restart network

4)调整内核参数,关闭arp相应:rs1,rs2

[root@rs1 network-scripts]# vim /etc/sysctl.conf

[root@rs1 network-scripts]# sysctl -p

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

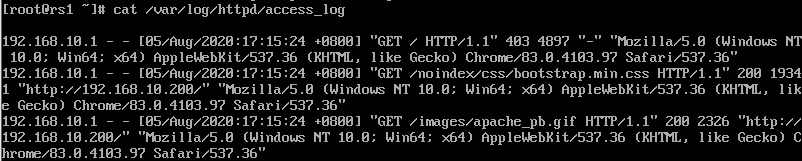

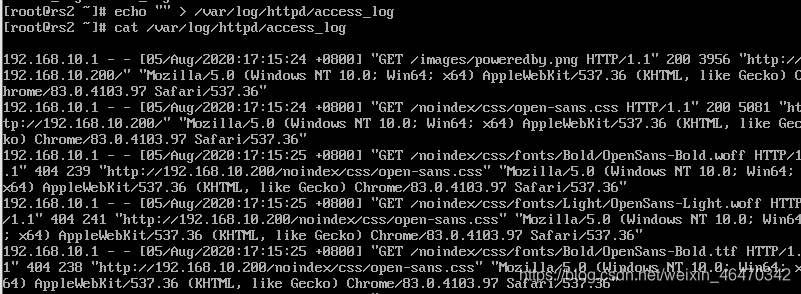

(5)集群功能测试

测试:起一个新的虚拟机:192.168.10.22

rs1上的日志信息

rs2上的日志信息

5.2 LVS-NAT的配置及运用

(1)基础环境准备

注:本次实例为修改上面的LVS-DR实例,本身已经安装好了服务器各项配置,若需下载服务器包等操作,yum等 ,最好需要先安装好服务器,再修改IP信息。

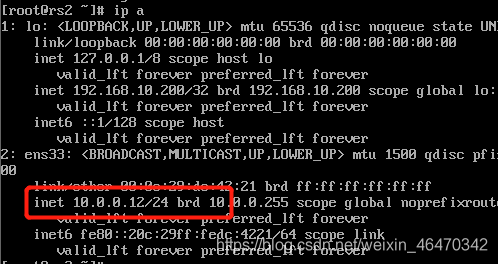

1)节点规划

| 主机 | ip | 角色 | 说明 |

|---|---|---|---|

| DS | IP1:192.168.10.23; IP2:10.0.0.20; VIP:192.168.10.200 | LVS负载调度器 | VIP为LVS上的浮动IP |

| RS1 | 10.0.0.11 | 真实服务器1 | 提供web服务 |

| RS2 | 10.0.0.12 | 真实服务器2 | 提供web服务 |

| nfs-server | 10.10.13 | 数据共享服务器 | 提供网页共享数据 |

2)处理防火墙

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

3)同步时钟源

yum -y install ntp ntpdate

ntpdate cn.pool.ntp.org

hwclock --systohc

4)配置网络

外网为nat模式,内网为仅主机模式

ds服务器网络

rs1网络:网关指向DS服务器上的192.168.10.23

rs2上:网关指向192.168.10.23(DS)

nfs-server服务器上

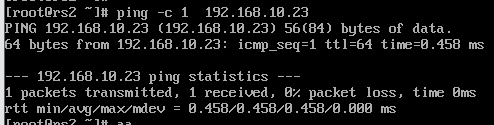

5)测试网络连通性

ds服务器上测试

rs1测试:

rs2上测试

nfs-server服务器上测试

(2)配置nfs-server数据共享服务器

此处为修改上面的DR模式,若需要重新配置则需要先配置服务器在修改ip

(3)配置web服务器

此处为修改上面的DR模式,若需要重新配置则需要先配置服务器在修改ip

(4)配置LVS负载调度服务器

1)配置LVS

[root@ds ~]# ipvsadm -A -t 192.168.10.200:80 -s rr

[root@ds ~]# ipvsadm -a -t 192.168.10.200:80 -r 10.0.0.11:80 -m

[root@ds ~]# ipvsadm -a -t 192.168.10.200:80 -r 10.0.0.12:80 -m

[root@ds ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.10.200:80 rr

-> 10.0.0.11:80 Masq 1 0 0

-> 10.0.0.12:80 Masq 1 0 0

开启路由转发

# 临时生效

[root@ds ~]# echo 1 > /proc/sys/net/ipv4/ip_forward

# 永久配置

[root@ds ~]# vim /etc/sysctl.conf

[root@ds ~]# sysctl -p

net.ipv4.ip_forward = 1

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.ens38.send_redirects = 0

2)重新配置nfs服务器

[root@nfs-server ~]# cat /etc/exports

/data 10.0.0.0/24(rw,sync)

# 重启服务

systemctl restart nfs

3)重新挂在共享文件

# rs服务器都进行

[root@rs1 ~]# cat /etc/fstab

10.0.0.20:/data /var/www/html

[root@rs1 ~]# mount -a

若此时卡住,需要将rs服务器重启

(5)集群功能测试

5.3 构建LVS集群注意事项

NAT模式下

(1)路由转发:

LVS调度器必须能够提供数据转发功能,而CentOS7 系统默认的规则没有开启,需要手动修改/etc/sysctl.conf文件开启该功能。

(2)该模式下,调度器除了担当调度的角色外,还要担当路由的角色,但CentOS7 下防火墙转发规则默认为

禁止转发,因此需要设置容许规则:

[root@bogon ~]# firewall-cmd --set-default-zone=trusted。

(3真实服务器网关必须指向调度服务器IP。

DR模式下

该模式下所有的真实服务器都配置了VIP地址,因此需要设置服务器不进行正对VIP地址的ARP广播,linux可直接通过arp_ignore与arp_announce来实现。

arp_ignore用来定义网卡在相应外部ARP请求时的响应级别。

0:默认,任何网络的接口收到ARP请求后,如果本机的任意接口有该IP。则给予相应。

1:某个网络接口收到ARP请求后,判断请求的IP地址是否为本地接口,是则回应,否则不回应。LVS调度器会

将客户请求转发给真实服务器的eth0接口,而真实服务的VPI地址配置在本地的回环设备上。

arp_announce用来定义网卡广播ARP包时的级别

0:默认,任何网络接口收到ARP请求后,如果本机的任意接口有该IP,则相应

1:尽量避免相应MAC地址非本网络接口IP地址的ARP请求。

2:不相应MAC地址非本网络接口IP地址的ARP请求。

------------------------------------------------------------------------------------------------------- 返回目录