论文阅读笔记:End-to-End Blind Image Quality Assessment Using Deep Neural Networks

论文提出一种多任务端到端优化的深度神经网络(MEON)做BIQA(blind image quality assessment)。

MEON包括两部分网络:失真判别网络和质量预测网络。

与传统的训练方法多任务网络不同,训练过程分为两个阶段。第一步,训练失真类型识别子网络。在第二步中,从训练的早期层和第一个子网的输出开始,使用随机梯度下降法的变体训练质量预测子网。与大多数不同深度神经网络,选择生物学启发的广义除法归一化(GDN),而不是经过校正的线性单位(ReLU)激活功能。我们凭经验证明GDN可以有效减少模型参数/层数,同时实现相似的质量预测性能。适度的模型复杂性方面,拟议的MEON指数达到了最新水平四个公开基准的效果。此外,使用群组最大差异竞争竞争方法论证了MEON相对于最新BIQA模型的强大竞争力。

Network Architecture

输入: 256 × 256 × 3 raw image

输出:图像失真类型(子网络1)和预测质量(子网络2)

GDN定义:

其中,S代表维度,偏差向量β,权重矩阵γ,其值都>=0

输入结构:

![]()

输入

Xk代表第k个图像, P(k)代表第k个图像的失真类型, q(k)代表第k个图像的MOS值

早期的共享层参数表示为W,经过在卷积池化后。用64维特征向量表示256×256×3原始图像,子网1的参数表示为W1,将预测出的失真类型,我们采用softmax函数将范围编码为[0,1]

失真类型预测

![]()

C种失真类型的概率

子网1的损失函数

经验交叉熵损失

子网2的参数表示为W2,其损失函数为

L1范式

其中,

si是第i类失真对应的分数

因此,整个网络的损失函数可定义为

损失函数

训练第一步,最小化子网1的损失函数,第二布,联合优化,最小化整个损失函数。实验过程及结果参见论文。

Experiments:

mini-batch = 40

初始化 learning rate α = 10e−2 , 按照10倍下降,固定在10e-4

数据集:

LIVE , CSIQ , TID2013 , Waterloo Exploration Database

Evaluation Criteria:

Spearman’s rank-order correlation coefficient (SRCC):

Pearson linear correlation coefficient (PLCC):

D-test:Pristine/distorted image discriminability test(原始/失真图像辨别性测试)。给定一个数据库,我们将原始和失真图像的分组分别设为Sp和Sd, 基于模型预测,可以找到最优阈值T *以最大化正确的分类率

D-test

![]()

条件

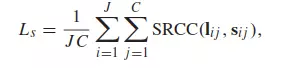

L-test:List wise ranking consistency test(排名一致性测试)。测试仅在失真级别上有所不同图像在BIQA模型的一致性。首先假设,随着任何失真类型的失真水平的增加,图像质量单调地降低。 给定具有J个源图像,C类畸变类型和L个畸变等级的数据库,采用平均SROCC来量化排序一致性

L-test

其中I是失真等级, s是模型预测值

P-test:Pairwise preference consistency test(成对偏好一致性测试)。它建立在DIP(可区分图像对)的概念上,该概念包含两个感知质量可区分的图像。 给定Q个 DIP的数据库,BIQA模型正确预测了Qc 个(DIP)的一致性

P-test

关于D-test、L-test、P-test见参考文献[4]。

[4] K. Ma et al., “Waterloo exploration database: New challenges for image quality assessment models,” IEEE Trans. Image Process., vol. 22, no. 2, pp. 1004–1016, Feb. 2017.

作者:池鱼_ed29

链接:https://www.jianshu.com/p/b738bb19e4af

来源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。