- 大数据学习(141)-分布式数据库

viperrrrrrr

大数据学习分布式clickhousehdfshbase

在分布式数据库中主要有hdfs、hbase、clickhouse三种。HDFS(HadoopDistributedFileSystem)、HBase和ClickHouse都是处理大数据的分布式系统,但它们的设计目标、架构和适用场景有所不同。一、HDFS(HadoopDistributedFileSystem)HDFS是Hadoop生态系统的一部分,是一个高度容错的系统,适合存储大量数据。它被设计为

- 大数据从入门到入魔系列————大数据治理技术栈&技术选型

小禾科技

大数据大数据hadoopsparknosql数据仓库ETL

文章目录前言一、大数据的历史二、大数据的必要性2.1为什么要学习大数据2.2大数据维度2.3大数据处理生活场景三、大数据处理问题模式四、大数据的学习路线4.1大数据技术栈4.2大数据学习路线献给读者福利福利免费的大数据学习资料网盘地址:点我!福利福利免费的大数据学习资料网盘地址:点我!福利福利免费的大数据学习资料网盘地址:点我!前言随着信息技术的迅猛发展,我们正处在一个数据驱动的世界中。每一天,全

- 大数据学习(138)-Hive数据分析3

viperrrrrrr

大数据学习hive

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、分组排序问题(TopN变体)1.按多个条件排序并取TopN问题:查询每个部门薪资最高且入职最早的前2名员工。思路:窗口函数中用ORDERBYsalaryDESC,hire_dateASC实现多条件排序。用ROW_NUMBER()生成唯一排名,避免并列。代码模板:WITHrank

- 大数据学习路线,从Linux基础到大型网站高并发处理项目实战

程序员面试吧

相信大家在学习大数据的时候都不知道怎么来学习,因为知识点太多了,也太杂了,没有一个系统的路线来引导大家学习.为了解决大家这个困惑,小编整理了从Linux基础到大型网站高并发处理项目实战的学习路线和知识点,希望大家能够喜欢,文末还有小编整理的视频和电子书籍,也希望大家能够喜欢。Linux理论1.Linux入门—Linux简介、VMWareworkstation安装—整理各大Linux发行版本的区别—

- 大数据学习(131)-Hive数据分析函数总结

viperrrrrrr

大数据学习hive

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦1.CAST函数用于将一种数据类型的表达式显式转换为另一种数据类型。它的语法如下:CAST(expression AS data_type)其中,expression是任何有效的SQL表达式,data_type是目标数据类型。CURRENT_DATE函数是SQL中的一个日期/时间函

- 大数据学习(133)-Hive数据分析2

viperrrrrrr

大数据学习hive

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦十一、分组去重(保留每组最新/最早记录)核心思路:使用窗口函数ROW_NUMBER()按分组排序,保留指定顺序的第一条记录。典型例题:查询每个用户最后一次登录记录。代码模板:WITHranked_loginsAS(SELECTuser_id,login_date,ROW_NUMBE

- 大数据学习(130)-zookeeper

viperrrrrrr

大数据学习zookeeper

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦1.ZooKeeper集群ZooKeeper集群是一个分布式协调服务系统,由多个ZooKeeper服务器节点组成。这些节点通过协作来提供高可用性、一致性和可靠性的服务。以下是ZooKeeper集群的关键特性:分布式架构:集群中的每个节点都可以处理客户端请求,并通过内部通信机制(如心

- 大数据学习(127)-hive日期函数

viperrrrrrr

大数据学习hive

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、日期提取类函数1.dayofweek(date)功能:返回日期的星期几(1=星期日,2=星期一,...,7=星期六)。示例:SELECTdayofweek('2023-10-01');--返回1(星期日)2.year(date)/month(date)/day(date)功能:

- 大数据项目-大数据开发架构学习大纲

brightl09

软件开发大数据方向大数据

大数据项目-大数据开发架构学习大纲超详细的大数据学习路线图,从零基础到资深专家的全路径知识体系,分阶段明确核心知识点、技术栈、实战目标及能力要求,适合系统化学习和职业规划一、基础入门阶段1.目标掌握大数据开发基础工具与核心概念,能完成简单数据处理任务2.核心知识点编程基础:Python/Java语法、数据结构、文件操作、面向对象编程、SQL增删改查、聚合函数、窗口函数、多表关联Linux与Shel

- 大数据学习(125)-hive数据分析

viperrrrrrr

大数据学习

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦1.连续登录问题变种题目:找出恰好连续登录3天的用户(不允许更长的连续区间)。表结构:user_logs(user_id,login_date)。参考答案:WITHranked_logsAS(SELECTuser_id,login_date,ROW_NUMBER()OVER(PAR

- 大数据学习(124)-spark数据倾斜

viperrrrrrr

大数据学习spark

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦1.倾斜表现某些Task执行时间远超其他Task(通常超过平均时间10倍以上)集群资源利用率不均(部分Executor负载过高)作业执行时间主要由少数几个Task决定频繁出现GC超时或OOM错误2.诊断方法scala//通过SparkUI观察Stage和Task的执行时间//查看S

- 大数据学习(121)-sql重点问题

viperrrrrrr

学习

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦窗口函数使用技巧窗口函数是SQL中处理复杂数据分析的强大工具,常用于排名、累计计算、同比环比等场景。以下从基础语法、高频函数、性能优化、典型场景四个维度总结核心技巧,并附示例代码和避坑指南。一、基础语法与核心组件1.完整语法结构sqlOVER([PARTITIONBY字段1,字段2

- 大数据学习之Linux环境搭建

Im_LSY

大数据

设置IP及主机名#1.修改IP$vi/etc/sysconfig/network-scripts/ifconfig-etho#修改IP为自己虚拟机IP段的固定IP:BOOTPROTO=staticIPADDR=192.168.111.11#2.设置主机名$vi/etc/sysconfig/networkNETWORKING=yesHOSTNAME=node01关闭防火墙和selinux#1.防火墙

- 尚硅谷大数据技术课程资料下载:开启大数据学习之旅

裘心国Trent

尚硅谷大数据技术课程资料下载:开启大数据学习之旅尚硅谷大数据技术-教程-学习路线-笔记汇总表课程资料下载项目地址:https://gitcode.com/Resource-Bundle-Collection/1d0e3项目介绍在数字化时代,大数据技术已成为企业决策和创新的核心驱动力。为了帮助广大技术爱好者和从业者快速掌握大数据技术,尚硅谷推出了全面的大数据技术课程资料下载仓库。本仓库不仅提供了详细

- 大数据学习(115)-hive与impala

viperrrrrrr

大数据学习hiveimpala

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦简介:Impala和Hive都是大数据领域中广泛使用的查询工具,它们在功能、性能和适用场景上存在一些差异。本文将深入比较这两者,并探讨Impala的优缺点。一、ApacheHadoop中的角色Impala和Hive都是ApacheHadoop生态系统中的重要组件,用于处理大规模数据

- 大数据学习(112)-HIVE中的窗口函数

viperrrrrrr

学习hivesql

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦在ApacheHive中,窗口函数(WindowFunctions)是一类强大的SQL函数,用于对查询结果集的一个“窗口”或“分组”进行计算,而不减少结果集的行数。以下是Hive中常用的窗口函数分类及示例:1.排名函数函数描述ROW_NUMBER()为结果集中的每一行分配一个唯一的

- 大数据学习(108)-子查询

viperrrrrrr

学习

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦相关子查询会针对外层查询的每一行单独执行,而不是一次性完成所有子查询操作。这意味着子查询的执行次数等于外层查询表的行数。SQL语句SELECTdepartment_nameFROMdepartmentsdWHERE5<(SELECTCOUNT(*)FROMemployeeseWHE

- 大数据学习(107)-sql中case使用场景

viperrrrrrr

大数据学习sql

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦在SQL中,CASE语句是处理条件逻辑的核心工具,以下是6个典型使用场景及示例:1.数据分类统计将连续数值分段统计(如年龄、分数):SELECTCASEWHENage'2025-01-01'THENpriceELSE0END)ASsales_2025,SUM(CASEWHENord

- 大数据学习笔记(三):HDFS分布式文件系统架构原理详解

weixin_34303897

大数据系统架构

在网易云课堂买了卡夫卡的大数据课程,开始学习咯!HDFS分布式文件系统解决问题:海量数据的存储——>分布式结构设计分布式的特点:集群,有多台机器共同协作完成存储主从架构设计HDFS设计思想1.namenode-主节点-领导主要存储文件的属性信息,即文件的元数据:文件的名称文件的位置文件的副本数文件的拥有者、组、权限存储快各个块在哪些datanode节点上2.datanode-从节点-随从存储具体的

- 最全大数据学习路线指南:大数据知识点汇总保姆级教程(2万字长文)

大模型大数据攻城狮

大数据知识大数据思维导图大数据学习大数据入门大数据入行大数据面试大数据BI

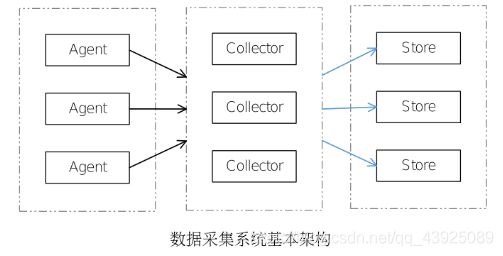

目录第一章大数据基础篇1.1Linux基础学习1.2SQL基础学习1.3Java与Scala基础学习第二章数据采集与存储技术2.1Hadoop基础及实战2.2Hive与Hbase技术2.3ETL流程及原理第三章数据管理与查询技术3.1数据仓库体系搭建3.2数据治理体系方法论3.3OLAP查询技术第四章大数据开发工具与平台4.1分布式协调工具Zookeeper4.2消息队列Kafka4.3任务调度工

- 大数据学习(100)-kafka详解

viperrrrrrr

大数据学习kafka

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦ApacheKafka是一个分布式流处理平台,主要用于构建高吞吐量、低延迟、可扩展的实时数据管道和流式应用程序。它广泛应用于日志聚合、事件溯源、消息队列、实时分析等场景。Kafka核心概念1.Producer(生产者)向Kafka发布(写入)消息的客户端。可以指定消息发送到哪个To

- 大数据学习(98)-数据治理

viperrrrrrr

大数据学习数据治理

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、大数据治理的核心目标提升数据质量通过自动化工具实时检测异常值、缺失值或逻辑错误(如使用ApacheGriffin或GreatExpectations)。建立数据质量评分体系,对数据源进行分级管理。元数据驱动管理构建全局元数据目录(如ApacheAtlas),追踪数据血缘、业务含

- 大数据学习(88)-zookeeper实现的高可用(HA)

viperrrrrrr

学习zookeeper大数据

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦ZooKeeper实现高可用的能力详解ZooKeeper不仅是实现分布式系统高可用(HA)的关键工具,其自身也通过特定架构设计实现了高可用特性。一、ZooKeeper自身的高可用实现1.集群架构设计典型部署:由3/5/7个节点组成的ZooKeeperEnsemble[Client]

- 大数据学习(91)-SQL优化

viperrrrrrr

大数据学习sql

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦数据库优化的思路SQL优化在我们书写SQL语句的时候,其实书写的顺序、策略会影响到SQL的性能,虽然实现的功能是一样的,但是它们的性能会有些许差别。因此,下面就讲解在书写SQL的时候,怎么写比较好。①选择最有效率的表名顺序数据库的解析器按照从右到左的顺序处理FROM子句中的表名,F

- 大数据学习-hive(四:数仓搭建,数据监控,数据支持)

宇智波云

大数据项目hivehive

一:数仓搭建1:完备性。要保证所需要的数据全部到达数仓。2:准备性。etl,和数据的计算校验,确保输出的数据准确。3:一致性。确保输出端口一致,防止输出数据不准。4:时效性。每天的定时调度。5:规范性。表名,字段名要进行规范化处理。6:稳定性。确保数仓稳定。二:数仓校验1:建表语句--建表--droptableifexistsdm.dim_dk_vehicle_info_dqc;createtab

- 大数据学习(82)-数仓详解

viperrrrrrr

大数据学习数仓

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、什么是数据仓库数据仓库(下文以“数仓”称),顾名思义,存放数据的仓库,它集合了各个业务系统的数据,以金融业为例,数仓包含了贷款业务、CRM、存款业务等数据。用于企业做数据分析、出报告、做决策;在有些公司也作为各业务系统的数据来源。从逻辑上理解,数据库和数仓没有区别,都是通过数据

- 大数据学习(75)-大数据组件总结

viperrrrrrr

大数据impalayarnhdfshiveCDHmapreduce

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、CDHCDH(ClouderaDistributionIncludingApacheHadoop)是由Cloudera公司提供的一个集成了ApacheHadoop以及相关生态系统的发行版本。CDH是一个大数据平台,简化和加速了大数据处理分析的部署和管理。CDH提供Hadoop的

- 大数据学习(67)- Flume、Sqoop、Kafka、DataX对比

viperrrrrrr

大数据学习flumekafkasqoopdatax

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦工具主要作用数据流向实时性数据源/目标应用场景Flume实时日志采集与传输从数据源到存储系统实时日志文件、网络流量等→HDFS、HBase、Kafka等日志收集、实时监控、实时分析Sqoop关系型数据库与Hadoop间数据同步关系型数据库→Hadoop生态系统(HDFS、Hive、

- 大数据学习(61)-Impala与Hive计算引擎

viperrrrrrr

学习impalahiveyarnhadoop

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、impala与yarn资源管理YARN是ApacheHadoop生态系统中的一个资源管理器,它采用了master/slave的架构,使得多个处理框架能够在同一集群上共享资源。Impala作为Hadoop生态系统中的一个组件,可以与YARN集成,以便更好地管理

- 大数据学习(62)- Hadoop-yarn

viperrrrrrr

大数据yarn

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、YARN概述1.YARN简介Hadoop-YARN是ApacheHadoop生态系统中的一个集群资源管理器。它作为Hadoop的第二代资源管理框架,负责管理和分配集群中的计算资源。YARN的设计目标是提供一个通用的资源管理框架,使得Hadoop集群可以同时运

- Linux的Initrd机制

被触发

linux

Linux 的 initrd 技术是一个非常普遍使用的机制,linux2.6 内核的 initrd 的文件格式由原来的文件系统镜像文件转变成了 cpio 格式,变化不仅反映在文件格式上, linux 内核对这两种格式的 initrd 的处理有着截然的不同。本文首先介绍了什么是 initrd 技术,然后分别介绍了 Linux2.4 内核和 2.6 内核的 initrd 的处理流程。最后通过对 Lin

- maven本地仓库路径修改

bitcarter

maven

默认maven本地仓库路径:C:\Users\Administrator\.m2

修改maven本地仓库路径方法:

1.打开E:\maven\apache-maven-2.2.1\conf\settings.xml

2.找到

- XSD和XML中的命名空间

darrenzhu

xmlxsdschemanamespace命名空间

http://www.360doc.com/content/12/0418/10/9437165_204585479.shtml

http://blog.csdn.net/wanghuan203/article/details/9203621

http://blog.csdn.net/wanghuan203/article/details/9204337

http://www.cn

- Java 求素数运算

周凡杨

java算法素数

网络上对求素数之解数不胜数,我在此总结归纳一下,同时对一些编码,加以改进,效率有成倍热提高。

第一种:

原理: 6N(+-)1法 任何一个自然数,总可以表示成为如下的形式之一: 6N,6N+1,6N+2,6N+3,6N+4,6N+5 (N=0,1,2,…)

- java 单例模式

g21121

java

想必单例模式大家都不会陌生,有如下两种方式来实现单例模式:

class Singleton {

private static Singleton instance=new Singleton();

private Singleton(){}

static Singleton getInstance() {

return instance;

}

- Linux下Mysql源码安装

510888780

mysql

1.假设已经有mysql-5.6.23-linux-glibc2.5-x86_64.tar.gz

(1)创建mysql的安装目录及数据库存放目录

解压缩下载的源码包,目录结构,特殊指定的目录除外:

- 32位和64位操作系统

墙头上一根草

32位和64位操作系统

32位和64位操作系统是指:CPU一次处理数据的能力是32位还是64位。现在市场上的CPU一般都是64位的,但是这些CPU并不是真正意义上的64 位CPU,里面依然保留了大部分32位的技术,只是进行了部分64位的改进。32位和64位的区别还涉及了内存的寻址方面,32位系统的最大寻址空间是2 的32次方= 4294967296(bit)= 4(GB)左右,而64位系统的最大寻址空间的寻址空间则达到了

- 我的spring学习笔记10-轻量级_Spring框架

aijuans

Spring 3

一、问题提问:

→ 请简单介绍一下什么是轻量级?

轻量级(Leightweight)是相对于一些重量级的容器来说的,比如Spring的核心是一个轻量级的容器,Spring的核心包在文件容量上只有不到1M大小,使用Spring核心包所需要的资源也是很少的,您甚至可以在小型设备中使用Spring。

- mongodb 环境搭建及简单CURD

antlove

WebInstallcurdNoSQLmongo

一 搭建mongodb环境

1. 在mongo官网下载mongodb

2. 在本地创建目录 "D:\Program Files\mongodb-win32-i386-2.6.4\data\db"

3. 运行mongodb服务 [mongod.exe --dbpath "D:\Program Files\mongodb-win32-i386-2.6.4\data\

- 数据字典和动态视图

百合不是茶

oracle数据字典动态视图系统和对象权限

数据字典(data dictionary)是 Oracle 数据库的一个重要组成部分,这是一组用于记录数据库信息的只读(read-only)表。随着数据库的启动而启动,数据库关闭时数据字典也关闭 数据字典中包含

数据库中所有方案对象(schema object)的定义(包括表,视图,索引,簇,同义词,序列,过程,函数,包,触发器等等)

数据库为一

- 多线程编程一般规则

bijian1013

javathread多线程java多线程

如果两个工两个以上的线程都修改一个对象,那么把执行修改的方法定义为被同步的,如果对象更新影响到只读方法,那么只读方法也要定义成同步的。

不要滥用同步。如果在一个对象内的不同的方法访问的不是同一个数据,就不要将方法设置为synchronized的。

- 将文件或目录拷贝到另一个Linux系统的命令scp

bijian1013

linuxunixscp

一.功能说明 scp就是security copy,用于将文件或者目录从一个Linux系统拷贝到另一个Linux系统下。scp传输数据用的是SSH协议,保证了数据传输的安全,其格式如下: scp 远程用户名@IP地址:文件的绝对路径

- 【持久化框架MyBatis3五】MyBatis3一对多关联查询

bit1129

Mybatis3

以教员和课程为例介绍一对多关联关系,在这里认为一个教员可以叫多门课程,而一门课程只有1个教员教,这种关系在实际中不太常见,通过教员和课程是多对多的关系。

示例数据:

地址表:

CREATE TABLE ADDRESSES

(

ADDR_ID INT(11) NOT NULL AUTO_INCREMENT,

STREET VAR

- cookie状态判断引发的查找问题

bitcarter

formcgi

先说一下我们的业务背景:

1.前台将图片和文本通过form表单提交到后台,图片我们都做了base64的编码,并且前台图片进行了压缩

2.form中action是一个cgi服务

3.后台cgi服务同时供PC,H5,APP

4.后台cgi中调用公共的cookie状态判断方法(公共的,大家都用,几年了没有问题)

问题:(折腾两天。。。。)

1.PC端cgi服务正常调用,cookie判断没

- 通过Nginx,Tomcat访问日志(access log)记录请求耗时

ronin47

一、Nginx通过$upstream_response_time $request_time统计请求和后台服务响应时间

nginx.conf使用配置方式:

log_format main '$remote_addr - $remote_user [$time_local] "$request" ''$status $body_bytes_sent "$http_r

- java-67- n个骰子的点数。 把n个骰子扔在地上,所有骰子朝上一面的点数之和为S。输入n,打印出S的所有可能的值出现的概率。

bylijinnan

java

public class ProbabilityOfDice {

/**

* Q67 n个骰子的点数

* 把n个骰子扔在地上,所有骰子朝上一面的点数之和为S。输入n,打印出S的所有可能的值出现的概率。

* 在以下求解过程中,我们把骰子看作是有序的。

* 例如当n=2时,我们认为(1,2)和(2,1)是两种不同的情况

*/

private stati

- 看别人的博客,觉得心情很好

Cb123456

博客心情

以为写博客,就是总结,就和日记一样吧,同时也在督促自己。今天看了好长时间博客:

职业规划:

http://www.iteye.com/blogs/subjects/zhiyeguihua

android学习:

1.http://byandby.i

- [JWFD开源工作流]尝试用原生代码引擎实现循环反馈拓扑分析

comsci

工作流

我们已经不满足于仅仅跳跃一次,通过对引擎的升级,今天我测试了一下循环反馈模式,大概跑了200圈,引擎报一个溢出错误

在一个流程图的结束节点中嵌入一段方程,每次引擎运行到这个节点的时候,通过实时编译器GM模块,计算这个方程,计算结果与预设值进行比较,符合条件则跳跃到开始节点,继续新一轮拓扑分析,直到遇到

- JS常用的事件及方法

cwqcwqmax9

js

事件 描述

onactivate 当对象设置为活动元素时触发。

onafterupdate 当成功更新数据源对象中的关联对象后在数据绑定对象上触发。

onbeforeactivate 对象要被设置为当前元素前立即触发。

onbeforecut 当选中区从文档中删除之前在源对象触发。

onbeforedeactivate 在 activeElement 从当前对象变为父文档其它对象之前立即

- 正则表达式验证日期格式

dashuaifu

正则表达式IT其它java其它

正则表达式验证日期格式

function isDate(d){

var v = d.match(/^(\d{4})-(\d{1,2})-(\d{1,2})$/i);

if(!v) {

this.focus();

return false;

}

}

<input value="2000-8-8" onblu

- Yii CModel.rules() 方法 、validate预定义完整列表、以及说说验证

dcj3sjt126com

yii

public array rules () {return} array 要调用 validate() 时应用的有效性规则。 返回属性的有效性规则。声明验证规则,应重写此方法。 每个规则是数组具有以下结构:array('attribute list', 'validator name', 'on'=>'scenario name', ...validation

- UITextAttributeTextColor = deprecated in iOS 7.0

dcj3sjt126com

ios

In this lesson we used the key "UITextAttributeTextColor" to change the color of the UINavigationBar appearance to white. This prompts a warning "first deprecated in iOS 7.0."

Ins

- 判断一个数是质数的几种方法

EmmaZhao

Mathpython

质数也叫素数,是只能被1和它本身整除的正整数,最小的质数是2,目前发现的最大的质数是p=2^57885161-1【注1】。

判断一个数是质数的最简单的方法如下:

def isPrime1(n):

for i in range(2, n):

if n % i == 0:

return False

return True

但是在上面的方法中有一些冗余的计算,所以

- SpringSecurity工作原理小解读

坏我一锅粥

SpringSecurity

SecurityContextPersistenceFilter

ConcurrentSessionFilter

WebAsyncManagerIntegrationFilter

HeaderWriterFilter

CsrfFilter

LogoutFilter

Use

- JS实现自适应宽度的Tag切换

ini

JavaScripthtmlWebcsshtml5

效果体验:http://hovertree.com/texiao/js/3.htm

该效果使用纯JavaScript代码,实现TAB页切换效果,TAB标签根据内容自适应宽度,点击TAB标签切换内容页。

HTML文件代码:

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml"

- Hbase Rest API : 数据查询

kane_xie

RESThbase

hbase(hadoop)是用java编写的,有些语言(例如python)能够对它提供良好的支持,但也有很多语言使用起来并不是那么方便,比如c#只能通过thrift访问。Rest就能很好的解决这个问题。Hbase的org.apache.hadoop.hbase.rest包提供了rest接口,它内嵌了jetty作为servlet容器。

启动命令:./bin/hbase rest s

- JQuery实现鼠标拖动元素移动位置(源码+注释)

明子健

jqueryjs源码拖动鼠标

欢迎讨论指正!

print.html代码:

<!DOCTYPE html>

<html>

<head>

<meta http-equiv=Content-Type content="text/html;charset=utf-8">

<title>发票打印</title>

&l

- Postgresql 连表更新字段语法 update

qifeifei

PostgreSQL

下面这段sql本来目的是想更新条件下的数据,可是这段sql却更新了整个表的数据。sql如下:

UPDATE tops_visa.visa_order

SET op_audit_abort_pass_date = now()

FROM

tops_visa.visa_order as t1

INNER JOIN tops_visa.visa_visitor as t2

ON t1.

- 将redis,memcache结合使用的方案?

tcrct

rediscache

公司架构上使用了阿里云的服务,由于阿里的kvstore收费相当高,打算自建,自建后就需要自己维护,所以就有了一个想法,针对kvstore(redis)及ocs(memcache)的特点,想自己开发一个cache层,将需要用到list,set,map等redis方法的继续使用redis来完成,将整条记录放在memcache下,即findbyid,save等时就memcache,其它就对应使用redi

- 开发中遇到的诡异的bug

wudixiaotie

bug

今天我们服务器组遇到个问题:

我们的服务是从Kafka里面取出数据,然后把offset存储到ssdb中,每个topic和partition都对应ssdb中不同的key,服务启动之后,每次kafka数据更新我们这边收到消息,然后存储之后就发现ssdb的值偶尔是-2,这就奇怪了,最开始我们是在代码中打印存储的日志,发现没什么问题,后来去查看ssdb的日志,才发现里面每次set的时候都会对同一个key