《动手学深度学习PyTorch版》打卡_Task5,卷积神经网络基础,LeNet,卷积神经网络进阶

最近参加了伯禹平台和Datawhale等举办的《动手学深度学习PyTorch版》课程,卷积神经网络基础,LeNet,卷积神经网络进阶。

神经网络中所说的卷积计算其实是互相关运算,一直以来理解有偏差。

互相关运算与卷积运算

卷积层得名于卷积运算,但卷积层中用到的并非卷积运算而是互相关运算。我们将核数组上下翻转、左右翻转,再与输入数组做互相关运算,这一过程就是卷积运算。由于卷积层的核数组是可学习的,所以使用互相关运算与使用卷积运算并无本质区别。

特征图与感受野

二维卷积层输出的二维数组可以看作是输入在空间维度(宽和高)上某一级的表征,也叫特征图(feature map)。影响元素x的前向计算的所有可能输入区域(可能大于输入的实际尺寸)叫做x的感受野(receptive field)。

填充

填充(padding)是指在输入高和宽的两侧填充元素(通常是0元素)

步幅

在互相关运算中,卷积核在输入数组上滑动,每次滑动的行数与列数即是步幅(stride)

一般来说,当高上步幅为sh,宽上步幅为sw时,输出形状为:

⌊(原始高+高方向填充长度*2−kh+sh)/sh⌋×⌊(原始宽+宽方向填充长度*2−kw+sw)/sw⌋

多输入,输出通道时

卷积核对应于输入通道是一对多进行运算后再对应位置相加的关系

1x1卷积层

1×1卷积核可在不改变高宽的情况下,调整通道数。1×1卷积核不识别高和宽维度上相邻元素构成的模式,其主要计算发生在通道维上。假设我们将通道维当作特征维,将高和宽维度上的元素当成数据样本,那么1×1卷积层的作用与全连接层等价。

池化

二维池化

池化层也可以在输入的高和宽两侧填充并调整窗口的移动步幅来改变输出形状。池化层填充和步幅与卷积层填充和步幅的工作机制一样。

在处理多通道输入数据时,池化层对每个输入通道分别池化,但不会像卷积层那样将各通道的结果按通道相加。这意味着池化层的输出通道数与输入通道数相等。

注意池化层也可以在模型中引入参数:比如最大池化后乘以一个权重。

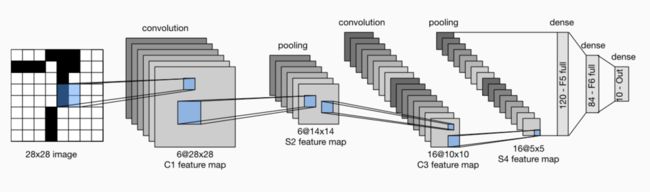

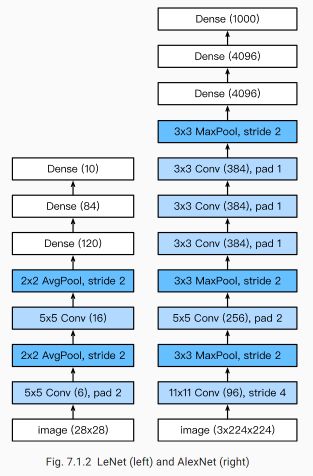

LeNet 模型

LeNet分为卷积层块和全连接层块两个部分。

卷积层块里的基本单位是卷积层后接平均池化层:卷积层用来识别图像里的空间模式,如线条和物体局部,之后的平均池化层则用来降低卷积层对位置的敏感性。

卷积层块由两个这样的基本单位重复堆叠构成。在卷积层块中,每个卷积层都使用5×5的窗口,并在输出上使用sigmoid激活函数。第一个卷积层输出通道数为6,第二个卷积层输出通道数则增加到16。

全连接层块含3个全连接层。它们的输出个数分别是120、84和10,其中10为输出的类别个数。

依据以下博客理解了一下LeNet-5 模型

https://blog.csdn.net/saw009/article/details/80590245

C1层:

参数个数:(5*5+1)*6=156,其中5*5为卷积核的25个参数,1为偏置

S2层:使用2×2大小的卷积核进行池化,padding=0,stride=2,

参数个数:(1+1)*6=12,其中第一个1为最大池化所对应的2*2感受野中最大的那个数的权重,第二个1为偏置

C3层:

该层第一个难点:6个输入图如何通过卷积得到16个特征图?

如图2所示,C3的前六个特征图(0,1,2,3,4,5)由S2的相邻三个特征图作为输入,接下来的6个特征图(6,7,8,9,10,11)由S2的相邻四个特征图作为输入,12,13,14号特征图由S2间断的四个特征图作为输入,15号特征图由S2全部(6个)特征图作为输入。

图2

该层第二个难点:通过S2的输入,如何卷积得到C3的一个特征图呢?

我用C3层0号特征图举例,它由S2层0,1,2号特征图作为输入,由于C3层共有16个卷积核,即C3每一个特征图是由一个卷积核对S2层相应的输入特征图卷积得到的,如图3所示。

图3

这里值得注意的是,上图的卷积核是一个5×5大小具有3个通道,每个通道各不相同,这也是下面计算时5*5后面还要乘以3,4,6的原因。具体可参考多通道卷积。

参数个数:(5*5*3+1)*6+(5*5*4+1)*6+(5*5*4+1)*3+(5*5*6+1)=1516

S4层:依然是池化层,使用16个2×2大小的卷积核进行池化,padding=0,stride=2,得到16个5×5大小的特征图(10-2+2*0)/2+1=5

参数个数:(1+1)*16=32

C5层:使用120个5*5卷积核对S4层16个特征图进行卷积,padding=0,stride=1,得到120个1*1大小的特征图,(5-5+2*0)/1+1=1

这里的计算跟C3相同,也是多通道卷积,因此5*5后面乘以16.

参数个数:(5*5*16+1)*120=48120

F6层:共有84个神经元,与C5层进行全连接,即每个神经元都与C5层的120个特征图相连。

参数个数:(120+1)*84=10164

Output层:输出层由欧式径向基函数(Euclidean Radial Basis Function)单元组成,每个单元由F6层84个神经元作为输入,输出0-9十个手写数字识别的结果

参数个数:84*10=840

深度卷积神经网络(AlexNet)

首次证明了学习到的特征可以超越⼿⼯设计的特征,从而⼀举打破计算机视觉研究的前状。

特征:

- 8层变换,其中有5层卷积和2层全连接隐藏层,以及1个全连接输出层。

- 将sigmoid激活函数改成了更加简单的ReLU激活函数。

- 用Dropout来控制全连接层的模型复杂度。

- 引入数据增强,如翻转、裁剪和颜色变化,从而进一步扩大数据集来缓解过拟合

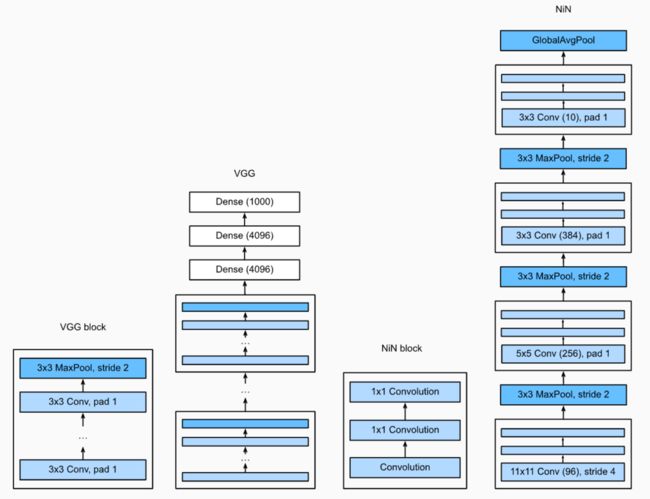

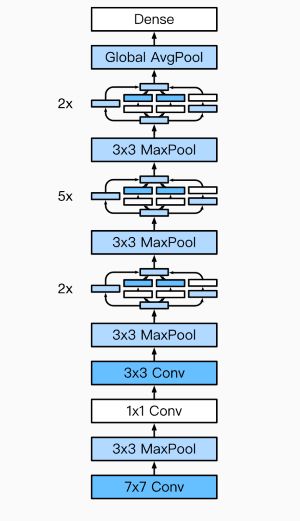

使用重复元素的网络(VGG)

VGG:通过重复使⽤简单的基础块来构建深度模型。

Block:数个相同的填充为1、窗口形状为3×3的卷积层,接上一个步幅为2、窗口形状为2×2的最大池化层。

卷积层保持输入的高和宽不变,而池化层则对其减半。

⽹络中的⽹络(NiN)

LeNet、AlexNet和VGG:先以由卷积层构成的模块充分抽取空间特征,再以由全连接层构成的模块来输出分类结果。

NiN:串联多个由卷积层和“全连接”层构成的小⽹络来构建⼀个深层⽹络。

⽤了输出通道数等于标签类别数的NiN块,然后使⽤全局平均池化层对每个通道中所有元素求平均并直接⽤于分类。

1×1卷积核作用

1.放缩通道数:通过控制卷积核的数量达到通道数的放缩。

2.增加非线性。1×1卷积核的卷积过程相当于全连接层的计算过程,并且还加入了非线性激活函数,从而可以增加网络的非线性。

3.计算参数少

NiN重复使⽤由卷积层和代替全连接层的1×1卷积层构成的NiN块来构建深层⽹络。

NiN去除了容易造成过拟合的全连接输出层,而是将其替换成输出通道数等于标签类别数 的NiN块和全局平均池化层。

NiN的以上设计思想影响了后⾯⼀系列卷积神经⽹络的设计。

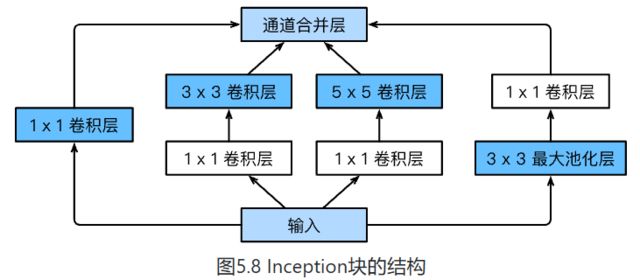

GoogLeNet

- 由Inception基础块组成。

- Inception块相当于⼀个有4条线路的⼦⽹络。它通过不同窗口形状的卷积层和最⼤池化层来并⾏抽取信息,并使⽤1×1卷积层减少通道数从而降低模型复杂度。

- 可以⾃定义的超参数是每个层的输出通道数,我们以此来控制模型复杂度。