spark——初识

文章目录

- 0. 待学习文章

- 1. pyspark.SparkContext的join

- 2.SparkSession

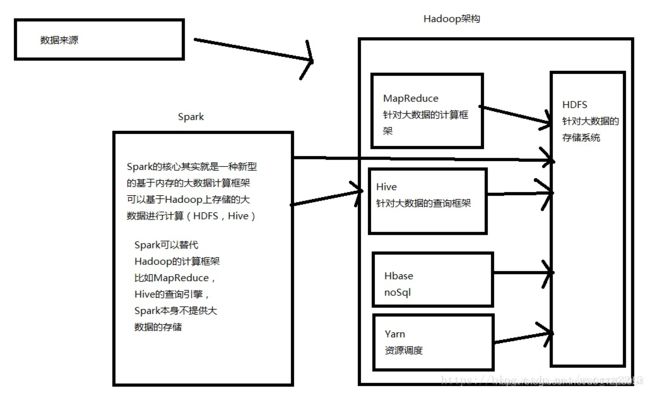

- 3. spark和hadoop的关系

0. 待学习文章

现在还不懂,但需要不断看:

- http://www.louisvv.com/archives/1340.html

1. pyspark.SparkContext的join

参考文章:https://www.cnblogs.com/FG123/p/9747901.html

leftOuterJoin, rightOuterJoin, fullOuterJoin, join

from pyspark import SparkConf, SparkContext

conf = SparkConf()

sc = SparkContext(conf=conf)

a = sc.parallelize([('name', 'Alice'),

('age', 20),

('job', 'student'),

('fav', 'basket')])

b = sc.parallelize([('name', 'Bob'),

('age', 22),

('address', 'Wuhan')])

result = a.join(b)

print(result)

print('join:{}'.format(a.join(b).collect()))

print('leftOuterJoin:', a.leftOuterJoin(b).collect())

print('rightOuterJoin:', a.rightOuterJoin(b).collect())

print('fullOuterJoin:', a.fullOuterJoin(b).collect())

# 结果

PythonRDD[9] at RDD at PythonRDD.scala:53

join:[('name', ('Alice', 'Bob')), ('age', (20, 22))]

leftOuterJoin: [('job', ('student', None)), ('fav', ('basket', None)), ('name', ('Alice', 'Bob')), ('age', (20, 22))]

rightOuterJoin: [('name', ('Alice', 'Bob')), ('age', (20, 22)), ('address', (None, 'Wuhan'))]

fullOuterJoin: [('job', ('student', None)), ('fav', ('basket', None)), ('name', ('Alice', 'Bob')), ('age', (20, 22)), ('address', (None, 'Wuhan'))]2.SparkSession

def getSparkSession(): SparkSession = {

val builder = SparkSession.builder.enableHiveSupport

.config("spark.serializer", "org.apache.spark.serializer.JavaSerializer")

.config("spark.sql.broadcastTimeout", "3000")

val sparkSession = builder.getOrCreate()

sparkSession

}创建SparkSession

编写 Spark SQL 应用的时候,第一个要创建的对象就是 SparkSession。SparkSession 是 Spark SQL 的入口。

builder:创建一个sparkSession实例

Builder 是 SparkSession 的构造器。 通过 Builder, 可以添加各种配置。

Builder 的方法如下:

| method | |

|---|---|

| getOrCreate | 获取或者新建一个SparkSession |

| enbleHiveSupport | 增加支持hive support |

| appname | 设置application的名字 |

| config | 设置各种设置 |