MPI实验三:梯形法求积分

实验三 梯形法求积分

1. 实验目的和要求

梯形法求积分

2.实验环境

安装了docker的PC

3.实验内容及实验数据记录

梯形法求积分

a. mpi_send, 0 for sum

b. mpi_gather, 回收到0号进程的数组,for sum

c. mpi_reduce, MPI_SUM求和

4.算法描述及实验步骤

第一:写函数double f(double x)和double Trap(double left_endpt,double right_endpt,int trap_count,double base_len)来计算pi

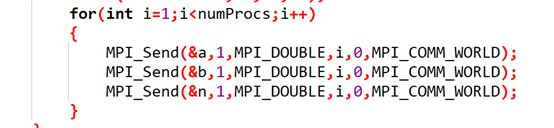

第二:进程 0输入a,b和n,且进程0把a,b,n发送给剩余进程

第四:计算h,每个进程需处理的长度local_n,还有每个进程的起始位置local_a和终点位置local_b

第五:用mpi_reducem ,mpi_gatherp ,mpi_send接收total_trap

![]()

5.调试过程

注意大小写

6. 实验结果

7.代码

#include