Pytorch:定义的网络结构层能否重复使用

前言:最近在构建网络的时候,有一些层参数一样,于是就没有定义新的层,直接重复使用了原来已经有的层,发现效果和模型大小都没有什么变化,心中产生了疑问:定义的网络结构层能否重复使用?因此接下来利用了一个小模型网络实验了一下。

一、网络结构一:(连续使用相同的层)

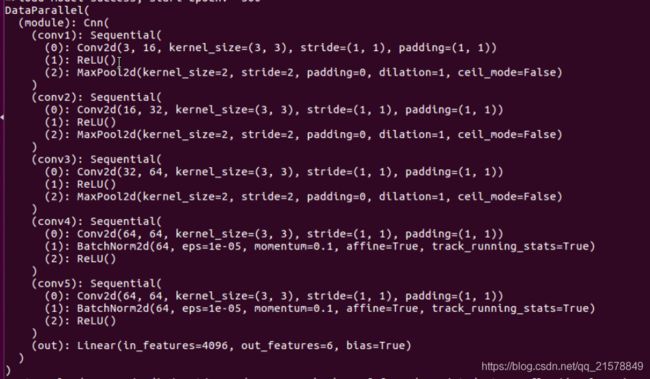

1、网络结构如下所示:

class Cnn(nn.Module):

def __init__(self):

super(Cnn, self).__init__()

self.conv1 = nn.Sequential(

nn.Conv2d(

in_channels = 3, #(, 64, 64, 3)

out_channels = 16,

kernel_size = 3,

stride = 1,

padding = 1

), ##( , 64, 64, 16)

nn.ReLU(),

nn.MaxPool2d(kernel_size = 2)

) ##( , 32, 32, 16)

self.conv2 = nn.Sequential(

nn.Conv2d(16,32,3,1,1),

nn.ReLU(),

nn.MaxPool2d(2)

)

self.conv3 = nn.Sequential(

nn.Conv2d(32,64,3,1,1),

nn.ReLU(),

nn.MaxPool2d(2)

)

self.conv4 = nn.Sequential(

nn.Conv2d(64,64,3,1,1),

nn.BatchNorm2d(64),

nn.ReLU(),

)

self.out = nn.Linear(64*8*8, 6)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = self.conv3(x)

x = self.conv4(x)

x = x.view(x.size(0),-1)

out = self.out(x)

return out

定义了一个卷积层conv4,接下来围绕着这个conv4做一些变化。打印一下网络结构:

和想象中的一样,其中

nn.BatchNorm2d # 对应上面的 module.conv4.1.*

激活层没有参数所以直接跳过

2、改变一下forward():

连续使用两个conv4层:

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = self.conv3(x)

x = self.conv4(x)

x = self.conv4(x)

x = x.view(x.size(0),-1)

out = self.out(x)

return out

二、网络结构二:(间断使用相同的层)

网络结构多定义一个和conv4一样的层conv5,同时间断使用conv4:

self.conv4 = nn.Sequential(

nn.Conv2d(64,64,3,1,1),

nn.BatchNorm2d(64),

nn.ReLU(),

)

self.conv5 = nn.Sequential(

nn.Conv2d(64,64,3,1,1),

nn.BatchNorm2d(64),

nn.ReLU(),

)

self.out = nn.Linear(64*8*8, 6)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = self.conv3(x)

x = self.conv4(x)

x = self.conv5(x)

x = self.conv4(x)

x = x.view(x.size(0),-1)

out = self.out(x)

return out

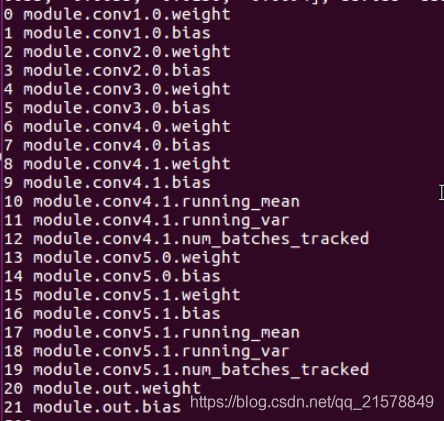

打印网络结构:

果不其然,新定义的conv5有效,conv4还是没有生效。

本来以为,使用重复定义的层会像conv4.0,conv4.1,…这样下去,看样子是不能重复使用定义的层。