XGBOOST参数调优

from:https://www.cnblogs.com/zhangbojiangfeng/p/6428988.html

XGBoost参数调优

http://blog.csdn.net/hhy518518/article/details/54988024

摘要:

转载:http://blog.csdn.NET/han_xiaoyang/article/details/52665396

1. 简介

如果你的预测模型表现得有些不尽如人意,那就用XGBoost吧。XGBoost算法现在已经成为很多数据工程师的重要武器。它是一种十分精致的算法,可以处理各种不规则的数据。

构造一个使用XGBoost的模型十分简单。但是,提高这个模型的表现就有些困难(至少我觉得十分纠结)。这个算法使用了好几个参数。所以为了提高模型的表现,参数的调整十分必要。在解决实际问题的时候,有些问题是很难回答的——你需要调整哪些参数?这些参数要调到什么值,才能达到理想的输出?

这篇文章最适合刚刚接触XGBoost的人阅读。在这篇文章中,我们会学到参数调优的技巧,以及XGboost相关的一些有用的知识。以及,我们会用Python在一个数据集上实践一下这个算法。

2. 你需要知道的

XGBoost(eXtreme Gradient Boosting)是Gradient Boosting算法的一个优化的版本。因为我在前一篇文章,基于Python的Gradient Boosting算法参数调整完全指南,里面已经涵盖了Gradient Boosting算法的很多细节了。我强烈建议大家在读本篇文章之前,把那篇文章好好读一遍。它会帮助你对Boosting算法有一个宏观的理解,同时也会对GBM的参数调整有更好的体会。

特别鸣谢:我个人十分感谢Mr Sudalai Rajkumar (aka SRK)大神的支持,目前他在AV Rank中位列第二。如果没有他的帮助,就没有这篇文章。在他的帮助下,我们才能给无数的数据科学家指点迷津。给他一个大大的赞!

3. 内容列表

1、XGBoost的优势

2、理解XGBoost的参数

3、调参示例

4. XGBoost的优势

XGBoost算法可以给预测模型带来能力的提升。当我对它的表现有更多了解的时候,当我对它的高准确率背后的原理有更多了解的时候,我发现它具有很多优势:

4.1 正则化

- 标准GBM的实现没有像XGBoost这样的正则化步骤。正则化对减少过拟合也是有帮助的。

- 实际上,XGBoost以“正则化提升(regularized boosting)”技术而闻名。

4.2 并行处理

- XGBoost可以实现并行处理,相比GBM有了速度的飞跃。

- 不过,众所周知,Boosting算法是顺序处理的,它怎么可能并行呢?每一课树的构造都依赖于前一棵树,那具体是什么让我们能用多核处理器去构造一个树呢?我希望你理解了这句话的意思。如果你希望了解更多,点击这个链接。

- XGBoost 也支持Hadoop实现。

4.3 高度的灵活性

- XGBoost 允许用户定义自定义优化目标和评价标准

- 它对模型增加了一个全新的维度,所以我们的处理不会受到任何限制。

4.4 缺失值处理

- XGBoost内置处理缺失值的规则。

- 用户需要提供一个和其它样本不同的值,然后把它作为一个参数传进去,以此来作为缺失值的取值。XGBoost在不同节点遇到缺失值时采用不同的处理方法,并且会学习未来遇到缺失值时的处理方法。

4.5 剪枝

- 当分裂时遇到一个负损失时,GBM会停止分裂。因此GBM实际上是一个贪心算法。

- XGBoost会一直分裂到指定的最大深度(max_depth),然后回过头来剪枝。如果某个节点之后不再有正值,它会去除这个分裂。

- 这种做法的优点,当一个负损失(如-2)后面有个正损失(如+10)的时候,就显现出来了。GBM会在-2处停下来,因为它遇到了一个负值。但是XGBoost会继续分裂,然后发现这两个分裂综合起来会得到+8,因此会保留这两个分裂。

4.6 内置交叉验证

- XGBoost允许在每一轮boosting迭代中使用交叉验证。因此,可以方便地获得最优boosting迭代次数。

- 而GBM使用网格搜索,只能检测有限个值。

4.7、在已有的模型基础上继续

- XGBoost可以在上一轮的结果上继续训练。这个特性在某些特定的应用上是一个巨大的优势。

- sklearn中的GBM的实现也有这个功能,两种算法在这一点上是一致的。

相信你已经对XGBoost强大的功能有了点概念。注意这是我自己总结出来的几点,你如果有更多的想法,尽管在下面评论指出,我会更新这个列表的!

你的胃口被我吊起来了吗?棒棒哒!如果你想更深入了解相关信息,可以参考下面这些文章:

XGBoost Guide - Introduce to Boosted Trees

Words from the Auther of XGBoost [Viedo]

5. XGBoost的参数

XGBoost的作者把所有的参数分成了三类:

- 通用参数:宏观函数控制。

- Booster参数:控制每一步的booster(tree/regression)。

- 学习目标参数:控制训练目标的表现。

在这里我会类比GBM来讲解,所以作为一种基础知识,强烈推荐先阅读这篇文章。

5.1 通用参数

这些参数用来控制XGBoost的宏观功能。

1、booster[默认gbtree]

- 选择每次迭代的模型,有两种选择:

gbtree:基于树的模型

gbliner:线性模型

2、silent[默认0]

- 当这个参数值为1时,静默模式开启,不会输出任何信息。

- 一般这个参数就保持默认的0,因为这样能帮我们更好地理解模型。

3、nthread[默认值为最大可能的线程数]

- 这个参数用来进行多线程控制,应当输入系统的核数。

- 如果你希望使用CPU全部的核,那就不要输入这个参数,算法会自动检测它。

还有两个参数,XGBoost会自动设置,目前你不用管它。接下来咱们一起看booster参数。

5.2 booster参数

尽管有两种booster可供选择,我这里只介绍tree booster,因为它的表现远远胜过linear booster,所以linear booster很少用到。

1、eta[默认0.3]

- 和GBM中的 learning rate 参数类似。

- 通过减少每一步的权重,可以提高模型的鲁棒性。

- 典型值为0.01-0.2。

2、min_child_weight[默认1]

- 决定最小叶子节点样本权重和。

- 和GBM的 min_child_leaf 参数类似,但不完全一样。XGBoost的这个参数是最小样本权重的和,而GBM参数是最小样本总数。

- 这个参数用于避免过拟合。当它的值较大时,可以避免模型学习到局部的特殊样本。

- 但是如果这个值过高,会导致欠拟合。这个参数需要使用CV来调整。

3、max_depth[默认6]

- 和GBM中的参数相同,这个值为树的最大深度。

- 这个值也是用来避免过拟合的。max_depth越大,模型会学到更具体更局部的样本。

- 需要使用CV函数来进行调优。

- 典型值:3-10

4、max_leaf_nodes

- 树上最大的节点或叶子的数量。

- 可以替代max_depth的作用。因为如果生成的是二叉树,一个深度为n的树最多生成n2个叶子。

- 如果定义了这个参数,GBM会忽略max_depth参数。

5、gamma[默认0]

- 在节点分裂时,只有分裂后损失函数的值下降了,才会分裂这个节点。Gamma指定了节点分裂所需的最小损失函数下降值。

- 这个参数的值越大,算法越保守。这个参数的值和损失函数息息相关,所以是需要调整的。

6、max_delta_step[默认0]

- 这参数限制每棵树权重改变的最大步长。如果这个参数的值为0,那就意味着没有约束。如果它被赋予了某个正值,那么它会让这个算法更加保守。

- 通常,这个参数不需要设置。但是当各类别的样本十分不平衡时,它对逻辑回归是很有帮助的。

- 这个参数一般用不到,但是你可以挖掘出来它更多的用处。

7、subsample[默认1]

- 和GBM中的subsample参数一模一样。这个参数控制对于每棵树,随机采样的比例。

- 减小这个参数的值,算法会更加保守,避免过拟合。但是,如果这个值设置得过小,它可能会导致欠拟合。

- 典型值:0.5-1

8、colsample_bytree[默认1]

- 和GBM里面的max_features参数类似。用来控制每棵随机采样的列数的占比(每一列是一个特征)。

- 典型值:0.5-1

9、colsample_bylevel[默认1]

- 用来控制树的每一级的每一次分裂,对列数的采样的占比。

- 我个人一般不太用这个参数,因为subsample参数和colsample_bytree参数可以起到相同的作用。但是如果感兴趣,可以挖掘这个参数更多的用处。

10、lambda[默认1]

- 权重的L2正则化项。(和Ridge regression类似)。

- 这个参数是用来控制XGBoost的正则化部分的。虽然大部分数据科学家很少用到这个参数,但是这个参数在减少过拟合上还是可以挖掘出更多用处的。

11、alpha[默认1]

- 权重的L1正则化项。(和Lasso regression类似)。

- 可以应用在很高维度的情况下,使得算法的速度更快。

12、scale_pos_weight[默认1]

- 在各类别样本十分不平衡时,把这个参数设定为一个正值,可以使算法更快收敛。

5.3学习目标参数

这个参数用来控制理想的优化目标和每一步结果的度量方法。

1、objective[默认reg:linear]

- 这个参数定义需要被最小化的损失函数。最常用的值有:

- binary:logistic 二分类的逻辑回归,返回预测的概率(不是类别)。

- multi:softmax 使用softmax的多分类器,返回预测的类别(不是概率)。

- 在这种情况下,你还需要多设一个参数:num_class(类别数目)。

- multi:softprob 和multi:softmax参数一样,但是返回的是每个数据属于各个类别的概率。

2、eval_metric[默认值取决于objective参数的取值]

- 对于有效数据的度量方法。

- 对于回归问题,默认值是rmse,对于分类问题,默认值是error。

- 典型值有:

- rmse 均方根误差(∑Ni=1ϵ2N−−−−−√)

- mae 平均绝对误差(∑Ni=1|ϵ|N)

- logloss 负对数似然函数值

- error 二分类错误率(阈值为0.5)

- merror 多分类错误率

- mlogloss 多分类logloss损失函数

- auc 曲线下面积

3、seed(默认0)

- 随机数的种子

- 设置它可以复现随机数据的结果,也可以用于调整参数

如果你之前用的是Scikit-learn,你可能不太熟悉这些参数。但是有个好消息,Python的XGBoost模块有一个sklearn包,XGBClassifier。这个包中的参数是按sklearn风格命名的。会改变的函数名是:

1、eta -> learning_rate

2、lambda -> reg_lambda

3、alpha -> reg_alpha

你肯定在疑惑为啥咱们没有介绍和GBM中的n_estimators类似的参数。XGBClassifier中确实有一个类似的参数,但是,是在标准XGBoost实现中调用拟合函数时,把它作为num_boosting_rounds参数传入。

XGBoost Guide 的一些部分是我强烈推荐大家阅读的,通过它可以对代码和参数有一个更好的了解:

XGBoost Parameters (official guide)

XGBoost Demo Codes (xgboost GitHub repository)

Python API Reference (official guide)

调参示例

我们从Data Hackathon 3.x AV版的hackathon中获得数据集,和GBM 介绍文章中是一样的。更多的细节可以参考competition page

数据集可以从这里下载。我已经对这些数据进行了一些处理:

City变量,因为类别太多,所以删掉了一些类别。DOB变量换算成年龄,并删除了一些数据。- 增加了

EMI_Loan_Submitted_Missing变量。如果EMI_Loan_Submitted变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的EMI_Loan_Submitted变量。 EmployerName变量,因为类别太多,所以删掉了一些类别。- 因为

Existing_EMI变量只有111个值缺失,所以缺失值补充为中位数0。 - 增加了

Interest_Rate_Missing变量。如果Interest_Rate变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Interest_Rate变量。 - 删除了

Lead_Creation_Date,从直觉上这个特征就对最终结果没什么帮助。 Loan_Amount_Applied, Loan_Tenure_Applied两个变量的缺项用中位数补足。- 增加了

Loan_Amount_Submitted_Missing变量。如果Loan_Amount_Submitted变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Loan_Amount_Submitted变量。 - 增加了

Loan_Tenure_Submitted_Missing变量。如果Loan_Tenure_Submitted变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Loan_Tenure_Submitted变量。 - 删除了

LoggedIn,Salary_Account两个变量 - 增加了

Processing_Fee_Missing变量。如果Processing_Fee变量的数据缺失,则这个参数的值为1。否则为0。删除了原先的Processing_Fee变量。 Source前两位不变,其它分成不同的类别。- 进行了离散化和独热编码(一位有效编码)。

如果你有原始数据,可以从资源库里面下载data_preparation的Ipython notebook 文件,然后自己过一遍这些步骤。

载入必要库:

[python] view plain copy

- import pandas as pd

- import numpy as np

- import xgboost as xgb

- from xgboost.sklearn import XGBClassifier

- from sklearn.model_selection import GridSearchCV,cross_val_score

- from sklearn import metrics

- import matplotlib.pylab as plt

读取文件

[python] view plain copy

- train_df = pd.read_csv('train_modified.csv')

- train_y = train_df.pop('Disbursed').values

- test_df = pd.read_csv('test_modified.csv')

- train_df.drop('ID',axis=1,inplace=True)

- test_df.drop('ID',axis=1,inplace=True)

- train_X = train_df.values

然后评分函数未下:

[python] view plain copy

- def modelMetrics(clf,train_x,train_y,isCv=True,cv_folds=5,early_stopping_rounds=50):

- if isCv:

- xgb_param = clf.get_xgb_params()

- xgtrain = xgb.DMatrix(train_x,label=train_y)

- cvresult = xgb.cv(xgb_param,xgtrain,num_boost_round=clf.get_params()['n_estimators'],nfold=cv_folds,

- metrics='auc',early_stopping_rounds=early_stopping_rounds)#是否显示目前几颗树额

- clf.set_params(n_estimators=cvresult.shape[0])

- clf.fit(train_x,train_y,eval_metric='auc')

- #预测

- train_predictions = clf.predict(train_x)

- train_predprob = clf.predict_proba(train_x)[:,1]#1的概率

- #打印

- print("\nModel Report")

- print("Accuracy : %.4g" % metrics.accuracy_score(train_y, train_predictions))

- print("AUC Score (Train): %f" % metrics.roc_auc_score(train_y, train_predprob))

- feat_imp = pd.Series(clf.booster().get_fscore()).sort_values(ascending=False)

- feat_imp.plot(kind='bar',title='Feature importance')

- plt.ylabel('Feature Importance Score')

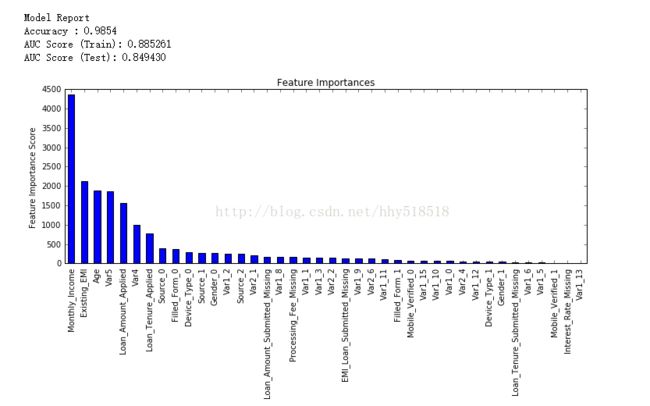

我们测试下:

Model Report Accuracy : 0.9854 AUC Score (Train): 0.851058

我们看下其中具体的cv结果

cvresult.shape[0]是其中我们用的树的个数

cvresult的结果是一个DataFrame

6.1 参数调优的一般方法

我们会使用和GBM中相似的方法。需要进行如下步骤:

-

选择较高的学习速率(learning rate)。一般情况下,学习速率的值为0.1。但是,对于不同的问题,理想的学习速率有时候会在0.05到0.3之间波动。选择对应于此学习速率的理想决策树数量。XGBoost有一个很有用的函数“cv”,这个函数可以在每一次迭代中使用交叉验证,并返回理想的决策树数量。

-

对于给定的学习速率和决策树数量,进行决策树特定参数调优(max_depth, min_child_weight, gamma, subsample, colsample_bytree)。在确定一棵树的过程中,我们可以选择不同的参数,待会儿我会举例说明。

-

xgboost的正则化参数的调优。(lambda, alpha)。这些参数可以降低模型的复杂度,从而提高模型的表现。

-

降低学习速率,确定理想参数。

-

第一步:确定学习速率和tree_based 参数调优的估计器数目

为了确定boosting参数,我们要先给其它参数一个初始值。咱们先按如下方法取值:

1、max_depth = 5 :这个参数的取值最好在3-10之间。我选的起始值为5,但是你也可以选择其它的值。起始值在4-6之间都是不错的选择。

2、min_child_weight = 1:在这里选了一个比较小的值,因为这是一个极不平衡的分类问题。因此,某些叶子节点下的值会比较小。

3、gamma = 0: 起始值也可以选其它比较小的值,在0.1到0.2之间就可以。这个参数后继也是要调整的。

4、subsample, colsample_bytree = 0.8: 这个是最常见的初始值了。典型值的范围在0.5-0.9之间。

5、scale_pos_weight = 1: 这个值是因为类别十分不平衡。

这里把学习速率就设成默认的0.1。然后用xgboost中的cv函数来确定最佳的决策树数量。前文中的函数可以完成这个工作。

[python] view plain copy

- def tun_parameters(train_x,train_y):

- xgb1 = XGBClassifier(learning_rate=0.1,n_estimators=1000,max_depth=5,min_child_weight=1,gamma=0,subsample=0.8,

- colsample_bytree=0.8,objective= 'binary:logistic',nthread=4,scale_pos_weight=1,seed=27)

- modelMetrics(xgb1,train_x,train_y)

然后我们得到如下的结果:

是根据交叉验证中迭代中

n_estimators: 112 Model Report Accuracy : 0.9854 AUC Score (Train): 0.891681

每一次迭代中使用交叉验证,并返回理想的决策树数量。这个值取决于系统的性能。

第二步: max_depth 和 min_child_weight 参数调优

[python] view plain copy

- param_test1 = {

- 'max_depth':range(3,10,2),

- 'min_child_weight':range(1,6,2)

- }

- gsearch1 = GridSearchCV(estimator=XGBClassifier( learning_rate =0.1, n_estimators=140, max_depth=5,

- min_child_weight=1, gamma=0, subsample=0.8,colsample_bytree=0.8,

- objective= 'binary:logistic', nthread=4,scale_pos_weight=1, seed=27),

- param_grid=param_test1,scoring='roc_auc',iid=False,cv=5)

- gsearch1.fit(train_X,train_y)

- gsearch1.grid_scores_,gsearch1.best_params_,gsearch1.best_score_

我们看见min_child_weight已经在边界处了所以我们还可以继续调整,也可以在下个参数一起调节

我们得到max_depth的理想取值为4,min_child_weight的理想取值为6。同时,我们还能看到cv的得分有了小小一点提高。需要注意的一点是,随着模型表现的提升,进一步提升的难度是指数级上升的,尤其是你的表现已经接近完美的时候。

我们能够进一步看是否6比较好,

[python] view plain copy

- param_test2b = {

- 'min_child_weight': [6, 8, 10, 12]

- }

- gsearch2b = GridSearchCV(estimator=XGBClassifier(learning_rate=0.1, n_estimators=140, max_depth=4,

- min_child_weight=2, gamma=0, subsample=0.8, colsample_bytree=0.8,

- objective='binary:logistic', nthread=4, scale_pos_weight=1,

- seed=27), param_grid=param_test2b, scoring='roc_auc', n_jobs=4,

- iid=False, cv=5)

- gsearch2b.fit(train_x, train_y)

- gsearch2b.grid_scores_, gsearch2b.best_params_, gsearch2b.best_score_

- modelMetrics(gsearch2b, train_x, train_y)

6确实是最佳的值了,不用再调节了。

然后我们拟合一下看下模型评分:

n_estimators: 140 Model Report Accuracy : 0.9854 AUC Score (Train): 0.875086

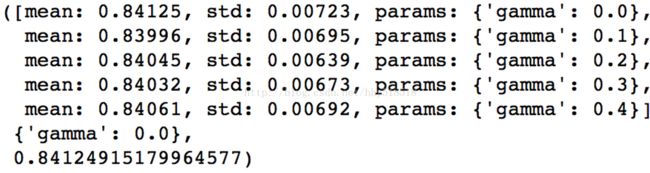

第三步:gamma参数调优

在已经调整好其它参数的基础上,我们可以进行gamma参数的调优了。Gamma参数取值范围可以很大,我这里把取值范围设置为5了。你其实也可以取更精确的gamma值。

[python] view plain copy

- param_test3 = {

- 'gamma': [i / 10.0 for i in range(0, 5)]

- }

- gsearch3 = GridSearchCV(

- estimator=XGBClassifier(learning_rate=0.1, n_estimators=140, max_depth=4, min_child_weight=6, gamma=0,

- subsample=0.8, colsample_bytree=0.8, objective='binary:logistic', nthread=4,

- scale_pos_weight=1, seed=27), param_grid=param_test3, scoring='roc_auc', n_jobs=4,

- iid=False, cv=5)

- gsearch3.fit(train_x,train_y)

- gsearch3.grid_scores_, gsearch3.best_params_, gsearch3.best_score_

从这里,可以看出,得分提高了。所以,最终得到的参数是:

xgb2 = XGBClassifier(

learning_rate =0.1,

n_estimators=1000,

max_depth=4,

min_child_weight=6,

gamma=0,

subsample=0.8,

colsample_bytree=0.8,

objective= 'binary:logistic',

nthread=4,

scale_pos_weight=1,

seed=27)

modelfit(xgb2, train, predictors)第四步:调整subsample 和 colsample_bytree 参数

这两个参数相当于每个树的样本和参数个数

[python] view plain copy

- param_test4 = {

- 'subsample': [i / 10.0 for i in range(6, 10)],

- 'colsample_bytree': [i / 10.0 for i in range(6, 10)]

- }

- gsearch4 = GridSearchCV(

- estimator=XGBClassifier(learning_rate=0.1, n_estimators=177, max_depth=3, min_child_weight=4, gamma=0.1,

- subsample=0.8, colsample_bytree=0.8, objective='binary:logistic', nthread=4,

- scale_pos_weight=1, seed=27), param_grid=param_test4, scoring='roc_auc', n_jobs=4,

- iid=False, cv=5)

- gsearch4.fit(train_x, train_y)

- gsearch4.grid_scores_, gsearch4.best_params_, gsearch4.best_score_

([mean: 0.83836, std: 0.00840, params: {'subsample': 0.6, 'colsample_bytree': 0.6},

mean: 0.83720, std: 0.00976, params: {'subsample': 0.7, 'colsample_bytree': 0.6},

mean: 0.83787, std: 0.00758, params: {'subsample': 0.8, 'colsample_bytree': 0.6},

mean: 0.83776, std: 0.00762, params: {'subsample': 0.9, 'colsample_bytree': 0.6},

mean: 0.83923, std: 0.01005, params: {'subsample': 0.6, 'colsample_bytree': 0.7},

mean: 0.83800, std: 0.00853, params: {'subsample': 0.7, 'colsample_bytree': 0.7},

mean: 0.83819, std: 0.00779, params: {'subsample': 0.8, 'colsample_bytree': 0.7},

mean: 0.83925, std: 0.00906, params: {'subsample': 0.9, 'colsample_bytree': 0.7},

mean: 0.83977, std: 0.00831, params: {'subsample': 0.6, 'colsample_bytree': 0.8},

mean: 0.83867, std: 0.00870, params: {'subsample': 0.7, 'colsample_bytree': 0.8},

mean: 0.83879, std: 0.00797, params: {'subsample': 0.8, 'colsample_bytree': 0.8},

mean: 0.84144, std: 0.00854, params: {'subsample': 0.9, 'colsample_bytree': 0.8},

mean: 0.83878, std: 0.00760, params: {'subsample': 0.6, 'colsample_bytree': 0.9},

mean: 0.83922, std: 0.00823, params: {'subsample': 0.7, 'colsample_bytree': 0.9},

mean: 0.83912, std: 0.00765, params: {'subsample': 0.8, 'colsample_bytree': 0.9},

mean: 0.83926, std: 0.00843, params: {'subsample': 0.9, 'colsample_bytree': 0.9}],

{'colsample_bytree': 0.8, 'subsample': 0.9},

0.84143722014693034)

若我们再将精度增加的话,我们将步长调节到0.05

我们得到的理想取值还是原来的值。因此,最终的理想取值是:

- subsample: 0.8

- colsample_bytree: 0.8

第五步:正则化参数调优

下一步是应用正则化来降低过拟合。由于gamma函数提供了一种更加有效地降低过拟合的方法,大部分人很少会用到这个参数。但是我们在这里也可以尝试用一下这个参数。

[python] view plain copy

- param_test6 = {

- 'reg_alpha':[1e-5, 1e-2, 0.1, 1, 100]

- }

- gsearch6 = GridSearchCV(estimator = XGBClassifier( learning_rate =0.1, n_estimators=177, max_depth=4, min_child_weight=6, gamma=0.1, subsample=0.8, colsample_bytree=0.8, objective= 'binary:logistic', nthread=4, scale_pos_weight=1,seed=27), param_grid = param_test6, scoring='roc_auc',n_jobs=4,iid=False, cv=5)

- gsearch6.fit(train_X, train_y)

- gsearch6.grid_scores_, gsearch6.best_params_, gsearch6.best_score_

([mean: 0.83949, std: 0.00720, params: {'reg_alpha': 1e-05},

mean: 0.83940, std: 0.00607, params: {'reg_alpha': 0.01},

mean: 0.84005, std: 0.00638, params: {'reg_alpha': 0.1},

mean: 0.84062, std: 0.00775, params: {'reg_alpha': 1},

mean: 0.81217, std: 0.01559, params: {'reg_alpha': 100}],

{'reg_alpha': 1},

0.84062434371797357)

相比之前的结果,CV的得分甚至还降低了。但是我们之前使用的取值是十分粗糙的,我们在这里选取一个比较靠近理想值(0.01)的取值,来看看是否有更好的表现。

[python] view plain copy

- param_test7 = {

- 'reg_alpha': [0, 0.001, 0.005, 0.01, 0.05]

- }

- gsearch7 = GridSearchCV(

- estimator=XGBClassifier(learning_rate=0.1, n_estimators=177, max_depth=4, min_child_weight=6, gamma=0.1,

- subsample=0.8, colsample_bytree=0.8, objective='binary:logistic', nthread=4,

- scale_pos_weight=1, seed=27), param_grid=param_test7, scoring='roc_auc', n_jobs=4,

- iid=False, cv=5)

- gsearch7.fit(train_x, train_y)

- gsearch7.grid_scores_, gsearch7.best_params_, gsearch7.best_score_

调整精度以后

CV的得分提高了。现在,我们在模型中来使用正则化参数,来看看这个参数的影响。

xgb3 = XGBClassifier(

learning_rate =0.1,

n_estimators=1000,

max_depth=4,

min_child_weight=6,

gamma=0,

subsample=0.8,

colsample_bytree=0.8,

reg_alpha=0.005,

objective= 'binary:logistic',

nthread=4,

scale_pos_weight=1,

seed=27)[python] view plain copy

现在我们可以来看下reg_lambda参数调节:

([mean: 0.83996, std: 0.00597, params: {'reg_lambda': 1e-05},

mean: 0.84030, std: 0.00580, params: {'reg_lambda': 0.01},

mean: 0.83965, std: 0.00574, params: {'reg_lambda': 0.1},

mean: 0.84035, std: 0.00622, params: {'reg_lambda': 1},

mean: 0.83601, std: 0.00944, params: {'reg_lambda': 100}],

{'reg_lambda': 1},

0.84035395025572046)

[python] view plain copy

- param_test8 = {

- 'reg_lambda': [1e-5, 1e-2, 0.1, 1, 100]

- }

- gsearch8 = GridSearchCV(

- estimator=XGBClassifier(learning_rate =0.1, n_estimators=177,max_depth=4,min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, reg_alpha=0.005,

- objective= 'binary:logistic',nthread=4, scale_pos_weight=1,seed=27), param_grid=param_test8, scoring='roc_auc', n_jobs=4,

- iid=False, cv=5)

- gsearch8.fit(train_X, train_y)

- gsearch8.grid_scores_, gsearch8.best_params_, gsearch8.best_score_

第6步:降低学习速率

最后,我们使用较低的学习速率,以及使用更多的决策树。我们可以用XGBoost中的CV函数来进行这一步工作。

xgb4 = XGBClassifier( learning_rate =0.01, n_estimators=5000, max_depth=4, min_child_weight=6, gamma=0, subsample=0.8, colsample_bytree=0.8, reg_alpha=0.005, objective= 'binary:logistic', nthread=4, scale_pos_weight=1, seed=27)

我们看下最后的模型评分

至此,你可以看到模型的表现有了大幅提升,调整每个参数带来的影响也更加清楚了。 在文章的末尾,我想分享两个重要的思想: 1、仅仅靠参数的调整和模型的小幅优化,想要让模型的表现有个大幅度提升是不可能的。GBM的最高得分是0.8487,XGBoost的最高得分是0.8494。确实是有一定的提升,但是没有达到质的飞跃。 2、要想让模型的表现有一个质的飞跃,需要依靠其他的手段,诸如,特征工程(feature egineering) ,模型组合(ensemble of model),以及堆叠(stacking)等。