C-COT: Continuous Convolution Operators for Visual Tracking 论文学习

Beyond Correlation Filters: Learning Continuous Convolution Operators for Visual Tracking

- Abstract

- 1. Introduction

- 2. Related Work

- 3. Learning Continuous Convolution Operators

- 3.1 Preliminaries and Notation

- 3.2 Our Continuous Learning Formulation

- 3.3 Training the Continuous Filter

- 3.4 Desired Confidence and Interpolation Function

- 3.5 Generalization to Higher Dimension

- 4. Tracking Frameworks

- 4.1 Localization step

- 4.2 Object Tracking Framework

- 4.3 Feature Point Tracking Framework

论文地址:https://arxiv.org/pdf/1608.03773.pdf

代码地址:https://github.com/martin-danelljan/Continuous-ConvOp

Abstract

Discriminative Correlation Filters(DCF) 在目标追踪方面表现出极大的优势。其成功的关键在于能有效地利用训练样本的所有平移版本作为可利用的负样本。但是,DCF 模式本身被限定在单分辨率特征图上,极大地束缚了其潜力。这篇论文突破传统的 DCF 方法,提出了一个新的训练连续卷积滤波器的方法。作者使用一个内插模型把学习问题放置于连续的空间域中。它能有效地集成多分辨率深度特征图,在3个目标跟踪 benchmarks 上表现优越:OTB-2015(+ 5.1% in mean OP), Temple-Color(+4.6% in mean OP), VOT2015(在失败率上降低了20%)。此外,此方法能进行亚像素(sub-pixel)定位,这对高精度的特征点追踪至关重要。

1. Introduction

目标跟踪是一个计算视频中目标轨迹的任务,这是计算机视觉中的基础问题之一。目标或特征点跟踪在机器人和安防等领域有着广泛应用。近些年,基于 DCF 的方法在目标跟踪 benchmarks 上成绩斐然。DCF 方法训练一个 相关滤波器(correlation filter) 来预测目标分类分数。与其他方法不同,DCF 通过离散傅里叶变换,高效地利用训练样本所有的空间位移。

CNNs 在很多任务上的表现令人印象深刻,因而产生了将其与 DCF 跟踪器结合的想法。CNN 包括了卷积,归一化与池化等多层。最近,最后的卷积层的特征图已经被运用到图像分类。深层卷积的特征有足够的判别度,同时保存了空间和结构信息。但是近期基于 DCF 的方法则展现了浅层卷积层的重要性,这些层提供了更高的分辨率,对于精准的目标定位至关重要。然而,如何将多个卷积层融入 DCF 框架仍有待探讨。

传统 DCF 模式受限于单精度特征图。因此,所有的特征通道必须有一样的空间分辨率,比如 HOG 描述器。这个限制阻碍了具有不同分辨率的卷积层进行融合。解决这个限制的直接方法就是,对所有的特征通道重新采样,使得它们的分辨率一致。但是,重新采样的过程不仅繁琐,而且增加了人工干预的成分。

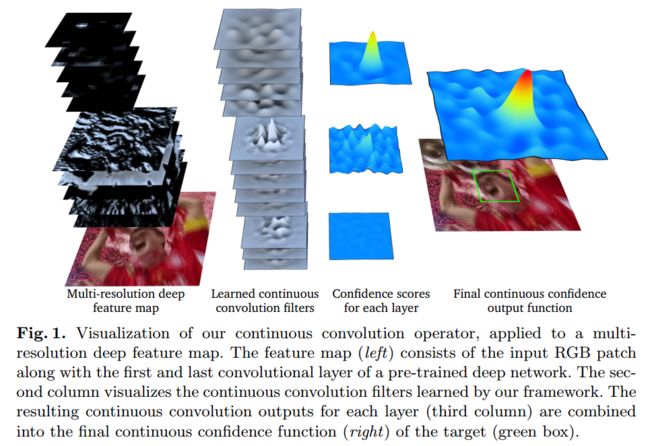

这篇论文提出了一个在连续空间域中学习卷积算子的新型方法。它在训练样本上使用了一个内插模型,学习一组卷积滤波器,对目标物体生成一个连续域置信图(continuous-domain confidence map)。这使得多分辨率特征图在一个联合学习的方法中完美融合。图一展示了在融合多分辨率特征图时,连续卷积算子(continuous convolution operator)操作的可视化。

除了多分辨率融合,此连续域学习方法能够精准地进行亚像素定位,这是通过将训练样本利用亚像素精度的连续置信图进行标定得到的。我们的方法因此适用于准确的特征点跟踪。作在 MPI Sintel 数据集上进行了准确性和鲁棒性测试。

2. Related Work

DCF 方法在目标追踪上成绩不错。它以滑动窗口的方式,利用循环相关特性 (circular correlation)特性来训练回归器。最初,DCF 方法被限制在单特征通道。后来,DCF 框架被推广到了多通道特征图。多通道的 DCF 允许使用高维度特征来提升追踪效果,比如 HOG 和 Color Names。除了加入多通道特征,DCF 框架现已通过加入尺度估计,非线性核,长时跟踪,以及改善循环卷积的周期效应,极大地提高了性能。

最近人们发现,CNNs 最后的卷积层对图像分类很有用,另一方面,浅层卷积层很适合用于目标追踪。较深的卷积层判别力强,能找出复杂的特征。浅的卷积层识别的特征较简单,但是空间分辨率高,很适合定位使用。作者在联合学习框架中提出了一个新型的连续方程,用于融合多个不同空间分辨率的卷积层。

与目标追踪不同,特征点追踪是要高精度地计算关键点的运动轨迹。经典方法有 Kanade-Lucas-Tomasi 追踪器。 KLT 追踪器是一个生成模型,最小化两个图片区域的均方误差。但是,作者针对特征点追踪,提出了一个可区分性的基于学习的方法。

本文方法:提出了一个理论框架,在连续空间域中学习可区分性的卷积算子。和传统 DCF 方法比,它有2个优势:

- 自然地融合多通道特征图,例如卷积层和多分辨率HOG特征及色彩特征的结合;

- 能够精准进行亚像素定位。

3. Learning Continuous Convolution Operators

3.1 Preliminaries and Notation

作者在这篇论文里使用了连续傅里叶分析里的概念和结论。为了清晰可见,作者首先介绍了一维空间中的数据学习方法(只有一个 spatial variable 的函数)。然后推广到高维空间,包括图像。

我们考虑复值函数 g : R → C g: \mathbb{R}\rightarrow \mathbb{C} g:R→C 对应的空间 L 2 ( T ) L^2(T) L2(T), g g g具有周期性,周期是 T > 0 T>0 T>0,并且勒贝格平方可积。 L 2 ( T ) L^2(T) L2(T) 是一个希尔伯特空间(Hilbert space),其定义有一个内积 ⟨ ⋅ , ⋅ ⟩ \langle \cdot,\cdot \rangle ⟨⋅,⋅⟩。对于函数 g , h ∈ L 2 ( T ) g,h\in L^2(T) g,h∈L2(T):

⟨ g , h ⟩ = 1 T ∫ 0 T g ( t ) h ( t ) ‾ d t , g ∗ h ( t ) = 1 T ∫ 0 T g ( t − s ) h ( s ) d s . ( 1 ) \langle g,h \rangle = \frac{1}{T}\int_0^T g(t)\overline{h(t)}dt,\quad\quad g\ast h(t) = \frac{1}{T}\int_0^T g(t-s)h(s) ds.\quad\quad\quad (1) ⟨g,h⟩=T1∫0Tg(t)h(t)dt,g∗h(t)=T1∫0Tg(t−s)h(s)ds.(1)

横线表示复数共轭。(1)式中作者定义了循环卷积算子(circular convolution operator) ∗ : L 2 ( T ) × L 2 ( T ) → L 2 ( T ) . \ast: L^2(T)\times L^2(T) \rightarrow L^2(T). ∗:L2(T)×L2(T)→L2(T).

在推导过程中,作者使用了复数指数函数 e k ( t ) = e i 2 π T k t e_k(t) = e^{i \frac{2\pi}{T}kt} ek(t)=eiT2πkt,因为它们是卷积算子 (1) 的特征函数。 { e k } − ∞ ∞ \{e_k\}^{\infin}_{-\infin} {ek}−∞∞集合形成 L 2 ( T ) L^2(T) L2(T)的标准正交基。作者定义了 g ∈ L 2 ( T ) g\in L^2(T) g∈L2(T)的傅里叶系数为 g ^ [ k ] = ⟨ g , e k ⟩ \hat g[k]=\langle g,e_k \rangle g^[k]=⟨g,ek⟩。为了清晰可见,我们使用了方括号代表离散域的函数。任何 g ∈ L 2 ( T ) g \in L^2(T) g∈L2(T) 都可以表达成傅里叶级数形式, g = ∑ − ∞ + ∞ g ^ [ k ] e k g=\sum_{-\infin}^{+\infin} \hat g[k]e_k g=∑−∞+∞g^[k]ek。其中,傅里叶系数满足 Parseval’s formula ∣ ∣ g ∣ ∣ 2 = ∣ ∣ g ^ ∣ ∣ l 2 2 ||g||^2=||\hat g||^2_{l^2} ∣∣g∣∣2=∣∣g^∣∣l22,其中 ∣ ∣ g ∣ ∣ 2 = ⟨ g , g ⟩ ||g||^2 = \langle g,g \rangle ∣∣g∣∣2=⟨g,g⟩, 并且 ∣ ∣ g ^ ∣ ∣ l 2 2 = ∑ − ∞ ∞ ∣ g ^ [ k ] ∣ 2 ||\hat g||^2_{l^2} = \sum_{-\infin}^{\infin} |\hat g[k]|^2 ∣∣g^∣∣l22=∑−∞∞∣g^[k]∣2 是 l 2 l^2 l2 — 范数的平方。而且,傅里叶系数满足两个卷积性质, g ∗ h ^ = g ^ h ^ \widehat {g \ast h} = \hat g \hat h g∗h =g^h^ 和 g h ^ = g ^ ∗ h ^ \widehat{gh}=\hat g \ast \hat h gh =g^∗h^,其中 g ^ ∗ h ^ [ k ] : = ∑ l = − ∞ ∞ g ^ [ k − l ] h ^ [ l ] \hat g \ast \hat h[k] := \sum_{l=-\infin}^{\infin} \hat g[k-l] \hat h[l] g^∗h^[k]:=∑l=−∞∞g^[k−l]h^[l]。

3.2 Our Continuous Learning Formulation

目的是基于训练样本 x j x_j xj 训练一个连续卷积算子。样本由各图片区域中提取的特征图组成。这些样本 x j x_j xj 包含 D D D 个从同一个图像区块提取的特征通道 x j 1 , ⋯ , x j D x_j^1,\cdots,x_j^D xj1,⋯,xjD。传统 DCF 方程假设每个特征通道有着一样的空间分辨率,比如说有着相同个数的空间采样点。不像之前的工作,作者去除了方程中的这个限制,并且让 N d N_d Nd指代 x j d x_j^d xjd中的采样数。在我们的方程中,特征通道 x j d ∈ R N d x_j^d \in \mathbb{R}^{N_d} xjd∈RNd 被看作是由离散空间变量 n ∈ { 0 , ⋯ , N d } n\in \{0,\cdots,N^d\} n∈{0,⋯,Nd}索引的函数 x j d [ n ] x_j^d[n] xjd[n]。采样空间表达成 χ = R N 1 × ⋯ × R N D \chi = \mathbb{R}^{N_1}\times \cdots \times \mathbb{R}^{N_D} χ=RN1×⋯×RND。

为了处理连续空间域内的学习问题,我们引入了训练样本的内插模型。我们将区间 [ 0 , T ) ∈ R [0,T)\in \mathbb{R} [0,T)∈R 视作特征图的空间支持。这里,标量 T T T代表支持区间的大小。然后,在实际操作中, T T T是任意的,因为它代表坐标系缩放比。对于每一个特征通道 d d d,我们定义插值操作: J d : R N d → L 2 ( T ) J_d:\mathbb{R}^{N_d} \rightarrow L^2(T) Jd:RNd→L2(T)有如下形式:

J d { x d } ( t ) = ∑ n = 0 N d − 1 x d [ n ] b d ( t − T N d n ) ( 2 ) J_d\{x^d\}(t) = \sum_{n=0}^{N_{d}-1}x^d[n]b_d(t-\frac{T}{N_d}n)\quad\quad\quad (2) Jd{xd}(t)=n=0∑Nd−1xd[n]bd(t−NdTn)(2)

插值样本 J d { x d } ( t ) J_d\{x^d\}(t) Jd{xd}(t)由一个内插函数 b d ∈ L 2 ( T ) b_d\in L^2(T) bd∈L2(T)的各个平移形式的叠加构造出来。在(2)中,特征值 x d [ n ] x^d[n] xd[n]在其中扮演每个平移后的函数的加权值。和传统的离散 DCF 方程的周期假设类似,特征图的周期扩展被应用到方程(2)这里。

正如之前讨论的,我们的目标是学习一个线性卷积算子 S f : χ → L 2 ( T ) S_f: \chi \rightarrow L^2(T) Sf:χ→L2(T)。这个算子将样本 x ∈ χ x\in \chi x∈χ映射到一个定义在连续区间 [ 0 , T ) [0,T) [0,T)中的目标置信函数 s ( t ) = S f { x } ( t ) s(t)=S_f\{x\}(t) s(t)=Sf{x}(t)。这里, s ( t ) ∈ R s(t)\in \mathbb{R} s(t)∈R是目标在图像中的位置 t ∈ [ 0 , T ) t\in [0,T) t∈[0,T)处的置信分数。和其它 discriminative 方式类似,目标通过寻找图片区域中的最大置信得分来定位。在我们的方程中,最关键的不同在于,置信分是在连续域上定义的。因此,我们的方程可以以更高的精度定位目标。

在我们的连续域方程中,算子 S f S_f Sf是由一系列卷积滤波器 f = ( f 1 , ⋯ , f D ) ∈ L 2 ( T ) D f=(f^1,\cdots,f^D)\in L^2(T)^D f=(f1,⋯,fD)∈L2(T)D参数化的。这里, f d ∈ L 2 ( T ) f^d\in L^2(T) fd∈L2(T)是针对特征通道 d d d的连续滤波器。我们定义卷积算子为:

S f { x } = ∑ d = 1 D f d ∗ J d { x d } , x ∈ χ ( 3 ) S_f\{x\} = \sum_{d=1}^D f^d \ast J_d\{x^d\}, \quad \quad x\in \chi \quad\quad\quad (3) Sf{x}=d=1∑Dfd∗Jd{xd},x∈χ(3)

这里,每个特征通道首先用(2)插值,然后和对应的滤波器进行卷积。记住卷积是在由(1)定义的连续域中应用的。最后一步,所有滤波器的卷积响应加起来产生了最后的置信函数。

在标准的 DCF 中,每一个训练样本由一个代表期望卷积输出的离散函数标定。与之不同,我们的样本 x j ∈ χ x_j \in \chi xj∈χ由定义在连续空间域内的置信函数 y j ∈ L 2 ( T ) y_j\in L^2(T) yj∈L2(T)标定。这里, y j y_j yj是卷积算子 S f { x j } S_f\{x_j\} Sf{xj}应用到训练样本 x j x_j xj上的设计输出。这使得 sub-pixel 精度信息在学习中合并了。滤波器 f f f在给定的 m m m个训练样本 pairs { x i , x j } 1 m ⊂ χ × L 2 ( T ) \{x_i, x_j\}^m_1 \subset \chi \times L^2(T) {xi,xj}1m⊂χ×L2(T)下训练,即最小化函数:

E ( f ) = ∑ j = 1 m α j ∣ ∣ S f { x j } − y j ∣ ∣ 2 + ∑ d = 1 D ∣ ∣ ω f d ∣ ∣ 2 ( 4 ) E(f)=\sum_{j=1}^m \alpha_j ||S_f\{x_j\} - y_j||^2 + \sum_{d=1}^D ||\omega f^d||^2\quad\quad\quad (4) E(f)=j=1∑mαj∣∣Sf{xj}−yj∣∣2+d=1∑D∣∣ωfd∣∣2(4)

这里,权重 α j ≥ 0 \alpha_j \geq 0 αj≥0控制着每个训练样本的影响力。我们额外地包含了一个空间正则化项,它由乘法函数 ω \omega ω决定。这个正则化使得滤波器能够通过控制滤波器的空间长度在任意大的区域上学习。通常对于背景的空间区域,在 ω \omega ω中被分配更大的惩罚值,而目标区域则对应较小的惩罚值。因此, ω \omega ω代表着依赖于其空间位置的特征先验知识。惩罚函数 ω \omega ω 是定义在整个连续区域 [ 0 , T ) [0,T) [0,T)之上,而且周期性拓展到了 ω ∈ L 2 ( T ) \omega \in L^2(T) ω∈L2(T)。因此,方程(4)要求 ∣ ∣ ω f d ∣ ∣ < ∞ ||\omega f^d||<\infin ∣∣ωfd∣∣<∞。而这一点,已经隐含在了我们随后的假设中,即 ω \omega ω含有有限个非零傅里叶系数 ω ^ [ k ] \hat \omega[k] ω^[k]。接下来,我们将用提出的方程(4) 推导训练连续滤波器 f f f的过程。

3.3 Training the Continuous Filter

为了训练滤波器 f f f,我们将在傅里叶域中最小化函数(4)。通过应用傅里叶分析的结论,插值后的特征图的傅里叶系数可以由 J d { x d } ^ [ k ] = X d [ k ] b ^ d [ k ] \widehat {J_d\{x^d\}}[k] = X^d [k] \hat b_d [k] Jd{xd} [k]=Xd[k]b^d[k]表示。这里, X d [ k ] : = ∑ n = 0 N d − 1 x d [ n ] e − i 2 π N d n k , k ∈ Z X^d [k] := \sum_{n=0}^{N_d-1}x^d [n]e^{-i \frac{2\pi}{N_d}nk}, k\in \mathbb{Z} Xd[k]:=∑n=0Nd−1xd[n]e−iNd2πnk,k∈Z是 x d x^d xd的离散傅里叶变换。通过使用3.1节描述的线性和卷积性质,输出置信函数(3)的傅里叶系数推导得到:

S f { x } ^ [ k ] = ∑ d = 1 D f ^ d X d [ k ] b ^ d [ k ] , k ∈ Z . ( 5 ) \widehat {S_f\{x\}}[k] = \sum_{d=1}^D \hat f^d X^d [k] \hat b_d [k], k\in \mathbb{Z}.\quad\quad\quad (5) Sf{x} [k]=d=1∑Df^dXd[k]b^d[k],k∈Z.(5)

通过应用 Parseval’s formula 到(4)和利用(5),可以得到:

E ( f ) = ∑ j = 1 m α j ∣ ∣ ∑ d = 1 D f ^ d X j d b ^ d − y ^ j ∣ ∣ l 2 2 + ∑ d = 1 D ∣ ∣ ω ^ ∗ f ^ d ∣ ∣ l 2 2 ( 6 ) E(f)=\sum_{j=1}^m \alpha_j ||\sum_{d=1}^D \hat f^d X_j^d \hat b_d - \hat y_j||^2_{l^2} + \sum_{d=1}^D ||\hat \omega \ast \hat f^d||^2_{l^2}\quad\quad\quad (6) E(f)=j=1∑mαj∣∣d=1∑Df^dXjdb^d−y^j∣∣l22+d=1∑D∣∣ω^∗f^d∣∣l22(6)

因此,泛函 E ( f ) E(f) E(f)最小化可以等价于其相对每个滤波器 f d f^d fd的傅里叶系数 f ^ d [ k ] \hat f^d[k] f^d[k]的最小化。我们利用傅里叶域的方程(6)去最小化原始的代价函数(4)。

出于实际考虑,滤波器 f f f需要由一个有限参数集合表示。有一种方法是利用一个参数化模型去描述无限数目的参数。但是,在本论文中,我们是通过最小化由有限维子空间 V = s p a n { e k } − K 1 K 1 × ⋯ × s p a n { e k } − K D K D V = span\{e_k\}^{K_1}_{-K_1} \times \cdots \times span\{e_k\}^{K_D}_{-K_D} V=span{ek}−K1K1×⋯×span{ek}−KDKD 表示的方程(6)来获得有限描述。也就是,我们相对于系数 { f ^ d [ k ] } − K D K D \{\hat f^d[k]\}^{K_D}_{-K_D} {f^d[k]}−KDKD最小化(6),同时假设当 ∣ k ∣ > K d |k|>K_d ∣k∣>Kd时, f ^ 2 [ k ] = 0 \hat f^2[k]=0 f^2[k]=0。实践中, K d K_d Kd决定了学习过程中对于特征通道 d d d中被计算的滤波器系数 f ^ d [ k ] \hat f^d[k] f^d[k]的数目。增加 K d K_d Kd可以对滤波器更好地估计,但是代价是增加了计算量和存储消耗。在实验中,作者设置 K d = ⌊ N d 2 ⌋ K_d=\lfloor \frac{N_d}{2}\rfloor Kd=⌊2Nd⌋,使得 d d d通道存储的滤波器系数的数目和训练样本 x d x^d xd的空间分辨率 N d N_d Nd相等。

为了推导满足 f ∈ V f\in V f∈V的最小化问题(6)的解,我们引入了非零傅里叶系数的组成的向量 f ^ d = ( f ^ d [ − K d ] ⋯ f ^ d [ K d ] ) T ∈ C 2 K d + 1 \bm{\hat f^d} = (\hat f^d[-K_d] \cdots \hat f^d[K_d])^T \in \mathbb{C}^{2K_d+1} f^d=(f^d[−Kd]⋯f^d[Kd])T∈C2Kd+1,并且定义系数向量 f ^ = [ ( f ^ 1 ) T , ⋯ , ( f ^ D ) T ] T \bm{\hat f}=[(\bm{\hat f}^1)^T, \cdots, (\bm{\hat f}^D)^T]^T f^=[(f^1)T,⋯,(f^D)T]T。进一步我们定义 y ^ j = ( y ^ j [ − K ] ⋯ y ^ j [ K ] ) T \bm{\hat y_j}=(\hat y_j[-K] \cdots \hat y_j[K])^T y^j=(y^j[−K]⋯y^j[K])T 是 y j y_j yj的前 K : = max d K d K:=\max \limits_{d} K_d K:=dmaxKd 个傅里叶系数的向量形式。为了简化(6)中的正则化形式,令 L L L表示 ω ^ [ k ] \hat \omega[k] ω^[k]中非零系数的数量,因此对所有 ∣ k ∣ > L |k|>L ∣k∣>L,有 ω ^ [ k ] = 0 \hat \omega [k]=0 ω^[k]=0。我们进一步定义 W d W_d Wd为 ( 2 K d + 2 L + 1 ) × ( 2 K d + 1 ) (2K_d+2L+1)\times (2K_d+1) (2Kd+2L+1)×(2Kd+1)的托普利兹矩阵(Toeplitz matrix),其对应着卷积算子 W d f ^ d = v e c ω ^ ∗ f ^ d W_d \bm{\hat f}^d = vec \hat \omega \ast \hat f^d Wdf^d=vecω^∗f^d。最后,记 W W W为块对角矩阵 W = W 1 ⊕ ⋯ ⊕ W D W=W_1\oplus \cdots \oplus W_D W=W1⊕⋯⊕WD。使得 f ∈ V f\in V f∈V且泛函(6)的最小化等价于最小平方问题:

E V ( f ^ ) = ∑ j = 1 m α j ∣ ∣ A j f ^ − y ^ j ∣ ∣ 2 2 + ∣ ∣ W f ^ ∣ ∣ 2 2 ( 7 ) E_V(\bm{\hat f}) = \sum_{j=1}^m \alpha_j ||A_j \bm{\hat f} - \hat y_j||^2_2 + ||W \bm{\hat f}||^2_2 \quad \quad \quad (7) EV(f^)=j=1∑mαj∣∣Ajf^−y^j∣∣22+∣∣Wf^∣∣22(7)

这里,矩阵 A j = [ A j 1 , ⋯ , A j D ] A_j = [A^1_j, \cdots, A_j^D] Aj=[Aj1,⋯,AjD]有 2 K + 1 2K+1 2K+1行,并且每个 2 K d + 1 2K_d+1 2Kd+1列的特征通道 d d d包含一个对角块 A j d A^d_j Ajd,其对角线元素为 { X j d [ k ] b ^ d [ k ] } − K d K d \{X_j^d [k] \hat b_d [k]\}^{K_d}_{-K_d} {Xjd[k]b^d[k]}−KdKd。在(7)中, ∣ ∣ ⋅ ∣ ∣ 2 ||\cdot||_2 ∣∣⋅∣∣2表示在 C M \mathbb{C}^M CM中标准的欧式范数。

为了获得正规方程的简化表达形式,我们定义样本矩阵 A = [ A 1 T , ⋯ , A m T ] A=[A_1^T,\cdots,A_m^T] A=[A1T,⋯,AmT],对角权重矩阵 Γ = α 1 I ⊕ ⋯ ⊕ α m I \Gamma = \alpha_1 I \oplus \cdots \oplus \alpha_m I Γ=α1I⊕⋯⊕αmI和 label 向量 y ^ = [ y ^ 1 T , ⋯ , y ^ m T ] \bm{\hat y} = [\bm{\hat y_1}^T, \cdots,\bm{\hat y_m}^T] y^=[y^1T,⋯,y^mT]。方程(7)的极小值可以通过求解以下正规方程获得:

( A H Γ A + W H W ) f ^ = A H Γ y ^ ( 8 ) (A^H\Gamma A+W^H W)\bm{\hat f} = A^H\Gamma \bm{\hat y}\quad \quad \quad (8) (AHΓA+WHW)f^=AHΓy^(8)

这里, H ^H H表示矩阵的共轭转置。注意 ω \omega ω的非零傅里叶系数 ω ^ [ k ] \hat \omega[k] ω^[k]的数目较小,那么(8)则是一个稀疏线性方程组。在4.2节展示的目标追踪框架里,我们利用了共轭梯度法迭代求解(8)。而对于我们在4.3节展示的特征点追踪方法,为了提高效率,我们用了一个单通道特征图和一个恒定的惩罚函数 ω \omega ω。这使得形成了对角型的方程组,方便直接高效地进行求解。

3.4 Desired Confidence and Interpolation Function

这里,我们描述了期望卷积输出 y j y_j yj和内插函数 b d b_d bd的选择。我们都是通过对定义在实线上的函数进行周期性重复构造 y j y_j yj和 b d b_d bd。通常,一个函数 g g g的周期 T T T循环定义为 g T ( t ) = ∑ − ∞ ∞ g ( t − n T ) g_T(t)=\sum_{-\infin}^{\infin} g(t-nT) gT(t)=∑−∞∞g(t−nT)。在推导得到的傅里叶域公式(6)中,函数 y j y_j yj和 b d b_d bd由它们各自的傅里叶稀疏表示。周期重复 g T g_T gT的傅里叶系数可以由 g ( t ) g(t) g(t)的连续傅里叶变换 g ^ ( ξ ) \hat g(\xi) g^(ξ)表示为 g ^ T [ k ] = 1 T g ^ ( k T ) \hat g_T[k] = \frac{1}{T} \hat g(\frac{k}{T}) g^T[k]=T1g^(Tk)。我们利用这个性质计算 y j y_j yj和 b d b_d bd的傅里叶系数。

为了构造期望的卷积输出 y j y_j yj,我们让 u j ∈ [ 0 , T ) u_j\in [0,T) uj∈[0,T)表示目标或者特征点的估计位置。我们定义 y j y_j yj为以 u j u_j uj为中心的高斯函数 e x p ( − ( t − u j ) 2 2 σ 2 ) exp(-\frac{(t-u_j)^2}{2\sigma^2}) exp(−2σ2(t−uj)2)的周期重复。以下表达式将给出其傅里叶系数:

y ^ j [ k ] = 2 π σ 2 T e x p ( − 2 σ 2 ( π k T ) 2 − i 2 π T u j k ) . \hat y_j[k] = \frac{\sqrt{2\pi \sigma^2}}{T} exp(-2\sigma^2 (\frac{\pi k}{T})^2 - i \frac{2\pi}{T}u_j k). y^j[k]=T2πσ2exp(−2σ2(Tπk)2−iT2πujk).

变量 σ 2 \sigma^2 σ2设置为一个较小的数,以获得一个尖锐的峰值。进一步,这保证了空间混淆可以被忽略。在我们的工作中,函数 b d b_d bd的构造是基于三次条样核(cubic spline kernel) b ( t ) b(t) b(t)。内插函数 b d b_d bd被设置成核 b ( N d T ( t − T 2 N d ) ) b(\frac{N_d}{T}(t-\frac{T}{2N_d})) b(TNd(t−2NdT))经缩放和平移后的周期性重复,以保持特征金字塔的空间排列。然后, b d b_d bd的傅里叶系数由 b ^ d [ k ] = 1 N d e x p ( − i π N d k ) b ^ ( k N d ) \hat b_d[k] = \frac{1}{N_d} exp(-i \frac{\pi}{N_d}k)\hat b (\frac{k}{N_d}) b^d[k]=Nd1exp(−iNdπk)b^(Ndk)得到。

3.5 Generalization to Higher Dimension

前面提出的方程可以推广到任意维度,对于我们的跟踪应用,主要考虑二维的情况,但是更高维的可以进行类似处理。对于图像我们使用含两个变量的平方可积的周期函数 g ( t 1 , t 2 ) g(t_1,t_2) g(t1,t2)形成空间 L 2 ( T 1 , T 2 ) L^2(T_1,T_2) L2(T1,T2)。而复数指数由 e k 1 , k 2 ( t 1 , t 2 ) = e i 2 π T 1 k 1 t 1 e i 2 π T 2 k 2 t 2 e_{k_1,k_2}(t_1,t_2) = e^{i\frac{2\pi}{T_1}k_1 t_1} e^{i\frac{2\pi}{T_2}k_2 t_2} ek1,k2(t1,t2)=eiT12πk1t1eiT22πk2t2 给出。对于期望卷积输出 y j y_j yj,我们采用二维高斯函数。此外,插值函数是以可分离的形式获得的 cubic spline kernel 的组合,比如 b ( t 1 , t 2 ) = b ( t 1 ) b ( t 2 ) b(t_1,t_2) = b(t_1)b(t_2) b(t1,t2)=b(t1)b(t2)。3.3节的推导也适用于更高维度的情况。

4. Tracking Frameworks

我们将连续学习公式应用于两个问题:视觉目标跟踪和特征点跟踪。我们首先提出了基于最大化连续置信度函数的定位过程。这是目标和特征点追踪的通用框架。

4.1 Localization step

目的是利用学习得到的滤波器 f f f定位跟踪的目标或者特征点。这首先要通过从一张图片中的感兴趣区域提取一个特征图 x ∈ χ x\in \chi x∈χ。然后,利用(5) 计算置信度函数 s = S f { x } s=S_f\{x\} s=Sf{x}的傅里叶系数。我们利用一个两步法来获取区间 t ∈ [ 0 , T ) t\in [0,T) t∈[0,T)上 s ( t ) s(t) s(t)的最大得分。为了得到一个粗略的初始估计,我们首先执行一个网格搜索,并在离散点 s ( T n 2 K + 1 ) s(\frac{T_n}{2K+1}) s(2K+1Tn),当 n = 0 , ⋯ , 2 K n=0,\cdots,2K n=0,⋯,2K时对得分函数进行评估。它被有效地实现为非零傅里叶系数 s ^ [ k ] , k = − K , ⋯ , K \hat s[k], k=-K,\cdots,K s^[k],k=−K,⋯,K的逆 DFT 的缩放。在网格搜索中获得的最大值将作为傅里叶级数展开 s ( t ) = ∑ − K K s ^ [ k ] e k ( t ) s(t)=\sum_{-K}^K \hat s[k]e_k(t) s(t)=∑−KKs^[k]ek(t)的迭代优化的初始值。为此,我们使用标准的牛顿法。梯度和 Hessian 通过 s ( t ) s(t) s(t)的分析差分来计算。

4.2 Object Tracking Framework

我们提出基于3.2节介绍的连续学习公式的目标跟踪框架。我们采用从预先训练的深度网络中提取的多分辨率特征图 x j x_j xj。类似于 DCF 追踪器,我们在每个帧中提取单个训练样本 x j x_j xj。从以目标位置为中心的图像区域提取样本,并将区域大小设为目标区域的 5 2 5^2 52倍。其相应的权重设置为 α j = α j − 1 1 − λ \alpha_j = \frac{\alpha_{j-1}}{1-\lambda} αj=1−λαj−1,使用学习率为 λ = 0.0075 \lambda = 0.0075 λ=0.0075。然后使权重归一化,即 ∑ j α j = 1 \sum_j \alpha_j = 1 ∑jαj=1。我们通过更换最小权重的样本来存储最多 m = 400 m=400 m=400个样本。惩罚函数的傅里叶系数 ω ^ \hat \omega ω^ 如 “Learning spatially regularized correlation filters for visual tracking” 论文中的描述进行计算。为了检测目标,我们采用一个多尺度的搜索策略,即5个尺度和相对比例因子 1.02。提取的置信度使用最大网格搜索之后,进行5次牛顿迭代,如4.1节描述的。

我们的连续卷积滤波器 f f f的训练是通过迭代求解正规方程(8)来完成的。由于计算高效性,我们使用了共轭梯度法(CG)。我们的数值优化线性正比于 O ( D ) \mathbb{O}(D) O(D),因此特别适用于高维度的深度特征。在第一帧中,我们使用100次迭代找到滤波器系数 f ^ \hat f f^的初始估计。随后,通过当前滤波器初始化CG,每帧5次迭代就够了。

4.3 Feature Point Tracking Framework

这里,我们描述基于我们的学习方法的特征点跟踪。为了计算效率,我们假设一个通道的特征图 ( D = 1 ) (D=1) (D=1),比如,一个灰度图,以及一个恒定的惩罚函数 ω ( t ) = β \omega(t) = \beta ω(t)=β。在这些假设下,正规方程(8)下形成了一个对角线方程组。滤波器的系数可以直接得到:

f ^ [ k ] = ∑ j = 1 M α j X j [ k ] b ^ [ k ] ‾ y ^ j [ k ] ∑ j = 1 M α j ∣ X j [ k ] b ^ [ k ] ∣ 2 + β 2 , k = − K , ⋯ , K . \hat f[k] = \frac{\sum_{j=1}^M \alpha_j \overline {X_j [k] \hat b [k]} \hat y_j [k]}{\sum_{j=1}^M \alpha_j |X_j [k] \hat b [k]|^2 + \beta^2}, k=-K, \cdots, K. f^[k]=∑j=1Mαj∣Xj[k]b^[k]∣2+β2∑j=1MαjXj[k]b^[k]y^j[k],k=−K,⋯,K.

在这里,为了清楚起见,我们已经放弃了特征维度索引。在这种情况下(单特征通道和恒定惩罚函数),训练方程(10)就类似于原始的MOSSE滤波器。然而,和原始的MOSSE相比,我们的连续方程有几个特点。首先,我们的公式采用由 b ^ \hat b b^给出的隐式插值模型。其次,每个样本用连续域置信度 y j y_j yj标记,使得 sub-pixel 信息能够被包含在学习中。第三,我们的卷积算子输出连续的置信度函数,允许对特征点进行精确定位。在我们的实验中,我们展示了连续公式的优势,而这些对准确的特征点跟踪至关重要。