行人检测论文笔记汇总(含代码地址)

论文标题:Bi-box Regression for Pedestrian Detection and Occlusion Estimation

论文下载地址:

http://openaccess.thecvf.com/content_ECCV_2018/papers/CHUNLUAN_ZHOU_Bi-box_Regression_for_ECCV_2018_paper.pdf

代码下载地址: https://github.com/rainofmine/Bi-box_Regression

论文简介:与通用目标检测相比,遮挡情况在行人检测中更为普遍,为此也是行人检测领域最广为关注的问题之一,对于遮挡情况下的行人检测,主要有两种思路:一是对目标候选框分成不同part逐一处理、区别对待再加以特征融合;二是从loss的角度使得目标候选框对相互遮挡的情况更具判别性,目前主流的行人检测算法大多基于两阶段的检测器框架,本文也不例外,但另辟蹊径,通过让网络同时输出目标候选框的可见部分,指导网络在学习的过程中对遮挡情况下的行人目标更具有判别力,实验表明该思路对严重遮挡情况下的行人检测十分有效。

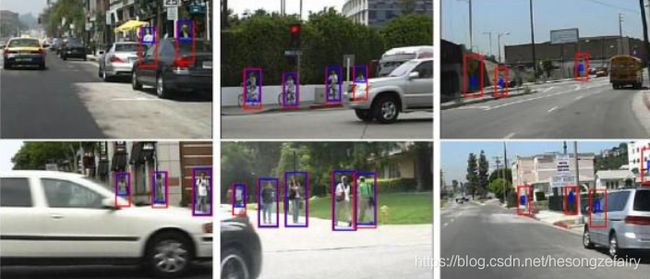

论文贡献:本文方法遵循Fast R-CNN检测框架。为了处理遮挡问题,本文提出利用一个网络同时进行行人检测和遮挡估计,具体而言就是让网络并行两个分支,分别输出两个bounding box,一个是完整的行人框,另一个时行人的可见部分。如下图所示,前者为红色框后者为蓝色框,对于没有行人目标的候选框而言,则可见部分分支的输出要尽量逼近候选框的中心。整个方法基于Fast R-CNN检测框架,首先产生目标候选框,将图像和目标候选框输入卷积神经网络,然后通过RoI pooling提取每个目标候选框的特征,对这些特征进行分类和回归,分别得到两个box。

本文的贡献包括三个方面:(1)提出了一种bi-box regression方法,通过学习由两个分支组成的深层CNN(一个用于全身估计,另一个用于可见部分)来实现行人检测和遮挡的同时估计。(2)提出了一种训练策略,以改善两个分支之间的互补性,以便可以融合其输出以提高行人检测性能;(3)预测行人框的可见部分是可行的,并可以带来整体行人检测的性能提升;训练时,结合遮挡程度来定义高质量的正样本,可以为训练带来帮助,不失为一种非常经济有效的提升性能的trick。

论文指标: 本文方法在Caltech、CityPerson数据集上使用False Positive Per Image(FPPI)作为评估指标,Reasonable、Partial、Heavy Occlusion状态下FPPI指标分别是最好的7.4%、13.3%、44.4%,在CityPerson数据集上的Reasonable、Heavy、All状态下FPPI指标分别是的11.24%、44.15%,43.41%

论文标题:High-level Semantic Feature Detection: A New Perspective for Pedestrian Detection

论文下载地址:https://arxiv.org/abs/1904.02948

代码下载地址: https://github.com/liuwei16/CSP

https://github.com/lw396285v/CSP-pedestrian-detection-in-pytorch

论文简介:目标检测通常需要传统的滑动窗口分类器或现代深度学习方法中基于锚框的预测。但是,这些方法中的任何一种都需要在boxes中进行繁琐的配置。在本文中,作者提供了一个新的视角,即将检测对象作为高级语义特征检测任务来激发。像边缘,拐角,斑点和其他特征检测器一样,建议的检测器在整个图像上扫描特征点,因此自然适合进行卷积。但是,与这些传统的低级功能不同,建议的检测器需要更高级别的抽象,也就是说,作者正在寻找存在对象的中心点,并且现代深度模型已经能够实现这种高级语义抽象。此外,像斑点检测一样,作者还可以预测中心点的尺度,这也是一个简单的卷积。因此,在本文中,通过卷积将行人和面部检测简化为直接的中心和规模预测任务。这样,所提出的方法享box-free设置。尽管结构简单,但它在包括行人检测和人脸检测在内的几个具有挑战性的基准上都具有竞争优势。此外,执行了跨数据集评估,证明了所提出方法的出色泛化能力。

论文贡献:本文提出了一个新的解决行人检测的视角,将目标检测理解为高级语言特征检测任务,像边缘,拐角,斑点和其他特征检测器一样,建议的检测器在整个图像上扫描特征点,因此自然适合进行卷积。但是,与这些传统的低级特征检测器不同,建议的检测器用于更高级别的抽象,也就是说,正在寻找存在对象的中心点。此外,类似于斑点检测,还预测了中心点的尺度。然而,考虑到它的强大功能,但是不像传统的斑点检测那样处理图像金字塔来确定比例,而是通过在全卷积网络(FCN)上进行一次直接卷积来预测对象比例。结果,行人和面部检测通过卷积被简单地表述为简单的中心和比例预测任务。所提出的方法的总体流程,表示为基于中心和规模预测(CSP)的检测器。这项工作的主要贡献如下:(1)展示了一种新的可能性,即行人和人脸检测可以通过卷积简化为直接的中心和尺度预测任务,从而绕开了基于锚框的探测器的局限性,并且 摆脱了基于最近的关键点配对的检测器的复杂后处理。 (2)拟议的CSP检测器在两个具有挑战性的行人检测基准(CityPersons [55]和Caltech [8])上达到了最新的最新性能,并且在最受欢迎的人脸检测基准之一上也达到了竞争性能。(3)进行跨数据集评估时,建议的CSP检测器具有良好的泛化能力

论文指标:作者在行人数据集Caltech, Cityperson数据集上做了实验,使用False Positive Per Image(FPPI)作为评估指标。CSP方法在Caltech数据集上的Reasonable、All、Heavy Occlusion状态下FPPI指标分别是最好的3.8%、54.4%、36.5%,在CityPerson数据集上的Reasonable、Heavy Occlusion状态下FPPI指标分别是的11.1%、49.3%,

论文标题:Scale Match for Tiny Person Detection

论文下载地址:https://arxiv.org/abs/1912.10664

代码下载地址: https://github.com/ucas-vg/TinyBenchmark

论文简介:论文提出了一个新的benchmark, TinyPerson, 其中包含了很多小的人体目标,另外,作者通过实验发现,在检测任务中,pre-training和detector训练数据之间的mismatch会导致检测器性能下降,因此提出了一种Scale Match手段来align两部分的数据集以提升检测器性能。

论文贡献:为了检测微小的人,作者提出了一种简单而有效的方法,称为“规模匹配”。本文方法的直觉是对齐用于预训练的数据集的对象比例和用于检测器训练的对象比例。规模匹配的本质是它可以更好地研究和利用微小规模的信息,并使卷积神经网络(CNN)对于微小对象表示更为复杂。本文工作的主要贡献包括:1.在海上快速救援的背景下,作者引入了TinyPerson,并对野外微小物体检测提出了巨大挑战。据所知,这是具有远距离背景的远距离人检测的第一个基准。Train/val注释将公开发布,并将建立在线基准以进行算法评估。 2.作者全面分析了有关小人物的挑战,并提出了尺度匹配方法,目的是使网络预训练数据集和检测器学习数据集之间的特征分布保持一致。 3.提出的比例匹配方法提升了最先进的检测器(FPN)5%的性能。

论文指标:本文提出的方法在MSCOCO上相比其他方法取得了最好的表现AP50为29.21