伪分布式Hadoop

关于Hadoop基础环境的搭建,在虚拟机中如何安装JDK和Hadoop呢?如何把jdk文件上传到虚拟机中呢?话不多说,先奉上我们要安装的JDK和Hadoop以及WINSCP传输软件

提取码:jlto

一:安装JDK

1、安装WINSCP

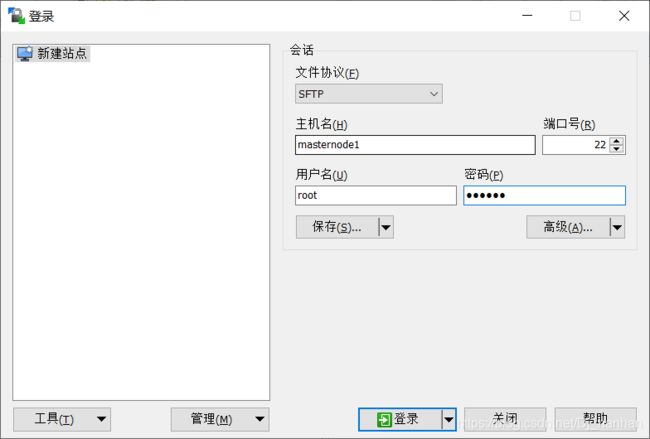

如果用VM自带的tool工具有可能会引发诸多问题,所以我推荐使用winscp,较为方便快捷。首先安装好winscp,保持虚拟机在开机状态,网络无异常,可以用ping www.baidu.com测试是否有网络。打开winscp,主机名填写虚拟机主机名或ip地址;masternode1是我虚拟机的主机名,可以用[hostname]查看自己虚拟机的主机名,默认端口号为22,不用修改;用root用户登录即可。

===如果使用winscp发现连不上虚拟机,请检查网络设置,尝试修改虚拟机ip地址,关闭防火墙,启动ssh。

vim /etc/sysconfig/network-scripts/ifcfg-ens33#修改ip地址文件

systemctl stop firewalld.service#关闭防火墙

/usr/sbin/sshd#启动ssh

2、安装JDK

先在虚拟机中创建目录文件夹用于存放JDK

mkdir /usr/java在winscp右边虚拟机目录中查找到该路径,然后把jdk文件拖动过来即可。传输完成后,可以使用命令查看是否成功传输

ll /usr/java进入当前目录,并执行解压命令

cd /usr/java#进入目录

tar -zxvf jdk-8u162-linux-x64.tar.gz#解压文件解压完成后,修改profile文件

vim /etc/profile配置环境变量,在文件末尾添加以下内容:

#set java enviroment

export JAVA_HOME=/usr/java/jdk1.8.0_162

export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH编译配置文件

source /etc/profile查看是否安装成功

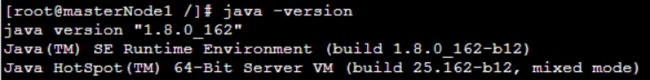

java -version出现以下内容则安装成功:

二、安装Hadoop

二、安装Hadoop

1、同理,将hadoop压缩包上传到虚拟机中,首先需要在虚拟机中创建目录

mkdir /usr/hadoop#创建文件夹进入当前目录,执行解压命令

cd /usr/hadoop

tar -zxvf hadoop-2.7.1.tar.gz -C/usr #解压命令创建数据目录:

mkdir /home/hadoopdir创建临时文件目录:

mkdir /home/hadoopdir/temp创建NameNode目录:

mkdir /home/hadoopdir/dfs #创建临时文件目录

mkdir /home/hadoopdir/dfs/name #创建元数据目录创建DataNode目录:

mkdir /home/hadoopdir/dfs/data #创建磁盘1

mkdir /home/hadoopdir/dfs/data1 #创建磁盘2

mkdir /home/hadoopdir/dfs/data2 #创建磁盘3,使用路径模拟磁盘如果需要使用磁盘,将磁盘挂载到这个路径即可使用。2、配置hadoop环境变量

vim /usr/hadoop-2.7.1/etc/hadoop/hadoop-env.sh

在hadoop-env.sh文件中增加一段自己的java环境变量和${JAVA_HOME}一致:

export JAVA_HOME=/usr/java/jdk1.8.0_162修改profile文件

vim /etc/profile在末尾加入hadoop的环境变量:

export HADOOP_HOME=/usr/hadoop-2.7.1

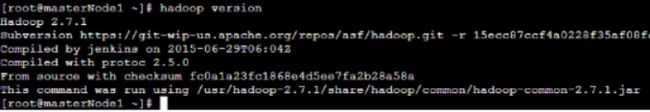

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:${PATH}执行source /etc/profile保存并退出 成功后执行 hadoop version 得到以下界面后,是为配置成功:

3、修改配置文件

(1)core-site.xml(默认这个文件为空)

vim /usr/hadoop-2.7.1/etc/hadoop/core-site.xml增加以下内容

fs.defaultFS</name>hdfs://masterNode1:9000</value>

指定namenode的hdfs协议的文件系统通信地址,,masterNode1为主机名</description>

</property>

</configuration> (2)修改hdfs-site.xml

vim /usr/hadoop-2.7.1/etc/hadoop/hdfs-site.xml

dfs.namenode.name.dir</name>file:///home/hadoopdir/dfs/name</value> hdfs元数据存存储目录</description>

</property>

dfs.datanode.data.dir</name> /home/hadoopdir/dfs/data,/home/hadoopdir/dfs/data1,/home/hadoopdir/dfs/data2</value> DataNode在本地文件系统中存放块的路径,如果是多个路径,请用逗号隔开,会自动选用多个目录进行数据存储</description>

</property>

dfs.replication</name>1</value>

备份数量,伪分布式则将其配置成1</description>

</property>

</configuration> (3)修改mapred-site.xml

vim /usr/hadoop-2.7.1/etc/hadoop/mapred-site.xml

mapreduce.framework.name</name>yarn</value>执行框架设置为Hadoop的YARN</description>

</property>

</configuration> (4)修改yarn-site.xml

vim /usr/hadoop-2.7.1/etc/hadoop/yarn-site.xml

yarn.nodemanager.aux-services</name>mapreduce_shuffle</value> NodeManager上运行的附属服务。需配置成mapreduce_shuffle才可运行MapReduce程序</description>

</property>

</configuration> 三、启动最小Hadoop伪分布式模式

1、格式化文件系统(第一次运行)

/usr/hadoop-2.7.1/bin/hdfs namenode -format2、启动NameNode守护进程和DataNode守护进程

/usr/hadoop-2.7.1/sbin/start-dfs.sh3、启动resourcemanager和nodemanager

/usr/hadoop-2.7.1/sbin/start-yarn.sh可以通过jps查看已经启动的进程

OK~今天的学习到此结束