论文笔记:Deep Residual Learning for Image Recognition

----生僻名词:

CVPR:

CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议。

normalized initialization, 规范初始化

intermediate normalization layers,中值规范化层

vanishing/exploding gradients 梯度爆炸、消失??

counterpart 相关联部分

identity mapping**恒等映射

shallower counterpart 较浅的

vetor quantization

residual solution

VGG网络

hierarchical basis preconditioning:级联基预处理??

multi-layer perceptrons:多层感知网络??

linear layer:线性层??

centering layer responses:层相应置中??

propagated errors:传播误差

“inception”layer:“开端”层??

恒等映射:identity mapping无参数,不会增大训练误差

零值映射:

reLU:

二阶非线性:

element-wise addition

FC:Fully conneted 普通的全连接网络

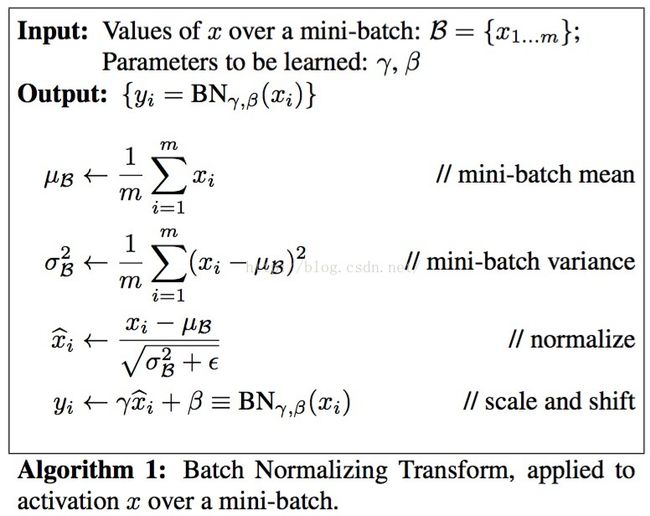

batch normalizetion(BN):批量规范化

dropout:

top-1 err. 和top-5 err.:

一般通过机器学习进行图像识别的时候可以让算法猜多次,top1 error指的是只猜1次的错误率。而top 5则指的是猜5次,只要有一次对就算对。 top5 error就是指此时的错误率。----kaiming he的个人主页,准备ppt用:http://www.kaiminghe.com/

----ILSVRC 2015:IMAGENET Large Scale Visual Recognition Challenge 2015

----the notorious problem of vanishing /exploding gradients has been largely addressed bynormalized initialization and intermediate normalization layers.

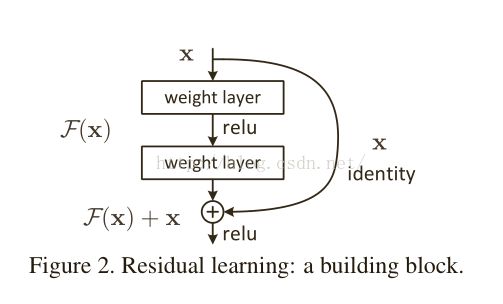

----Rsidual learning :

----vanising/exploding gradients:

要计算前面网络的梯度,必须是后面的网络连乘梯度,如果连乘梯度中的几个梯度很小,那就出现了梯度消失现象,反之出现梯度爆炸现象。网络深度越深越容易出现。

----batch normalization(BN):https://www.zhihu.com/question/38102762

机理:批量范化,在该结构中处在卷积之后,activetion之前。使得输出信号的各个维度的均值为0,方差为1。而最后的“scale and shift”操作则是为了因训练所需而刻意加入的BN能够有可能还原最初的输入,从而保证整个网络的容纳能力(capasity:可以还原输入又可以改变)。

注释:在每个mini-batch中计算得到mini-batch mean和variance来替代整体训练集的mean和variance. 这便是Algorithm 1.

原理:说到底还是为了防止“梯度弥散”。关于梯度弥散,大家都知道一个简单的栗子:。在BN中,是通过将activation规范为均值和方差一致的手段使得原本会减小的activation的scale变大

----Activation functions:

---SVG:stochastic gradient descent(随机梯度下降)???

---ImageNet:

---VLAD: vector of lacally aggregated descriptors

-----重网格方法(Multigridmethod):

多重网格方法是解微分方程的方法。这个方法的好处是在利用迭代法收敛结果的时候速度特别快。并且,不管是否对称,是否线性都无所谓。它的值要思想是在粗糙结果和精细结果之间插值。

http://blog.csdn.net/wangxiaojun911/article/details/7067553

-----构成更深的网络模型的方法之一:

在所增加的层次上均采用恒等映射(identity Mapping),其他层次直接用已经学习好的浅层网络。其作用是为了加深后的模型产生的训练误差不高于它所基于的浅层模型。

------超深度残差网络的特点:

1)更便于优化,但它所对应的简单通过层次堆叠而成的网络的训练误差会随着网络层 次的加深而增大。

2)更容易增加深度的同时获得精度的提高,明显优于之前网络结构的结果。

-----一个好的模型重构或预处理将有利于模型的优化。

----相对“高速公路网络”展示的门函数的捷径链接是数据相关并且需要进行参数调整,它的恒等捷径无需调参数。

----“高速公路网络”Highway Networks:

当门捷径关闭的时候(趋近于0),该网络中的层表示为非残差函数,而对残差函数的学习贯穿始终的残差网的恒等捷径不需要关闭。

----退化问题(degradation problem):随着网络深度的增加,训练误差增大。

----残差学习的方法重构可以让恒等映射的求解变得简单。

-----残差函数:F(x)=H(x)-x

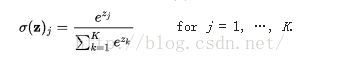

----softmax函数:

如果某一个zj大过其他z,那这个映射的分量就逼近于1,其他就逼近于0,主要应用就是多分类,sigmoid函数只能分两类,而softmax能分多类,softmax是sigmoid的扩展。

----通过步长为2进行下采样

-----y=F(x, {Wi })+Ws x Ws将仅仅被用来解决维数匹配的问题(当F和x的维度不一致的时候)

-------批量梯度下降(Batch gradient)和随机梯度下降(Stochastic)

-----该论文网络结构:

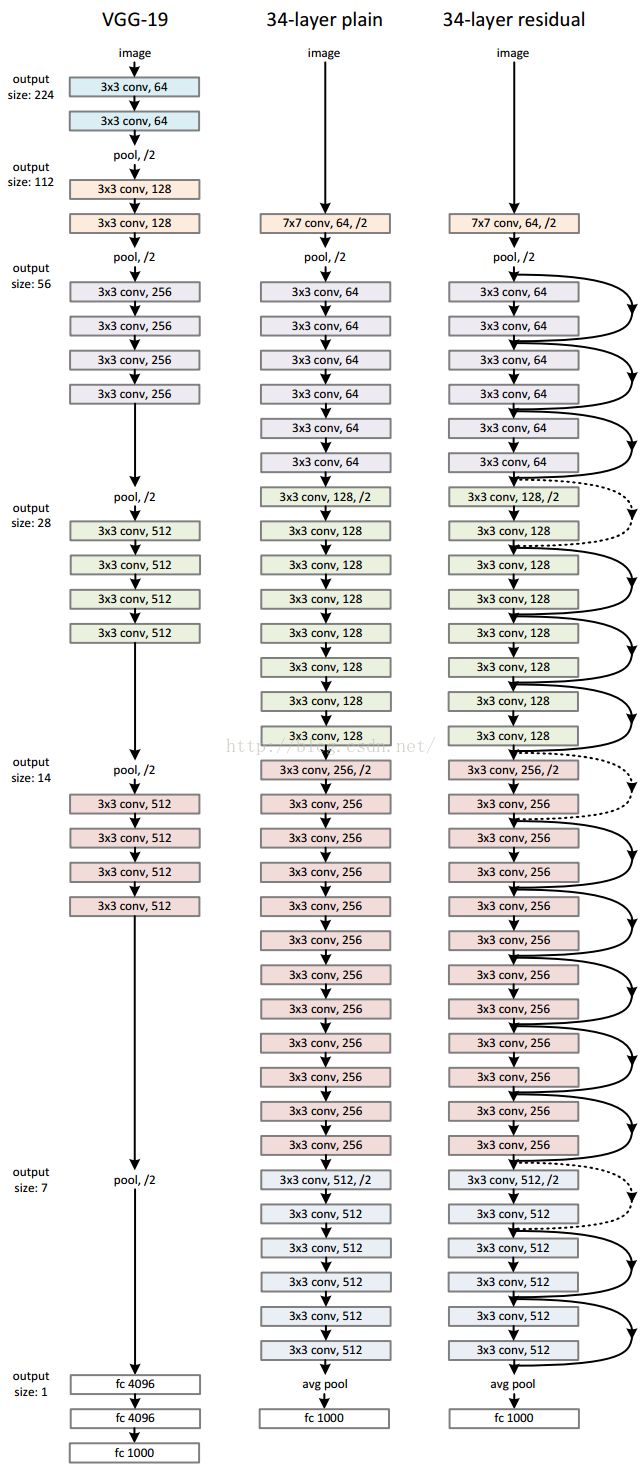

平凡网络我们的普通基准网络(图3-中图)主要是受VGG网络理论的启发[41] (图3-左图)。多数的卷积层的过滤器尺寸为3×3并且在设计时遵从下列两条简单的规则:(i)对于相应大小的输出特征图尺寸,层中必须含有相同数量的过滤器;(ii)若特征图尺寸减半时,则需要倍增过滤器数量来保持各层的时间复杂度。我们通过步长为2的卷积层直接进行降采样。最终的网络包括了一个全局的均值池化层和1000路装备了softmax激活函数的全连接层。含有权重的网络层总计有34层(图3-中图)。

残差网络 基于上述的平凡网络,我们增加了一些捷径连接(见图3,右图)后,则将网络转化为与之对应的残差版网络。当网络的输入维度和输出维度相等时可以直接应用公式(1)所示的恒等捷径(图3中的实线捷径)。当维数增加时(图3中的点画线捷径),我们考虑了两种策略:(A)捷径依然采用恒等映射,对于维数增加带来的空缺元素补零,这种策略将引入新的参数;(B)利用公式(2)所示的投影捷径来匹配维数(通过1×1的卷积层实现)。对于这两种策略,当捷径连接了两个尺寸的特征图时,它们将依步长2进行排布。

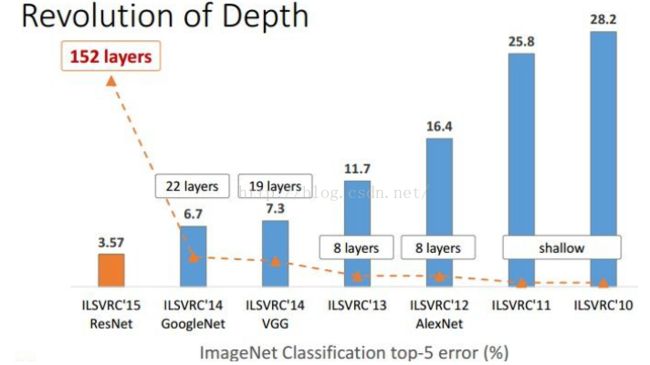

----ImageNet Classification top-5 error:

----ResNet的实现:

前期图像处理:图片按短边作等比缩放---->按照随机选取以[256,480]区间为采样尺寸进行尺度增强---->随机的从图像或其水平镜像(左右对调)采样大小为224*224的剪裁图像---->将剪裁结果减去像素平均值---->标准色彩增强(亮度、色调、饱和度,如:直方图均衡的增强图像)---->在卷积之后activation之前,批量正规化(Batch Normalization,BN)

训练过程:初始化权重---->分别从零开始训练平凡网络和残差网络(采用的SGD的最小批量大小为256):学习速率被初始化为0.1,并且在每次遇到错误率平台区时除以10,对各模型(指的是三个模型)都迭代60万次进行训练。使用权值衰减惩罚技术,其速率参数设为0.0001,冲量参数设为0.9。

( 注解:1、“momentum是冲量单元,也就是下式中的m,作用是有助于训练过程中逃离局部最小值,使网络能够更快速地收敛,也是需要经过反复地trial and error获得的经验值。”

2、神经网络的训练过程(也就是梯度下降法)是在高维曲面上寻找全局最优解的过程(也就是寻找波谷),每经过一次训练epoch,搜寻点应该更加靠近最优点所在的区域范围,这时进行权重衰减便有利于将搜寻范围限制在该范围内,而不至于跳出这个搜索圈,反复进行权重衰减便逐渐缩小搜索范围,最终找到全局最优解对应的点,网络收敛。

2、神经网络的训练过程(也就是梯度下降法)是在高维曲面上寻找全局最优解的过程(也就是寻找波谷),每经过一次训练epoch,搜寻点应该更加靠近最优点所在的区域范围,这时进行权重衰减便有利于将搜寻范围限制在该范围内,而不至于跳出这个搜索圈,反复进行权重衰减便逐渐缩小搜索范围,最终找到全局最优解对应的点,网络收敛。

)

测试: 为了对结果作对比,采用了标准的10折测试[21]。为了获得最佳的结果,采用了全连接卷积形式的网络,最终结果为对多个尺寸图像(图像分别等比缩放为短边长度{224,256,384,480,640})的实验结果得分取平均值。

----ResNet网络的结构细节:

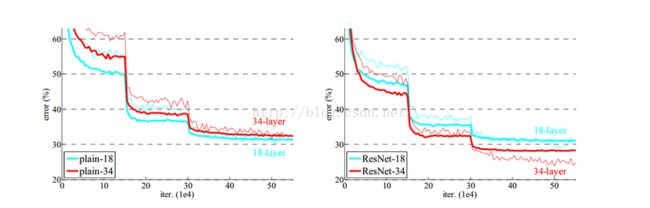

和平凡网络比较得出,深度残差网络能够改善退化问题。

错误率比较:

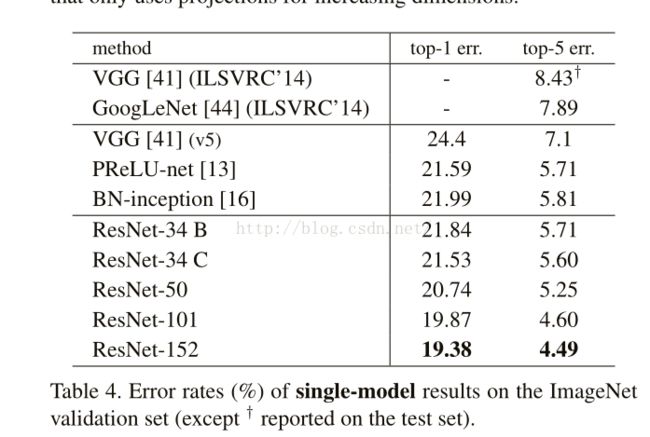

单模型错误率:

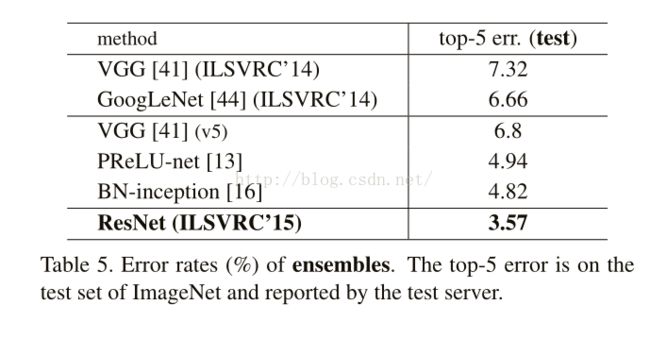

组合模型错误率(由测试服务器汇报):

CIFAR-10上的测试: