问题说明

spark中运行项目有两种方式

-

在spark-shell中导入依赖,编写代码,执行

-

和在idea中写好应用,使用spark-submit方式提交到spark运行

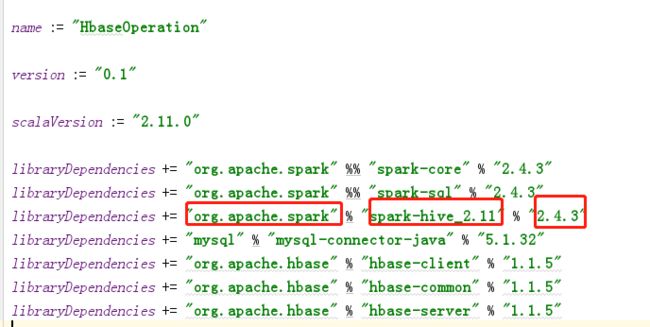

在使用idea开发spark应用时,引入依赖总是失败,原因是不知道依赖的信息和对应scala版本的关系,所有需要知道仓库资源的信息

sbt插件默认仓库地址

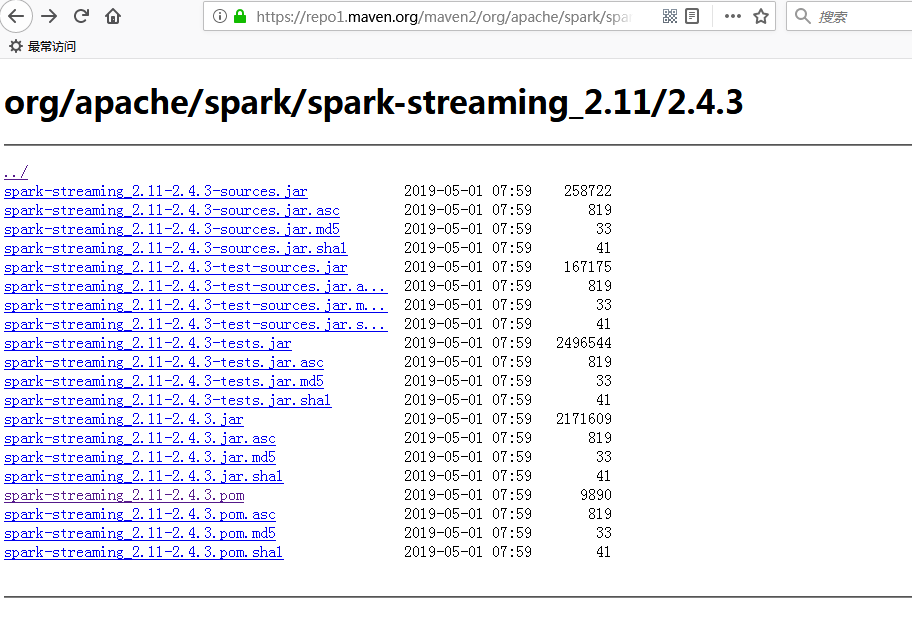

https://repo1.maven.org/maven2

打开以上仓库地址,查找依赖

比如spark-streaming,在org/apache/spark目录下

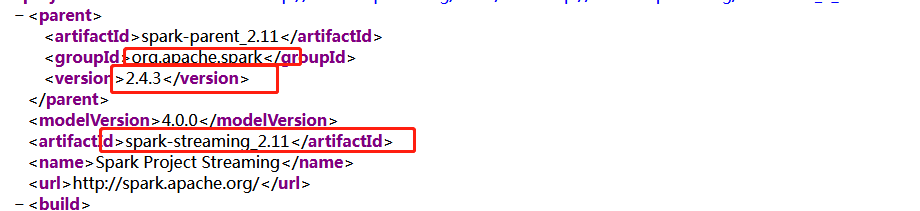

打开spark-streaming_2.11-2.4.3.pom

其中,groupId,artifactId,version分别对应sbt依赖的groupId,artifactId,version

注意:spark-streaming_2.11后缀2.11表示scala的版本信息,必须选择与当前scala版本一致的依赖引入,最后的2.4.3表示spark-core的版本

下载速度优化

如果是在idea安装sbt插件方式,默认的sbt下载位置在C:\Users\Administrator\.IdeaIC2018.1\config\plugins\Scala\launcher

用ZIP压缩方式打开sbt-launch.jar,把此文件拷贝出来,修改sbt目录下的sbt.boot.properties文件,在local下加入阿里云仓库地址

local

alirepo1:https://maven.aliyun.com/repository/central

alirepo2:https://maven.aliyun.com/repository/jcenter

alirepo3:https://maven.aliyun.com/repository/public

修改完之后 替换掉原来的sbt-launch.jar的sbt目录下的sbt.boot.properties文件 如果提示正在使用 需要关掉idea并杀掉所有javaw.exe进程