- Unet 改进:在encoder和decoder间加入TransformerBlock

听风吹等浪起

AI改进系列transformer图像分割Unet

目录1.TransformerBlock2.Unet改进3.完整代码Tips:融入模块后的网络经过测试,可以直接使用,设置好输入和输出的图片维度即可1.TransformerBlockTransformerBlock是Transformer模型架构的基本组件,广泛应用于机器翻译、文本摘要和情感分析等自然语言处理任务。TransformerBlock是一个由两个子组件组成的构建块:多头注意力机制和前

- 【AI知识点】三种不同架构的大语言模型(LLMs)的区别

AI完全体

AI知识点人工智能语言模型自然语言处理机器学习深度学习注意力机制自注意力机制

【AI论文解读】【AI知识点】【AI小项目】【AI战略思考】在自然语言处理(NLP)中,预训练语言模型(LLMs,LargeLanguageModels)通常基于不同的架构,如仅编码器的模型(Encoder-only)、编码器-解码器的模型(Encoder-Decoder),以及仅解码器的模型(Decoder-only)。这三种架构有着显著的区别,主要体现在功能、适用任务和性能上。下面从架构、功能

- 自然语言处理基础知识入门(四) Transformer模型整体最详解(self- attention机制,mask机制)

这个男人是小帅

NLP自然语言知识梳理入门自然语言处理transformer人工智能nlp语言模型机器翻译深度学习

文章目录前言一、Seq2Seq1.1Seq2Seq的基本架构1.2Seq2Seq的框架实例二、Transformer2.1Transformer的整体架构2.2Transformer的输入2.2.1InputEmbeding2.2.2PositionalEncoder2.2.3Transformer的输入2.3Transformer的自注意力机制2.3.1注意力机制2.3.2权重矩阵WWW2.3.

- (25-4-01)基于本地知识库的自动问答系统(LangChain+ChatGLM+ModelScope/Huggingface部署): 构建和部署对话系统(1)

码农三叔

《NLP算法实战》训练RAG多模态)langchainpython自然语言处理语言模型bert文心一言Huggingface

13.3.4构建和部署对话系统文件jina_serving.py定义了一个名为KnowledgeBasedChatLLM的类,用于初始化模型配置、加载文件、检索问题答案等操作。其中,LangChain是文件jina_serving.py中的一个重要组件,它通过将自然语言处理技术与信息检索技术相结合,实现了以下功能:模型管理与加载:通过init_model和reinit_model函数,实现了模型的

- 智能化Kubernetes管理:AI与ChatGPT提升运维效率的创新实践

大大宝的博客

k8skubernetes人工智能chatgpt

摘要随着云计算技术的飞速发展,Kubernetes(K8s)已成为企业进行容器化应用管理的标准平台。然而,Kubernetes集群的管理在复杂度、规模和资源优化等方面仍然面临巨大挑战。传统的Kubernetes运维方式往往依赖手动操作,导致效率低下,且容易产生人为错误。随着人工智能(AI)技术的成熟,特别是基于自然语言处理(NLP)的智能体如ChatGPT的出现,AI智能体能够在Kubernete

- 【大模型应用开发 动手做AI Agent】Plan and Solve策略的提出

杭州大厂Java程序媛

计算机软件编程原理与应用实践javapythonjavascriptkotlingolang架构人工智能

【大模型应用开发动手做AIAgent】Plan-and-Solve策略的提出关键词:大模型,AIAgent,Plan-and-Solve,智能体,策略学习,强化学习,自然语言处理1.背景介绍随着人工智能技术的飞速发展,大模型(LargeLanguageModel,LLM)在自然语言处理(NaturalLanguageProcessing,NLP)领域取得了显著的突破。大模型能够理解和生成自然语言,

- 深度学习-笔记1

深度学习神经网络

刚开始接触深度学习相关内容,在这儿做一个笔记:网址:https://gitee.com/paddlepaddle/PaddleNLPpaddle-nlp是一个自然语言处理NLP方面的工具包(代码库)ERNIEERNIE是百度基于BERT改进的预训练大模型,结合了Transformer架构和知识增强机制。整体上可以分为预训练模型层和任务适配层,预训练模型层负责学习通用的语言知识和语义表示,任务适配层

- 自然语言处理-词嵌入 (Word Embeddings)

纠结哥_Shrek

自然语言处理人工智能

词嵌入(WordEmbedding)是一种将单词或短语映射到高维向量空间的技术,使其能够以数学方式表示单词之间的关系。词嵌入能够捕捉语义信息,使得相似的词在向量空间中具有相近的表示。常见词嵌入方法基于矩阵分解的方法LatentSemanticAnalysis(LSA)LatentDirichletAllocation(LDA)非负矩阵分解(NMF)基于神经网络的方法Word2Vec(Google提

- AIGC时代的Vue或React前端开发

GISer_Jinger

JavascriptReactVueAIGCvue.jsreact.js

在AIGC(人工智能生成内容)时代,Vue开发正经历着深刻的变革。以下是对AIGC时代Vue开发的详细分析:一、AIGC技术对Vue开发的影响代码生成与自动化AIGC技术使得开发者能够借助智能工具快速生成和优化Vue代码。例如,通过自然语言处理模型(如ChatGPT),开发者可以描述组件的功能和样式需求,然后自动生成包含模板、脚本和样式的完整组件代码。这不仅大大提高了开发效率,还减少了人为错误的可

- DeepSeek大模型技术深度解析:揭开Transformer架构的神秘面纱

不一样的信息安全

网络杂烩AIDeepSeek

摘要DeepSeek大模型由北京深度求索人工智能基础技术研究有限公司开发,基于Transformer架构,具备卓越的自然语言理解和生成能力。该模型能够高效处理智能对话、文本生成和语义理解等复杂任务,标志着人工智能在自然语言处理领域的重大进展。关键词DeepSeek模型,Transformer架构,自然语言,智能对话,文本生成,语义理解一、DeepSeek大模型的架构解析1.1DeepSeek大模型

- 基于深度学习的大规模模型训练

SEU-WYL

深度学习dnn深度学习人工智能dnn

基于深度学习的大规模模型训练涉及训练具有数百万甚至数十亿参数的深度神经网络,以处理复杂的任务,如自然语言处理、计算机视觉和语音识别。以下是关于基于深度学习的大规模模型训练的详细介绍:1.背景和动机数据和模型规模增长:随着数据量和模型复杂度的增加,传统的单机或小规模集群训练难以满足需求。计算资源需求:大规模模型训练需要大量计算资源和存储,单一设备无法满足。任务复杂性:处理复杂任务(如GPT-3、BE

- 表格化数据处理中大语言模型的微调优化策略研究

C7211BA

人工智能自然语言处理大语言模型

论文地址ResearchonFine-TuningOptimizationStrategiesforLargeLanguageModelsinTabularDataProcessing论文主要内容这篇论文的主要内容是研究大型语言模型(LLMs)在处理表格数据时的微调优化策略。具体来说,论文探讨了以下几个关键方面:背景与挑战:大型语言模型(LLMs)在自然语言处理(NLP)领域取得了显著进展,但在处

- 【人工智能】基于Python的机器翻译系统,从RNN到Transformer的演进与实现

蒙娜丽宁

Python杂谈人工智能人工智能python机器翻译

《PythonOpenCV从菜鸟到高手》带你进入图像处理与计算机视觉的大门!解锁Python编程的无限可能:《奇妙的Python》带你漫游代码世界机器翻译(MachineTranslation,MT)作为自然语言处理领域的重要应用之一,近年来受到了广泛的关注。在本篇文章中,我们将详细探讨如何使用Python实现从传统的循环神经网络(RNN)到现代Transformer模型的机器翻译系统。文章将从机

- 【大模型入门必看】LLM大语言模型导读

古-月

LLM大语言模型

前言在规模扩展定律(ScalingLaws)被证明对语言模型有效之后,研究者构建出了许多大语言模型。尤其是2022年底面向普通消费者的ChatGPT模型的出现,正式标志着自然语言处理进入大语言模型时代。本章将简要梳理大语言模型的技术要点以及构建过程,并且列举了可用于预训练以及微调模型的常用数据集,介绍了目前开发大语言模型常用的代码库、预训练大语言模型的步骤以及涉及的关键技术,包括数据准备阶段、模型

- 讯飞绘镜(ai生成视频)技术浅析(三):自然语言处理(NLP)

爱研究的小牛

AIGC—视频AIGC—自然语言处理自然语言处理人工智能自然语言处理AIGC深度学习

1.技术架构概述讯飞绘镜的NLP技术架构可以分为以下几个核心模块:语义分析:理解用户输入的文本,提取关键信息(如实体、事件、情感等)。情节理解:分析文本中的故事情节,识别事件序列和逻辑关系。人物关系建模:识别文本中的人物及其关系,构建人物关系图。场景生成:根据情节和人物关系生成场景描述。每个模块都依赖于先进的深度学习模型和算法,以下将逐一详细讲解。2.语义分析语义分析的目标是从用户输入的文本中提取

- DeepSeek R1与OpenAI o1深度对比

码事漫谈

AI人工智能机器学习

文章目录引言技术原理DeepSeekR1OpenAIo1性能表现官方数据推理任务知识密集型任务通用能力价格对比应用场景科研与技术开发自然语言处理(NLP)企业智能化升级教育与培训数据分析与智能决策部署与集成DeepSeekR1OpenAIo1伦理考量DeepSeekR1OpenAIo1未来展望DeepSeekR1OpenAIo1引言在科技飞速发展的当下,人工智能领域中的大型语言模型(LLMs)正以

- A Survey on Large Language Model Acceleration based on KV Cache Management

UnknownBody

LLMDailySurveyPaperLLMInference语言模型人工智能自然语言处理

本文是LLM系列文章,针对《ASurveyonLargeLanguageModelAccelerationbasedonKVCacheManagement》的翻译。基于KV缓存管理的大型语言模型加速研究综述摘要1引言2前言3分类4token级优化5模型级优化6系统级优化7文本和多模态数据集8结论摘要大型语言模型(LLM)因其理解上下文和执行逻辑推理的能力,彻底改变了自然语言处理、计算机视觉和多模态

- Llama大型语言模型原理详解

摆烂大大王

llamallama语言模型人工智能

Llama大型语言模型是一种基于深度学习的自然语言处理模型,它在文本生成、问答、摘要等多种NLP任务中展现出强大的性能。本文将详细解析Llama模型的原理,包括其结构、训练过程以及工作机制,帮助读者深入理解这一先进的模型。一、模型结构Llama模型采用了一种基于Transformer的架构,这是一种由多个自注意力机制和前馈神经网络组成的深度神经网络结构。Transformer架构通过自注意力机制捕

- Linux系统python虚拟环境及HanLP部署

段智华

在Linux系统中运行HanLP,要安装部署一个Python的虚拟环境,实现Python2与Python3的版本共存,Python虚拟环境与JavaJVM虚拟机的共存,HanLP是面向生产环境的多语种NLP工具包,HanLp的标记是一只蝴蝶,蝴蝶象征着蝴蝶效应、非线性与混沌理论——虽然微小,但足以改变世界!(《自然语言处理入门》图书作者何晗)Linuxopenssl、libssl-dev等模块安装

- 《攻克语言密码:教AI理解隐喻与象征》

程序猿阿伟

人工智能

在自然语言处理(NLP)领域,让计算机理解人类语言中的隐喻和象征,是迈向更高语言理解水平的关键一步。从“时间就是金钱”这样的概念隐喻,到文学作品里象征着坚韧的“寒梅”,这些非字面意义的表达方式承载着丰富的情感与文化内涵。然而,对于基于规则和数据驱动的NLP模型来说,理解隐喻和象征一直是块难啃的硬骨头。理解隐喻与象征:人类语言的独特魅力隐喻和象征作为常见的修辞手法,为语言表达增添了生动性与深度。隐喻

- AI 大模型创业:如何利用商业优势?

AI天才研究院

大数据AI人工智能ChatGPTjavapythonjavascriptkotlingolang架构人工智能大厂程序员硅基计算碳基计算认知计算生物计算深度学习神经网络大数据AIGCAGILLM系统架构设计软件哲学Agent程序员实现财富自由

第1章:AI大模型概述1.1AI大模型的概念与演进AI大模型(Large-scaleArtificialIntelligenceModels)是指通过大规模数据训练得到的复杂神经网络模型。这些模型通常具有数十亿甚至千亿个参数,能够实现从自然语言处理到计算机视觉、语音识别等广泛领域的任务。AI大模型的概念起源于20世纪80年代,当时研究人员提出了深度学习(DeepLearning)这一概念。深度学习

- 语言模型与向量模型:深入解析与实例剖析

♢.*

语言模型人工智能自然语言处理

亲爱的小伙伴们,在求知的漫漫旅途中,若你对深度学习的奥秘、Java与Python的奇妙世界,亦或是读研论文的撰写攻略有所探寻,那不妨给我一个小小的关注吧。我会精心筹备,在未来的日子里不定期地为大家呈上这些领域的知识宝藏与实用经验分享。每一个点赞,都如同春日里的一缕阳光,给予我满满的动力与温暖,让我们在学习成长的道路上相伴而行,共同进步✨。期待你的关注与点赞哟!在自然语言处理领域,语言模型和向量模型

- Python 库的记录

weixin_40895135

python

GitHub-jobbole/awesome-python-cn:Python资源大全中文版,内容包括:Web框架、网络爬虫、网络内容提取、模板引擎、数据库、数据可视化、图片处理、文本处理、自然语言处理、机器学习、日志、代码分析等环境管理管理Python版本和环境的工具p–非常简单的交互式python版本管理工具。pyenv–简单的Python版本管理工具。Vex–可以在虚拟环境中执行命令。vir

- 词表设计:特殊Token区域与共享去区域的深入探讨

东方佑

开发语言

在自然语言处理(NLP)中,Tokenizer的设计对于模型性能有着至关重要的影响。Tokenizer不仅决定了文本如何被分割成更小的单位(即token),还决定了这些token如何被映射到模型可以理解的形式。本文将详细探讨一种特殊的Tokenizer设计方法——特殊Token区域与共享去区域的设计理念,并介绍其应用场景和实现方式。特殊Token区域概述特殊Token区域通常包括一些特定的标识符,

- Synthesia技术浅析(四):自然语言处理

爱研究的小牛

AIGC—视频AIGC—虚拟现实AIGC—自然语言处理自然语言处理人工智能AIGC

Synthesia的自然语言处理(NLP)模块是其核心技术之一,涵盖了文本转语音(TTS)、情感分析以及多语言支持等多个方面。一、文本转语音(TTS)1.关键组件Synthesia的TTS系统主要依赖于Tacotron2和WaveGlow模型。这些模型共同作用,将文本转换为高质量的语音。2.过程模型详解2.1文本预处理文本预处理是TTS的第一步,包括分词、标点符号处理、数字和日期格式转换等。分词(

- 大模型问答机器人的智能化程度

AI大模型应用之禅

AI大模型与大数据javapythonjavascriptkotlingolang架构人工智能

大模型、问答机器人、智能化程度、自然语言处理、深度学习、Transformer模型、知识图谱、推理能力、对话系统1.背景介绍近年来,人工智能技术取得了飞速发展,特别是深度学习的兴起,为自然语言处理(NLP)领域带来了革命性的变革。其中,大模型问答机器人作为一种新型的智能交互系统,凭借其强大的语言理解和生成能力,在客服、教育、娱乐等领域展现出广阔的应用前景。问答机器人是指能够理解用户自然语言问题并给

- 大语言模型原理与工程实践:残差连接与层归一化

AI大模型应用之禅

AI大模型与大数据计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

1.背景介绍随着自然语言处理(NLP)的发展,深度学习在过去几年中取得了令人瞩目的成果。其中,循环神经网络(RNN)和卷积神经网络(CNN)在图像和文本分类、语义角色标注、机器翻译等领域表现出色。然而,这些网络在训练过程中经常遭遇梯度消失和梯度爆炸的问题。为了解决这些问题,我们引入了残差连接(ResidualConnections)和层归一化(BatchNormalization)来改善模型性能。

- 模型架构选择:从传统NLP到Transformer

AI天才研究院

AI大模型应用入门实战与进阶大数据AI人工智能计算大数据人工智能语言模型AI大模型LLMJavaPython架构设计AgentRPA

模型架构选择:从传统NLP到Transformer关键词:自然语言处理(NLP),模型架构,传统NLP,Transformer,RNN,CNN,预训练模型文章目录模型架构选择:从传统NLP到Transformer1.背景介绍1.1问题的由来1.2研究现状1.3研究意义1.4本文结构2.核心概念与联系3.核心算法原理&具体操作步骤3.1算法原理概述3.1.1传统NLP模型3.1.2RNN模型3.1.

- Transformer架构的GPU并行和之前的NLP算法并行有什么不同?

AI大模型学习不迷路

transformer自然语言处理大模型深度学习NLPLLM大语言模型

1.什么是GPU并行计算?GPU并行计算是一种利用图形处理单元(GPU)进行大规模并行数据处理的技术。与传统的中央处理单元(CPU)相比,GPU拥有更多的核心,能够同时处理数千个线程,这使得GPU在处理高度并行的任务时表现出色。在深度学习中,GPU并行计算被广泛应用于训练神经网络,加速模型训练过程。在2017年之前,自然语言处理(NLP)领域的研究者们通常会从头开始训练模型,那时能够利用GPU进行

- 《向量数据库指南》——MoE应用:解锁深度学习新境界的钥匙

大禹智库

《实战AI智能体》《向量数据库指南》深度学习人工智能向量数据库大禹智库低代码MoE模型

在深度学习的广阔天地里,混合专家(MoE)模型如同一把锐利的钥匙,正逐步解锁着各种复杂应用场景的新境界。作为大禹智库的向量数据库高级研究员,同时也是《向量数据库指南》的作者,我深感MoE模型在推动AI技术向前发展中所扮演的重要角色。今天,我将带大家深入探讨MoE模型在自然语言处理、计算机视觉以及多模态学习等领域的应用,并巧妙引导大家通过《向量数据库指南》获取更多干货和深度实战经验。一、自然语言处理

- Java实现的基于模板的网页结构化信息精准抽取组件:HtmlExtractor

yangshangchuan

信息抽取HtmlExtractor精准抽取信息采集

HtmlExtractor是一个Java实现的基于模板的网页结构化信息精准抽取组件,本身并不包含爬虫功能,但可被爬虫或其他程序调用以便更精准地对网页结构化信息进行抽取。

HtmlExtractor是为大规模分布式环境设计的,采用主从架构,主节点负责维护抽取规则,从节点向主节点请求抽取规则,当抽取规则发生变化,主节点主动通知从节点,从而能实现抽取规则变化之后的实时动态生效。

如

- java编程思想 -- 多态

百合不是茶

java多态详解

一: 向上转型和向下转型

面向对象中的转型只会发生在有继承关系的子类和父类中(接口的实现也包括在这里)。父类:人 子类:男人向上转型: Person p = new Man() ; //向上转型不需要强制类型转化向下转型: Man man =

- [自动数据处理]稳扎稳打,逐步形成自有ADP系统体系

comsci

dp

对于国内的IT行业来讲,虽然我们已经有了"两弹一星",在局部领域形成了自己独有的技术特征,并初步摆脱了国外的控制...但是前面的路还很长....

首先是我们的自动数据处理系统还无法处理很多高级工程...中等规模的拓扑分析系统也没有完成,更加复杂的

- storm 自定义 日志文件

商人shang

stormclusterlogback

Storm中的日志级级别默认为INFO,并且,日志文件是根据worker号来进行区分的,这样,同一个log文件中的信息不一定是一个业务的,这样就会有以下两个需求出现:

1. 想要进行一些调试信息的输出

2. 调试信息或者业务日志信息想要输出到一些固定的文件中

不要怕,不要烦恼,其实Storm已经提供了这样的支持,可以通过自定义logback 下的 cluster.xml 来输

- Extjs3 SpringMVC使用 @RequestBody 标签问题记录

21jhf

springMVC使用 @RequestBody(required = false) UserVO userInfo

传递json对象数据,往往会出现http 415,400,500等错误,总结一下需要使用ajax提交json数据才行,ajax提交使用proxy,参数为jsonData,不能为params;另外,需要设置Content-type属性为json,代码如下:

(由于使用了父类aaa

- 一些排错方法

文强chu

方法

1、java.lang.IllegalStateException: Class invariant violation

at org.apache.log4j.LogManager.getLoggerRepository(LogManager.java:199)at org.apache.log4j.LogManager.getLogger(LogManager.java:228)

at o

- Swing中文件恢复我觉得很难

小桔子

swing

我那个草了!老大怎么回事,怎么做项目评估的?只会说相信你可以做的,试一下,有的是时间!

用java开发一个图文处理工具,类似word,任意位置插入、拖动、删除图片以及文本等。文本框、流程图等,数据保存数据库,其余可保存pdf格式。ok,姐姐千辛万苦,

- php 文件操作

aichenglong

PHP读取文件写入文件

1 写入文件

@$fp=fopen("$DOCUMENT_ROOT/order.txt", "ab");

if(!$fp){

echo "open file error" ;

exit;

}

$outputstring="date:"." \t tire:".$tire."

- MySQL的btree索引和hash索引的区别

AILIKES

数据结构mysql算法

Hash 索引结构的特殊性,其 检索效率非常高,索引的检索可以一次定位,不像B-Tree 索引需要从根节点到枝节点,最后才能访问到页节点这样多次的IO访问,所以 Hash 索引的查询效率要远高于 B-Tree 索引。

可能很多人又有疑问了,既然 Hash 索引的效率要比 B-Tree 高很多,为什么大家不都用 Hash 索引而还要使用 B-Tree 索引呢

- JAVA的抽象--- 接口 --实现

百合不是茶

抽象 接口 实现接口

//抽象 类 ,方法

//定义一个公共抽象的类 ,并在类中定义一个抽象的方法体

抽象的定义使用abstract

abstract class A 定义一个抽象类 例如:

//定义一个基类

public abstract class A{

//抽象类不能用来实例化,只能用来继承

//

- JS变量作用域实例

bijian1013

作用域

<script>

var scope='hello';

function a(){

console.log(scope); //undefined

var scope='world';

console.log(scope); //world

console.log(b);

- TDD实践(二)

bijian1013

javaTDD

实践题目:分解质因数

Step1:

单元测试:

package com.bijian.study.factor.test;

import java.util.Arrays;

import junit.framework.Assert;

import org.junit.Before;

import org.junit.Test;

import com.bijian.

- [MongoDB学习笔记一]MongoDB主从复制

bit1129

mongodb

MongoDB称为分布式数据库,主要原因是1.基于副本集的数据备份, 2.基于切片的数据扩容。副本集解决数据的读写性能问题,切片解决了MongoDB的数据扩容问题。

事实上,MongoDB提供了主从复制和副本复制两种备份方式,在MongoDB的主从复制和副本复制集群环境中,只有一台作为主服务器,另外一台或者多台服务器作为从服务器。 本文介绍MongoDB的主从复制模式,需要指明

- 【HBase五】Java API操作HBase

bit1129

hbase

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.HColumnDescriptor;

import org.apache.ha

- python调用zabbix api接口实时展示数据

ronin47

zabbix api接口来进行展示。经过思考之后,计划获取如下内容: 1、 获得认证密钥 2、 获取zabbix所有的主机组 3、 获取单个组下的所有主机 4、 获取某个主机下的所有监控项

- jsp取得绝对路径

byalias

绝对路径

在JavaWeb开发中,常使用绝对路径的方式来引入JavaScript和CSS文件,这样可以避免因为目录变动导致引入文件找不到的情况,常用的做法如下:

一、使用${pageContext.request.contextPath}

代码” ${pageContext.request.contextPath}”的作用是取出部署的应用程序名,这样不管如何部署,所用路径都是正确的。

- Java定时任务调度:用ExecutorService取代Timer

bylijinnan

java

《Java并发编程实战》一书提到的用ExecutorService取代Java Timer有几个理由,我认为其中最重要的理由是:

如果TimerTask抛出未检查的异常,Timer将会产生无法预料的行为。Timer线程并不捕获异常,所以 TimerTask抛出的未检查的异常会终止timer线程。这种情况下,Timer也不会再重新恢复线程的执行了;它错误的认为整个Timer都被取消了。此时,已经被

- SQL 优化原则

chicony

sql

一、问题的提出

在应用系统开发初期,由于开发数据库数据比较少,对于查询SQL语句,复杂视图的的编写等体会不出SQL语句各种写法的性能优劣,但是如果将应用系统提交实际应用后,随着数据库中数据的增加,系统的响应速度就成为目前系统需要解决的最主要的问题之一。系统优化中一个很重要的方面就是SQL语句的优化。对于海量数据,劣质SQL语句和优质SQL语句之间的速度差别可以达到上百倍,可见对于一个系统

- java 线程弹球小游戏

CrazyMizzz

java游戏

最近java学到线程,于是做了一个线程弹球的小游戏,不过还没完善

这里是提纲

1.线程弹球游戏实现

1.实现界面需要使用哪些API类

JFrame

JPanel

JButton

FlowLayout

Graphics2D

Thread

Color

ActionListener

ActionEvent

MouseListener

Mouse

- hadoop jps出现process information unavailable提示解决办法

daizj

hadoopjps

hadoop jps出现process information unavailable提示解决办法

jps时出现如下信息:

3019 -- process information unavailable3053 -- process information unavailable2985 -- process information unavailable2917 --

- PHP图片水印缩放类实现

dcj3sjt126com

PHP

<?php

class Image{

private $path;

function __construct($path='./'){

$this->path=rtrim($path,'/').'/';

}

//水印函数,参数:背景图,水印图,位置,前缀,TMD透明度

public function water($b,$l,$pos

- IOS控件学习:UILabel常用属性与用法

dcj3sjt126com

iosUILabel

参考网站:

http://shijue.me/show_text/521c396a8ddf876566000007

http://www.tuicool.com/articles/zquENb

http://blog.csdn.net/a451493485/article/details/9454695

http://wiki.eoe.cn/page/iOS_pptl_artile_281

- 完全手动建立maven骨架

eksliang

javaeclipseWeb

建一个 JAVA 项目 :

mvn archetype:create

-DgroupId=com.demo

-DartifactId=App

[-Dversion=0.0.1-SNAPSHOT]

[-Dpackaging=jar]

建一个 web 项目 :

mvn archetype:create

-DgroupId=com.demo

-DartifactId=web-a

- 配置清单

gengzg

配置

1、修改grub启动的内核版本

vi /boot/grub/grub.conf

将default 0改为1

拷贝mt7601Usta.ko到/lib文件夹

拷贝RT2870STA.dat到 /etc/Wireless/RT2870STA/文件夹

拷贝wifiscan到bin文件夹,chmod 775 /bin/wifiscan

拷贝wifiget.sh到bin文件夹,chm

- Windows端口被占用处理方法

huqiji

windows

以下文章主要以80端口号为例,如果想知道其他的端口号也可以使用该方法..........................1、在windows下如何查看80端口占用情况?是被哪个进程占用?如何终止等. 这里主要是用到windows下的DOS工具,点击"开始"--"运行",输入&

- 开源ckplayer 网页播放器, 跨平台(html5, mobile),flv, f4v, mp4, rtmp协议. webm, ogg, m3u8 !

天梯梦

mobile

CKplayer,其全称为超酷flv播放器,它是一款用于网页上播放视频的软件,支持的格式有:http协议上的flv,f4v,mp4格式,同时支持rtmp视频流格 式播放,此播放器的特点在于用户可以自己定义播放器的风格,诸如播放/暂停按钮,静音按钮,全屏按钮都是以外部图片接口形式调用,用户根据自己的需要制作 出播放器风格所需要使用的各个按钮图片然后替换掉原始风格里相应的图片就可以制作出自己的风格了,

- 简单工厂设计模式

hm4123660

java工厂设计模式简单工厂模式

简单工厂模式(Simple Factory Pattern)属于类的创新型模式,又叫静态工厂方法模式。是通过专门定义一个类来负责创建其他类的实例,被创建的实例通常都具有共同的父类。简单工厂模式是由一个工厂对象决定创建出哪一种产品类的实例。简单工厂模式是工厂模式家族中最简单实用的模式,可以理解为是不同工厂模式的一个特殊实现。

- maven笔记

zhb8015

maven

跳过测试阶段:

mvn package -DskipTests

临时性跳过测试代码的编译:

mvn package -Dmaven.test.skip=true

maven.test.skip同时控制maven-compiler-plugin和maven-surefire-plugin两个插件的行为,即跳过编译,又跳过测试。

指定测试类

mvn test

- 非mapreduce生成Hfile,然后导入hbase当中

Stark_Summer

maphbasereduceHfilepath实例

最近一个群友的boss让研究hbase,让hbase的入库速度达到5w+/s,这可愁死了,4台个人电脑组成的集群,多线程入库调了好久,速度也才1w左右,都没有达到理想的那种速度,然后就想到了这种方式,但是网上多是用mapreduce来实现入库,而现在的需求是实时入库,不生成文件了,所以就只能自己用代码实现了,但是网上查了很多资料都没有查到,最后在一个网友的指引下,看了源码,最后找到了生成Hfile

- jsp web tomcat 编码问题

王新春

tomcatjsppageEncode

今天配置jsp项目在tomcat上,windows上正常,而linux上显示乱码,最后定位原因为tomcat 的server.xml 文件的配置,添加 URIEncoding 属性:

<Connector port="8080" protocol="HTTP/1.1"

connectionTi

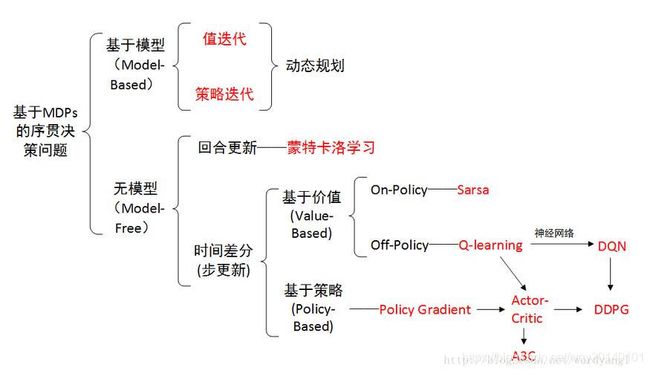

On-line代表,agent必须和环境交互,一边选取动作一遍学习;Off-line代表,agent既可以直接与环境交互进行学习,也可以从别人的经验里学习。

On-line代表,agent必须和环境交互,一边选取动作一遍学习;Off-line代表,agent既可以直接与环境交互进行学习,也可以从别人的经验里学习。