有码照片还原成无码:谷歌大脑能让模糊人脸变清晰

在观看岛国教育片的时候,往往在不可描述的部位打上了马赛克,固然呈现了朦胧美,但部分观众依然希望变得更加清晰。现在,Google Brain 在提升图片分辨率方面取得了突破性进展。他们已经成功将 8*8(毫米)网格的像素马赛克转换成为肉眼可辨识的人物图像。

而真正能够提升低分辨率照片细节的最佳突破口就是神经网路。当我们被照片中所包含的像素信息难倒的时候,深度学习能通过人类常说的「幻想」来增加细节。实质就是软件基于从其他图片中学习到的信息对图片进行猜测。

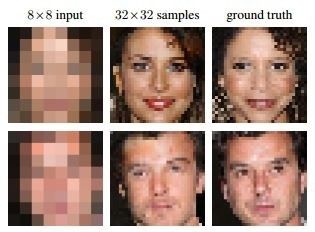

下面是他们复原的效果案例之一:

右手边的图片,是 32 x 32 网格的真实人物头像。左手边的图片,是已经压缩到 8 x 8 网格的相同头像,而中间的照片,是 GoogleBrain 基于低分辨率样片猜测的原图。

整个复原过程使用了两种神经网络。首先介绍的是调节网络(Conditioning Network),它将低分辨率照片和数据库中的高分辨率照片进行对比。这个过程中迅速降低数据库照片中的分辨率,并根据像素颜色匹配一堆同类照片。

接下来介绍的是优先网络(prior network),它就会猜测那些细节可以作为高分辨率照片的特征。利用 PixelCNN 架构,该网络会筛查该尺寸的同类照片,并根据概率优先对高分辨率照片进行填充。例如,在论文提供的例子中,提供的同类照片是名人和卧室,优先网络根据优先级最终确认了名人的照片。优先网络会在低分辨率和高分辨率照片中做出决定,如果发现鼻子的可能性比较大,就会选择鼻子。

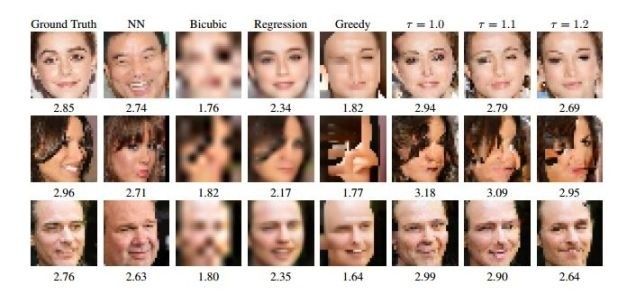

接下来,两个神经网络的最佳猜测就会进行整合,最终形成的图像如下:

下面也是一些通过超像素技术变化的样本:

在你开始思考:「这并不准确,这个人工智能是愚蠢的」,那么请记住人类同样也是愚蠢的。一名志愿者参与了这样的测试,同时展示降低分辨率的照片和通过 Google Brain 复原的照片,然后提问「你猜那张照片来自于相机?」,最终结果是 10% 的名人照片,测试者选择了 Google Brain 的照片。在 28% 的卧室样片中,测试者选择了 Google Brain 的照片。

尽管技术是纯净的,但是未来可能会有非常可怕的应用。就像是波士顿马拉松爆炸案一样,不难联想到一些执法部门会滥用该软件来抓取嫌疑犯。更为重要的是,人工智能的多次尝试已经被证明存在种族主义,因为往往会参杂人类的偏见。分析型人工智能和图像技术的结合,在未来必然会经历一段漫长的调试过程。

谷歌旗下人工智能部门“谷歌大脑”设计了一款全新软件,可以把马赛克一样的源图片还原成清晰图片。简而言之,原本“打码”的照片现在也可以轻松变成无码高清了。

首先来看一张图,左边一列是分辨率为8×8的打码图片,中间一列是谷歌大脑软件还原的图片,而右边一列则是真正的原始图片。实际效果非常接近原始图片。

众所周知,不可能制作出比源图片更加详细的图片,那么谷歌大脑是如何做到的呢?他们将两个神经网络聪明地整合到一起。

第一部分是条件网络(conditioning network),它会将8×8的图片与高清图片进行对比,将其他高清图片缩小到8×8的分辨率,然后进行匹配。

第二部分是优先网络(prior network),使用PixelCNN(像素神经网络)向8×8的源图片中增加真实的高清细节。在这个案例中,优先网络其实是吸收了大量名人和卧室照片。然后,当需要解析源图片时,便会从其已知的图片中寻找与之匹配的新像素,并将添加进去。

例如,图片顶部有一个棕色像素,而优先网络或许认为那是一条眉毛:于是,当要解析图片时,就会用眉毛形状的棕色像素填补进去。

为了制作出最终的无码高清图片,需要融合这两个神经网络输出的数据,最终结果往往会包含一些似是而非的新细节。

谷歌大脑的高清还原技术已经在实际测试中取得了一定的成功。当该团队向人类观察员呈现真实的高清明星照和经过电脑还原的照片时,观察员被骗的比例达到10%(50%就属于完美得分)。而在卧室照片中,人类观察员被骗的比例达到28%。这两个得分都远高于常规的双三次插值放大技术,后者没有骗过任何人类观察员。

需要指出的是,电脑还原的高清图片并非真实图片,它所增加的细节只是一种“猜测”。这便引发了一些有趣的问题,尤其是在监控和法医领域。这项技术可以把模糊的嫌疑人照片放大成更加清晰的图片,但却无法得到真正的嫌疑人照片,但仍然可以为警方提供一些帮助。

谷歌大脑和DeepMind是Alphabet的两大深度学习研究机构。前者最近发布了一些有趣的研究成果,例如,开发了可以自行制作加密算法的人工智能技术。后者则因为其开发的AlphaGo去年击败全球顶级围棋选手李世石而名声大噪。

:Google Brain在提升图片分辨率方面取得了突破性进展。他们已经成功将8*8(毫米)网格的像素马赛克转换成为肉眼可辨识的人物图像。

在观看岛国教育片的时候,往往在不可描述的部位打上了马赛克,固然呈现了朦胧美,但部分观众依然希望变得更加清晰。现在,Google Brain在提升图片分辨率方面取得了突破性进展。他们已经成功将8*8(毫米)网格的像素马赛克转换成为肉眼可辨识的人物图像。

而真正能够提升低分辨率照片细节的最佳突破口就是神经网路。当我们被照片中所包含的像素信息难倒的时候,深度学习能通过人类常说的「幻想」来增加细节。实质就是软件基于从其他图片中学习到的信息对图片进行猜测。

Google Brain的研究团队已经公布了「像素递归超分辨率」技术(Pixel Recursive Super Resolution)的最新进展,尽管结果看上去有点瘆人,但是整个还原效果令人印象深刻。

下面是他们复原的效果案例之一:

右手边的图片,是32 x 32网格的真实人物头像。左手边的图片,是已经压缩到8 x 8网格的相同头像,而中间的照片,是GoogleBrain基于低分辨率样片猜测的原图。

整个复原过程使用了两种神经网络。首先介绍的是调节网络(Conditioning Network),它将低分辨率照片和数据库中的高分辨率照片进行对比。这个过程中迅速降低数据库照片中的分辨率,并根据像素颜色匹配一堆同类照片。

接下来介绍的是优先网络(prior network),它就会猜测那些细节可以作为高分辨率照片的特征。利用PixelCNN架构,该网络会筛查该尺寸的同类照片,并根据概率优先对高分辨率照片进行填充。例如,在论文提供的例子中,提供的同类照片是名人和卧室,优先网络根据优先级最终确认了名人的照片。优先网络会在低分辨率和高分辨率照片中做出决定,如果发现鼻子的可能性比较大,就会选择鼻子。

接下来,两个神经网络的最佳猜测就会进行整合,最终形成的图像如下:

下面也是一些通过超像素技术变化的样本:

在你开始思考:「这并不准确,这个人工智能是愚蠢的」,那么请记住人类同样也是愚蠢的。一名志愿者参与了这样的测试,同时展示降低分辨率的照片和通过Google Brain复原的照片,然后提问「你猜那张照片来自于相机?」,最终结果是10% 的名人照片,测试者选择了Google Brain的照片。在28% 的卧室样片中,测试者选择了Google Brain的照片。

尽管技术是纯净的,但是未来可能会有非常可怕的应用。就像是波士顿马拉松爆炸案一样,不难联想到一些执法部门会滥用该软件来抓取嫌疑犯。更为重要的是,人工智能的多次尝试已经被证明存在种族主义,因为往往会参杂人类的偏见。分析型人工智能和图像技术的结合,在未来必然会经历一段漫长的调试过程。