- Flink读写Kafka(Table API)

sf_www

实时计算Flinkflinkkafka大数据

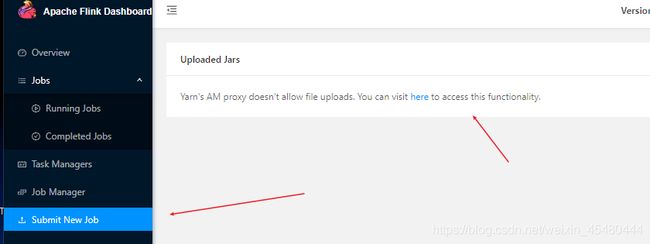

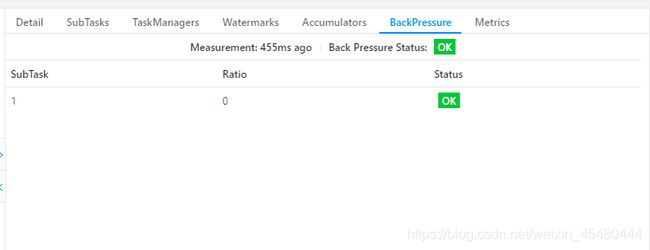

前面(Flink读写Kafka(DataStreamAPI)_flinkkafkascram-CSDN博客)我们已经讲解了使用DataStreamAPI来读取Kafka,在这里继续讲解下使用TableAPI来读取Kafka,和前面一样也是引入相同的依赖即可。org.apache.flinkflink-connector-kafka1.15.41.创建KafkaTable可以使用以下方式来创建Kaf

- 2025年新出炉的MySQL面试题

长风清留扬

150道MySQL高频面试题mysql数据库面试sql

作者简介:CSDN\阿里云\腾讯云\华为云开发社区优质创作者,专注分享大数据、Python、数据库、人工智能等领域的优质内容个人主页:长风清留杨的博客形式准则:无论成就大小,都保持一颗谦逊的心,尊重他人,虚心学习。✨推荐专栏:Python入门到入魔,Mysql入门到入魔,Python入门基础大全,Flink入门到实战若缘分至此,无法再续相逢,愿你朝朝暮暮,皆有安好,晨曦微露道早安,日中炽热说午安,

- 精选了几道MySQL的大厂面试题,被提问的几率很高!

长风清留扬

150道MySQL高频面试题mysqlandroid数据库面试学习MySQL面试

作者简介:CSDN\阿里云\腾讯云\华为云开发社区优质创作者,专注分享大数据、Python、数据库、人工智能等领域的优质内容个人主页:长风清留杨的博客形式准则:无论成就大小,都保持一颗谦逊的心,尊重他人,虚心学习。✨推荐专栏:Python入门到入魔,Mysql入门到入魔,Python入门基础大全,Flink入门到实战若缘分至此,无法再续相逢,愿你朝朝暮暮,皆有安好,晨曦微露道早安,日中炽热说午安,

- Apache Flink 替换 Spark Stream的架构与实践( bilibili 案例解读)_streamsparkflink加载udf

2501_90243308

apacheflinkspark

3.基于ApacheFlink的流式计算平台为解决上述问题,bilibili希望根据以下三点要求构建基于ApacheFlink的流式计算平台。第一点,需要提供SQL化编程。bilibili对SQL进行了扩展,称为BSQL。BSQL扩展了Flink底层SQL的上层,即SQL语法层。**第二点,**DAG拖拽编程,一方面用户可以通过画板来构建自己的Pipeline,另一方面用户也可以使用原生Jar方式

- Flink (十二) :Table API & SQL (一) 概览

Leven199527

Flinkflinksql大数据

ApacheFlink有两种关系型API来做流批统一处理:TableAPI和SQL。TableAPI是用于Scala和Java语言的查询API,它可以用一种非常直观的方式来组合使用选取、过滤、join等关系型算子。FlinkSQL是基于ApacheCalcite来实现的标准SQL。无论输入是连续的(流式)还是有界的(批处理),在两个接口中指定的查询都具有相同的语义,并指定相同的结果。TableAP

- 用 Java 的思路快速学习 Scala

进朱者赤

其他大数据scalaScala

引言Scala是一种结合了面向对象和函数式编程的现代编程语言,广泛应用于大数据处理框架如ApacheSpark和ApacheFlink。对于熟悉Java的开发者来说,Scala的学习曲线相对平缓。本文将通过类比Java中的概念,帮助Java开发者快速上手Scala。1.基本语法1.1.数据类型以下是Scala和Java数据类型的汇总表格:Scala数据类型Java数据类型说明Intint32位整数

- Flink之kafka消息解析器2

怎么才能努力学习啊

flinkkafka大数据

概要昨天的话题,FlinkSource消费kafka数据自定义反序列化,获取自己想要的数据和类型实现过程publicclassTestWithMetadataDeserializationSchemaimplementsKafkaRecordDeserializationSchema{第一步:自定义实现这个接口,这里的泛型一般的都是自定义类@Overridepublicvoiddeserializ

- Flink之kafka消费数据

怎么才能努力学习啊

flinkkafka大数据

场景:本地构建Flink程序问题描述消费Kafka的数据时,使用Flink新的KakfaSource。会报如下错误KafkaSourcekafkaSource=KafkaSource.builder().setBootstrapServers(kafkaProperties.getProperty("kafka.bootstrap.servers")).setTopics("test2").set

- 【Flink 实战系列】Flink CDC 实时同步 Mysql 全量加增量数据到 Hudi

JasonLee实时计算

Flink实战系列hbasespark大数据

【Flink实战系列】FlinkCDC实时同步Mysql全量加增量数据到Hudi前言FlinkCDC是基于Flink开发的变化数据获取组件(Changedatacapture),简单的说就是来捕获变更的数据,ApacheHudi是一个数据湖平台,又支持对数据做增删改查操作,所以FlinkCDC可以很好的和Hudi结合起来,打造实时数仓,实时湖仓一体的架构,下面就来演示一下同步的过程。环境组件版本F

- Flink系列-2、Flink架构体系

技术武器库

大数据专栏flink架构jvm

版权声明:本文为博主原创文章,遵循CC4.0BY-SA版权协议,转载请附上原文出处链接和本声明。大数据系列文章目录官方网址:https://flink.apache.org/学习资料:https://flink-learning.org.cn/目录Flink中的重要角⾊Flink数据流编程模型Libraries支持Flink集群搭建Local本地模式(开发测试)Standalone-伪分布环境(开

- Flink 的核心特点和概念

Ray.1998

大数据大数据数据分析数据仓库flink

Flink是一个流式处理框架,专注于高吞吐量、低延迟的数据流处理。它能处理无限流(即实时数据流)和有限流(批处理),具有很强的灵活性和可扩展性,广泛应用于实时数据分析、监控系统、数据处理平台等场景。下面是一些关于Flink的核心特点和概念:1.流处理和批处理流处理(StreamProcessing):Flink的核心就是流处理,它能够实时处理不断到达的数据流。Flink会将数据划分成时间窗口来处理

- Flink的流处理和批处理

Ray.1998

大数据flink大数据数据挖掘数据分析

1.流处理(StreamProcessing)流处理是Flink的核心功能之一,主要用于处理无限流数据,也就是不断到达的数据。它能够实时处理数据流,并对每个数据元素执行操作。流处理中的数据没有预定的边界,它的特征是持续到达,因此,流处理必须实时处理每个事件,而不能等到所有数据都到齐后再进行处理。核心特点:实时性:流处理的最大优势是实时性。Flink允许对实时数据流进行分析,计算和处理,几乎是对数据

- HUDI-0.11.0 BUCKET index on Flink 特性试用

_Magic

BigDataflinkhudi

1.背景在0.10.1版本下,使用默认的index(FLINK_STATE),在upsert模式下,几十亿级别的数据更新会消耗大量内存,并且检查点(checkpoint)时间过长。因此,切换到0.11.0的BUCKET索引。当前环境:Flink1.13.2+Hudi0.11.0(master2022.04.11)+COW+HDFS。关键配置项:index.type=BUCKEThoodie.buc

- Kafka 迁移 AutoMQ 时 Flink 位点管理的挑战与解决方案

AutoMQ

云计算云原生Kafka消息计算大数据AWSAutoMQ阿里云腾讯云GCP

编辑导读:AutoMQ是一款与ApacheKafka100%完全兼容的新一代Kafka,可以做到至多10倍的成本降低和极速的弹性。凭借其与Kafka的完全兼容性可以与用户已有的Flink等大数据基础设施进行轻松整合。Flink是重要的流处理引擎,与Kafka有着密切的关系。本文重点介绍了当用户需要将生产Kafka集群迁移到AutoMQ时,如何处理好Flink的位点来确保整体迁移的平滑过渡。引言在云

- 20250120 Flink 的 缓冲区超时(Buffer Timeout)

靈臺清明

flink

Flink的缓冲区超时(BufferTimeout)机制确实类似于一辆车等待乘客的过程,如果车每次只载一个乘客就发车,会导致效率低下,资源浪费。同样,在Flink的数据流处理中,缓冲区超时的设置对吞吐量和延迟的权衡至关重要。以下是更详细的原因解析和背后的机制:1.什么是缓冲区超时(BufferTimeout)?在Flink中,算子之间的数据通过网络传输。为了提高传输效率,Flink会在发送数据之前

- Java 驱动大数据流处理:Storm 与 Flink 入门 (大数据)

用心去追梦

大数据javastorm

Java是一种广泛使用的编程语言,特别适用于企业级应用开发。随着数据量的不断增长,处理大数据流成为了现代软件开发中的一个重要领域。ApacheStorm和ApacheFlink是两个用于处理大规模数据流的开源框架,它们都支持用Java编写的应用程序。下面将简要介绍这两个框架,并提供一些入门指导。ApacheStormApacheStorm是一个免费、开源的分布式实时计算系统。Storm让用户能够轻

- SeaTunnel 与 DataX 、Sqoop、Flume、Flink CDC 对比

不二人生

#数据集成工具SeaTunnel

文章目录SeaTunnel与DataX、Sqoop、Flume、FlinkCDC对比同类产品横向对比2.1、高可用、健壮的容错机制2.2、部署难度和运行模式2.3、支持的数据源丰富度2.4、内存资源占用2.5、数据库连接占用2.6、自动建表2.7、整库同步2.8、断点续传2.9、多引擎支持2.10、数据转换算子2.11、性能2.12、离线同步2.13、增量同步&实时同步2.14、CDC同步2.15

- 20250120 深入了解 Apache Flink 的 Checkpointing

靈臺清明

Flinkapacheflink大数据

ApacheFlink是一种用于实时流处理和批处理的分布式计算框架。在实时流处理任务中,保证数据的一致性和任务的容错性是至关重要的,而Flink的Checkpointing机制正是实现这一目标的核心技术。本文将详细介绍Flink的Checkpointing,包括其概念、原理、配置和实际应用。什么是Checkpointing?Checkpointing是Flink提供的一种用于容错的机制。它会在流处

- Flink Standalone 方案中解决挂机问题

星尘幻宇科技

flink大数据

Standalone中可以配置HighAvailability(HA)部署和配置首先了解Flink实际运行时包括两类进程:JobManager(又称为JobMaster):协调Task的分布式执行,包括调度Task、协调创Checkpoint以及当Jobfailover时协调各个Task从Checkpoint恢复等。TaskManager(又称为Worker):执行Dataflow中的Tasks,

- 大数据学习(37)- Flink运行时架构

viperrrrrrr

学习flink大数据

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦1)作业管理器(JobManager)JobManager是一个Flink集群中任务管理和调度的核心,是控制应用执行的主进程。也就是说,每个应用都应该被唯一的JobManager所控制执行。JobManger又包含3个不同的组件。(1)JobMasterJobM

- Flink CDC MySQL同步MySQL错误记录

lingllllove

flinkmysql大数据

FlinkCDC简介FlinkCDC(ChangeDataCapture)是一种高效的数据同步工具,利用Flink强大的实时流处理能力,从MySQL等数据库捕获数据变更,并将这些变更实时同步到目标数据库。本文将详细介绍FlinkCDCMySQL同步到MySQL时常见的错误记录及其解决方法。常见错误及解决方法1.连接错误错误信息:FailedtoconnecttoMySQLserver.可能原因:

- FFA 2024 「流批一体」专场:探索在不同场景的流批一体

Apache Flink

FlinkForwardAsia2024即将盛大开幕!作为ApacheFlink社区备受期待的年度盛会之一,本届大会将于11月29至30日在上海隆重举行。FlinkForwardAsia(简称FFA)是由Apache官方授权的社区技术大会,旨在汇聚领先的行业实践与技术动态。在众多合作伙伴和技术开发者的支持下,FFA已成功举办六届。适逢ApacheFlink诞生10周年,今年的FFA将与广大开发者分

- Scaleph:基于Kubernetes的开放式数据平台

尤淞渊

Scaleph:基于Kubernetes的开放式数据平台scalephOpendataplatformbasedonFlinkandKubernetes,supportsweb-uiclick-and-dropdataintegrationwithSeaTunnelbackendedbyFlinkengine,flinkonlinesqldevelopmentbackendedbyFlinkSql

- 深入Flink : 源码解读数据倾斜代码落地

java

大家好,我是大圣,很高兴又和大家见面。上篇文章,我们详细说了通过使得Flink每个并行子任务上面都有对应的key来解决数据倾斜。但是我们只说了这个方案的思想和设计理解,还没有把这种方案真正应用到我们的Flink任务当中。这篇文章我们就重点把这种方案实践到我们写的Flink任务当中。什么是数据倾斜解决方案回顾代码如下:publicclassRebalanceKeyCreator{privateint

- Flink(十):DataStream API (七) 状态

Leven199527

Flinkflink大数据

1.状态的定义在ApacheFlink中,状态(State)是指在数据流处理过程中需要持久化和追踪的中间数据,它允许Flink在处理事件时保持上下文信息,从而支持复杂的流式计算任务,如聚合、窗口计算、联接等。状态是Flink处理有状态操作(如窗口、时间戳操作、聚合等)的核心组成部分。2.状态的类型Flink提供了强大的状态管理机制,允许应用程序在分布式环境中处理状态,保证高可用性和容错性。Flin

- Apache Flink

morcake

flink大数据

"ApacheFlinkistheopensourcestreamprocessingframeworkfordistributed,high-performance,ready-to-use,andaccuratestreamprocessingapplications."ApacheFlinkisaframeworkanddistributedprocessingengineforstatef

- 一文帮你搞懂flink中窗口的分类(一)

知否&知否

flink中窗口及其函数分类flink大数据

Window可以分成两类:CountWindow:按照指定的数据条数生成一个Window,与时间无关。滚动计数窗口,每隔N条数据,统计前N条数据滑动计数窗口,每隔N条数据,统计前M条数据TimeWindow:按照时间生成Window。(重点)滚动时间窗口,每隔N时间,统计前N时间范围内的数据,窗口长度N,滑动距离N滑动时间窗口,每隔N时间,统计前M时间范围内的数据,窗口长度M,滑动距离N还有一种特

- Java 大视界 -- Java 驱动大数据流处理:Storm 与 Flink 入门(六)

青云交

大数据新视界Java大视界FlinkStorm大数据流处理实时数据处理架构实时监控数据分析java

亲爱的朋友们,热烈欢迎你们来到青云交的博客!能与你们在此邂逅,我满心欢喜,深感无比荣幸。在这个瞬息万变的时代,我们每个人都在苦苦追寻一处能让心灵安然栖息的港湾。而我的博客,正是这样一个温暖美好的所在。在这里,你们不仅能够收获既富有趣味又极为实用的内容知识,还可以毫无拘束地畅所欲言,尽情分享自己独特的见解。我真诚地期待着你们的到来,愿我们能在这片小小的天地里共同成长,共同进步。本博客的精华专栏:大数

- 【大数据】Flink CDC 实时同步mysql数据

小码农叔叔

springboot入门到精通大数据FlinkCDCFlinkCDC同步数据FlinkCDC数据同步

目录一、前言二、FlinkCDC介绍2.1什么是FlinkCDC2.2FlinkCDC特点2.3FlinkCDC核心工作原理2.4FlinkCDC使用场景三、常用的数据同步方案对比3.1数据同步概述3.1.1数据同步来源3.2常用的数据同步方案汇总3.3为什么推荐FlinkCDC3.4FlinkCDC适用范围3.5FlinkCDC不同版本对比3.5.1FlinkCDC1.x3.5.2FlinkCD

- Flink 使用 Kafka 作为数据源时遇到了偏移量提交失败的问题

java我跟你拼了

异常笔记flinkkafka大数据

具体的错误日志21:43:57.069[KafkaFetcherforSource:CustomSource->Map->Filter(1/1)#2]ERRORorg.apache.kafka.clients.consumer.internals.ConsumerCoordinator-[ConsumerclientId=consumer-my-group-6,groupId=my-group]O

- Java实现的简单双向Map,支持重复Value

superlxw1234

java双向map

关键字:Java双向Map、DualHashBidiMap

有个需求,需要根据即时修改Map结构中的Value值,比如,将Map中所有value=V1的记录改成value=V2,key保持不变。

数据量比较大,遍历Map性能太差,这就需要根据Value先找到Key,然后去修改。

即:既要根据Key找Value,又要根据Value

- PL/SQL触发器基础及例子

百合不是茶

oracle数据库触发器PL/SQL编程

触发器的简介;

触发器的定义就是说某个条件成立的时候,触发器里面所定义的语句就会被自动的执行。因此触发器不需要人为的去调用,也不能调用。触发器和过程函数类似 过程函数必须要调用,

一个表中最多只能有12个触发器类型的,触发器和过程函数相似 触发器不需要调用直接执行,

触发时间:指明触发器何时执行,该值可取:

before:表示在数据库动作之前触发

- [时空与探索]穿越时空的一些问题

comsci

问题

我们还没有进行过任何数学形式上的证明,仅仅是一个猜想.....

这个猜想就是; 任何有质量的物体(哪怕只有一微克)都不可能穿越时空,该物体强行穿越时空的时候,物体的质量会与时空粒子产生反应,物体会变成暗物质,也就是说,任何物体穿越时空会变成暗物质..(暗物质就我的理

- easy ui datagrid上移下移一行

商人shang

js上移下移easyuidatagrid

/**

* 向上移动一行

*

* @param dg

* @param row

*/

function moveupRow(dg, row) {

var datagrid = $(dg);

var index = datagrid.datagrid("getRowIndex", row);

if (isFirstRow(dg, row)) {

- Java反射

oloz

反射

本人菜鸟,今天恰好有时间,写写博客,总结复习一下java反射方面的知识,欢迎大家探讨交流学习指教

首先看看java中的Class

package demo;

public class ClassTest {

/*先了解java中的Class*/

public static void main(String[] args) {

//任何一个类都

- springMVC 使用JSR-303 Validation验证

杨白白

springmvc

JSR-303是一个数据验证的规范,但是spring并没有对其进行实现,Hibernate Validator是实现了这一规范的,通过此这个实现来讲SpringMVC对JSR-303的支持。

JSR-303的校验是基于注解的,首先要把这些注解标记在需要验证的实体类的属性上或是其对应的get方法上。

登录需要验证类

public class Login {

@NotEmpty

- log4j

香水浓

log4j

log4j.rootCategory=DEBUG, STDOUT, DAILYFILE, HTML, DATABASE

#log4j.rootCategory=DEBUG, STDOUT, DAILYFILE, ROLLINGFILE, HTML

#console

log4j.appender.STDOUT=org.apache.log4j.ConsoleAppender

log4

- 使用ajax和history.pushState无刷新改变页面URL

agevs

jquery框架Ajaxhtml5chrome

表现

如果你使用chrome或者firefox等浏览器访问本博客、github.com、plus.google.com等网站时,细心的你会发现页面之间的点击是通过ajax异步请求的,同时页面的URL发生了了改变。并且能够很好的支持浏览器前进和后退。

是什么有这么强大的功能呢?

HTML5里引用了新的API,history.pushState和history.replaceState,就是通过

- centos中文乱码

AILIKES

centosOSssh

一、CentOS系统访问 g.cn ,发现中文乱码。

于是用以前的方式:yum -y install fonts-chinese

CentOS系统安装后,还是不能显示中文字体。我使用 gedit 编辑源码,其中文注释也为乱码。

后来,终于找到以下方法可以解决,需要两个中文支持的包:

fonts-chinese-3.02-12.

- 触发器

baalwolf

触发器

触发器(trigger):监视某种情况,并触发某种操作。

触发器创建语法四要素:1.监视地点(table) 2.监视事件(insert/update/delete) 3.触发时间(after/before) 4.触发事件(insert/update/delete)

语法:

create trigger triggerName

after/before

- JS正则表达式的i m g

bijian1013

JavaScript正则表达式

g:表示全局(global)模式,即模式将被应用于所有字符串,而非在发现第一个匹配项时立即停止。 i:表示不区分大小写(case-insensitive)模式,即在确定匹配项时忽略模式与字符串的大小写。 m:表示

- HTML5模式和Hashbang模式

bijian1013

JavaScriptAngularJSHashbang模式HTML5模式

我们可以用$locationProvider来配置$location服务(可以采用注入的方式,就像AngularJS中其他所有东西一样)。这里provider的两个参数很有意思,介绍如下。

html5Mode

一个布尔值,标识$location服务是否运行在HTML5模式下。

ha

- [Maven学习笔记六]Maven生命周期

bit1129

maven

从mvn test的输出开始说起

当我们在user-core中执行mvn test时,执行的输出如下:

/software/devsoftware/jdk1.7.0_55/bin/java -Dmaven.home=/software/devsoftware/apache-maven-3.2.1 -Dclassworlds.conf=/software/devs

- 【Hadoop七】基于Yarn的Hadoop Map Reduce容错

bit1129

hadoop

运行于Yarn的Map Reduce作业,可能发生失败的点包括

Task Failure

Application Master Failure

Node Manager Failure

Resource Manager Failure

1. Task Failure

任务执行过程中产生的异常和JVM的意外终止会汇报给Application Master。僵死的任务也会被A

- 记一次数据推送的异常解决端口解决

ronin47

记一次数据推送的异常解决

需求:从db获取数据然后推送到B

程序开发完成,上jboss,刚开始报了很多错,逐一解决,可最后显示连接不到数据库。机房的同事说可以ping 通。

自已画了个图,逐一排除,把linux 防火墙 和 setenforce 设置最低。

service iptables stop

- 巧用视错觉-UI更有趣

brotherlamp

UIui视频ui教程ui自学ui资料

我们每个人在生活中都曾感受过视错觉(optical illusion)的魅力。

视错觉现象是双眼跟我们开的一个玩笑,而我们往往还心甘情愿地接受我们看到的假象。其实不止如此,视觉错现象的背后还有一个重要的科学原理——格式塔原理。

格式塔原理解释了人们如何以视觉方式感觉物体,以及图像的结构,视角,大小等要素是如何影响我们的视觉的。

在下面这篇文章中,我们首先会简单介绍一下格式塔原理中的基本概念,

- 线段树-poj1177-N个矩形求边长(离散化+扫描线)

bylijinnan

数据结构算法线段树

package com.ljn.base;

import java.util.Arrays;

import java.util.Comparator;

import java.util.Set;

import java.util.TreeSet;

/**

* POJ 1177 (线段树+离散化+扫描线),题目链接为http://poj.org/problem?id=1177

- HTTP协议详解

chicony

http协议

引言

- Scala设计模式

chenchao051

设计模式scala

Scala设计模式

我的话: 在国外网站上看到一篇文章,里面详细描述了很多设计模式,并且用Java及Scala两种语言描述,清晰的让我们看到各种常规的设计模式,在Scala中是如何在语言特性层面直接支持的。基于文章很nice,我利用今天的空闲时间将其翻译,希望大家能一起学习,讨论。翻译

- 安装mysql

daizj

mysql安装

安装mysql

(1)删除linux上已经安装的mysql相关库信息。rpm -e xxxxxxx --nodeps (强制删除)

执行命令rpm -qa |grep mysql 检查是否删除干净

(2)执行命令 rpm -i MySQL-server-5.5.31-2.el

- HTTP状态码大全

dcj3sjt126com

http状态码

完整的 HTTP 1.1规范说明书来自于RFC 2616,你可以在http://www.talentdigger.cn/home/link.php?url=d3d3LnJmYy1lZGl0b3Iub3JnLw%3D%3D在线查阅。HTTP 1.1的状态码被标记为新特性,因为许多浏览器只支持 HTTP 1.0。你应只把状态码发送给支持 HTTP 1.1的客户端,支持协议版本可以通过调用request

- asihttprequest上传图片

dcj3sjt126com

ASIHTTPRequest

NSURL *url =@"yourURL";

ASIFormDataRequest*currentRequest =[ASIFormDataRequest requestWithURL:url];

[currentRequest setPostFormat:ASIMultipartFormDataPostFormat];[currentRequest se

- C语言中,关键字static的作用

e200702084

C++cC#

在C语言中,关键字static有三个明显的作用:

1)在函数体,局部的static变量。生存期为程序的整个生命周期,(它存活多长时间);作用域却在函数体内(它在什么地方能被访问(空间))。

一个被声明为静态的变量在这一函数被调用过程中维持其值不变。因为它分配在静态存储区,函数调用结束后并不释放单元,但是在其它的作用域的无法访问。当再次调用这个函数时,这个局部的静态变量还存活,而且用在它的访

- win7/8使用curl

geeksun

win7

1. WIN7/8下要使用curl,需要下载curl-7.20.0-win64-ssl-sspi.zip和Win64OpenSSL_Light-1_0_2d.exe。 下载地址:

http://curl.haxx.se/download.html 请选择不带SSL的版本,否则还需要安装SSL的支持包 2. 可以给Windows增加c

- Creating a Shared Repository; Users Sharing The Repository

hongtoushizi

git

转载自:

http://www.gitguys.com/topics/creating-a-shared-repository-users-sharing-the-repository/ Commands discussed in this section:

git init –bare

git clone

git remote

git pull

git p

- Java实现字符串反转的8种或9种方法

Josh_Persistence

异或反转递归反转二分交换反转java字符串反转栈反转

注:对于第7种使用异或的方式来实现字符串的反转,如果不太看得明白的,可以参照另一篇博客:

http://josh-persistence.iteye.com/blog/2205768

/**

*

*/

package com.wsheng.aggregator.algorithm.string;

import java.util.Stack;

/**

- 代码实现任意容量倒水问题

home198979

PHP算法倒水

形象化设计模式实战 HELLO!架构 redis命令源码解析

倒水问题:有两个杯子,一个A升,一个B升,水有无限多,现要求利用这两杯子装C

- Druid datasource

zhb8015

druid

推荐大家使用数据库连接池 DruidDataSource. http://code.alibabatech.com/wiki/display/Druid/DruidDataSource DruidDataSource经过阿里巴巴数百个应用一年多生产环境运行验证,稳定可靠。 它最重要的特点是:监控、扩展和性能。 下载和Maven配置看这里: http

- 两种启动监听器ApplicationListener和ServletContextListener

spjich

javaspring框架

引言:有时候需要在项目初始化的时候进行一系列工作,比如初始化一个线程池,初始化配置文件,初始化缓存等等,这时候就需要用到启动监听器,下面分别介绍一下两种常用的项目启动监听器

ServletContextListener

特点: 依赖于sevlet容器,需要配置web.xml

使用方法:

public class StartListener implements

- JavaScript Rounding Methods of the Math object

何不笑

JavaScriptMath

The next group of methods has to do with rounding decimal values into integers. Three methods — Math.ceil(), Math.floor(), and Math.round() — handle rounding in differen