一文详细介绍NeurIPS论文高引量的TOP10明星学者!!!

NeurIPS2019即将于12月8日(本周日)在加拿大温哥华举办,NeurIPS是人工智能和机器学习领域的国际顶级会议,由NIPS基金会负责运营。该会议全称为神经信息处理系统大会(Conference and Workshop on Neural Information Processing Systems,NIPS),自1987年开始,每年的12月份,来自世界各地的从事AI和ML相关的专家学者和从业人士汇聚一堂。受其名称歧义带来的压力(部分原因是其首字母缩写具有「暧昧的内涵」,带有性别歧视的意义),2018年的会议名称改为NeurIPS 。

最近通过对NeurIPS近十年接收论文引用量的统计分析,我们评选出了NeurIPS高引学者TOP100榜单。下面我们主要来介绍以下TOP10的NeurIPS明星学者!!!

包揽高引学者榜单前三甲的正是“神经网络之父” Geoffrey Hinton与他的高徒Ilya Sutskever、Alex Krizhevsky。

排在高引学者榜单第二位的Geoffrey Hinton,是深度学习的泰斗,被人们誉为“人工智能教父”,他的名字在当今的人工智能研究界可谓是如雷贯耳。他曾发明了玻尔兹曼机(Boltzmann machine),也首先将反向传播(Backpropagation)应用于多层神经网络;不仅如此,他还有 Yann LeCun 和 Ilya Sutskever 等大牛级的学生。

Hinton在剑桥大学获得实验心理学学士学位,在爱丁堡大学获得人工智能博士学位。现任Google副总裁兼工程研究员,同时在多伦多大学教书育人,也是VectorInstitute首席科学顾问。在2012年,Hinton还获得了加拿大基廉奖(Killam Prizes,有“加拿大诺贝尔奖”之称的国家最高科学奖)。

Hinton教授是机器学习的开创者,使得计算机可以独立想出程序、自己解决问题。特别重要的是,他还从中开辟了机器学习的一个子领域,即所谓的“深度学习”,也就是让那些机器像一个蹒跚学步的孩子一样,模仿大脑的神经网络形式进行学习。他将神经网络带入到研究与应用的热潮,将“深度学习”从边缘课题变成了谷歌等互联网巨头仰赖的核心技术。

Hinton自NeurIPS创办以来的三十多年间,共发表了60篇论文,几乎每年都有成果产出。而在2009年至2019年间,Hinton在NeurIPS共发表了16篇论文,引用量达47482次。

正可谓青出于蓝而胜于蓝, 排在榜首的Ilya Sutskever不仅是Hinton的博士生,还是吴恩达的博后,他曾是谷歌的顶级人工智能专家,后来创办了人工智能非盈利公司——OpenAI。

Sutskever的H-index值为56,在2015 年他被麻省理工学院技术评论评为Visionaries 类别「35 岁以下创新者」。

十年间,他虽只在NeurIPS发表了11篇文章,但引用量高达67457次,位于高引学者榜单首位。

对计算机非常痴迷的Sutskever本科就读于多伦多大学。在大学期间,他遇到了Hinton教授。Hinton 给了他一个研究项目:改进随机邻居嵌入算法。该项目正是他们合作的开始,接下来Sutskever顺理成章地加入了Hinton的小组攻读博士学位。

2012年毕业后,Sutskever在斯坦福大学跟随吴恩达教授读了两个月的博士后。然后他回到了多伦多大学并加入了Hinton创立的研究公司 DNNResearch。四个月后,Google 收购了 DNNResearch,而Sutskever至此正式加入Google Brain 。

在谷歌的两年间, Sutskever曾加入过 Google 开源库,开发了深度学习框架TensorFlow。他还协助DeepMind开发了划时代的围棋人工智能 AlphaGo,而关于AlphaGo 的论文于2016 年在Nature上发表,Sutskever 是合著者之一。

2015年12月,Sutskever离开谷歌,和Greg Brockman(现为 OpenAI 首席技术官)共同创立了 OpenAI。OpenAI 的目标是希望向所有人开放人工智能技术,在过去的几年间OpenAI取得了许多惊人的成就。Sutskever则一直站在人工智能革命的最前沿,和他的团队一起推动实现强人工智能的终极高峰。

排在榜单第三位的Alex Krizhevsky,同样作为Hinton的博士生,Alex似乎显得更为低调,网上也鲜有他的资料。

2012 年,在Hinton的指导下,Alex Krizhevsky和Sutskever 合作开发了 轰动一时的AlexNet。这篇题为《ImageNet Classification with Deep Convolutional Neural Networks》的论文,引用量高达44218次。这也是Alex 在NeurIPS发表的唯一论文。

AlexNet以一种新颖的神经网络架构在NeurIPS亮相,包含五个卷积层和三个全连接层。这篇论文被广泛认为是一项真正的开创性工作,因为它首次证明了在GPU上训练的深度神经网络可以将图像识别任务提升到一个新的水平。

AlexNet网络对神经网络的发展产生了非常重要的影响,之后的ImageNet冠军全都采用了卷积神经网络结构,使得CNN架构成为图像分类的核心模型,并由此开启了深度学习新一波浪潮,其使用的卷积+池化+全连接的架构仍然是当前深度学习最主要的网络结构。

自那之后,Alex似乎沉寂起来。他曾同Hinton教授和Sutskever 共同创办了初创公司 DNNresearch,他们开发出了可以大幅改善目标辨识技术的解决方案。后来Alex和Sutskever共同加入了谷歌。

再后来,Alex加入了加拿大创业公司Dessa ,担任Dessa的首席机器学习架构师。而就在今年年初,Dessa开发了一个语音合成系统RealTalk,与以往基于语音输入学习人声的系统不同,它可以仅基于文本输入生成完美逼近真人的声音。

排在榜单第四位的是“人工智能三巨头”之一的Yoshua Bengio,他同Geoffrey Hinton、Yann LeCun同获2018年图灵奖。

Yoshua Bengio是人工智能自然语言处理领域的先锋。Bengio,1964年出生于法国,成长于加拿大,现居蒙特利尔,在蒙特利尔大学(University of Montreal)计算机科学与运算系任教授。Bengio在麦吉尔大学获得计算机科学博士学位。他与Geoffrey Hinton、Yann LeCun一起被认为是20世纪90年代和21世纪初期推动深度学习的三个人。2016年10月,Bengio联合创立了一个位于蒙特利尔的人工智能孵化器Element AI。

Bengio也是三人中最看重学术纯粹性的。在微软担任顾问的同时,他还是CIFAR机器与大脑学习项目的联合主任,加拿大计算机科学与运筹学系的全职教授,也是蒙特利尔大学统计学习算法研究主席。

在NeurIPS会议上,Bengio一共发表了74篇论文,尤其在今年的会议上,有 Bengio署名的论文就有9篇。

在过去的十年间,他在NeurIPS共发表了40篇文章,引用量达18714次。

其中引用量最高的是发表于2014年,同他的博士生Ian Goodfellow合著的《Generative Adversarial Nets》一文,引用量达10618次,这篇文章提出了著名的生成对抗网络(GANs)。

它是一种能“教会”计算机胜任人类工作的有趣方法。过去五年,GANs在图像生成领域取得了重大突破,现在可以生成动物、风景以及人脸等高度逼真的合成图像,充分展示了“无监督学习”技术的潜力。

同时它在理论层面解决了机器学习技术长久以来的问题:如何促使机器学习的训练成果向着人类希望的方向前进。2015年时,GANs技术还名不见经传,2016年就达到了无处不在的火爆程度,甚至被专家称为“机器学习领域20年来最酷的想法”。

说到了GANs,那就不得不说Ian Goodfellow–“GANs之父”。他位于高引学者榜单的第九位,十年间他在NeurIPS共发表了10篇论文,总引用量达13480次。

Goodfellow是机器学习领域备受关注的年轻学者之一,本科与硕士就读于斯坦福大学,师从吴恩达,博士阶段则跟随Yoshua Bengio研究机器学习。他最引人注目的成就是在 2014 年 6 月提出了生成对抗网络(GANs)。

毕业后,Goodfellow加入Google,成为Google Brain研究团队的一员。然后他离开谷歌加入新成立的OpenAI研究所,在2017年3月他又回到谷歌研究院。就在今年4月,Ian Goodfellow加入苹果公司担任总监级别职务,在苹果公司领导一个「机器学习特殊项目组」。

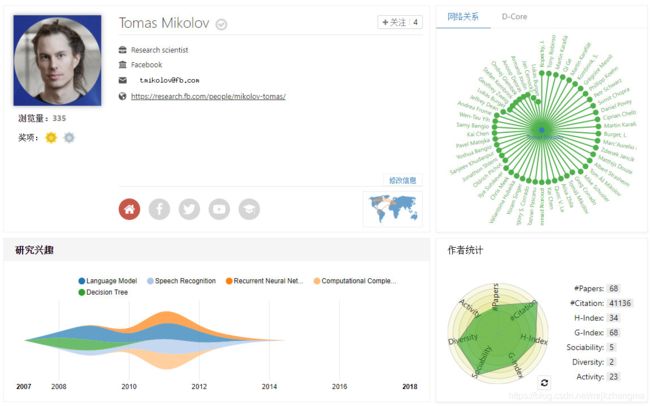

位于高引学者榜单第五至第八位的学者,是来自谷歌的Greg Corrado、Jeffrey Dean、Kai Chen、Tomas Mikolov。

Greg Corrado、Jeffrey Dean十年间在NeurIPS各发表了3篇文章,总引用量为17218次。Tomas Mikolov也发表了3篇文章,总引用量为15407。Kai Chen发文两篇,总引用量为16139次。

他们与Ilya Sutskever于2013年共同发表了《Distributed Representations of Words and Phrases and their Compositionality》一文,引用量达14087次。

这篇论文是对《Efficient Estimation of Word Representations in Vector Space》的补充,介绍了使用Skip-gram模型和Hierarchical Softmax训练模式的训练方法,并补充了Negative Sampling的训练模式替代Negative Sampling,获得更快的训练效果。论文还提出了对高频词进行二次抽样的方法,以及衡量短语的方法,学习短语的表示。

Greg Corrado是Google机器学习资深研究科学家,主要研究方向为人工智能、计算神经科学和可扩展机器学习,也是Google Brain项目的创始人之一。

谷歌人工智能大神Jeff Dean,是谷歌的首席架构师、谷歌研究院的高级研究员,也是谷歌的人工智能团队谷歌大脑(Google Brain)的负责人。身披华盛顿大学博士、美国工程院院士、ACM Fellow、清华大学AI研究院计算机学科顾问、AAAS Fellow等名誉的Jeff Dean在谷歌负责过许多大型项目,支持谷歌运行的超大规模计算框架MapReduce和机器学习的标志性软件TensorFlow就是在他的领导下开发的。

Tomas Mikolov曾在谷歌工作,目前是Facebook人工智能研究实验室的科学家。他也是一位产出多篇高质量paper的学者,从RNNLM、Word2Vec再到最近流行的FastText都与他息息相关。

排在第十位的是计算机视觉大神、Facebook AI研究科学家何恺明。他的研究方向为计算机视觉和深度学习。十年间他在NeurIPS共发表过3篇论文,总引用量为12605次。

最有名的一篇是发表于2015年的《Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks》一文,引用量达11093次。

在这份TOP100榜单中,还有更多机器学习领域大神级人物的存在,比如机器学习之父、美国三院院士、伯克利教授Michael I.Jordan,苹果首任AI总监Ruslan Salakhutdinov等等,虽然我们没有一一写到,但并不能否认他们在机器学习领域无人能及的地位。

为了更便于大家了解和掌握NeurIPS2019的最新信息与动态,请大家关注微信公众号 “深度学习技术前沿”,第一时间内为大家发布最新讯息!!!