- 自定义分区

我的K8409

Hadoophdfshadoop大数据

通过简单例子了解partition分区类的重写方法分区是在MR的过程中进行的,属于Shuffle阶段但是在Job端不要忘记进行调用:job.setPartitionerClass(xxx.class)按照年龄分区:classAgePartitionerextendsPartitioner{@OverridepublicintgetPartition(MyComparablekey,NullWrit

- 一文搞懂 Flink Task 数据交互之数据写源码

mn_kw

flink交互java

一文搞懂FlinkTask数据交互之数据写源码1.RecordWriterOutput2.RecordWriter3.数据分区器ChannelSelector4.数据输出模型ResultPartition5.子模型ResultSubpartition6.本地buffer池LocalBufferPool7.获取buffer8.将buffer添加到ResultSubpartitionFlink重要源码

- Kafka系列之:kafka命令详细总结

快乐骑行^_^

日常分享专栏KafkaKafka系列kafka命令详细总结

Kafka系列之:kafka命令详细总结一、添加和删除topic二、修改topic三、平衡领导者四、检查消费者位置五、管理消费者群体一、添加和删除topicbin/kafka-topics.sh--bootstrap-serverbroker_host:port--create--topicmy_topic_name\--partitions20--replication-factor3--con

- ROW_NUMBER()

向日葵般的数学人~

SQLsql

ROW_NUMBER()OVER(PARTITIONBY...ORDERBY...)是一个窗口函数,用于生成每个分组内的唯一行号。这个函数非常适合在分组数据中进行排序,并为每一行分配一个序号。下面是对你的具体示例的详细解释:ROW_NUMBER()OVER(PARTITIONBYMONTH(p.fdate)ORDERBYCOUNT(p.user_id)DESC,s.song_id)ASsong_r

- Kafka的ack机制

香山上的麻雀

ack=0/1/-1的不同情况:0:producer不等待broker的ack,broker一接收到还没有写入磁盘就已经返回,当broker故障时有可能丢失数据;1:producer等待broker的ack,partition的leader落盘成功后返回ack,如果在follower同步成功之前leader故障,那么将会丢失数据;-1:producer等待broker的ack,partition的

- Online Conversion of a Non-Partitioned Table to a Partitioned Table in Oracle Database 12c Release 2

IT皮特

数据库oracle

从12.2开始,通过MODIFYTABLE可以在线实现普通表转分区表。一、创建测试表:DROPTABLEt1PURGE;CREATETABLEt1(idNUMBER,descriptionVARCHAR2(50),created_dateDATE,CONSTRAINTt1_pkPRIMARYKEY(id));CREATEINDEXt1_created_date_idxONt1(created_da

- Kafka 实战 - Kafka分区和副本机制理解

用心去追梦

kafka分布式

ApacheKafka的分区(Partition)和副本(Replica)机制是其核心架构和可靠性保证的关键组成部分。以下是对其理解的详细解释:分区(Partition)分区概念:在Kafka中,每个主题(Topic)可以被划分为多个分区。分区是一个有序的、不可变的消息序列。这意味着消息在分区中按生成顺序存储,每个消息都有一个唯一的偏移量(Offset)。目的:分区的主要目的是为了水平扩展和并行处

- 分区Partition

DashVector

embedding数据库python人工智能数据挖掘

理解Partition向量检索服务DashVector的Collection具有分区(Partition)的能力,同一个Collection下的Doc可通过不同的Partition进行物理和逻辑上的分区。各种Doc操作(如插入Doc、检索Doc等)若指定Partition,则该操作将限定在该指定的Paritition内进行。通过合理的Partition设置,可有效提升Doc操作的效率。同一个Col

- 老版本kafka查询topic消费情况(python查询)

代码是谁

kafkapython分布式

由于老版本的kafka缺少shell,导致无法通过命令直接进行查询,所以通过python代码,实现消费情况查询安装必须的包#pyhon2.5pipinstallkafka-python==1.4.7python脚本#!/usr/bin/envpythonimportsysfromkafkaimportKafkaConsumer,TopicPartitioniflen(sys.argv)!=2:pr

- hive表格统计信息不准确

weixin_41956627

hivehivehadoop数据仓库

问题描述有个hive分区表,orc存储格式,有个分区,查询selectcount(1)fromtablewheredt='yyyyMMdd'结果是0,但查询select*fromtablewheredt='yyyyMMdd'又能查到数据,去hdfs对应目录下查看,也能看到有数据文件解决执行如下sqlANALYZETABLEdb.table1PARTITION(dt='20240908')COMPU

- Hadoop之mapreduce -- WrodCount案例以及各种概念

lzhlizihang

hadoopmapreduce大数据

文章目录一、MapReduce的优缺点二、MapReduce案例--WordCount1、导包2、Mapper方法3、Partitioner方法(自定义分区器)4、reducer方法5、driver(main方法)6、Writable(手机流量统计案例的实体类)三、关于片和块1、什么是片,什么是块?2、mapreduce启动多少个MapTask任务?四、MapReduce的原理五、Shuffle过

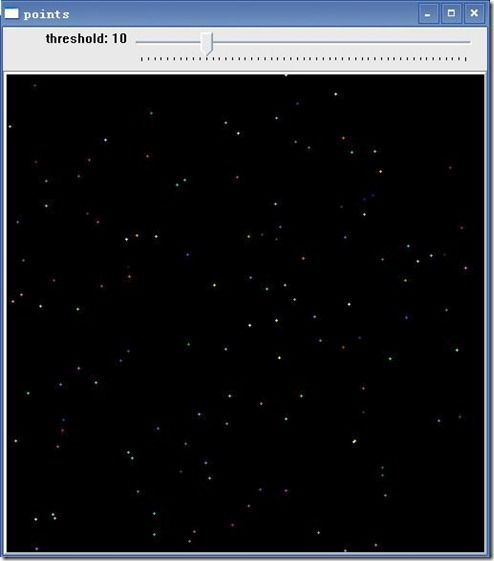

- python产生随机整数数组_生成随机整数数组

长迦

python产生随机整数数组

这是一个精确的(每个合法的和都有相同的概率)解。它使用所有合法和的枚举,并不是说我们要遍历每个和,而是给定一个数字n,我们可以直接计算枚举中的第n个和。由于我们也知道合法和的总数,我们可以简单地画出统一的整数并对其进行转换:importnumpyasnpimportfunctoolsasft#

[email protected]_cache(None)defcapped_pc(N,k,m):

- Spring Cloud全解析:注册中心之Eureka架构介绍

拾光师

springcloudjava

Eureka架构介绍Eureka在设计时采用的是AP原则,是Netflix的一个子模块,用于微服务的服务注册与发现P:Partitiontolerance,网络分区容错。类似多机房部署,保证服务稳定性A:Availability,可用性C:Consistency,一致性对于任意一个系统只能同时满足两个,一个分布式系统不可能同时很好的满足一致性、可用性和分区容错性CA单点集群,满足一致性和可用性,在

- Kafka是如何实现高性能的

明斯克开源

Java经验分享架构java

将写磁盘的过程变为顺序写Kafka的整个设计中,Partition相当于一个非常长的数组,而Broker接收到的所有消息顺序写入这个大数组中。同时Consumer通过Offset顺序消费这些数据,并且不删除已经消费的数据,从而避免了随机写磁盘的过程。由于磁盘有限,不可能保存所有数据,实际上作为消息系统Kafka也没必要保存所有数据,需要删除旧的数据。而这个删除过程,并非通过使用“读-写”模式去修改

- ClickHouse实战处理(一):MergeTree系列引擎

sheep8521

clickhouse数据库大数据

MergeTree作为家族系列最基础的表引擎,主要有以下特点:存储的数据按照主键排序:创建稀疏索引加快数据查询速度。支持数据分区,可以通过PARTITIONBY语句指定分区字段。支持数据副本。支持数据采样。总之适用于高负载任务的最通用和功能最强大的表引擎。可以快速插入数据并进行后续的后台数据处理。支持数据复制(使用Replicated*的引擎版本)、分区和其他引擎不支持的特性MergeTree系列

- 【Hot100】LeetCode—215. 数组中的第K个最大元素

山脚ice

#Hot100leetcode算法

目录1-思路快速选择2-实现⭐215.数组中的第K个最大元素——题解思路3-ACM实现原题连接:215.数组中的第K个最大元素1-思路快速选择第k大的元素的数组下标:inttarget=nums.length-k1-根据partition分割的区间来判断当前处理方式如果返回的int等于target说明找到了,直接返回如果返回的int小于target说明要在当前区间的右侧寻找,也就是[pivotIn

- pairwise

chanTwo_00

数据结构开发语言

pairwise是itertools模块中的一个函数,它用于生成输入序列中相邻元素的配对。在Python3.10中被引入。可以使用pairwise来简化查找相邻元素差值的代码fromitertoolsimportpairwiseclassSolution:deffindValueOfPartition(self,nums:List[int])->int:nums.sort()min_differe

- Python酷库之旅-第三方库Pandas(081)

神奇夜光杯

pythonpandas开发语言人工智能标准库及第三方库excel学习与成长

目录一、用法精讲336、pandas.Series.str.rpartition方法336-1、语法336-2、参数336-3、功能336-4、返回值336-5、说明336-6、用法336-6-1、数据准备336-6-2、代码示例336-6-3、结果输出337、pandas.Series.str.slice方法337-1、语法337-2、参数337-3、功能337-4、返回值337-5、说明337

- Kafka Broker处于高负载状态(例如消息处理量大或系统资源不足),无法及时响应消费者的请求

战族狼魂

消息队列javakafka分布式

Causedby:org.apache.kafka.common.errors.TimeoutException:Timeoutof60000msexpiredbeforethepositionforpartitionactivity-0couldbedetermined。出现这个错误的原因是Kafka消费者在尝试获取分区(activity-0)的位置信息时,超时了。在60秒内无法确定该分区的最新

- 大数据秋招面经之spark系列

wq17629260466

大数据spark

文章目录前言spark高频面试题汇总1.spark介绍2.spark分组取TopN方案总结:方案2是最佳方案。3.repartition与coalesce4.spark的oom问题怎么产生的以及解决方案5.storm与flink,sparkstreaming之间的区别6.spark的几种部署方式:7.复习spark的yarn-cluster模式执行流程:8.spark的job提交流程:9.spar

- 【笔记】Explain执行计划怎么看

寻梦的小柳

来源来源当Explain与SQL语句一起使用时,MySQL会显示来自优化器关于SQL执行的信息。也就是说,MySQL解释了它将如何处理该语句,包括如何连接表以及什么顺序连接表等。Explain执行计划包含字段信息如下:分别是id、select_type、table、partitions、type、possible_keys、key、key_len、ref、rows、filtered、Extra12

- Kafka-设计原理

姜希成

Kafkakafka

ControllerLeader-PartitionRebalance消息发布机制HW与LEO日志分段ControllerKafka核心总控制器Controller:在Kafka集群中会有一个或者多个broker,其中有一个broker会被选举为控制器(KafkaController),它负责管理整个集群中所有分区和副本的状态当某个分区的leader副本出现故障时,由控制器负责为该分区选举新的le

- Java 7.1 - 理论 & 算法 & 协议

没有韭菜的饺子

java开发语言

什么是CAP理论?C:Consistency一致性A:Availability可用性P:Partition分区容错性对于理论计算机科学,CAP定理指出,对于一个分布式系统而言,CAP中的三个只能同时满足两个。分区容错性:分布式系统出现网络分区的时候,仍然可以向外提供服务。*网络分区分布式系统中,多个节点之间的网络本来是相连的。但现在因为某些原因,某些节点之间不再连通,网络会被分成多个区域,这就叫网

- 关于PostgreSQL的分区表的历史及分区裁剪参数enable_partition_pruning与constraint_exclusion的区别

胖胖小李胡

postgresqlpostgresql数据库

1.疑惑我们知道控制分区裁剪的参数有两个:enable_partition_pruningconstraint_exclusion这两个参数有什么区别呢?2.解答要说明这两个参数的区别需要先讲一讲PostgreSQL数据库中分区的历史,在PostgreSQL10版本之前,PostgreSQL数据库实际上是没有单独的创建分区表的DDL语句,都是通过表继承的原理来创建分区表,这样使得在PostgreS

- 132. Palindrome Partitioning II (Hard)

Ysgc

Description:Givenastrings,partitionssuchthateverysubstringofthepartitionisapalindrome.Returntheminimumcutsneededforapalindromepartitioningofs.Example:Input:"aab"Output:1Explanation:Thepalindromepartit

- Kafka~Kafka命令行参数使用教程

飞Link

大数据kafkazookeeper分布式

一、kafka-topics.sh1.参数参数描述–bootstrap-server连接的KafkaBroker主机名称和端口号–topic操作的topic名称–create创建主题–delete删除主题–alter修改主题–list查看所有主题–describe查看主题详细描述–partition设置分区数–replication-factor设置分区副本–config更新系统默认的配置2.实例

- 【openGauss5.0.0版本】分区表新增的特性 - 示例

若兰幽竹

openGaussopenGauss

openGauss5.0.0版本中,List和range分区新增功能如下:List分区键最大数由1扩展为16列:createtabletp16(c1int,c2int,c3int,c4int,c5int,c6int,c7int,c8int,c9int,c10int,c11int,c12int,c13int,c14int,c15int,c16int)partitionbylist(c1,c2,c3,

- hive学习(五)

2301_79721847

hive学习hadoop

一、hive的DML操作1.load(向表中装载数据)hive>loaddata[local]inpath'路径'[overwrite]intotable表名[partition(partcol1=val1,…)];特殊说明1)local:标识从本地加载数据到Hive表,若没有local的话从HDFS加载数据到Hive表2)overwrite:表示覆盖原有数据,若没有追加在原有数据上3)若目标是分

- hive学习(四)

2301_79721847

hive学习hadoop

一、分区表的数据导入1.静态分区(需要手动指定分区字段的值)直接将文件数据导入到分区表语法:loaddata[local]inpath'filepath'intotabletablenamepartition(分区字段1='分区值1',分区字段2='分区值2'...);loaddata[local]inpath'/root/hive/data/c.txtintotablenickypartitio

- VirtualBox Debian 自动安装脚本

入秋的大橘

开发问题解决Linux开发环境debianchrome运维

概览相较于原脚本(安装目录/UnattendedTemplates/debian_pressed.cfg)更新如下内容:配置清华镜像源配置仅主机网卡(后续只需添加仅主机网卡即可)配置Root用户远程登录配置用户sudo组脚本debian_pressed.cfg###Partitioningd-ipartman-auto/diskstring/dev/sdad-ipartman-auto/metho

- rust的指针作为函数返回值是直接传递,还是先销毁后创建?

wudixiaotie

返回值

这是我自己想到的问题,结果去知呼提问,还没等别人回答, 我自己就想到方法实验了。。

fn main() {

let mut a = 34;

println!("a's addr:{:p}", &a);

let p = &mut a;

println!("p's addr:{:p}", &a

- java编程思想 -- 数据的初始化

百合不是茶

java数据的初始化

1.使用构造器确保数据初始化

/*

*在ReckInitDemo类中创建Reck的对象

*/

public class ReckInitDemo {

public static void main(String[] args) {

//创建Reck对象

new Reck();

}

}

- [航天与宇宙]为什么发射和回收航天器有档期

comsci

地球的大气层中有一个时空屏蔽层,这个层次会不定时的出现,如果该时空屏蔽层出现,那么将导致外层空间进入的任何物体被摧毁,而从地面发射到太空的飞船也将被摧毁...

所以,航天发射和飞船回收都需要等待这个时空屏蔽层消失之后,再进行

&

- linux下批量替换文件内容

商人shang

linux替换

1、网络上现成的资料

格式: sed -i "s/查找字段/替换字段/g" `grep 查找字段 -rl 路径`

linux sed 批量替换多个文件中的字符串

sed -i "s/oldstring/newstring/g" `grep oldstring -rl yourdir`

例如:替换/home下所有文件中的www.admi

- 网页在线天气预报

oloz

天气预报

网页在线调用天气预报

<%@ page language="java" contentType="text/html; charset=utf-8"

pageEncoding="utf-8"%>

<!DOCTYPE html PUBLIC "-//W3C//DTD HTML 4.01 Transit

- SpringMVC和Struts2比较

杨白白

springMVC

1. 入口

spring mvc的入口是servlet,而struts2是filter(这里要指出,filter和servlet是不同的。以前认为filter是servlet的一种特殊),这样就导致了二者的机制不同,这里就牵涉到servlet和filter的区别了。

参见:http://blog.csdn.net/zs15932616453/article/details/8832343

2

- refuse copy, lazy girl!

小桔子

copy

妹妹坐船头啊啊啊啊!都打算一点点琢磨呢。文字编辑也写了基本功能了。。今天查资料,结果查到了人家写得完完整整的。我清楚的认识到:

1.那是我自己觉得写不出的高度

2.如果直接拿来用,很快就能解决问题

3.然后就是抄咩~~

4.肿么可以这样子,都不想写了今儿个,留着作参考吧!拒绝大抄特抄,慢慢一点点写!

- apache与php整合

aichenglong

php apache web

一 apache web服务器

1 apeche web服务器的安装

1)下载Apache web服务器

2)配置域名(如果需要使用要在DNS上注册)

3)测试安装访问http://localhost/验证是否安装成功

2 apache管理

1)service.msc进行图形化管理

2)命令管理,配

- Maven常用内置变量

AILIKES

maven

Built-in properties

${basedir} represents the directory containing pom.xml

${version} equivalent to ${project.version} (deprecated: ${pom.version})

Pom/Project properties

Al

- java的类和对象

百合不是茶

JAVA面向对象 类 对象

java中的类:

java是面向对象的语言,解决问题的核心就是将问题看成是一个类,使用类来解决

java使用 class 类名 来创建类 ,在Java中类名要求和构造方法,Java的文件名是一样的

创建一个A类:

class A{

}

java中的类:将某两个事物有联系的属性包装在一个类中,再通

- JS控制页面输入框为只读

bijian1013

JavaScript

在WEB应用开发当中,增、删除、改、查功能必不可少,为了减少以后维护的工作量,我们一般都只做一份页面,通过传入的参数控制其是新增、修改或者查看。而修改时需将待修改的信息从后台取到并显示出来,实际上就是查看的过程,唯一的区别是修改时,页面上所有的信息能修改,而查看页面上的信息不能修改。因此完全可以将其合并,但通过前端JS将查看页面的所有信息控制为只读,在信息量非常大时,就比较麻烦。

- AngularJS与服务器交互

bijian1013

JavaScriptAngularJS$http

对于AJAX应用(使用XMLHttpRequests)来说,向服务器发起请求的传统方式是:获取一个XMLHttpRequest对象的引用、发起请求、读取响应、检查状态码,最后处理服务端的响应。整个过程示例如下:

var xmlhttp = new XMLHttpRequest();

xmlhttp.onreadystatechange

- [Maven学习笔记八]Maven常用插件应用

bit1129

maven

常用插件及其用法位于:http://maven.apache.org/plugins/

1. Jetty server plugin

2. Dependency copy plugin

3. Surefire Test plugin

4. Uber jar plugin

1. Jetty Pl

- 【Hive六】Hive用户自定义函数(UDF)

bit1129

自定义函数

1. 什么是Hive UDF

Hive是基于Hadoop中的MapReduce,提供HQL查询的数据仓库。Hive是一个很开放的系统,很多内容都支持用户定制,包括:

文件格式:Text File,Sequence File

内存中的数据格式: Java Integer/String, Hadoop IntWritable/Text

用户提供的 map/reduce 脚本:不管什么

- 杀掉nginx进程后丢失nginx.pid,如何重新启动nginx

ronin47

nginx 重启 pid丢失

nginx进程被意外关闭,使用nginx -s reload重启时报如下错误:nginx: [error] open() “/var/run/nginx.pid” failed (2: No such file or directory)这是因为nginx进程被杀死后pid丢失了,下一次再开启nginx -s reload时无法启动解决办法:nginx -s reload 只是用来告诉运行中的ng

- UI设计中我们为什么需要设计动效

brotherlamp

UIui教程ui视频ui资料ui自学

随着国际大品牌苹果和谷歌的引领,最近越来越多的国内公司开始关注动效设计了,越来越多的团队已经意识到动效在产品用户体验中的重要性了,更多的UI设计师们也开始投身动效设计领域。

但是说到底,我们到底为什么需要动效设计?或者说我们到底需要什么样的动效?做动效设计也有段时间了,于是尝试用一些案例,从产品本身出发来说说我所思考的动效设计。

一、加强体验舒适度

嗯,就是让用户更加爽更加爽的用你的产品。

- Spring中JdbcDaoSupport的DataSource注入问题

bylijinnan

javaspring

参考以下两篇文章:

http://www.mkyong.com/spring/spring-jdbctemplate-jdbcdaosupport-examples/

http://stackoverflow.com/questions/4762229/spring-ldap-invoking-setter-methods-in-beans-configuration

Sprin

- 数据库连接池的工作原理

chicony

数据库连接池

随着信息技术的高速发展与广泛应用,数据库技术在信息技术领域中的位置越来越重要,尤其是网络应用和电子商务的迅速发展,都需要数据库技术支持动 态Web站点的运行,而传统的开发模式是:首先在主程序(如Servlet、Beans)中建立数据库连接;然后进行SQL操作,对数据库中的对象进行查 询、修改和删除等操作;最后断开数据库连接。使用这种开发模式,对

- java 关键字

CrazyMizzz

java

关键字是事先定义的,有特别意义的标识符,有时又叫保留字。对于保留字,用户只能按照系统规定的方式使用,不能自行定义。

Java中的关键字按功能主要可以分为以下几类:

(1)访问修饰符

public,private,protected

p

- Hive中的排序语法

daizj

排序hiveorder byDISTRIBUTE BYsort by

Hive中的排序语法 2014.06.22 ORDER BY

hive中的ORDER BY语句和关系数据库中的sql语法相似。他会对查询结果做全局排序,这意味着所有的数据会传送到一个Reduce任务上,这样会导致在大数量的情况下,花费大量时间。

与数据库中 ORDER BY 的区别在于在hive.mapred.mode = strict模式下,必须指定 limit 否则执行会报错。

- 单态设计模式

dcj3sjt126com

设计模式

单例模式(Singleton)用于为一个类生成一个唯一的对象。最常用的地方是数据库连接。 使用单例模式生成一个对象后,该对象可以被其它众多对象所使用。

<?phpclass Example{ // 保存类实例在此属性中 private static&

- svn locked

dcj3sjt126com

Lock

post-commit hook failed (exit code 1) with output:

svn: E155004: Working copy 'D:\xx\xxx' locked

svn: E200031: sqlite: attempt to write a readonly database

svn: E200031: sqlite: attempt to write a

- ARM寄存器学习

e200702084

数据结构C++cC#F#

无论是学习哪一种处理器,首先需要明确的就是这种处理器的寄存器以及工作模式。

ARM有37个寄存器,其中31个通用寄存器,6个状态寄存器。

1、不分组寄存器(R0-R7)

不分组也就是说说,在所有的处理器模式下指的都时同一物理寄存器。在异常中断造成处理器模式切换时,由于不同的处理器模式使用一个名字相同的物理寄存器,就是

- 常用编码资料

gengzg

编码

List<UserInfo> list=GetUserS.GetUserList(11);

String json=JSON.toJSONString(list);

HashMap<Object,Object> hs=new HashMap<Object, Object>();

for(int i=0;i<10;i++)

{

- 进程 vs. 线程

hongtoushizi

线程linux进程

我们介绍了多进程和多线程,这是实现多任务最常用的两种方式。现在,我们来讨论一下这两种方式的优缺点。

首先,要实现多任务,通常我们会设计Master-Worker模式,Master负责分配任务,Worker负责执行任务,因此,多任务环境下,通常是一个Master,多个Worker。

如果用多进程实现Master-Worker,主进程就是Master,其他进程就是Worker。

如果用多线程实现

- Linux定时Job:crontab -e 与 /etc/crontab 的区别

Josh_Persistence

linuxcrontab

一、linux中的crotab中的指定的时间只有5个部分:* * * * *

分别表示:分钟,小时,日,月,星期,具体说来:

第一段 代表分钟 0—59

第二段 代表小时 0—23

第三段 代表日期 1—31

第四段 代表月份 1—12

第五段 代表星期几,0代表星期日 0—6

如:

*/1 * * * * 每分钟执行一次。

*

- KMP算法详解

hm4123660

数据结构C++算法字符串KMP

字符串模式匹配我们相信大家都有遇过,然而我们也习惯用简单匹配法(即Brute-Force算法),其基本思路就是一个个逐一对比下去,这也是我们大家熟知的方法,然而这种算法的效率并不高,但利于理解。

假设主串s="ababcabcacbab",模式串为t="

- 枚举类型的单例模式

zhb8015

单例模式

E.编写一个包含单个元素的枚举类型[极推荐]。代码如下:

public enum MaYun {himself; //定义一个枚举的元素,就代表MaYun的一个实例private String anotherField;MaYun() {//MaYun诞生要做的事情//这个方法也可以去掉。将构造时候需要做的事情放在instance赋值的时候:/** himself = MaYun() {*

- Kafka+Storm+HDFS

ssydxa219

storm

cd /myhome/usr/stormbin/storm nimbus &bin/storm supervisor &bin/storm ui &Kafka+Storm+HDFS整合实践kafka_2.9.2-0.8.1.1.tgzapache-storm-0.9.2-incubating.tar.gzKafka安装配置我们使用3台机器搭建Kafk

- Java获取本地服务器的IP

中华好儿孙

javaWeb获取服务器ip地址

System.out.println("getRequestURL:"+request.getRequestURL());

System.out.println("getLocalAddr:"+request.getLocalAddr());

System.out.println("getLocalPort:&quo