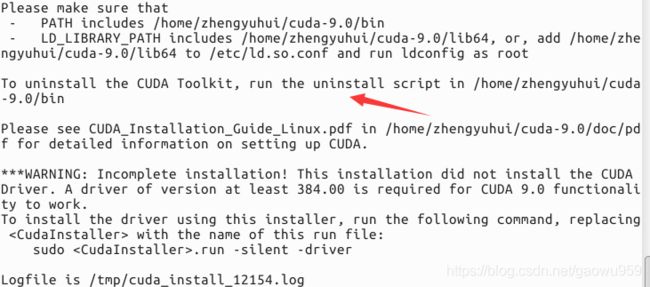

【续】深度学习软件安装(显卡为1080ti)CUDA8.0+cuDNN5.1+pytorch1.0.0

【CUDA8.0传送门】:

http://blog.csdn.net/masa_fish/article/details/51882183(亲测不可用)

参考:https://blog.csdn.net/u012235003/article/details/54575758(亲测可用,强烈推荐,网上的其他版本看似通过了测试其实cuDnn根本就没有起到加速作用)

sudo apt-get install freeglut3-dev build-essential libx11-dev libxmu-dev libxi-dev libgl1-mesa-glx libglu1-mesa libglu1-mesa-dev与网上版本不同的地方在于装cuda前需要装这些依赖

/usr/local/cuda/sample

注意:在cuda最后的make必须要编译全通过才能说明cuda装成功(对于make全通过而已,可能只是必要的,可能需要按照cuda里面指定的显卡驱动来按照)

【cuDNN5.1安装】下面有三个版本推荐使用版本三!!

版本一(废除):

下载完成后解压,得到一个 cudn 文件夹,该文件夹下include 和 lib64 两个文件夹,命令行进入 cudn/include 路径下,然后进行以下操作:

sudo cp cudnn.h /usr/local/cuda/include/ #复制头文件- 1

然后命令行进入 cudn/lib64 路径下,运行以下命令:

sudo cp lib* /usr/local/cuda/lib64/ #复制动态链接库

cd /usr/local/cuda/lib64/sudo rm -rf libcudnn.so libcudnn.so.5 #删除原有动态文件

sudo ln -s libcudnn.so.5.1.10 libcudnn.so.5 #生成软衔接

sudo ln -s libcudnn.so.5 libcudnn.so #生成软链接- 1

- 2

- 3

- 4

这里需要注意第三行命令,网上有人的第三行命令为:

sudo ln -s libcudnn.so.5.1.5 libcudnn.so.5 #生成软衔接

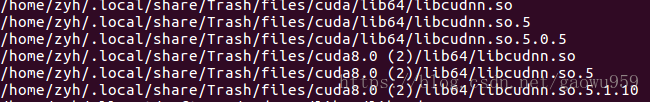

原因是版本的不同,所以这里需要先查看一下自己应该链接的是 libcudnn.so.5.1.10 还是 libcudnn.so.5.1.5 ,查看方法为下:

locate libcudnn.so

可以看到我的文件是 libcudnn.so.5.1.10 ,并没有 libcudnn.so.5.1.5,所以第三行命令我链接的是 libcudnn.so.5.1.10 ,这里第三行链接命令视你的查看结果而定。

安装完成后可用 nvcc -V 命令验证是否安装成功,若出现以下信息则表示安装成功:

yhao@yhao-X550VB:~$ nvcc -V

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2016 NVIDIA Corporation

Built on Tue_Jan_10_13:22:03_CST_2017

Cuda compilation tools, release 8.0, V8.0.61- 1

- 2

- 3

- 4

- 5

版本二(废除):

- sudo tar xvf cudnn-8.0-linux-x64-v5.1.tgz

- 切换到 cuda/lib64 目录下:sudo cp lib* /usr/local/cuda-8.0/lib64/

- 切换到 cuda/include 目录下:sudo cp *.h /usr/local/cuda-8.0/include/

- cd /usr/local/cuda/lib64/

- sudo rm -rf libcudnn.so libcudnn.so.5

- sudo ln -s libcudnn.so.5.1.5 libcudnn.so.5

- sudo ln -s libcudnn.so.5 libcudnn.so

-

若需要更换cudnn版本,则替换原来的libcudnn*,并重新软链接。

更新链接库:sudo ldconfig

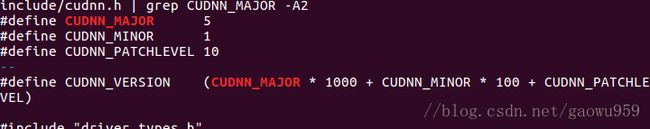

- 测试:sudo cat /usr/local/cuda/include/cudnn.h | grep CUDNN_MAJOR -A2

版本三(官方最为推荐前面全部废除):

参考官方文档:https://docs.nvidia.com/deeplearning/sdk/cudnn-install/index.html

$ sudo cp cuda/include/cudnn.h /usr/local/cuda/include

$ sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

$ sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*注意:注意必须通过上述官网2.4Verifying的测试才能说明cudnn安装成功

[pytorch1.0.0]

在装好pytorch后,运行下述代码确保cudnn的版本与自己所装的版本一致

import torch

print(torch.backends.cudnn.version())