清华大学王晓智:大规模通用域事件检测数据集MAVEN

点击蓝字

![]()

关注我们

AI TIME欢迎每一位AI爱好者的加入!

事件检测任务是事件抽取的第一步,对事件语义建模有重要意义。然而现有事件检测数据集存在两个严重的问题:

(1)数据稀缺,现有小规模数据集不足以充分训练和稳定评测复杂的神经网络模型;

(2)覆盖率低,现有数据集关心的有限数据类型不足以覆盖通用域中的广泛事件语义,也限制了事件检测模型的应用范围。

为了缓解这些问题带来的影响,本文构建了一个大规模通用域事件检测数据集MAVEN,它包含4480篇文章和118732个事件实例,覆盖了168种事件类型。同时也在MAVEN数据集上复现了一系列当前最佳的模型并进行了全面的实验。实验结果显示在传统数据集上表现极好的模型并不能在MAVEN上也取得理想的表现,这表明事件检测仍是一个具有挑战性的方向。本文也通过一些实证分析讨论了事件检测任务后续的发展方向。

本期AI TIME PhD直播间,我们有幸邀请到了清华大学计算机系的博士一年级研究生王晓智,为大家分享这项研究工作!

王晓智:清华大学计算机系博士一年级研究生,导师李涓子教授。主要研究方向为事件抽取和预训练语言模型。已在EMNLP、NAACL、COLING等会议发表多篇文章。

![]()

一、背景

一、 事件检测的定义

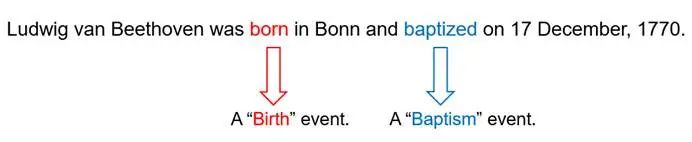

事件检测任务旨在从文本中识别事件触发词并正确分类事件类型。触发词指的是最能清晰明显表达事件出现的核心词语或短语,事件类型则需要在数据集中预先定义。

比如,在图1中,born是一个触发词,触发了birth这一事件,同时baptized也是一个触发词,触发了baptism这一事件。简单地说,事件检测任务的目的是从文本中检测出所关心的事件。

图1:事件检测举例

二、现有事件检测数据集的严重缺陷

事件检测在事件语义建模中具有基础性的作用,近些年来中外学者在事件检测的任务上做了很多的研究工作,提出了很多先进的模型,也取得了越来越好的事件检测的表现。然而值得注意的是,尽管整个事件抽取领域的模型更新非常快速,标准数据集的更新换代却非常的缓慢。不仅如此,标准数据集通常存在数据稀缺和覆盖率低这两个严重问题。

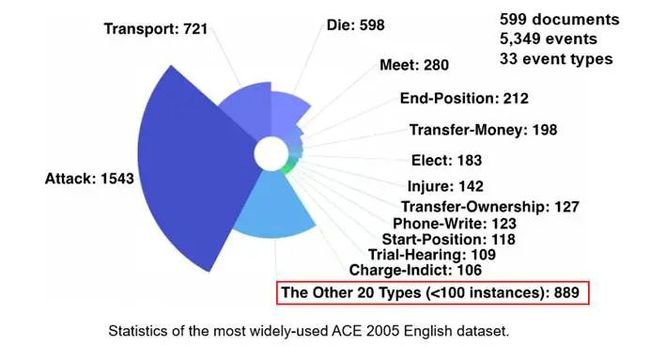

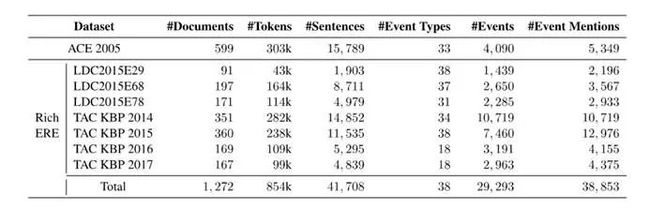

以目前最广泛使用的事件检测数据集ACE 2005为例,它只有不到600篇文档和5000多个标注出来的事件实例,仅仅覆盖了33个事件类型,这样的事件规模在现在看来是非常小而且难以充分训练模型的。同时由于难以避免的数据不平衡性,在这33个类别中,有20个事件类别只有不到100个标注实例。数据本身就非常小,再加上这么长尾的分布,很难去训练和稳定评测对数据量需求比较大的神经网络模型。

图2:ACE 2005统计数据

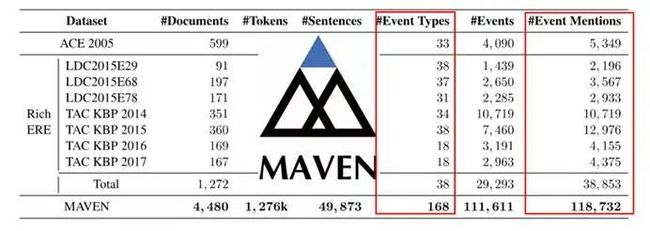

图3:事件检测数据集统计细节

二、解决方案

一、MAVEN数据集的构建

从数据稀缺和覆盖率低这两个问题出发,作者构造了MAVEN,一个大规模通用域的事件检测数据集。

首先看一下MAVEN的统计信息:针对数据稀缺这一问题,标注的Event Mentions的数量超过了10万,比起之前的数据集具备数量级级别的提升;针对覆盖率低的问题,MAVEN定义的Event Type达到了168个。可以看到,MAVEN比所有的现有数据检测数据集规模都要大很多,可以显著缓解数据稀缺和覆盖率低这两个问题。

图4:MAVEN的统计信息

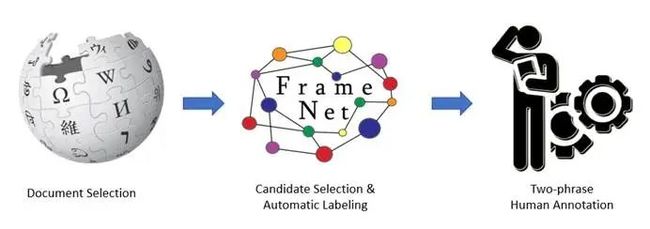

构建的第一步,需要做Document Selection,选择一些合适的语料来用于标注。具体来说,选择的是4480篇英文维基的文章作为标注的基础语料。

选择英文维基的原因:

首先,被使用范围比较广泛,语言的形式也相对流畅,比较好理解;

第二,虽然事件抽取目前与知识图谱的结合工作不算特别多,但是长远来看,它也是一个信息抽取任务,它的目的是为了丰富知识库中的资源,因此选用英文维基这么一个比较容易与其它的信息抽取任务和知识图谱相结合的一个语料,对于将来的数据构建和模型开发都是有一定帮助的。

具体来说,这4480篇文章的主题描述的是大事件,因为描述大事件的文章要比描述客观的实体,比如说香蕉、苹果,的文章含有更多的需要标注的基础事件,原子级别的事件。

第二步,做Candidate Selection(选择一些词作为用于标注的candidate)和Automatic Labeling(自动标注,比如预先用一些模型来做一个预置的推荐的标注结果),从而节省标注员的一些时间和精力,对整体的标注质量也是有帮助的。

最后一步是一个两阶段的人工标注,这一步与之前的ACE2005等数据集的构建思路非常类似:第一阶段中,对于每篇文档,邀请了2位独立的标注员来做独立的互相不知道结果的标注,从而能够比较好的提升标注的召回;第二阶段,邀请一位受过严格训练的标注员在第一阶段标注结果的基础上进行最终的标注。这个标注过程是实践证明会比较可靠的。

图5:MAVEN的构建

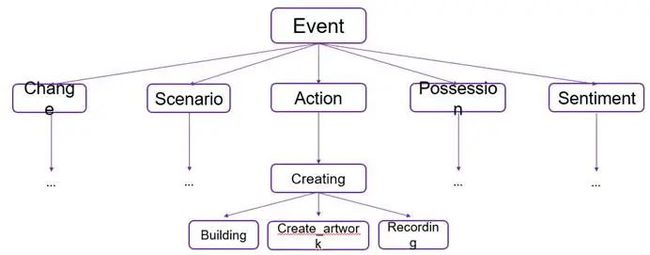

在做数据标注之外,要保证数据集有一个好的覆盖率,因此从FrameNet中推导派生出了一个Event Type Schema,它的特点是不仅覆盖率比较高,而且具备层次化,有比较明确的父子继承关系,会比较方便后面的模型做一些工作。这里展示的仅仅是一小部分的例子,如果对整个的168个事件的schema感兴趣,可以参阅论文的附录。

图6:层次化的Event Type Schema

二、MAVEN标注出的数据分布

整体来讲,MAVEN的数据分布还是非常长尾的。虽然数据分布本身的长尾不可避免,但是因为整体的数据规模做得非常大,其中41%的事件类型是超过500个标注实例的,82%的事件类型是超过100个标注实例的,对模型的训练会有很好的帮助。

另外一个比较关键的观察是,在MAVEN中会有多个事件在同一个句子中出现,模型可以考虑到一句话中不同事件类型之间的联系,更好地做事件类型的分类。这必定对模型是会有帮助的。然而,由于之前的一些小规模的数据集覆盖率比较低,一个句子中出现多个事件的现象是比较少见的,这也鼓励了模型设计针对这一现象做更多的考虑。

二、实验结果

一、模型表现

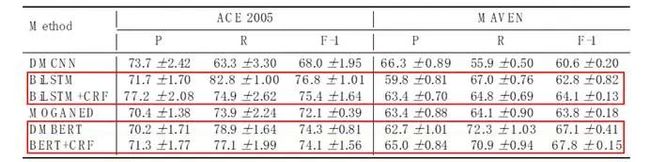

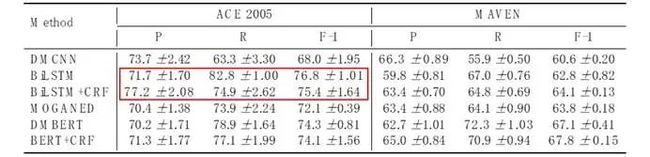

实验中实现了6个神经网络模型,同时在ACE 2005和MAVEN上比较了模型的表现。可以看出,模型在MAVEN上的表现显著差于在ACE 2005上的表现,这说明通用域的事件检测难度是非常大的,需要更多的研究精力来解决这个任务。同时,MAVEN上的模型表现标准差常常是比ACE 2005上的标准差低非常多的,这也证明小数据规模的数据集是不能稳定评测神经网络模型的。

进一步来看,以BiLSTM和BiLSTM+CRF作为模型,DMBERT和BERT+CRF作为模型,两对模型对比可以看出,加入CRF的模型表现在MAVEN上是要比基础模型要好的,而在ACE 2005上,它的提升不会很明显。考虑到CRF的主要作用是考虑一句话中多个事件之间的联系,可以证明之前所说的观察,启发之后的模型设计更多的往这一点上考虑。

另一个发现是,BiLSTM模型的表现在ACE 2005上是非常高的,甚至比BERT还要高,这可能也是证明了在ACE 2005这个小数据集上有一些不稳定性,而在MAVEN上并没有这个问题。

图7:ACE 2005和MAVEN的模型表现

二、对比实验

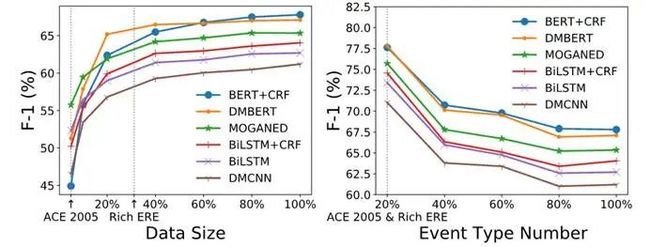

MAVEN数据集的一个显著优势是做了更多的数据和事件类型,为了观察数据量和事件类型是否足够,做了两个对比实验。

首先随机选择了一定比例MAVEN的训练数据,看这些比例下的训练数据的表现结果。从数据规模上来看,随着数据规模的上升,模型表现也在上升。现有数据集的规模无法使得模型得到充分训练,不足以得到稳定的比较结果,而在整个MAVEN的大小上,表现结果是再增加数据也不会带来很大的模型表现的提升;从事件类型的数量上来看,随着数量的上升,模型的表现在下降,这也证明了高覆盖率会带来一些新的挑战。

图8:对比实验的结果

三、Transferability实验

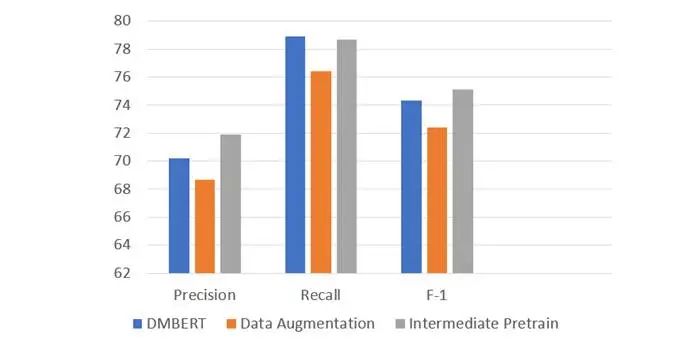

另一个要研究的问题是,在MAVEN上学习到了一些通用的事件检测的知识,然而通用域的知识能不能迁移到其它的检测工作上,在这里做了一个简单的实验来探索这个方向。实验采用了两种knowledge transfer的方式,一种是Direct Data Augmentation,一种是Intermediate Pretrain。可以看到,直接做数据增强的结果呈现比起原始结果的表现是要低一些的,这可能是由于MAVEN的语料与ACE语料之间domain的差异,把数据直接加进去的话表现会受到一定的影响。另一方面,Intermediate Pretrain的表现是要高一些的,证明将来可以探索怎样开发更好的knowledge transfer的方式。

图9:knowledge transfer的实验表现

四、错误分析

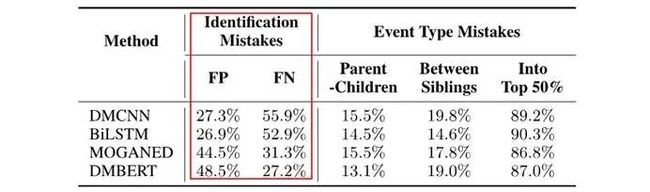

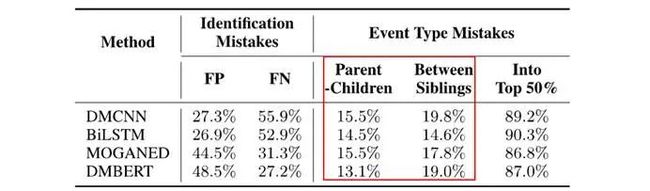

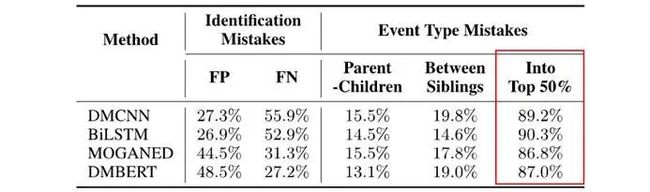

除了之前的实验,我们还对实现的模型做了错误分析,以期得到一些将来可以改进的方向。

第一种类型的错误,即假阳性和假阴性,可以看到这个类型的错误占错误比例是最高的,表明真正从文本中检测事件语义这一步骤是非常困难的,这也是将来模型要首先攻克的方向。

而第二种类型的错误Event Type Mistakes,即将数据错误分类到另一个Event Type中,可以看到在层次化的Event Type Schema下面,父子兄弟这种比较接近的类型之间互相分错的比例显著高于分错到别的类型的比例。

最后一种情况指的是,把一个数据错误的分类到数据量位于前50%的event type中去,可以看到这个比例非常的高,证明数据不平衡带来了很大的影响。

图10:错误分析

这些错误分析希望可以对大家做的模型开发有一些帮助。

总结及未来展望

首先,MAVEN是大规模的,人工标注的,具有高覆盖率的一个数据集。

其次,作者通过实证研究指出了开发新的通用域的事件检测模型的方向。比如,可以更高的建模一句话中多个事件的联系,可以对长尾类型做更好的理解,可以用knowledge transfer帮助一些数据量比较小的工作。在这些方向中,层次化的Event Type Schema会比较有帮助。

未来作者也计划在MAVEN上继续Event Argument Extraction和Event Relation Extraction的数据,从而能够使得MAVEN变成事件语义理解的一个大平台。

相关代码和数据集可以从https://github.com/THU-KEG/MAVEN-dataset获取,模型的预测结果可以在CodaLab上提交,欢迎大家多多使用。

论文原文和链接:

Xiaozhi Wang, et al. "MAVEN: A Massive General Domain Event Detection Dataset."

https://arxiv.org/pdf/2004.13590.pdf

e m t

往期精彩

AI i

![]()

整理:san

排版:岳白雪

审稿:王晓智

AI TIME欢迎AI领域学者投稿,期待大家剖析学科历史发展和前沿技术。针对热门话题,我们将邀请专家一起论道。同时,我们也长期招募优质的撰稿人,顶级的平台需要顶级的你!

请将简历等信息发至[email protected]!

微信联系:AITIME_HY

AI TIME是清华大学计算机系一群关注人工智能发展,并有思想情怀的青年学者们创办的圈子,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法、场景、应用的本质问题进行探索,加强思想碰撞,打造一个知识分享的聚集地。

![]()

更多资讯请扫码关注

![]()

(直播回放:https://b23.tv/GoTxPR)

(点击“阅读原文”下载本次报告ppt)