梦回93年,32岁的Yann LeCun在展示他的卷积网络...

作者:梦佳

1993年的你在哪里?

1993年的杨立昆已经做出了第一个卷积网络。

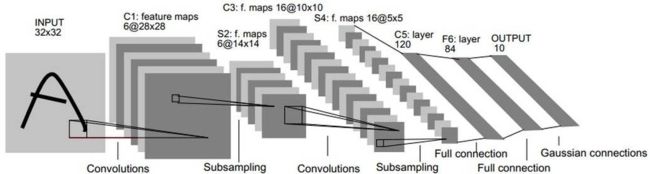

最近,Reddit上一段来自1993年的 1分钟视频火爆网络,视频中,刚过而立之年的Yann LeCun向大家展示了当时世界上第一个可以快速准确识别手写数字的卷积网络,LeNet。

识别的第一串字符据说是LeCun当时在贝尔实验室的电话号码。

虽然画质高糊,也没有背景音,但我们可以清楚地看到,当时的识别准确率已经相当高,也可以识别一定程度的变体。

LeNet就是最早的卷积网络之一。

那个年代,没有GPU,甚至没有像样的CPU,利用几台古董机,做出这么好的成绩,LeCun真无愧于卷积神经网络之父的名头。

01

领衔反向传播算法,LeNet 曾读取全美10%支票

据LeCun自己的介绍,LeNet 于1988年至1993年,诞生自新泽西州霍姆德尔(Holmdel)贝尔实验室的自适应系统研究部门。大名鼎鼎的贝尔实验室曾经被誉为这个星球上最伟大的实验室之一,晶体管、电子数字计算机、C语言、UNIX操作系统等重大发明均诞生于此。在加入Facebook之前,LeCun有20年的时光都是在贝尔实验室度过。

早在20世纪80年代中期,LeCun已经展示出非凡的天赋。1986年,在题为“Learning Internal Representations by Error propagation” 的文章中,便提出了反向传播算法(BP算法),如今这种算法已经成为人工神经网络的标配。

英雄所见略同,LeCun在博士就读期间也独立发明了反向传播算法的一种早期版本,随后他从法国巴黎远赴多伦多,加入了Hinton的团队。大师们漂洋过海的相聚促成了反向传播算法的加速发展。

在那个年代,深度神经网络还是个十分冷门的学科。正如一位读者评论所说,“杨立昆开始做深度神经网络的时候,大部分人还根本不知深度学习为何物。”

优异的成果往往需要天时地利人和。在贝尔实验室,不到30岁的LeCun接触到了大量数据集和运行飞快的电脑。

正是在贝尔实验室,LeCun 将 BP 算法应用于卷积神经网络中,并将其实用化,推广到各种图像相关任务中。

他创造的网络可以读取信件上的手写邮政编码,采用修订的美国国家标准与技术研究院(MNIST)数据库作为一种标记数据基准。这项技术当时最主要的应用有自动读取邮件信息,以及识别ATM机上银行支票的金额。有趣的是,最难的部分其实是查找支票上数字的位置,因为每张支票都有不同的格式。

他协助开发的银行支票识别系统读取了20世纪90年代末至21世纪初全美国超过10%的支票。

1998年,在此基础上,LeCun 在论文《Gradient-Based Learning Applied to Document Recognition》中提出了最终的神经网络结构 LeNet-5,将BP算法应用到这个神经网络结构的训练上,形成了当代卷积神经网络的雏形。

LeNet-5可以用于手写机印识别,甚至可以识别一些极端的变体,对于字符的扭曲和和简单的几何变换具有鲁棒性。

02

从冰点期重生,三十年后卷土重来

蓦然回首,三十载已过。曾经三十岁的青年,如今也已经迈过六十的大关,步入耳顺之年。

80年代初,LeCun刚刚进入机器学习领域的时候,神经网络思想火了一阵。只是好景不长,demo中演示的片段虽然是星星之火但因为遇到了“AI寒冬”而没有成燎原之势。更复杂多样的机器识别需要更高的运算量,显然已经超出了当时硬件设备的负荷。

原本蒸蒸日上的计划却因为公司内部斗争被迫叫停,LeCun也一度陷入消沉。LeCun 曾经在采访中回忆往事,“就在黎明来临之际,整个项目却被解散得差不多了”。

关于漫长的深度学习冰点期,依图科技CEO朱珑曾经撰文写道:

人工智能领域,神经网络思想在80年代末开始衰落,之后分别经历了几个划时代的图灵奖级工作的兴起,统计学习理论(带来支持向量机 SVM 算法),可学习理论(带来 Boosting 算法),概率推断(图模型,graphical model)几乎垄断了过去的三十年。在2012年的 Geoff Hinton 团队的深度学习打败Google的标志性事件前,图模型的思想横扫计算机视觉领域(超越了boosting,SVM等)。这使得深度学习生存艰难,没有多少同行在研究中使用深度学习,更多年轻学生愿意去“时髦”的机器学习研究组。

具有转折意义的是2003年。那一年,LeCun成为纽约大学教师,并与三巨头的另外两位Hinton 和 Bengio结成非正式的联盟,一个名为Neural Computation and Adaptive Perception(NCAP,神经计算和自适应感知)的项目,共同主导了神经网络的“复兴”。

大众狂欢的前夜是小众的“阴谋”。

三人小组组建后不久,Hinton 便将「神经网络」更名为「深度学习」(Deep Learning)。2006 年,Hinton发表了两篇代表性的论文:

A fast learning algorithm for deep belief nets;

Reducing the dimensionality of data with neural networks,

当中提出了深度信念网络(Deep Belief Nets)。与传统的训练方式不同,“深度信念网络”有一个“预训练”(pre-training)的过程,这可以方便地让神经网络中的权值找到一个接近最优解的值,之后再使用“微调”(fine-tuning)技术来对整个网络进行优化训练。这种分阶段两部训练技术的运用大幅度减少了训练多层神经网络的时间。深度信念网络正是深度学习爆发前夕重要的研究成果之一。

而令人惊讶的是,6年后的2012年,Yann LeCun的文章依然在顶会CVPR上发表困难,甚至惨遭拒稿。审稿人表示他的论文结果存疑。同年,LeCun 和 Bengio 共同创办了 ICLR(International Conference on Learning Representations,国际学习表征会议),希望为「深度学习」提供一个专业化的交流平台。

后来的故事我们都很熟悉,深度学习一度迎来了黄金时代,从学界到工业界呈现爆发式的增长,GPU带来的强大计算能力让深度学习系统有能力完成几年前计算机不可能完成的工作。“从没人做这个方向到所有人都做这个方向,只花了不到一年的时间。”

如今,LeCun已经年过六十,Hinton也已经年过七旬。为了这个深度的“信念”,竟然坚守了三十年。

当然,一直以来有关深度学习过誉的声音也不绝于耳。2015年,在周志华的《机器学习》一书的序言中,陆汝钤院士提到“深度学习掀起的热潮也许大过它本身真正的贡献,在理论和技术上并没有太多的创新,只不过是由于硬件技术的革命,计算机的速度大大提高了,使得人们有可能采用原来复杂度很高的算法,从而得到比过去更精细的结果。”

2018年,曾有学者表示,“很多研究领域都经历过萌芽期,发展期,泡沫,回归正常。深度学习显然在泡沫期,泡沫过后一地鸡毛。”

深度学习如今已经过了泡沫期,但显然并没有“一地鸡毛”,究其原因在于“It works”。

03

几点启示

最后,简单说三点启示。

第一,任何伟大的工作,都是站在巨人肩膀上做出的。

如今大家普遍认为 Yann LeCun 是“CNN之父”。但最早提出CNN思想的则是福岛邦彦(当时不叫CNN,而是Neocognitron),1980年从猫的视觉系统实验中得到的启发提出卷积和池化的思想(这又要致敬Hubel和Wiesel)。LeCun发明的 LeNet 的不同之处在于引入了BP算法,也因此把CNN发扬光大。任何伟大的工作都不是凭空想出来的,而必然是基于前人大量工作的基础上,添加了一个“细枝末节”,却产生了巨大变化。

第二,人工智能的最终胜利还很遥远。

有读者看罢视频评论表示,「现在所谓的AI其实还是停留在那个年代!只有应用方面成熟了,没有突破性的进步。」对于这种声音,从业者认为,“如果以为CNN就是AI的巅峰技术,从而断言AI这几十年都没有革命性的进步,那就有点太鼠目寸光了。科学的发展都是一步一个脚印,妄言自己已经站在巅峰,未免过于狂妄。”

第三,“少数派”要拥有独立的见解和勇气。

回望过去10年,以深度学习为代表的人工智能技术取得了巨大进展,这个发展的过程离不开研究人员独立的见解和勇气,就像为了证明「神经网络」是有用的,三巨头坚守长达三十年,Yann LeCun曾经被屡屡拒稿,被业内人士排挤也没有忘记初心。期间,深度学习经历了低谷和复兴,最终从边缘化走向主流。

在过去的数年,深度学习不仅深刻改变了人工智能学科,也在许多场景中不断颠覆传统学科的研究范式,呈现出“多点爆发”的趋势。从最初的茫然无知,到后来的全民兴奋、资本涌入,到现在热潮退去、回归理性。身处其中的研究者必定要经受一番考验,选择随波逐流还是坚持信仰。

![]()

点击左下角“阅读原文”,了解更多!