- Spring Boot 整合 Elasticsearch 实践:从入门到上手

遇见伯灵说

mysqlSpringelasticsearchjenkinsspringboot

引言Elasticsearch是一个开源的分布式搜索引擎,广泛用于日志分析、搜索引擎、数据分析等场景。本文将带你通过一步步的教程,在SpringBoot项目中整合Elasticsearch,轻松实现数据存储与查询。1.创建SpringBoot项目首先,你需要创建一个SpringBoot项目。如果你还没有创建,可以使用SpringInitializr快速生成一个项目。在生成项目时,确保选择了以下依赖

- autosar功能安全文档解析

dont__cry

安全

该文档是AUTOSAR汽车搜索引擎发布的关于AUTOSAR经典平台功能安全措施的概述,涵盖功能安全机制、措施、硬件诊断等内容,为汽车安全相关系统开发提供指导。1.**引言**-**范围**:涵盖功能安全机制、措施及硬件诊断等多方面内容,帮助理解AUTOSAR在功能安全方面的作用。-**目的**:总结AUTOSAR功能安全要点,指导相关系统开发人员利用其机制和措施,取代旧文档。-**目标受众**:主

- 第七章Solr:企业级搜索应用

AGI大模型与大数据研究院

DeepSeekR1&大数据AI人工智能计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

第七章Solr:企业级搜索应用1.背景介绍1.1搜索引擎的重要性在当今信息时代,数据量呈指数级增长,海量数据中蕴含着极其宝贵的信息和知识。然而,如何快速、准确地从大数据中检索出所需的信息,一直是企业和组织面临的巨大挑战。传统的数据库查询方式已经无法满足现代搜索需求,因此高效的搜索引擎应运而生。1.2什么是SolrApacheSolr是一个高性能、可扩展、云就绪的企业级搜索平台,由Apache软件基

- MySQL 与 Elasticsearch 联合查询

墨瑾轩

一起学学数据库【一】mysqlelasticsearchadb

关注墨瑾轩,带你探索编程的奥秘!超萌技术攻略,轻松晋级编程高手技术宝库已备好,就等你来挖掘订阅墨瑾轩,智趣学习不孤单即刻启航,编程之旅更有趣嘿,小伙伴们!今天我们要来聊聊MySQL与Elasticsearch如何携手合作,共同完成高效的联合查询和数据检索任务。MySQL是一款非常流行的数据库管理系统,而Elasticsearch则是一款基于Lucene的搜索引擎,擅长全文搜索和实时数据分析。两者结

- 大模型联网搜索组件 SearXNG 部署和使用

「已注销」

SearXNG是一个免费的互联网元搜索引擎,它整合了来自超过70个搜索服务的结果。用户不会被跟踪或进行特征分析,很好地保护了用户隐私。2022年11月OpenAI发布ChatGPT后,大模型和知识库开始火爆,联网搜索成为弥补大模型知识陈旧的重要工具。提供元搜索功能的SearXNG开始被很多大模型应用比如ChatNio[1]采用,在大模型时代发挥了巨大作用。本文将介绍如何基于docker部署私人的S

- 信息收集之 子域名收集,子域名爆破_dnsdumpster

2401_89829398

网络

「作者主页」:士别三日wyx「作者简介」:CSDNtop100、阿里云博客专家、华为云享专家、网络安全领域优质创作者「专栏简介」:此文章已录入专栏《网络安全快速入门》子域名收集一、域名爆破原理二、搜索引擎收集子域名三、第三方网站收集子域名1.VirusTotal2.DNSdumpster四、工具收集子域名子域名就是下一级域名的意思,比如map.baidu.com和image.baidu.com就是

- 添加 ChatGPT/Grok/Gemini 到浏览器搜索引擎

YiYueHuan

搜索引擎GrokChatGPT

添加ChatGPT/Grok/Gemini到浏览器搜索引擎添加ChatGPT/Grok/Gemini到浏览器搜索引擎如何添加步骤1:打开浏览器设置步骤2:添加新搜索引擎步骤3:保存设置注意事项添加ChatGPT/Grok/Gemini到浏览器搜索引擎在使用ChatGPT/Grok/Gemini进行对话时,每次都需要先打开对应的网页,然后再进行对话,非常繁琐。因此,我们可以将这些工具添加到浏览器的搜

- 国内外AI搜索产品盘点

Suee2020

人工智能

序号AISearch产品名简介网站开发者1Perplexity强大的对话式AI搜索引擎https://www.perplexity.aiPerplexity2GensparkAIAgent搜索引擎https://www.genspark.aiMainFunc(景鲲、朱凯华)3Kimi.ai智能助手https://kimi.moonshot.cn/月之暗面(杨植麟)4秘塔AI搜索AI搜索引擎http

- Elasticsearch大文件检索性能提升20倍实践(干货)_elasticsearch 查询优化

2401_84247505

2024年程序员学习elasticsearchjenkins大数据

3、问题排查与定位步骤1:限定返回记录条数。不提供直接访问末页的入口。baidu,360,搜狗等搜索引擎都不提供访问末页的请求方式。都是基于如下的请求方式:通过点击上一下、下一页逐页访问。这个从用户的角度也很好理解,搜索引擎返回的前面都是相关度最高的,也是用户最关心的信息。Elasticsearch的默认支持的数据条数是10000条,可以通过post请求修改。最终,本步骤将支持ES最大返回值100

- 百度蜘蛛池是什么

asdjka2wfd

百度百度小程序百度云算法

百度蜘蛛池是一种SEO策略或程序,旨在吸引百度搜索引擎的爬虫(百度蜘蛛)更频繁地访问和收录网站内容5。以下是关于它的详细介绍:构成要素:通常包括大量的域名资源、强大的服务器支持以及复杂的链接结构。大量的域名数量众多,来源多样;强大的服务器是为了承载众多域名的运行和大量的访问请求,确保稳定和高效的服务;而复杂的链接结构则将各个域名和页面相互连接,形成一个有机的整体,引导蜘蛛在其中爬行。www.sgs

- 算法在各领域的广泛应用:100 个实例全解析

软件职业规划

AI&模型算法

一、互联网与信息技术领域搜索引擎算法:如谷歌的PageRank算法,用于根据网页的重要性和相关性对搜索结果进行排序,帮助用户快速找到所需信息。推荐系统算法:例如亚马逊和Netflix使用的协同过滤算法。根据用户的历史行为(购买、观看记录等)和其他相似用户的偏好,为用户推荐可能感兴趣的产品或内容。社交网络分析算法:用于分析社交网络中的用户关系,如Facebook通过算法发现用户的好友推荐、社区划分等

- springboot 整合 elk (Elasticsearch+Logstash+Kibana)

高大王竟然被注册

spring运维

Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。Logstash是一个完全开源的工具,他可以对你的日志进行收集、过滤,并将其存储供以后使用(如,搜索)。Kibana也是一个开源和免费的工具,它Kibana可以为Logstash和ElasticSearch提供的日志分析友好的Web界

- 信息检索系统评估指标的层级分析:从单点精确度到整体性能度量

人工智能深度学习llm检索系统

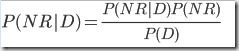

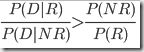

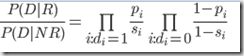

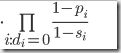

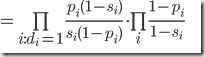

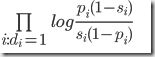

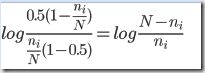

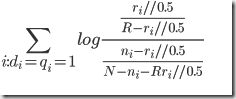

在构建搜索引擎系统时,有效的评估机制是保证系统质量的关键环节。当用户输入查询词如"machinelearningtutorialspython",系统返回结果列表后,如何客观评估这些结果的相关性和有效性?这正是信息检索评估指标的核心价值所在。分析用户与搜索引擎的交互模式,我们可以观察到以下行为特征:用户主要关注结果列表的前几项对顶部结果的关注度显著高于底部结果用户基于多次搜索体验形成对搜索系统整体

- 泛目录程序:站群策略在SEO优化中的优势与应用

奥顺互联_老张

站群php数据库缓存搜索引擎

泛目录程序案例:站群策略在SEO优化中的优势与应用引言在当今竞争激烈的互联网环境中,搜索引擎优化(SEO)已成为企业提升在线可见性和流量的关键策略。泛目录和站群作为SEO优化中的两种重要策略,近年来备受关注。本文将通过具体案例,深入探讨这两种策略在SEO优化中的优势与应用。一、泛目录的定义与优势1.1泛目录的定义泛目录是指通过创建大量内容相关、结构相似的目录页面,覆盖广泛的搜索关键词,从而提升网站

- SEO 优化

前端岳大宝

前端核心知识总结前端html

以下是SEO(搜索引擎优化)的基础知识点梳理,从前端技术、内容策略到搜索引擎原理,覆盖核心优化方向:一、SEO基础概念定义与目标SEO是通过优化网站结构、内容和技术,提升网站在搜索引擎自然搜索结果中的排名,吸引更多免费流量。核心目标:满足用户搜索意图,同时符合搜索引擎爬虫的抓取规则。搜索引擎工作原理爬取(Crawling):搜索引擎蜘蛛(如Googlebot)抓取网页内容。索引(Indexing)

- HTML标记语言<head>中 的几个元素

2301_79698214

html前端

在HTML文档中,部分包含了文档的元数据(metadata),这对于网页的正确显示和搜索引擎优化(SEO)非常重要。部分通常包含以下几个重要的元素::定义了网页的标题,这个标题会显示在浏览器的标题栏或页面的标签上。例如:我的网页:用于定义网页的元数据,如字符集、页面描述、关键词、作者、视口设置等。例如::用于链接外部资源,如CSS文件、图标(favicon)等。例如::用于直接在文档中嵌入CSS样

- 文件关键字搜索技术要点与实战

体制教科书

本文还有配套的精品资源,点击获取简介:在IT行业中,能够通过输入关键字高效定位和管理大量文档是一项重要的技能。此功能通常集成于文件管理软件、搜索引擎或脚本程序中。技术实现包括文件系统API、文本搜索算法和文件过滤规则。本文将详细介绍这些技术要点,例如使用文件系统API遍历文件、采用高效文本搜索算法(如Boyer-Moore)以及应用文件过滤规则(包括类型筛选和正则表达式匹配)。特殊文件格式如Out

- Python 爬虫基础教程

盛子涵666

python爬虫开发语言

爬虫的背景与应用诞生爬虫(WebCrawling)是自动化程序,用于从互联网上获取信息。爬虫的基本任务是自动访问网站,通过抓取网页内容并提取有用数据来构建数据库、索引或者进行进一步的数据分析。爬虫通常会模拟浏览器的行为,以避免被服务器识别为机器人,并且能够在大规模范围内高效地抓取信息。爬虫技术最早由搜索引擎开发者提出,目的是自动收集网页信息并将其索引,便于用户搜索时快速检索相关内容。随着互联网的快

- 爬虫的精准识别:基于 User-Agent 的正则实现

Small踢倒coffee_氕氘氚

经验分享笔记

##摘要随着互联网技术的飞速发展,网络爬虫在数据采集、搜索引擎优化等领域的应用日益广泛。然而,恶意爬虫的存在也给网站安全和数据隐私带来了严重威胁。因此,精准识别爬虫行为成为网络安全领域的重要课题。本文提出了一种基于User-Agent正则表达式的爬虫识别方法,通过分析User-Agent字符串的特征,构建正则表达式规则,实现对爬虫的精准识别。实验结果表明,该方法具有较高的识别准确率和较低的误报率,

- Java线程协作式中断机制

超人汪小建(seaboat)

线程协作式中断机制jvm

跟着作者的65节课彻底搞懂Java并发原理专栏,一步步彻底搞懂Java并发原理。作者简介:笔名seaboat,擅长工程算法、人工智能算法、自然语言处理、计算机视觉、架构、分布式、高并发、大数据和搜索引擎等方面的技术,大多数编程语言都会使用,但更擅长Java、Python和C++。平时喜欢看书写作、运动、画画。崇尚技术自由,崇尚思想自由。出版书籍:《Tomcat内核设计剖析》、《图解数据结构与算法》

- 美司法部考虑分拆谷歌:美国司法部在谷歌垄断在线搜索市场后,正在考虑的惩罚谷歌选择中,包括将谷歌分拆这种罕见的举措。

百态老人

笔记

1.案件背景与起因1.1美国司法部对谷歌提起诉讼美国司法部对谷歌提起诉讼的背景是该公司在在线搜索市场的主导地位引起了反垄断的担忧。司法部认为谷歌通过排他性协议和财务激励手段,限制了其他搜索引擎的发展空间,从而损害了市场竞争。诉讼时间:诉讼始于2020年,由美国司法部联合52个州及司法辖区的检察长共同发起。诉讼焦点:主要聚焦于谷歌与设备制造商、无线服务商等签订的独家协议,这些协议使谷歌搜索成为默认选

- AI编程方法第二弹:边提问边调整

leeshuqing

AI编程AI编程

AI编程的提问词非常类似于传统搜索引擎中的检索词,虽然采取了自然语言表示,但是在获取结果的策略上却很一致。因为用户在一开始可能并不非常清楚AI编程工具如何理解用户的提问,因此输出结果可能并不能完全满足用户要求,此时用户可以不断的根据生成结果,动态的灵活的调整提问,使之不断趋近于自己满意的结果。比如,对于“Python”等任意英文单词,允许用户指定总宽度后,通过自动填充空格,使之总宽度尽可能等于该宽

- 网站外链影响网站排名吗为什么

霏霏看世界

搜索引擎百度百度小程序百度云算法

权重传递:搜索引擎认为,如果一个网站被其他高质量、权威的网站所链接,就像是获得了这些网站的“信任投票”。高质量的外链能够将一部分权重传递给目标网站,提升其在搜索引擎眼中的重要性和可信度,从而有助于提高排名。例如,在学术领域,一篇论文被众多知名学术期刊引用,那么这篇论文的学术价值和影响力就会被认可,类似地,网站获得权威网站的外链,也会被搜索引擎认为更有价值。www.czyhjy.cn增加爬行入口:搜

- 【爬虫实战】python入门爬取猫眼电影排行

进击的C语言

爬虫自动化网络

爬虫爬虫概述应用场景:1、抓取特定网站或应用的内容,提取出有价值的信息。2、模拟用户在浏览器或应用中的操作,实现自动化流程。爬虫是什么专业术语:网络爬虫(又称网页蜘蛛、网络机器人)网络爬虫是一种自动按照特定规则抓取网页信息的程序或脚本。爬虫起源随着网络的迅猛发展,万维网成为海量信息的载体,如何有效地提取和利用这些信息成为一项巨大挑战。搜索引擎如Yahoo、Google、百度等,作为帮助人们检索信息

- 分布式系统架构设计原理与实战:理解并使用分布式搜索引擎

AI天才研究院

AI大模型企业级应用开发实战大数据人工智能语言模型JavaPython架构设计

作者:禅与计算机程序设计艺术1.背景介绍在当代互联网时代,随着互联网的迅速发展、信息量的爆炸性增长,人们对获取新信息的渠道越来越多,需要快速而准确地检索信息。基于这一需求,许多网站都提供搜索功能。目前,搜索引擎服务主要由传统的基于数据库检索技术向云端托管的检索服务器和搜索引擎框架组成。由于传统的基于数据库检索方式具有很高的查询效率,因此可以满足一般用户的搜索需求;但是,对于一些高级的功能要求或是特

- MindSearch: 革新人工智能搜索引擎的未来

2401_87189860

人工智能搜索引擎

MindSearch:革新人工智能搜索引擎的未来在人工智能和大语言模型快速发展的今天,搜索引擎领域正迎来新的变革。由上海人工智能实验室开发的MindSearch项目,正是这场变革中的佼佼者。MindSearch是一个开源的AI搜索引擎框架,它通过模仿人类思维过程,为用户提供深度的AI搜索能力。本文将深入探讨MindSearch的特点、工作原理以及它对未来搜索技术的影响。MindSearch的核心特

- Scira:极简AI驱动搜索引擎

开源项目精选

人工智能

Scira(原名MiniPerplx)是一款极简的AI驱动搜索引擎,可帮助您在互联网上查找信息。它由VercelAISDK提供支持,并可使用Grok2.0等模型进行搜索。Stars数7,186Forks数845主要特点AI驱动的智能搜索:借助Anthropic的模型,快速获取问题的答案,让搜索变得更加智能化。网页搜索:使用Tavily的API来进行高效的网页搜索,无需额外的插件即可快速得到网页内容

- 9.3 智谱AI大模型生态爆发!中文准确率89.2%+代码生成67.3%,全面碾压GPT-4!

少林码僧

掌握先机!从0起步实战AI大模型微调打造核心竞争力人工智能语言模型gpt

智谱AI大模型生态爆发!中文准确率89.2%+代码生成67.3%,全面碾压GPT-4!1.WebGLM:联网检索增强大模型智谱AI于2022年推出的WebGLM是基于GLM-10B打造的检索增强生成(RAG)模型,其创新性地将大语言模型与搜索引擎深度整合,构建了独特的四阶段处理架构:

- 使用OpenAI API实现自然语言处理应用

shuoac

自然语言处理人工智能python

使用OpenAIAPI实现自然语言处理应用技术背景介绍随着人工智能技术的不断发展,自然语言处理(NLP)在各种应用中的地位越来越重要。从自动文本生成、聊天机器人到智能搜索引擎,NLP技术的应用场景非常广泛。而OpenAI提供的API使得开发者可以轻松地将先进的NLP模型集成到他们的应用中。核心原理解析OpenAI的API基于强大的GPT(GenerativePre-trainedTransform

- 使用Vespa进行高级检索与向量数据库管理

scaFHIO

数据库python

技术背景介绍在现代信息检索领域,为了提供精准且高效的搜索体验,往往需要结合使用向量搜索(ANN)、词法搜索以及结构化数据搜索。Vespa作为一个功能完备的搜索引擎与向量数据库,为我们提供了一站式的解决方案。本文将详细介绍如何使用Vespa进行高级检索,并通过代码示例展示其实际应用。核心原理解析Vespa具备以下核心功能:向量搜索(ANN):基于向量空间的近似最近邻搜索,提高了高维数据检索的效率。词

- 矩阵求逆(JAVA)初等行变换

qiuwanchi

矩阵求逆(JAVA)

package gaodai.matrix;

import gaodai.determinant.DeterminantCalculation;

import java.util.ArrayList;

import java.util.List;

import java.util.Scanner;

/**

* 矩阵求逆(初等行变换)

* @author 邱万迟

*

- JDK timer

antlove

javajdkschedulecodetimer

1.java.util.Timer.schedule(TimerTask task, long delay):多长时间(毫秒)后执行任务

2.java.util.Timer.schedule(TimerTask task, Date time):设定某个时间执行任务

3.java.util.Timer.schedule(TimerTask task, long delay,longperiod

- JVM调优总结 -Xms -Xmx -Xmn -Xss

coder_xpf

jvm应用服务器

堆大小设置JVM 中最大堆大小有三方面限制:相关操作系统的数据模型(32-bt还是64-bit)限制;系统的可用虚拟内存限制;系统的可用物理内存限制。32位系统下,一般限制在1.5G~2G;64为操作系统对内存无限制。我在Windows Server 2003 系统,3.5G物理内存,JDK5.0下测试,最大可设置为1478m。

典型设置:

java -Xmx

- JDBC连接数据库

Array_06

jdbc

package Util;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.sql.Statement;

public class JDBCUtil {

//完

- Unsupported major.minor version 51.0(jdk版本错误)

oloz

java

java.lang.UnsupportedClassVersionError: cn/support/cache/CacheType : Unsupported major.minor version 51.0 (unable to load class cn.support.cache.CacheType)

at org.apache.catalina.loader.WebappClassL

- 用多个线程处理1个List集合

362217990

多线程threadlist集合

昨天发了一个提问,启动5个线程将一个List中的内容,然后将5个线程的内容拼接起来,由于时间比较急迫,自己就写了一个Demo,希望对菜鸟有参考意义。。

import java.util.ArrayList;

import java.util.List;

import java.util.concurrent.CountDownLatch;

public c

- JSP简单访问数据库

香水浓

sqlmysqljsp

学习使用javaBean,代码很烂,仅为留个脚印

public class DBHelper {

private String driverName;

private String url;

private String user;

private String password;

private Connection connection;

privat

- Flex4中使用组件添加柱状图、饼状图等图表

AdyZhang

Flex

1.添加一个最简单的柱状图

? 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28

<?xml version=

"1.0"&n

- Android 5.0 - ProgressBar 进度条无法展示到按钮的前面

aijuans

android

在低于SDK < 21 的版本中,ProgressBar 可以展示到按钮前面,并且为之在按钮的中间,但是切换到android 5.0后进度条ProgressBar 展示顺序变化了,按钮再前面,ProgressBar 在后面了我的xml配置文件如下:

[html]

view plain

copy

<RelativeLa

- 查询汇总的sql

baalwolf

sql

select list.listname, list.createtime,listcount from dream_list as list , (select listid,count(listid) as listcount from dream_list_user group by listid order by count(

- Linux du命令和df命令区别

BigBird2012

linux

1,两者区别

du,disk usage,是通过搜索文件来计算每个文件的大小然后累加,du能看到的文件只是一些当前存在的,没有被删除的。他计算的大小就是当前他认为存在的所有文件大小的累加和。

- AngularJS中的$apply,用还是不用?

bijian1013

JavaScriptAngularJS$apply

在AngularJS开发中,何时应该调用$scope.$apply(),何时不应该调用。下面我们透彻地解释这个问题。

但是首先,让我们把$apply转换成一种简化的形式。

scope.$apply就像一个懒惰的工人。它需要按照命

- [Zookeeper学习笔记十]Zookeeper源代码分析之ClientCnxn数据序列化和反序列化

bit1129

zookeeper

ClientCnxn是Zookeeper客户端和Zookeeper服务器端进行通信和事件通知处理的主要类,它内部包含两个类,1. SendThread 2. EventThread, SendThread负责客户端和服务器端的数据通信,也包括事件信息的传输,EventThread主要在客户端回调注册的Watchers进行通知处理

ClientCnxn构造方法

&

- 【Java命令一】jmap

bit1129

Java命令

jmap命令的用法:

[hadoop@hadoop sbin]$ jmap

Usage:

jmap [option] <pid>

(to connect to running process)

jmap [option] <executable <core>

(to connect to a

- Apache 服务器安全防护及实战

ronin47

此文转自IBM.

Apache 服务简介

Web 服务器也称为 WWW 服务器或 HTTP 服务器 (HTTP Server),它是 Internet 上最常见也是使用最频繁的服务器之一,Web 服务器能够为用户提供网页浏览、论坛访问等等服务。

由于用户在通过 Web 浏览器访问信息资源的过程中,无须再关心一些技术性的细节,而且界面非常友好,因而 Web 在 Internet 上一推出就得到

- unity 3d实例化位置出现布置?

brotherlamp

unity教程unityunity资料unity视频unity自学

问:unity 3d实例化位置出现布置?

答:实例化的同时就可以指定被实例化的物体的位置,即 position

Instantiate (original : Object, position : Vector3, rotation : Quaternion) : Object

这样你不需要再用Transform.Position了,

如果你省略了第二个参数(

- 《重构,改善现有代码的设计》第八章 Duplicate Observed Data

bylijinnan

java重构

import java.awt.Color;

import java.awt.Container;

import java.awt.FlowLayout;

import java.awt.Label;

import java.awt.TextField;

import java.awt.event.FocusAdapter;

import java.awt.event.FocusE

- struts2更改struts.xml配置目录

chiangfai

struts.xml

struts2默认是读取classes目录下的配置文件,要更改配置文件目录,比如放在WEB-INF下,路径应该写成../struts.xml(非/WEB-INF/struts.xml)

web.xml文件修改如下:

<filter>

<filter-name>struts2</filter-name>

<filter-class&g

- redis做缓存时的一点优化

chenchao051

redishadooppipeline

最近集群上有个job,其中需要短时间内频繁访问缓存,大概7亿多次。我这边的缓存是使用redis来做的,问题就来了。

首先,redis中存的是普通kv,没有考虑使用hash等解结构,那么以为着这个job需要访问7亿多次redis,导致效率低,且出现很多redi

- mysql导出数据不输出标题行

daizj

mysql数据导出去掉第一行去掉标题

当想使用数据库中的某些数据,想将其导入到文件中,而想去掉第一行的标题是可以加上-N参数

如通过下面命令导出数据:

mysql -uuserName -ppasswd -hhost -Pport -Ddatabase -e " select * from tableName" > exportResult.txt

结果为:

studentid

- phpexcel导出excel表简单入门示例

dcj3sjt126com

PHPExcelphpexcel

先下载PHPEXCEL类文件,放在class目录下面,然后新建一个index.php文件,内容如下

<?php

error_reporting(E_ALL);

ini_set('display_errors', TRUE);

ini_set('display_startup_errors', TRUE);

if (PHP_SAPI == 'cli')

die('

- 爱情格言

dcj3sjt126com

格言

1) I love you not because of who you are, but because of who I am when I am with you. 我爱你,不是因为你是一个怎样的人,而是因为我喜欢与你在一起时的感觉。 2) No man or woman is worth your tears, and the one who is, won‘t

- 转 Activity 详解——Activity文档翻译

e200702084

androidUIsqlite配置管理网络应用

activity 展现在用户面前的经常是全屏窗口,你也可以将 activity 作为浮动窗口来使用(使用设置了 windowIsFloating 的主题),或者嵌入到其他的 activity (使用 ActivityGroup )中。 当用户离开 activity 时你可以在 onPause() 进行相应的操作 。更重要的是,用户做的任何改变都应该在该点上提交 ( 经常提交到 ContentPro

- win7安装MongoDB服务

geeksun

mongodb

1. 下载MongoDB的windows版本:mongodb-win32-x86_64-2008plus-ssl-3.0.4.zip,Linux版本也在这里下载,下载地址: http://www.mongodb.org/downloads

2. 解压MongoDB在D:\server\mongodb, 在D:\server\mongodb下创建d

- Javascript魔法方法:__defineGetter__,__defineSetter__

hongtoushizi

js

转载自: http://www.blackglory.me/javascript-magic-method-definegetter-definesetter/

在javascript的类中,可以用defineGetter和defineSetter_控制成员变量的Get和Set行为

例如,在一个图书类中,我们自动为Book加上书名符号:

function Book(name){

- 错误的日期格式可能导致走nginx proxy cache时不能进行304响应

jinnianshilongnian

cache

昨天在整合某些系统的nginx配置时,出现了当使用nginx cache时无法返回304响应的情况,出问题的响应头: Content-Type:text/html; charset=gb2312 Date:Mon, 05 Jan 2015 01:58:05 GMT Expires:Mon , 05 Jan 15 02:03:00 GMT Last-Modified:Mon, 05

- 数据源架构模式之行数据入口

home198979

PHP架构行数据入口

注:看不懂的请勿踩,此文章非针对java,java爱好者可直接略过。

一、概念

行数据入口(Row Data Gateway):充当数据源中单条记录入口的对象,每行一个实例。

二、简单实现行数据入口

为了方便理解,还是先简单实现:

<?php

/**

* 行数据入口类

*/

class OrderGateway {

/*定义元数

- Linux各个目录的作用及内容

pda158

linux脚本

1)根目录“/” 根目录位于目录结构的最顶层,用斜线(/)表示,类似于

Windows

操作系统的“C:\“,包含Fedora操作系统中所有的目录和文件。 2)/bin /bin 目录又称为二进制目录,包含了那些供系统管理员和普通用户使用的重要

linux命令的二进制映像。该目录存放的内容包括各种可执行文件,还有某些可执行文件的符号连接。常用的命令有:cp、d

- ubuntu12.04上编译openjdk7

ol_beta

HotSpotjvmjdkOpenJDK

获取源码

从openjdk代码仓库获取(比较慢)

安装mercurial Mercurial是一个版本管理工具。 sudo apt-get install mercurial

将以下内容添加到$HOME/.hgrc文件中,如果没有则自己创建一个: [extensions] forest=/home/lichengwu/hgforest-crew/forest.py fe

- 将数据库字段转换成设计文档所需的字段

vipbooks

设计模式工作正则表达式

哈哈,出差这么久终于回来了,回家的感觉真好!

PowerDesigner的物理数据库一出来,设计文档中要改的字段就多得不计其数,如果要把PowerDesigner中的字段一个个Copy到设计文档中,那将会是一件非常痛苦的事情。