python的requests模块是爬虫的基本模块,让我们看看怎么用!

参考:Python3 网络爬虫开发实战

介绍

Requests 模块是一个用于网络访问的模块。就像这个url:https://www.baidu.com,如果我们想获取这个url的网页源代码,requests模块可以帮我们实现,甚至可以帮我们获取到更多更多的信息。

URL介绍

URL 的一般语法格式为:

protocol :// hostname[:port] / path / [;parameters][?query]#fragment

举例

http://www.imailtone.com:80/WebApplication1/WebForm1.aspx?name=tom&;amp;age=20#resume

protocol一般代表 http/https/ftp 等

hostname 一般代表主机域名或IP地址

port 端口号,可省略。

path 路径 表示主机下的目录路径

param 向服务器传入参数

query代表查询字符串

fragment代表定位 #top代表移动到顶部

浏览器请求

- get:向服务器请求数据

- post:向服务器提交数据

导入

import requests

使用

import requests

# 有参数,可以无参数

params={

'key1':'value1',

'key2':'value2'

}

r=requests.get('http://baidu.com',params=params)

print(r.url)

# 结果如下

# http://baidu.com/?key2=value2&key1=value1

可以通过requests.get()传入url各部分组成,然后通过url方法获取最后的链接。

import requests

r = requests.get('https://www.baidu.com/')

print(type(r)) # r返回类型

print(r.status_code)# 返回状态200代表正常

print(type(r.text)) # 源代码类型

print(r.text) # 源代码

获取到了网页源代码

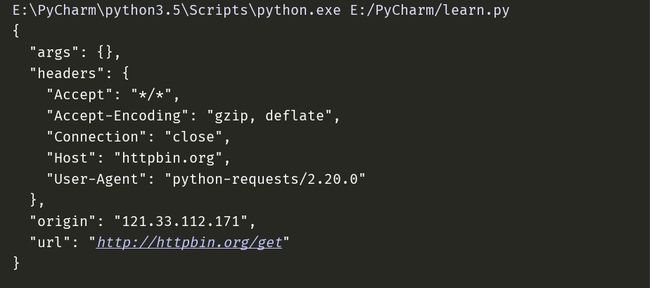

get请求

import requests

r = requests.get('http://httpbin.org/get')

print(r.text)

http://httpbin.org/get 如果判断是GET请求,就会返回Request信息

结果其实就是浏览器看到的

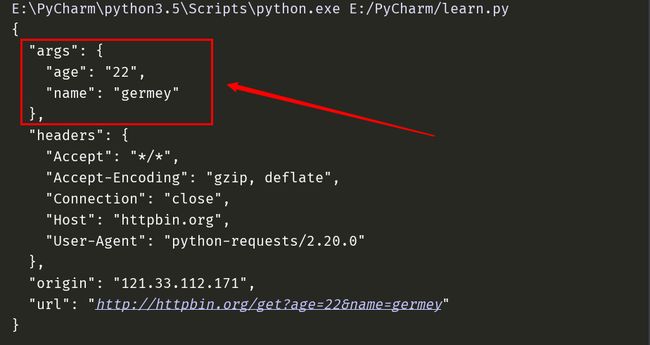

也可以模拟get请求,传入参数

import requests

data = {

'name': 'germey',

'age': 22

}

r = requests.get("http://httpbin.org/get", params=data)

print(r.text)

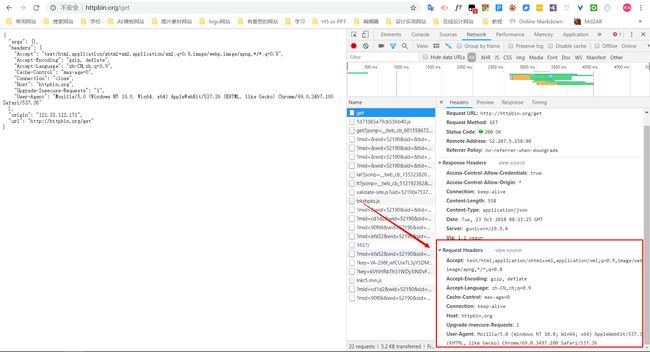

添加Headers

有时候也可以通过headers参数来传递头信息。

有些网站需要添加Headers才能正常请求。

比如知乎

import requests

r = requests.get("https://www.zhihu.com/explore")

print(r.text)

正常访问应该是可以的。

让我们添加头部

import requests

# 可在浏览器的network找得到

headers = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'

}

r = requests.get("https://www.zhihu.com/explore", headers=headers)

print(r.text)

得到源代码

POST请求

post请求就是模拟表单提交,把数据提交到服务器上

用requests实现post请求同样很简单

import requests

data = {'name': 'germey', 'age': '22'}

r = requests.post("http://httpbin.org/post", data=data)

print(r.text)

返回结果中的form部分就是提交的数据,就可以证明post请求成功

Response

发送requests请求后,自然就是response响应,上面的实例都是获取到了response内容。

我们可以通过很多方法或属性获取到其他的信息。

例如Headers,cookies,status code等

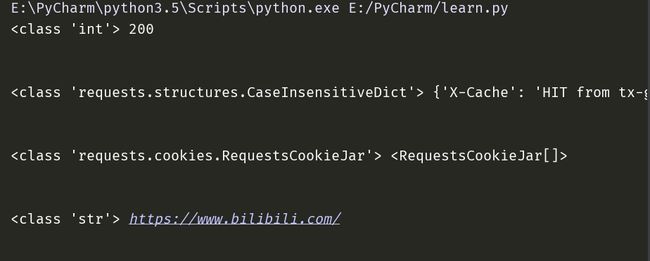

import requests

r = requests.get('https://www.bilibili.com/')

print(type(r.status_code), r.status_code)

print('\n')

print(type(r.headers), r.headers)

print('\n')

print(type(r.cookies), r.cookies)

print('\n')

print(type(r.url), r.url)

超时设置

有时网络不好,请求一个网站就会很慢或者无响应,会等待很久。为了防止服务器不能及时响应,我们可以设置一个响应时间。

即超过这个时间还没得到响应,那就报错

import requests

r = requests.get('https://www.taobao.com', timeout=1)

print(r.status_code)

## 结果

# 200

如果timeout=0.0001就会出错,如图。

代理设置

对于爬虫,就是需要频繁的请求,那就容易要输入验证码,甚至把你的IP封禁,这样就不能再访问这个网站了。这就是现在所谓的反爬机制。

为了防止这种情况发生,需要代理IP来解决这个问题。

import requests

# 代理IP

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'http://10.10.1.10:1080',

}

requests.get('https://www.taobao.com', proxies=proxies)

代理IP有免费的,收费的。但一般收费的才比较稳。

实例

下面我们要把知乎的搜索的热题都给爬取下来

首先前面讲过,访问这个网站需要headers

其次这个需要用正则表达式匹配。

让我们看看知乎今日最热模块的代码分析

# 知乎搜索遍历

import requests

import re

headers = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'

}

r=requests.get("https://www.zhihu.com/explore", headers=headers)

print(r.text)

pattern = re.compile('explore-feed.*?question_link.*?>(.*?)',re.S)

titles = re.findall(pattern,r.text)

print(titles)

看结果

['\n为什么faker没进总决赛没人骂,UZI拿了8强舆论一边倒?\n', '\n如何评价罗云熙在《快乐大本营》的表现?\n', '\n为什么有些人能够在受挫后百折不挠,有些人却会在即使前景还是很光明的情况下很快放弃?\n', '\n如何看待酒泉市男孩被七八只野狗咬伤,医院公布血腥图片引发争议事件?\n', '\n有哪些已经堕落了的公司,为什么?\n', '\n抛开粉丝滤镜,金泰亨现在的颜是否下滑?\n', '\n有什么影视剧让你觉得可惜?\n', '\n你们见过最逆天的女主设定是什么样的?\n', '\n如何看待华晨宇歌迷一致要求经纪人王桂红辞职事件?\n', '\n有哪些惊艳到你的句子?\n']

可以看出各标题都给爬取下来了。格式什么的都是浮云,我就懒得调了。

-not end-

python学习笔记