NeurIPS 2021 | CDN:首个融合two-stage和one-stage思想的HOI检测方法

近日,阿里巴巴淘系技术多媒体算法团队与计算机视觉青年学者刘偲副教授团队合作论文 CDN:《Mining the Benefits of Two-stage and One-stage HOI Detection》 被 NeurIPS 2021 接收,全部代码及模型均已开源。

作为当前全球最负盛名的AI学术会议,NeurIPS是每年学界的重要事件。NeurIPS全称为Neural Information Processing Systems,神经信息处理系统大会,通常每年12月举办,讨论内容包含深度学习、计算机视觉、大规模机器学习、学习理论、优化、稀疏理论等众多细分领域。今年NeurIPS共有9122篇有效论文投稿,总接受率为26%。

本次合作论文在业界首次提出融合two-stage和one-stage思想的transformer-based HOI检测方法,大幅刷新了HOI领域多个数据集的指标。截止到发稿,本文为公开发表(含Arxiv)的HOI数据集的性能SOTA。

地址:

Arxiv:https://arxiv.org/abs/2108.05077

Github:https://github.com/YueLiao/CDN

背景

随着电商业务的深入发展,淘宝直播、逛逛、点淘等基于视频多媒体内容的业务形式正在成为淘宝内容消费种草和导购的主流模式,针对视频多媒体内容的深度内容理解与结构化成为视频业务提质提效的关键。

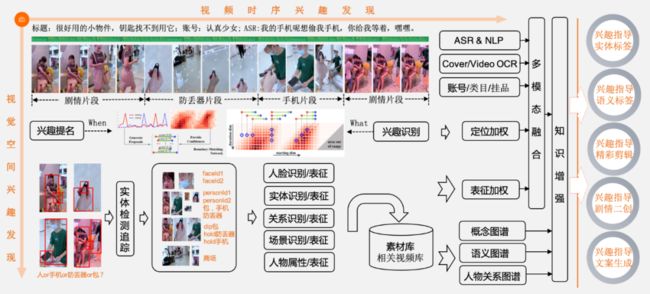

如图1所示,我们需要从海量的复杂视频中提取人、物、事、时、空的结构化信息,挖掘指向用户兴趣的视频核心时间片段和核心实体、事件、关系、意图指向、情感倾向,从而达到多层次认知和推理,进而为下游的标签、检索、生产等任务提供更精准的多模态输入。

视频内容相较于图文,信息量成倍增长,语义表达更复杂,人物关系更多样,情感表达更丰富,使得该技术领域面临了巨大的技术挑战。我们在解决点淘场景下的视频/直播在空间维度上的兴趣发现和定位问题时,沉淀下来了视频空间兴趣定位的技术能力,并在相应HOI领域学术数据集上进行验证,在NeurIPS 2021上录用了文章,具体将在下文介绍。

图1:基于兴趣发现的视频内容理解示意图

摘要

在人物交互关系检测(Human-Object Interaction Detection, HOI)领域,两阶段范式是相对传统的方法,一阶段范式是近期开始流行起来的方法。我们探索了两阶段和一阶段范式各自的优缺点:两阶段范式主要受限于如何定位有关系的人-物对,而一阶段范式主要受限于如何权衡实体检测和关系分类的多任务学习。因此,如何发扬这两种范式各自的优势和抑制两种范式各自的劣势,成为一个核心问题。

我们提出了一种新颖的一阶段范式:通过级联的方式来解耦人-物对检测和关系分类。即,采用去掉关系分类多任务学习的一阶段范式作为人-物对检测器,然后设计一个独立的关系分类器来确定人-物对的关系类别。这样,两个级联的解码器可以解耦地分别关注人-物对检测和关系分类任务。

具体实施上,我们采用了基于transformer的HOI检测器来实现我们的设计。通过这种解耦的HOI检测范式,我们在两个大规模HOI数据集上都实现了目前业绩最优的效果,在HICO-DET和V-COCO上的mAP分别相对提升了9.32%和5.94%。

动机

如图2所示,传统两阶段范式把HOI检测任务![]() 分解成检测

分解成检测![]() 和分类

和分类![]() 两个阶段。在第一阶段,

两个阶段。在第一阶段,![]() 预测

预测![]() 个人的检测框和

个人的检测框和![]() 个物体的检测框,因此产出

个物体的检测框,因此产出![]() 个人-物对。实际上,真正有关系的人-物对只有

个人-物对。实际上,真正有关系的人-物对只有![]() 个,远远小于

个,远远小于![]() 。但是,在第二阶段,

。但是,在第二阶段,![]() 需要逐个遍历

需要逐个遍历![]() 个关系对并预测置信度。这种范式产生三个问题:一是产生了大量的额外计算消耗,

个关系对并预测置信度。这种范式产生三个问题:一是产生了大量的额外计算消耗,![]() ;二是正例负例不均衡导致模型容易对负例过拟合,尤其是容易误判为“no-interaction”类;三是

;二是正例负例不均衡导致模型容易对负例过拟合,尤其是容易误判为“no-interaction”类;三是![]() 与

与![]() 采用相同的特征输入,但前者关注语义特征,而后者关注实体边缘特征,两者相互干扰。

采用相同的特征输入,但前者关注语义特征,而后者关注实体边缘特征,两者相互干扰。

一阶段范式或是以多任务方式直接提取人-物对和关系类别,即![]() ;或是以并行结构分别提取人-物对和关系类别,再通过额外的offset预测来做关联,即

;或是以并行结构分别提取人-物对和关系类别,再通过额外的offset预测来做关联,即![]() 。这两种一阶段方法,都端到端提取了人-物对,使得计算复杂度降为

。这两种一阶段方法,都端到端提取了人-物对,使得计算复杂度降为![]() ,并直接提取有关系的人-物对对应的特征,从而降低了负例的干扰。但他们都受限于多任务学习导致的特征权衡问题,也就是使用统一的特征表达来处理非常不同的任务,导致任务之间性能受到干扰。

,并直接提取有关系的人-物对对应的特征,从而降低了负例的干扰。但他们都受限于多任务学习导致的特征权衡问题,也就是使用统一的特征表达来处理非常不同的任务,导致任务之间性能受到干扰。

因此,我们针对这两种范式各自的优缺点,提出了一种如图1 (d)所示的新结构,Cascade Disentangling Network (CDN)。我们保留了一阶段范式的优点:直接预测有关系的人-物对;同时引入了两阶段范式的优势:把关系分类和人-物检测解耦。这是一种级联的一阶段范式,第一个解码器用于预测人-物对,即![]() ,第二个独立的解码器用于预测关系类别,即

,第二个独立的解码器用于预测关系类别,即![]() 。

。

图 2:两阶段范式与一阶段范式对比分析

方法

我们采用基于transformer的HOI检测器来实现我们的设计,并使用了DETR [1]的基础模型结构。在这个结构中,N层解码器把视觉编码器输出的特征![]() ,区分特征相对位置的向量

,区分特征相对位置的向量![]() ,和一系列可学习的输入向量

,和一系列可学习的输入向量![]() 作为输入。通过自注意力(self-attention)和多头互注意力(multi-head co-attention)机制,以及包含分类或回归的目标训练任务,输入向量

作为输入。通过自注意力(self-attention)和多头互注意力(multi-head co-attention)机制,以及包含分类或回归的目标训练任务,输入向量![]() 被解码为含有位置或类别信息的输出向量

被解码为含有位置或类别信息的输出向量![]() 。每个解码器可以表示为:

。每个解码器可以表示为:

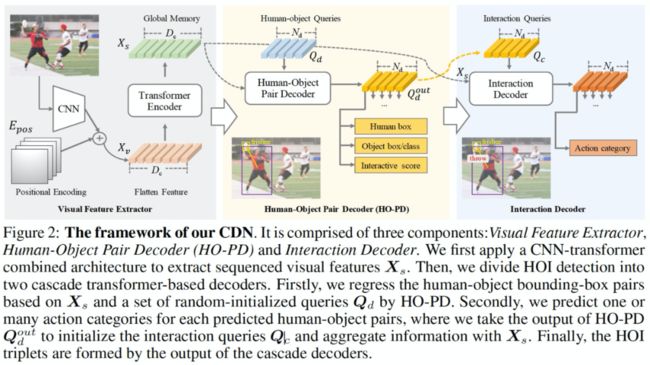

图3:Cascade Disentangling Network (CDN)框架图

我们提出的CDN结构框架如图3所示。首先,我们设计了Human-Object Pair Decoder (HO-PD)结构来把随机初始化的输入向量![]() 解码成输出向量

解码成输出向量![]() 。解码过程采用的训练任务为人的检测框回归,物体的检测框归回,物体的类别分类和是否有关系的置信度预测。在这种训练任务下,

。解码过程采用的训练任务为人的检测框回归,物体的检测框归回,物体的类别分类和是否有关系的置信度预测。在这种训练任务下,![]() 可以表征一系列的人-物对。这个解码过程可以表示为:

可以表征一系列的人-物对。这个解码过程可以表示为:

接下来,我们提出了一个独立的解码器对HO-PD输出的每个表征一个人-物对的向量![]() 分配一个或多个关系类别。这其中一个关键设计是,关系解码器采用的输入向量

分配一个或多个关系类别。这其中一个关键设计是,关系解码器采用的输入向量![]() 不再是随机初始化的向量,而是HO-PD的输出向量

不再是随机初始化的向量,而是HO-PD的输出向量![]() ,这样可以利用HO-PD训练得到的先验知识,对

,这样可以利用HO-PD训练得到的先验知识,对![]() 表征的每一个人-物对进行关系类别解码,通过关系分类训练任务,解码得到的输出向量

表征的每一个人-物对进行关系类别解码,通过关系分类训练任务,解码得到的输出向量![]() 可以表征关系类别。关系解码器可以表示如下。

可以表征关系类别。关系解码器可以表示如下。

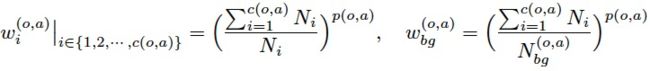

在训练过程中,针对HOI数据存在的长尾类别分布问题,我们提出了一种动态加权机制。我们首先用常规的损失函数训练模型,然后固定视觉编码器的参数,用一个使用小学习率和动态加权策略的损失函数来单独训练两个级联的解码器。动态加权分别作用于物体类别![]() 和关系类别

和关系类别![]() 。在训练过程中,通过队列截断训练时间窗口来累计样本数,

。在训练过程中,通过队列截断训练时间窗口来累计样本数,![]() 为每个类别累计的样本数,

为每个类别累计的样本数,![]() 为背景类累计的样本数。动态加权机制使用的类别权重表示如下:

为背景类累计的样本数。动态加权机制使用的类别权重表示如下:

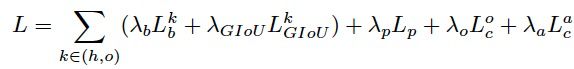

训练过程采用了基于集合匹配的方式,匹配过程对人-物对解码器HO-PD和关系解码器统一端到端匹配。损失函数如下,包含检测框回归![]() ,检测框交并比

,检测框交并比![]() ,交互关系置信度

,交互关系置信度![]() ,物体类别

,物体类别![]() 和关系类别

和关系类别![]() 。

。

推理:HOI任务的后处理是把模型各模块预测的人、物体和关系组合成可信的<人,物,关系>三元组。在我们的CDN结构设计下,<人检测框,物体检测框,物体类别,交互关系置信度,关系类别>都在输出的向量![]() 和

和![]() 中得到了一一对应,于是,第个向量对应的三元组为

中得到了一一对应,于是,第个向量对应的三元组为![]() ,其中三元组置信度为

,其中三元组置信度为![]() 。对

。对![]() 进行降序排序并取

进行降序排序并取![]() 个三元组后,我们设计了一种pair-wise non-maximal suppression (PNMS)策略,来成对的过滤人-物对检测框,计算过滤PIoU的公式如下。

个三元组后,我们设计了一种pair-wise non-maximal suppression (PNMS)策略,来成对的过滤人-物对检测框,计算过滤PIoU的公式如下。

实验

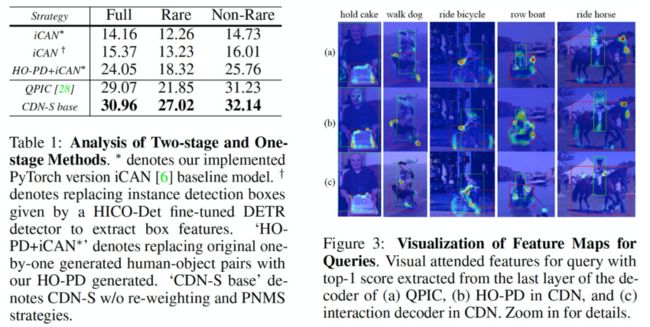

我们首先验证了CDN中HO-PD模块的设计在特征上是否有效。如图4,我们使用HO-PD的人-物对替换经典两阶段方法iCAN [2]的通过检测框遍历组合出来的人-物对,在计算量从![]() 下降到

下降到![]() 的情况下,mAP指标从15.37提升到了24.05,证明HO-PD的设计确实可以通过抑制负例,在节省计算量的同时提升人-物对提名的质量。进而,完整的CDN结构,在没有动态加权和PNMS机制加成的情况下,指标达到了30.96。图4右侧显示了特征图,HO-PD关注有关系的人和物体的边缘,例如<人,拿,蛋糕>三元组的人体和蛋糕边缘部位,而CDN的关系解码器更关注关系的语义特征,例如<人,骑,马>三元组的牵缰绳部位。

的情况下,mAP指标从15.37提升到了24.05,证明HO-PD的设计确实可以通过抑制负例,在节省计算量的同时提升人-物对提名的质量。进而,完整的CDN结构,在没有动态加权和PNMS机制加成的情况下,指标达到了30.96。图4右侧显示了特征图,HO-PD关注有关系的人和物体的边缘,例如<人,拿,蛋糕>三元组的人体和蛋糕边缘部位,而CDN的关系解码器更关注关系的语义特征,例如<人,骑,马>三元组的牵缰绳部位。

图4:CDN方法验证及特征图分析

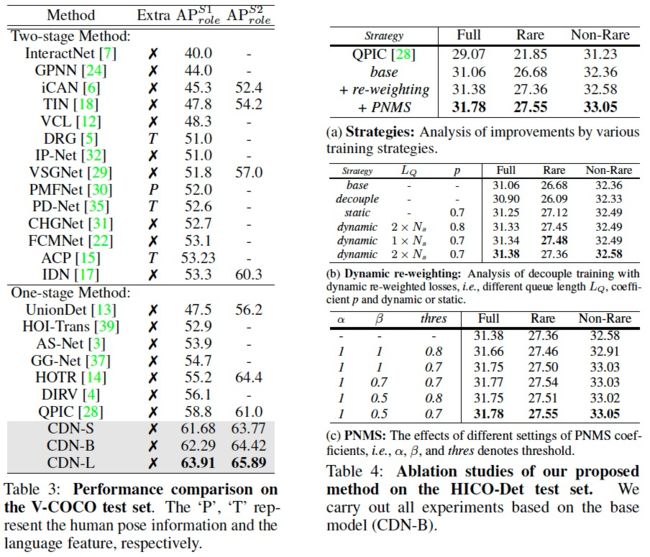

我们在HICO-DET数据集[3]上验证了三种结构的CDN:基于ResNet-50的3-layer解码器的CDN-S,基于ResNet-50的6-layer解码器的CDN-B,和基于ResNet-101的6-layer解码器的CDN-L。CDN表现超过了全部已知的两阶段和一阶段方法,在不使用人体关键点和语言特征等额外特征的情况下,最高指标达到了32.07 mAP。

图5:HICO-Det数据集实验结果

我们也在V-COCO数据集[4]上验证了CDN。CDN表现同样超过了全部已知的两阶段和一阶段方法,在没有人体关键点和语言特征等额外特征条件下,Scenario 1的role mAP达到了63.91,Scenario 2的role mAP达到了65.89。图6右侧表格中的消融实验,验证了CDN主体结构设计,以及动态加权机制和PNMS机制的有效性。

图6:V-COCO数据集实验结果及消融实验

总结与展望

本文在详细分析HOI检测任务现有的两阶段范式和一阶段范式的优缺点之后,提出了以级联方式解耦人-物对检测和关系分类的CDN方法,在保持一阶段范式的计算效率和直接定位有关系的人-物对来提升精度的同时,引入了两阶段范式的回归和分类解耦的思想,在HOI任务上达到了性能SOTA。

同时,我们指出了把适用于两阶段范式的种种创新方法引入到一阶段范式中,是一种不错的提升性能的解决方案。我们在文中只实施了一种引入两阶段范式的核心解耦思想到一阶段范式中的基于transformer的HOI方案,未来还可以做更多的尝试。

参考文献

[1] End-to-end object detection with transformers. In ECCV, 2020.

[2] ICAN: Instance-centric attention network for human-object interaction detection. In BMVC, 2018.

[3] Learning to detect human-object interactions. In WACV, 2018.

[4] Visual semantic role labeling. arXiv preprint arXiv:1505.04474, 2015.

✿ 拓展阅读

作者|少麟、索塔、刘偲、叶盈、咏亮、高晨、篱悠

编辑|橙子君

出品|阿里巴巴新零售淘系技术