Python 搭建 AI 健身评分系统

作者|李秋键

来源|AI科技大本营(ID:rgznai100)

![]()

引言

人工智能作为计算机科学的一个分支,其主要是将人的思维与计算机网络相结合,令整个系统在对某一类事物进行处理时实现人工智能化分析,然后结合内部程序的设定,分析出当前事务处理所具备的各类功能如何实现。人工智能作为一项综合性学科,其在发展过程中可分为低级、中级、高级三个阶段,通过技术体系的逐步更新,人们将思维意识与计算机网络系统形成深度融合,利用人工智能体系在社会事务处理中实现智能化转变,以此来达到人力资源节约的效果。

将人工智能与体育产业的融合是指通过智能化体系的融合,体育产业以及其关联行业在发展过程中可对数据信息进行精准分辨,尤其是在大数据发掘技术的作用下,各类工作机制的建设可通过行业领域业务拓展实现技术性融合。然而,从现阶段实际应用趋势来看,人工智能与体育产业的融合无法得到有效基准的制定,这就造成相关职能部门在制定规范制度时,无法将人工智能与体育产业进行深度分析,令制度本身缺乏有效监管性。除此之外,体育产业作为综合型项目,人工智能体系的应用,无法覆盖到整个体育产业链中,只要造成体育项目在实际开展中无法形成合理、科学性的基准,进而令地区体育项目的发展无法达成一致,在一定程度上,将令体育产业形成以地区为主导的滞后性发展现象。

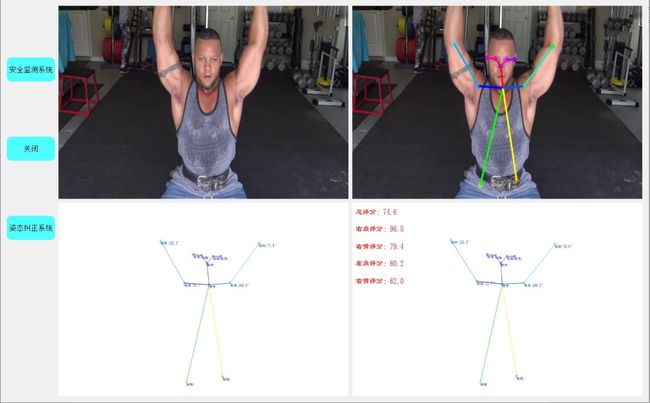

本项目使用姿态估计技术,提取人体关键点后,对不同人体肢节进行组合,实时评估骨骼向量角数据,并根据人体向量角数据与建立好的标准动作比对,给出各肢体评分,和总评分。在这里我们以举哑铃动作为例,搭建我们的智能健身评分系统:

![]()

1、系统使用

本系统主要使用的人体姿态估计技术。需要用到的知识点有openpose姿态估计算法、向量角组合和计算,评估准则的判定。

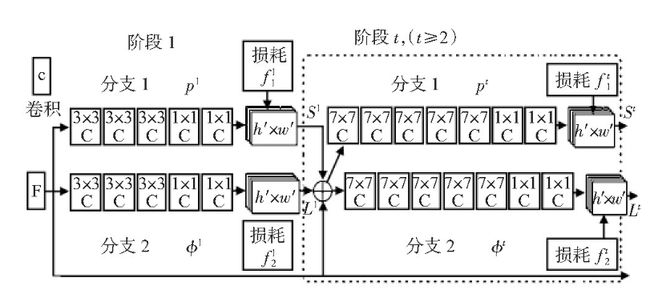

1.1 openpose姿态估计

Open Pose实时姿态监测估计算法是由卡内基梅隆大学的一个团队最先提出的。此算法使用一种叫做人体关键点亲和域的方法连接人体关键点。图中的网络结构分支1的S1代表一组关键点,分支2的Ll代表连接这些关键点的亲和向量。重复此步,可以得到一个所有2D关键点的集合S和关键点相关度的向量集合L,再根据相关度连接将得到一个近似度高的棍型图。所采用的数据集是COCO和MPI,并且收集了试验者执行的不同活动并与计算机相关联,既能检测人体,也能感知到周围环境中的信息。

Open Pose提供了23个精确的身体部位,包括肩膀、肘部、手腕、臀部、膝盖、脚踝等。为了减少数据集的冗余,系统参考不同身体关节的视觉效应,根据人体结构和运动特征将关节分成不同的组,并给每个关节分配不同的权重。

1)面部五官:面部关节分布集中密集,活动范围小。它们很少表现出明显的独立运动。

2)躯干关节:躯干关节包括肩关节、脊椎中心和臀部,它们体现了身体运动位移的主要趋势,是连接身体和四肢的枢纽。

3)一级关节:一级关节包括肘关节和膝关节,包含大量关于四肢动作的信息。当身体旋转和弯曲时,它在视觉上相对躯干关节有更重要的作用。

4)二级连接:二级连接部位包括手腕和脚踝。手腕和踝关节比肘关节和膝盖点延伸得更长,给人留下更加明显的视觉印象。

5)三级连接:三级点包含右手、右臀、右脚、左手、左臀和左脚。手和脚是手腕和脚踝的延伸,没有明显的视觉印象。

1.2标准动作

在这里我们设置标准动作如下:

作为标准动作,统计出各个骨骼关键点坐标,并根据不同骨骼坐标点组合形成向量角,并计算不同关节之间的向量角作为标准。

1.3评估标准

对摄像头视频流或者本地视频流数据实时计算各个关键点角度,并逐一对比,并可视化。计算公式按照欧氏距离做出最简单评估即可。

![]()

2、模型实验

2.1 环境搭建

1、首先下载好完整无误配置好的代码(包括模型等等,见文末)。

2、整个多目标动作监测系统的搭建主要是依赖于openpose的姿态识别环境。而openpose的基本环境依赖于python,CUDA和swig的支持,其中python是作为openpose的代码编写和运行工具,CUDA作为调用显卡训练测试的必须软件需要和python版本有一定的关系,swig目的在于给openpose编译环境。根据openpose官方提供的cmu模型、mobilenet_thin模型、mobilenet_v2_large模型和mobilenet_v2_small模型的评价,我们选择了cmu模型作为姿态识别的调用模型,主要原因在于cmu具有更高一些的识别精度。

Openpose的调用在这里通过调用其中设定好的主函数即可,其中包括模型加载程序、调用程序以及Estimator评估等等。

3、配置好python的cuda环境,以及opencv、pyqt5等基础环境。

4、运行GUI.py主界面,点击按钮即可。

2.2 姿态估计

这里设置默认的标准动作位为'Standard/1.jpg',默认使用模型为cmu模型。按照标准的姿态估计配置,设置代码如下:

parser = argparse.ArgumentParser(description='tf-pose-estimation run')

parser.add_argument('--image', type=str, default='Standard/1.jpg')

parser.add_argument('--model', type=str, default='cmu',

help='cmu / mobilenet_thin / mobilenet_v2_large / mobilenet_v2_small')

parser.add_argument('--resize', type=str, default='0x0',

help='if provided, resize images before they are processed. '

'default=0x0, Recommends : 432x368 or 656x368 or 1312x736 ')

parser.add_argument('--resize-out-ratio', type=float, default=4.0,

help='if provided, resize heatmaps before they are post-processed. default=1.0')

args = parser.parse_args()

w, h = model_wh(args.resize)

if w == 0 or h == 0:

e = TfPoseEstimator(get_graph_path(args.model), target_size=(432, 368))

else:

e = TfPoseEstimator(get_graph_path(args.model), target_size=(w, h))2.3角度计算

计算需要使用到的关节角度,分别为右键、右手臂、左键、左手臂。代码如下:

image1 = TfPoseEstimator.draw_humans(image, humans, imgcopy=True)

cv2.imwrite("../img1.jpg", image1)

f = open("../img1.txt", 'w')

f.close()

line = Vector([0, 100])

'''角度'''

try:

# 右肩5

RShoulder = Vector(list_sub(skeleton[5], skeleton[6]))

RShoulder_angel = line.angle_with(RShoulder)

Angels[5]=str(round(RShoulder_angel,1))+"°"

# 右手臂6

RElbow = Vector(list_sub(skeleton[6], skeleton[7]))

RElbow_angel = line.angle_with(RElbow)

Angels[6] = str(round(RElbow_angel, 1)) + "°"

# 左肩3

LShoulder = Vector(list_sub(skeleton[2], skeleton[3]))

LShoulder_angel = line.angle_with(LShoulder)

Angels[2] = str(round(LShoulder_angel, 1)) + "°"

# 左手臂4

LElbow = Vector(list_sub(skeleton[3], skeleton[4]))

LElbow_angel = line.angle_with(LElbow)

Angels[3] = str(round(LElbow_angel, 1)) + "°"

state=True

except:

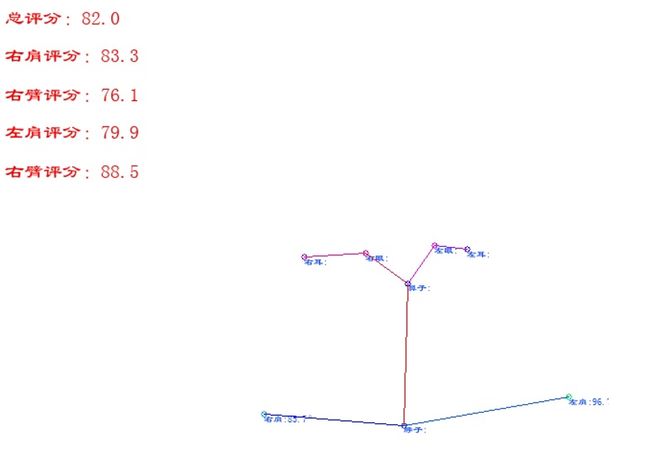

pass2.4 评分可视化

在获取到角度值后,设置各个角度评分为(1 - abs((RShoulder_angel - Standard[i]) / Sum_Standard)) * 100,即最高分为100分,最低分为0分。其中标准对比值由标准动作自行计算,放入数组即可,代码如下:

if state:

'''评分'''

Standard = [150, 10, 150, 10]

Sum_Standard = sum(Standard)

Score1 = (1 - abs((RShoulder_angel - Standard[0]) / Sum_Standard)) * 100

Score2 = (1 - abs((RElbow_angel - Standard[1]) / Sum_Standard)) * 100

Score3 = (1 - abs((LShoulder_angel - Standard[2]) / Sum_Standard)) * 100

Score4 = (1 - abs((LElbow_angel - Standard[3]) / Sum_Standard)) * 100

Avg_Score=(Score1+Score2+Score3+Score4)/len(Standard)

myfont = ImageFont.truetype(r'C:/Windows/SIMLI.TTF', 20)

image2 = Image.fromarray(cv2.cvtColor(image2, cv2.COLOR_BGR2RGB))

draw = ImageDraw.Draw(image2)

draw.text((10, 10), "总评分:"+str(round(Avg_Score,1)), font=myfont, fill=(255, 0, 0))

draw.text((10,50), "右肩评分:"+str(round(Score1,1)), font=myfont, fill=(255, 0, 0))

draw.text((10, 90), "右臂评分:" + str(round(Score2, 1)), font=myfont, fill=(255, 0, 0))

draw.text((10, 130), "左肩评分:" + str(round(Score3, 1)), font=myfont, fill=(255, 0, 0))

draw.text((10, 170), "右臂评分:" + str(round(Score4, 1)), font=myfont, fill=(255, 0, 0))

image2 = cv2.cvtColor(np.asarray(image2), cv2.COLOR_RGB2BGR)运行过程如下可见,在这里通过双击“启动.bat”即可直接运行:

完整代码:

附行为安全监测系统见文章

https://blog.csdn.net/dQCFKyQDXYm3F8rB0/article/details/120299561。

姿态估计代码:

链接:

https://pan.baidu.com/s/1vkc1EQuaAUMqoaegkdZ_pA

提取码:i46w

健身评分系统代码:

https://download.csdn.net/download/qq_42279468/33154887

李秋键,CSDN博客专家,CSDN达人课作者。硕士在读于中国矿业大学,开发有taptap竞赛获奖等。

往

期

回

顾

资讯

AI 将有自我视觉?Facebook正在研究新系统

资讯

微软、英伟达联手推出最大语言模型

资讯

“倚天”一出,谁与争锋?阿里发布云芯片

技术

ST-GCN 实现人体姿态行为分类

分享

点收藏

点点赞

点在看