完整的模型验证套路————PyTorch(完结)

哔哩大学的PyTorch深度学习快速入门教程(绝对通俗易懂!)【小土堆】

的P32讲介绍了利用上几节的模型,从网上找了一张狗的图片进行验证。

所用图片为:

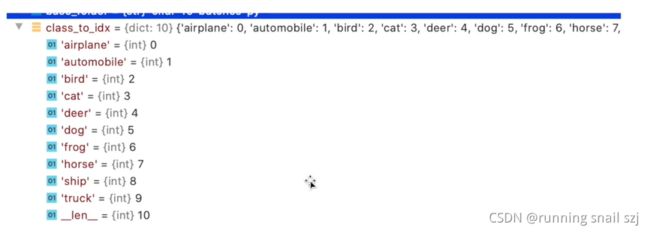

上几节的CIFAR10模型的每个序列对应的真实类别如图:

他的意思是,若输出为tensor([0]),则代表识别图片结果为 飞机。同理输出为tensor([5]),则代表识别图片结果为 狗。

上图片若结果为第5个类别的概率最大,输出tensor([5])则验证成功!

代码看不懂可以看前面帖子(完整的模型训练套路(一)————PyTorch),有详细的注释。

代码注释为:

其中tudui_0.pth为上几节保存的文件,这个代码要用最开始cpu训练的模型。

import torch

import torchvision

from PIL import Image

from torch import nn

image_path = "imgs/dog.png"

image = Image.open(image_path)

print(image)

image = image.convert('RGB')

# 因为png格式为四个通道,除了RGB三个通道外,还有一个透明度通道。所以调用此语句保留其颜色通道。

transform = torchvision.transforms.Compose([torchvision.transforms.Resize((32, 32)),

torchvision.transforms.ToTensor()])

# 这个照片size=258x208,因为模型为32×32,所以改一下

image = transform(image)

print(image.shape)

# 加载网络模型

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

# 为了避免上下两个def都写一整串,将整个网络放到序列当中,前边有讲过,注释了很多代码有老乡的那一篇

self.model = nn.Sequential(

nn.Conv2d(3, 32, 5, 1, 2), # 卷积

nn.MaxPool2d(2), # 池化

nn.Conv2d(32, 32, 5, 1, 2),

nn.MaxPool2d(2),

nn.Conv2d(32, 64, 5, 1, 2),

nn.MaxPool2d(2),

nn.Flatten(),

nn.Linear(64*4*4, 64), # 最后两步的展平

nn.Linear(64, 10)

)

def forward(self, x):

x = self.model(x)

return x

model = torch.load("tudui_0.pth")

print(model)

# img输入到这个模型中

# 这里一开始用的gpu的模型,会报错,换成cpu的"tudui_0.pth"模型就行了

image = torch.reshape(image, (1, 3, 32, 32))

model.eval()

with torch.no_grad():

output = model(image)

print(output)

print(output.argmax(1))

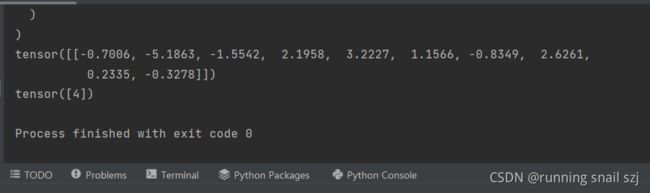

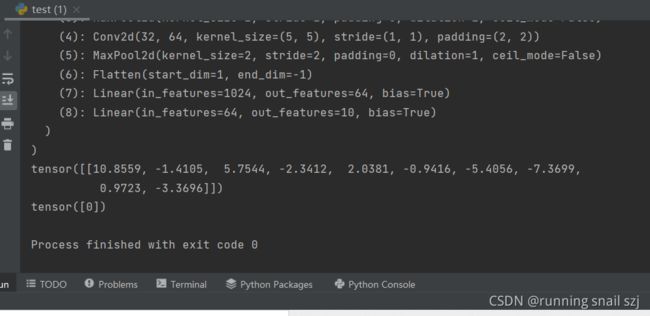

结果如图:

很遗憾,没有验证对,识别成了青蛙。这是因为训练了10次,次数不够。我们用GPU进行30次训练再试一次。

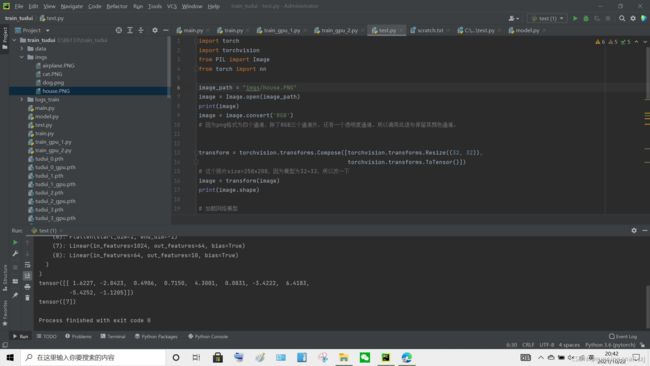

还是这个代码,有一个细节的修改,在!!!处注释了。这次用的30次训练后的gpu模型

import torch

import torchvision

from PIL import Image

from torch import nn

image_path = "imgs/dog.png"

image = Image.open(image_path)

print(image)

image = image.convert('RGB')

# 因为png格式为四个通道,除了RGB三个通道外,还有一个透明度通道。所以调用此语句保留其颜色通道。

transform = torchvision.transforms.Compose([torchvision.transforms.Resize((32, 32)),

torchvision.transforms.ToTensor()])

# 这个照片size=258x208,因为模型为32×32,所以改一下

image = transform(image)

print(image.shape)

# 加载网络模型

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

# 为了避免上下两个def都写一整串,将整个网络放到序列当中,前边有讲过,注释了很多代码有老乡的那一篇

self.model = nn.Sequential(

nn.Conv2d(3, 32, 5, 1, 2), # 卷积

nn.MaxPool2d(2), # 池化

nn.Conv2d(32, 32, 5, 1, 2),

nn.MaxPool2d(2),

nn.Conv2d(32, 64, 5, 1, 2),

nn.MaxPool2d(2),

nn.Flatten(),

nn.Linear(64*4*4, 64), # 最后两步的展平

nn.Linear(64, 10)

)

def forward(self, x):

x = self.model(x)

return x

# model = torch.load("tudui_0.pth") # 这里一开始用的gpu的模型,会报错,换成cpu的"tudui_0.pth"模型就行了

model = torch.load("tudui_29_gpu.pth", map_location=torch.device('cpu'))

# gpu的训练模型的话,上边这个指令代替上边的上边那个指令

# !!!!!!!!!!!!!!!!!!!

print(model)

# img输入到这个模型中

image = torch.reshape(image, (1, 3, 32, 32))

model.eval()

with torch.no_grad():

output = model(image)

print(output)

print(output.argmax(1))

人工智障!!!!!!!!!!!!!!!

但是,up主的图片识别出来了,

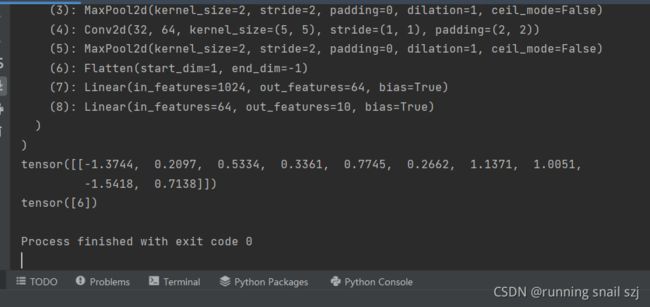

我们换个图片再试一遍。换个飞机✈,如图:

这次算对啦!

CIFAR10模型第0个是飞机:正确!!!!

再来个,房子:

我还试了猫的图片,可惜算成了dog,实验了卡车和房子都正确。

up说这个模型的正确率为60%