深度学习的十年经典之作

写在前面的话: 看了“机器之心”的告别2019:属于深度学习的十年,那些我们必须知道的经典,总结回顾了从2011年至今的深度学习发展。看完之后感觉干货满满,所以特意mark下来留给自己,也留给对深度学习有兴趣的你。

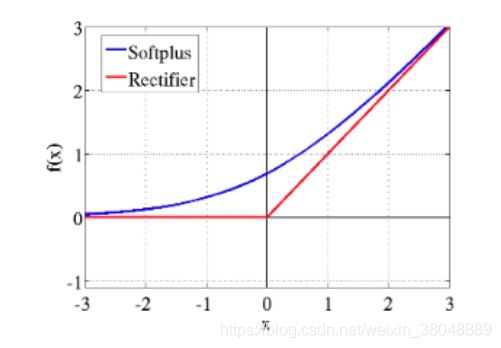

2011 年:激活函数 ReLU

《Deep Sparse Rectifier Neural Networks(ReLU)》

论文链接(被引用量 4071)

在此之前,主流激活函数是sigmod,但是随着网络层次加深sigmod会出现梯度消失的现象,导致模型学不到东西了。ReLU有效的解决了梯度消失问题,目前ReLU已经被广泛的应用到深度学习实践中。

当然,ReLU 也有一些缺点。在函数为 0 的时候不可微,而神经元可能会「死亡」,也就是梯度为0。在 2011 年之后,很多针对 ReLU 的改进也被提了出来。

年度荣誉提名:(这一年的大部分研究集中于对激活函数的改进)

1、《Rectifier Nonlinearities Improve Neural Network Acoustic Models(Leaky ReLU)》

基于对 ReLU 进行了改进的激活函数,在 x 为负时不取 0。

论文链接

2、《Fast and Accurate Deep Network Learning by Exponential Linear Units (ELUs)》

论文链接

3、《Self-Normalizing Neural Networks(SELUs)》

论文链接

4、《Gaussian Error Linear Units (GELUs)》

这一激活函数已证明比 ReLU 效果更好,BERT 等模型已使用。

论文链接

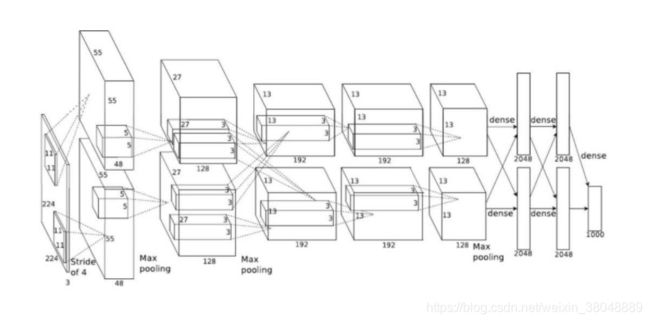

2012 年:掀起深度学习浪潮的 AlexNet

《ImageNet Classification with Deep Convolutional Neural Networks(AlexNet)》

论文链接(被引用量 52025)

AlexNet 经常被认为是这一波人工智能浪潮的起点,该网络在ImageNet挑战赛上吊打上一届的冠军和同届亚军,错误率与前一届冠军相比减小了 10% 以上,比亚军高出 10.8 个百分点。

AlexNet 是一个 8 层的卷积神经网络,使用 ReLU 激活函数,总共有 6 千万参数量。AlexNet 的最大贡献在于证明了深度学习的能力。它也是第一个使用并行计算和 GPU 进行加速的网络。

从此之后,各种层数更多,效果更好的网络不断出现,使得一些基于图像应用能够被广泛的应用。这几年基于内容的应用如此火热(新闻推荐类应用,各大垂直社区,直播,小视频等),与此技术有千丝万缕的联系。

年度荣誉提名:

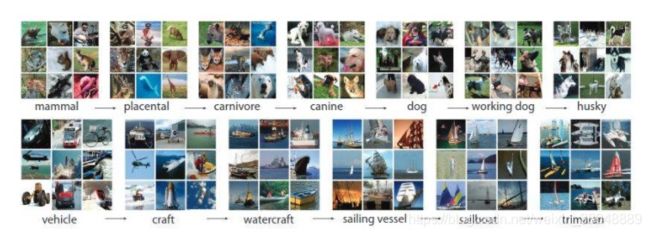

1、《ImageNet: A Large-Scale Hierarchical Image Database(ImageNet)》

ImageNet 是斯坦福大学李飞飞等人完成的一个用于图像识别的数据集,是计算机视觉领域检验模型性能的基准数据集。

论文链接

2、《Flexible, High Performance Convolutional Neural Networks for Image Classification(Jurgen Schmidhuber 为通讯作者)》

论文链接

3、《Gradient-Based Learning Applied to Document Recognition》

论文链接

2013 年:NLP 的经典 word2vec,开启深度强化学习时代

《Distributed Representations of Words and Phrases and their Compositionality(word2vec)》

论文链接(被引用量 16923)

Word2vec 是由谷歌研究团队里 Thomas Mikolov 等人提出的模型,该模型能从非常大的数据集中计算出用以表示词的连续型向量。Word2Vector技术可以说是深度自然语言处理的基石,在此之后几乎所有的基于深度学习的自然语言处理技术均是使用Word Embedding作为输入,如语言模型,QA系统,机器翻译,自动摘要等等。更难能可贵的是,除了在NLP领域以外,该技术还广泛的应用于物品推荐领域,自动学习物品的特征,提升下游物品推荐的效果。

年度荣誉提名:

1、《GloVe: Global Vectors for Word Representation》

论文链接

2、《Playing Atari with Deep Reinforcement Learning》

论文链接(被引用量 3251)

DeepMind 在这一年提出的用 DQN 玩雅达利游戏开启了深度强化学习研究的大门。强化学习过去大多数情况下用在低维环境中,很难在更复杂的环境中使用。雅达利游戏是第一个强化学习在高维环境中的应用。这一研究提出了 Deep Q-learning 算法,使用了一个基于价值的奖励函数。

年度荣誉提名:

1、《Learning from Delayed Rewards(Q-Learning)》

论文链接

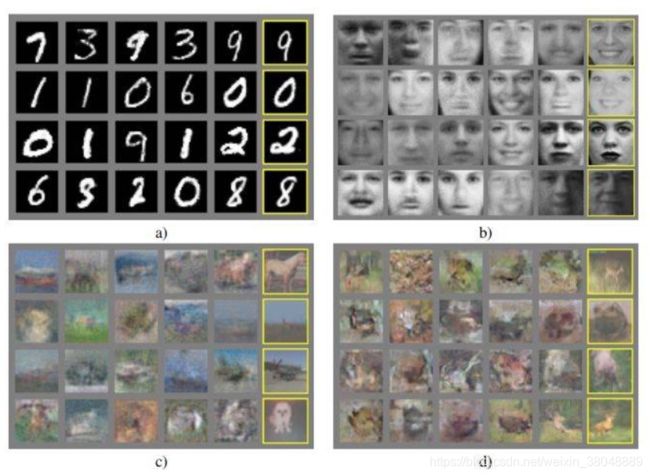

2014 年:GAN;Adam;Attention 机制

《Generative Adversarial Networks》

论文链接(被引用量 13917)

生成对抗网络(Generative Adversarial Network,简称 GAN)核心逻辑是通过两个机器学习互相博弈的架构,使得模型可以通过以往的数据,生成一些新的数据,并且可以使得生成的数据和以往的数据非常类似,达到以假乱真的效果。GAN 在CV(Computer Vision)等领域获得了广泛的关注,比如在游戏领域,可以用GAN自动生成逼真的树,动物,山川等等,减少人力成本。在内容生产领域,可以根据文章内容和素材,使用GAN自动生成插图。

年度荣誉提名:

1、《Wasserstein GAN & Improved Training of Wasserstein GANs(WGAN)》

WGAN 是 GAN 的改进版本,取得了更好的效果。

论文链接

2、《StyleGAN》

论文链接

3、《Neural Machine Translation by Jointly Learning to Align and Translate(attention 机制)》

论文链接(被引用量 9882)

介绍了注意力机制的思路。采用将整个语境保存在内存中的方式取代将所有信息压缩到一个 RNN 的隐层中,这么做的好处使所有输出都能和输入对应。除了在机器翻译中使用外,attention 机制还被用于 GAN 等模型中。

《Adam: A Method for Stochastic Optimization》

论文链接(被引用量 34082)

Adam 由于其易微调的特性而被广泛使用。它基于对每个参数的不同学习率进行适应这种思想。虽然近来有对 Adam 性能提出质疑的论文出现,但它依然是深度学习中最受欢迎的目标函数。

年度荣誉提名:

1、《Decoupled Weight Decay Regularization》

论文地址

2、《RMSProp》

和 Adam 一样出名的目标函数。

论文地址

2015:超越人类的 ResNet;神奇的批归一化

《Deep Residual Learning for Image Recognition》

论文链接(被引用量 34635)

何恺明、张祥雨、任少卿和孙剑研究的 ResNet ,在视觉分类任务上的性能第一次超越了人类。ResNet核心思想是通过在网络中添加一条捷径,使得网络传递中有价值的信息得到保留,该设计与LSTM中的细胞状态。

最初 ResNet 的设计是用来处理深层 CNN 结构中梯度消失和梯度爆炸的问题,如今 Residual Block 已经成为了几乎所有 CNN 结构中的基本构造。

这个想法很简单:将输入(input)从卷积层的每个块添加到输出(output)。残差网络之后的启示是,神经网络不应分解为更多的层数,在最不理想的情况下,其他层可以简单设置为恒等映射(identity mapping)。但在实际情况中,更深层的网络常常在训练上遇到困难。残差网络让每一层更容易学习恒等映射,并且还减少了梯度消失的问题。

尽管并不复杂,但残差网络很大程度上优于常规的 CNN 架构,尤其在应用于更深层的网络上时。

有异曲同工之妙,不知道ResNet的作者们当时是否有借鉴。

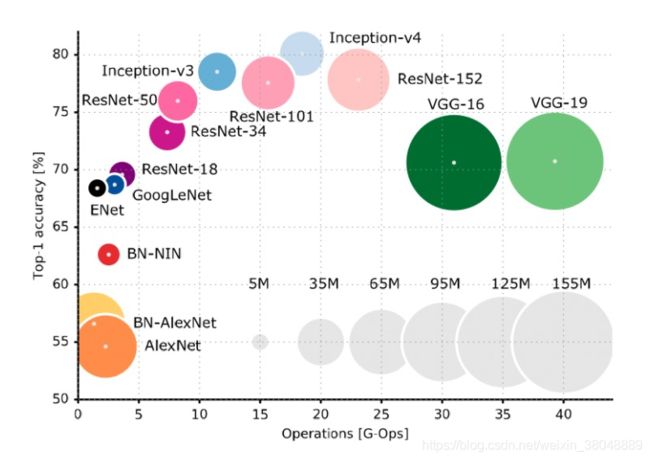

众多 CNN 架构都在争夺「头把交椅」,以下是一部分具有代表意义的样本:

年度荣誉提名:

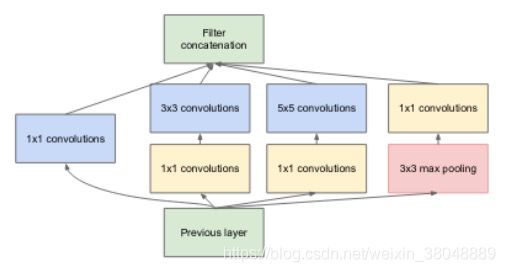

1、《Going Deeper with Convolutions》

论文链接

2、《Very Deep Convolutional Networks for Large-Scale Image Recognition》

论文链接

3、《Neural Ordinary Differential Equations》

论文链接(NIPS 2018 最佳论文奖)

《Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift(批归一化)》

论文链接(14384 次引用)

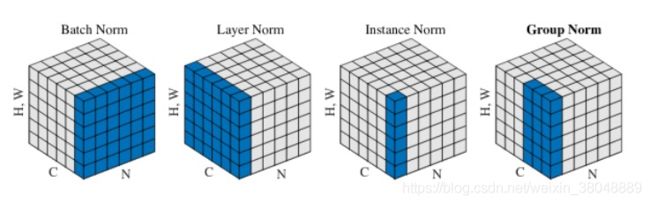

批归一化(Batch normalization)是如今几乎所有神经网络的主流趋势。批归一基于另外一个简单但是很棒的想法:在训练过程中保持均值和方差统计,借此将 activation 的范围变换为零均值和单位方差。

关于批归一化效果的确切原因还未有定论,但从实践上说确实有效的。

年度荣誉提名:

1、《层归一化(Layer Normalization)》

论文链接

2、《实例归一化(Instance Normalization)》

论文链接

3、《组归一化(Group Normalization)》

论文链接

2016 年:攻陷最复杂的游戏——AlphaGo

登上 Nature 的 AlphaGo 论文**《Mastering the game of Go with deep neural networks and tree search》**

论文链接(被引用量 6310)

AlphaGo 研究项目始于 2014 年,目的是为了测试一个使用深度学习的神经网络如何在 Go 上竞争。他的成功是因为人工智能第一次完胜人类职业9段棋手,打破了人工智能不能解决围棋这类复杂问题的说法。

自从2016年后,深度强化学习技术确实火了几年,但是近几年又有回归理性的趋势。

AlphaGo 比以前的 Go 程序有了显着的改进,在与其他可用围棋程序(包括 Crazy Stone 和 Zen)的 500 场比赛中,在单台计算机上运行的 AlphaGo 赢得了除一个之外的所有胜利,而运行在多台计算机上的 AlphaGo 赢得了与其他 Go 程序对战的所有 500 场比赛,在与单台计算机上运行的 AlphaGo 比赛中赢下了 77%的对阵。2015 年 10 月的分布式版本使用了 1,202 个 CPU 和 176 个 GPU,当时它以 5: 0 的比分击败了欧洲围棋冠军樊麾(职业 2 段选手),轰动一时。

有人认为强化学习的环境模拟是一大障碍。游戏或者围棋这些问题的环境相对好创建,游戏的环境是现成的,围棋有棋谱。但是广告,商品推荐,feed流推荐应用中是将用户作为环境,用户的行为很难准确模拟,如果环境不准,那么在此之上的Agent学习出来的策略就会因为环境误差不断累积而不准。

年度荣誉提名:

1、DeepMind 的另一篇 AlphaGo Nature 论文 《Mastering the game of Go without human knowledge》

论文链接

作为 AlphaGo 的后继版本,2017 年 10 月,DeepMind 发布最新强化版的 AlphaGo Zero,这是一个无需用到人类专业棋谱的版本,比之前的版本都强大。通过自我对弈,AlphaGo Zero 经过三天的学习就超越了 AlphaGo Lee 版本的水平,21 天后达到 AlphaGo Maseter 的实力,40 天内超越之前所有版本。

2017 年:几乎人人都用的 Transformer

《Attention Is All You Need》

论文链接(被引用量 5059)

自从2014年Seq2Seq问世以来,该方法在机器翻译领域就吊打所有以前的方法。在此之后基于Seq2Seq的大多数改进基本上都可以归结为换着花样使用Attention。2017 年 6 月,谷歌实现了完全基于 attention 的 Transformer 机器翻译网络架构,并且还在 WMT 2014 的多种语言对的翻译任务上超越了之前 Facebook 的成绩,实现了新的最佳水平。Transformer用Attention完全替代了原来的LSTM,结果是在机器翻译问题上完胜之前的Seq2Seq架构,并且所需要的训练时间更短。

在编码器-解码器配置中,显性序列显性转导模型(dominant sequence transduction model)基于复杂的 RNN 或 CNN。表现最佳的模型也需通过注意力机制(attention mechanism)连接编码器和解码器。

谷歌提出了一种新型的简单网络架构——Transformer,它完全基于注意力机制,彻底放弃了循环和卷积。两项机器翻译任务的实验表明,这些模型的翻译质量更优,同时更并行,所需训练时间也大大减少。新的模型在 WMT 2014 英语转德语的翻译任务中取得了 BLEU 得分 28.4 的成绩,领先当前现有的最佳结果(包括集成模型)超过 2 个 BLEU 分值。在 WMT 2014 英语转法语翻译任务上,在 8 块 GPU 上训练了 3.5 天之后,新模型获得了新的单模型顶级 BLEU 得分 41.0,只是目前文献中最佳模型训练成本的一小部分。

Transformer 在其他任务上也泛化很好,把它成功应用到了有大量训练数据和有限训练数据的英语组别分析上。

《Neural Architecture Search with Reinforcement Learning》

论文链接(被引用量 1186)

神经结构搜索(NAS)表示自动设计人工神经网络(ANN)的过程,人工神经网络是机器学习领域中广泛使用的模型。NAS 的各种方法设计出的神经网络,其性能与手工设计的架构相当甚至更优越。可以根据搜索空间,搜索策略和性能评估策略三个方面对 NAS 的方法进行分类。其他方法,如《Regularized Evolution for Image Classifier Architecture Search》(即 AmoebaNet)使用了进化算法。

2018 年:预训练模型大热

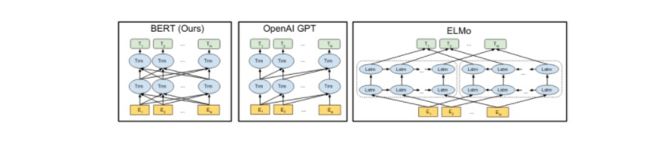

当然是谷歌的 NLP 预训练模型 BERT:《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》,这篇论文现在已经有 3025 次引用量了。

论文链接

本文介绍了一种新的语言表征模型 BERT——来自 Transformer 的双向编码器表征。与最近的语言表征模型不同,BERT 旨在基于所有层的左、右语境来预训练深度双向表征。BERT 是首个在大批句子层面和 token 层面任务中取得当前最优性能的基于微调的表征模型,其性能超越许多使用任务特定架构的系统,刷新了 11 项 NLP 任务的当前最优性能记录。

BERT的作用与Word2Vector类似,是一个预训练技术,用于计算词向量。但是BERT训练出来的embedding在不同语境下可以表现出不同的意义,在11项NLP任务中都取得了state of the art的效果。该方法也应用了Transformer的思想,可以是说是集大成之作。

年度荣誉提名:

自 BERT 被提出以来,基于 Transformer 的语言模型呈井喷之势。这些论文尚需时间考验,还很难说哪一个最具影响力。

1、《Deep contextualized word representations》

论文链接

2、《Improving Language Understanding by Generative Pre-Training》

论文链接

3、《Language Models are Unsupervised Multitask Learners》——即 OpenAI 在 2 月份推出的,参数量高达 15 亿的预训练模型 GPT-2。

论文链接

4、《Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context》

以往的 Transformer 网络由于受到上下文长度固定的限制,学习长期以来关系的潜力有限。本文提出的新神经架构 Transformer-XL 可以在不引起时间混乱的前提下,可以超越固定长度去学习依赖性,同时还能解决上下文碎片化问题。

论文链接

5、《XLNet: Generalized Autoregressive Pretraining for Language Understanding》

BERT 带来的影响还未平复,CMU 与谷歌大脑 6 月份提出的 XLNet 在 20 个任务上超过了 BERT 的表现,并在 18 个任务上取得了 SOTA。

论文链接

6、《Neural Machine Translation of Rare Words with Subword Units》

论文链接

2019 年:深度学习的原理改进

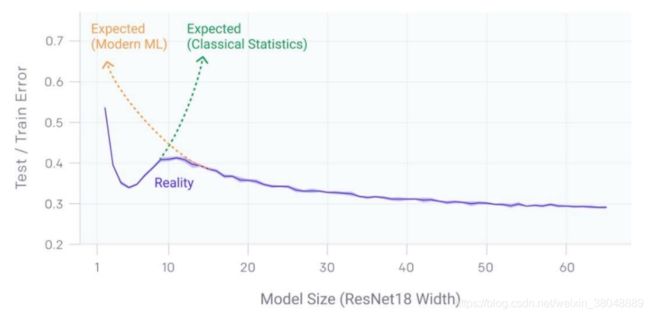

论文 《Deep Double Descent: Where Bigger Models and More Data Hurt》,本文讨论的 Double Descent 现象与经典机器学习和现代深度学习中的流行观点背道而驰。

论文链接

在本文中研究者证明,各种现代深度学习任务都表现出「双重下降」现象,并且随着模型尺寸的增加,性能首先变差,然后变好。此外,他们表明双重下降不仅作为模型大小的函数出现,而且还可以作为训练时间点数量的函数。研究者通过定义一个新的复杂性度量(称为有效模型复杂性,Effective Model Complexity)来统一上述现象,并针对该度量推测一个广义的双重下降。此外,他们对模型复杂性的概念使其能够确定某些方案,在这些方案中,增加(甚至四倍)训练样本的数量实际上会损害测试性能。

来自 MIT CSAIL 研究者的论文**《The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks》**,它也获得了 ICLR 2019 的最佳论文奖。

论文链接

研究者们发现,标准的神经网络剪枝技术会自然地发现子网络,这些子网络经过初始化后能够有效进行训练。基于这些结果,研究者提出了「彩票假设」(lottery ticket hypothesis):密集、随机初始化的前馈网络包含子网络(「中奖彩票」),当独立训练时,这些子网络能够在相似的迭代次数内达到与原始网络相当的测试准确率。

未来?

因为深度学习和基于梯度的神经网络出现技术突破,过去十年是人工智能高速发展的一段时期。这很大程度上是因为芯片算力的显著提高,神经网络正在变得越来越大,性能也越来越强。从计算机视觉到自然语言处理,新的方法已经大面积取代了传统的 AI 技术。

但是神经网络也有其缺点:它们需要大量已标注数据进行续联,无法解释自身的推断机制,难以推广到单个任务之外。不过因为深度学习的推动,AI 领域快速发展,越来越多的研究者正在致力于应对这些挑战。

在未来的几年里,人们对于神经网络的理解还会不断增加。人工智能的前景还是一片光明:深度学习是 AI 领域里最有力的工具,它会使我们进一步接近真正的智能。

让我们期待 2020 年的新成果吧。

参考链接:https://leogao.dev/2019/12/31/The-Decade-of-Deep-Learning/

参考链接:https://www.jiqizhixin.com/articles/2020-01-01

参考链接:http://bourneli.github.io/deep-learning/2020/01/01/summary-of-the-past-10-years.html