北航出品,CVPR 安全AI大赛第二名:梯度细化提高对抗传递性

引言

2021年的安全AI挑战者计划的第六期由阿里和CVPR联合推出的竞赛一共分为两个赛道,赛道1是[ 防御模型的白盒对抗攻击 ],赛道2是 [ ImageNet无限制对抗攻击 ] 。

随着比赛的结束,优秀的攻击算法也运营而生,今天介绍的论文是赛道2算法的一篇论文,作者在1558支队伍中获得攻击成功率第二名的好成绩。

要知道深层神经网络容易受到对抗样本的攻击,这些样本是通过在原始图像中添加人类察觉不到的扰动而生成的。大多数现有的对抗攻击方法在白盒设置下实现了接近100%的攻击成功率,而在黑盒设置下只实现了相对较低的攻击成功率。论文的作者提出了一种梯度细化方法可进一步提高对抗传递性。

比赛链接:https://sourl.cn/WrfHzW

论文链接:https://arxiv.org/abs/2105.04834

论文贡献

该论文的贡献可以归结为以下三个:

通过综合考虑多幅变换图像的梯度,作者提出了一种有效的方法来提高对抗传递性,抵消输入分集过程中产生的无用梯度。

作者提出的方法具有良好的可扩展性,它可以很好地与现有的攻击策略(如I-FGSM、MI-FGSM 、TI-FGSM)相结合,进一步提高对抗样本攻击的可传递性。

大量实验结果表明,该方法的平均传输成功率为82.07%,比其他主流方法高出6.0%。

算法模型

相关工作

给定一个分类器神经网络 ,其中参数为 。 表示样本图像和对应的标签,对抗攻击的目的是找到一个样本 ,它可以使得分类器分类出错。

在大多数情况下,用阈值 去约束范数 获得对抗样本,其中 的取值为0或者2,表达式可以表示为:

输入多样性攻击

在每次迭代中对输入图像应用随机变换,以创建更多样的输入模式,这给对抗扰动带来了随机性,并有效地提高了对抗样本的泛化能力,表达式可以表示为:

其中 表示损失函数 , 表示的符号函数, 表示的补长。 以概率 随机变换的函数。

由于攻击者看不到原始输入,因此生成的对抗样本在黑盒模型上往往具有高得多的攻击成功率,但在白盒模型上成功率较低。

平移不变迭代攻击

通过使用预定义的核平滑图像的梯度来提高攻击能力,使得对抗样本对被攻击的白盒模型的辨别区域不太敏感。该方法可表述为:

其中 表示的是预定义的核。 的尺寸在提高迁移性中扮演了一个很重要的角色,随着尺寸的增加,对抗扰动会被更容易察觉。动量迭代攻击

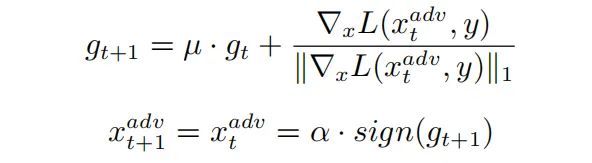

通过将动量项集成到迭代过程中来稳定更新方向,从而增强对抗攻击。基于动量的迭代攻击可以表示为:

其中 表示的是动量梯度, 是衰减系数。

论文算法

输入多样性创建了不同的输入模式,在攻击图像的过程中,图像将在每次迭代期间以一定的概率随机变换一次,从而增强了可转移性。

这自然会抛出一个问题:即输入多样性带来的随机性是否总是正的?如果没有,将如何抵消无用的随机性?

输入多样性方法带来随机梯度,平移不变方法放大了随机性。虽然随机梯度减少了过度拟合,但确使的对抗样本更具普遍性和可转移性,但梯度存在随机无用信息,在一定程度上抑制了对抗样本的普遍性和可转移性。

为了减少输入多样性引入的随机无用梯度信息的影响,作者设计了一种梯度细化的方法,可以有效地提高对抗样本的可移植性。

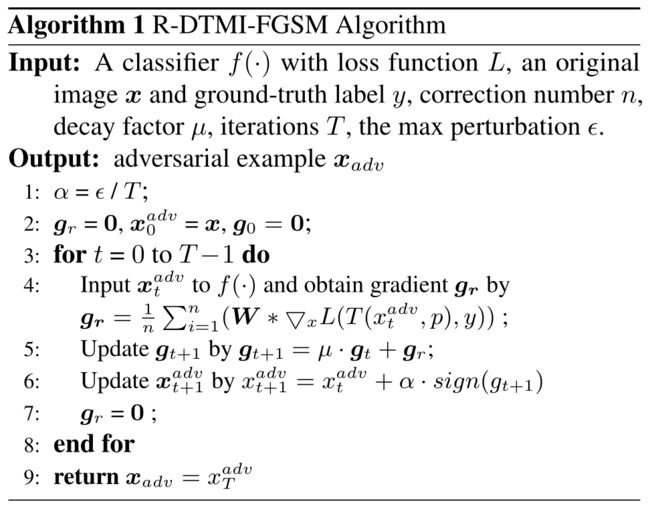

在攻击图像的过程中,在每次迭代中对图像进行多次随机变换,并计算它们各自的梯度,然后对它们进行平均,得到一个细化的梯度,该梯度保留了有助于传递的梯度,并抵消了攻击中无用的梯度,具体的公式可以表示为:

其中 表示的是梯度矫正的次数。随着 的增加,攻击能力也会随之提高。

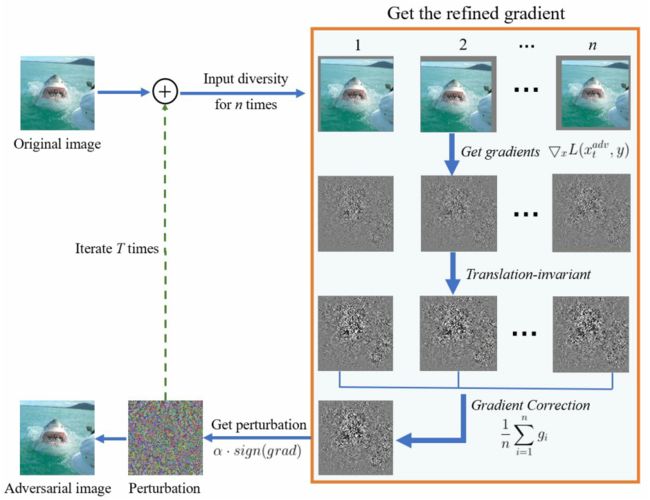

下图给出了该算法的框架。对于原始图像,使用输入多样性和了随机性,多次获得多个变换图像,并计算它们各自的梯度。平移不变方法用于放大随机性。然后保留有用的梯度信息,通过平均运算抵消无用的梯度,得到细化的梯度。将上述过程重复 次,得到一个具有高度可转移性的对抗性图像。

相应的算法框架如下图所示

实验结果

实验设置

数据集:在阿里巴巴集团提供的数据集上进行实验,该数据集包含从ImageNet中选择的5000幅图像,每类5幅图像,所有这些图像都被调整到 。

网络结构:作者研究了四个具有不同结构和参数的模型,其中三个是正常训练的模型,最后一个是对抗训练的模型,它们是Resnet 101,Denset 161,Inception v4,和adv-Inception Resnet v2。

实施细节:作者把每个像素的最大扰动设为 ,总迭代次数 等于8。对于随机变换函数 ,概率 设置为 。高斯核 的大小为 。

度量:作者使用攻击成功率(ASR)来评估不同的攻击方法,攻击成功率是指目标模型可以错误分类的所有图像的百分比。

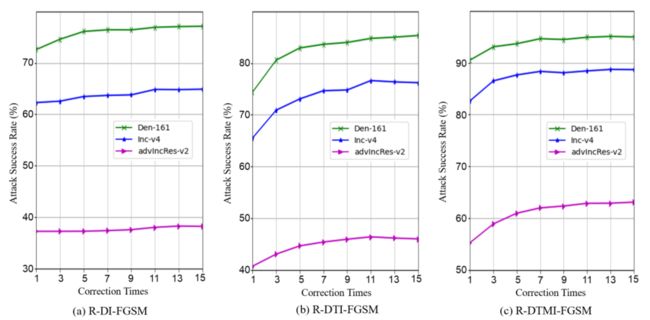

修正次数的影响

校正次数 在提高转移攻击成功率方面起着关键作用。作者用不同的修正时间攻击了Res-101模型,修正时间从 到 ,粒度为 。结果如下图所示,转移攻击成功率起初持续上升,修正次数超过 次后转而保持稳定。

不同设置下的攻击成功率

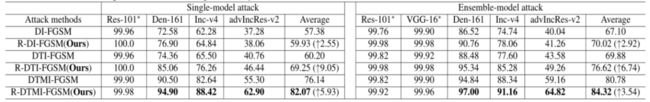

我们使用DI-FGSM、DTI-FGSM和DTMI-FGSM算法,以及它们的扩展,结合梯度细分攻击方法,如R-DI-FGSM、R-DTI-FGSM和R-DTMI-FGSM算法,进行对抗攻击。

作者报告了在单模型设置和集成模型设置下使用三种基线方法的基于梯度细化的攻击成功率。结果如下表所示:

在单模型攻击下,当提出的梯度细化时,转移攻击成功率被大幅度提高。平均而言,基于梯度细化的攻击的转移攻击成功率比基线攻击高出6.0%。

通过使用R-DTI-FGSM,生成的对抗样本的平均转移攻击成功率为69.15%,比基线方法提高了9.05%,除此之外,论文中的方法产生的对抗性扰动具有更好的不可感知性。

在集合模型设置下,过使用梯度细化也可以提高可传递性。论文中作者使用两个模型,Res-101和VGG-16。R-DTI-FGSM大大提高了基线方法的转移攻击成功率,因为平移不变方法放大了输入多样性带来的随机性,论文中的方法可以纠正无用的随机性,并获得一个精细的梯度来产生更强的对抗扰动。

备注:对抗

对抗攻击交流群

对抗攻击等最新资讯,若已为CV君其他账号好友请直接私信。