提取谷歌游览器Cookie的五重境界

经常玩爬虫的童鞋都知道cookie的重要性,目前为止大部分网站都仍然使用cookie标识登录状态,只有少部分网站升级到使用jwt记录登录状态。

提取cookie作用不言而喻,那么提取cookie有哪些高端的操作呢?请观看:

文章目录

- 纯手动提取谷歌游览器cookie

- selenium手动登录并获取cookie

- selenium无头模式获取非登录cookie

- 获取本地谷歌游览器中的cookie

- 解析存储谷歌游览器cookie数据的文件并提取

纯手动提取谷歌游览器cookie

这应该是任何玩过爬虫的童鞋都会的方案,也可能是对于完全不会爬虫的童鞋使用起来最困难的方案。

方法就是先F12打开开发者工具,然后访问要提取cookie的网站,然后在网络中选中刚才访问的请求。具体步骤如下:

然后在请求头中找到cookie这一项,复制对应的值即可:

这应该是任何学过爬虫的童鞋都会的操作,那么我们有没有办法利用代码增加一点自动化的效果呢?

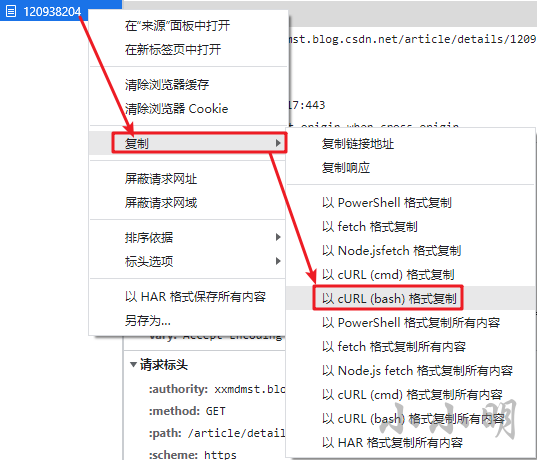

我的方案是在复制curl请求后,利用代码直接提取,操作如下:

将请求以curl命令形式复制到剪切板之后,我们就可以通过代码直接提取cookie,代码如下:

import re

import pyperclip

def extractCookieByCurlCmd(curl_cmd):

cookie_obj = re.search("-H \$?'cookie: ([^']+)'", curl_cmd, re.I)

if cookie_obj:

return cookie_obj.group(1)

cookie = extractCookieByCurlCmd(pyperclip.paste())

print(cookie)

经对比发现打印出来的cookie与直接复制的完全一致。

selenium手动登录并获取cookie

以保存B站登录cookie为例:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.common.exceptions import NoSuchElementException

import time

import json

browser = webdriver.Chrome()

browser.get("https://passport.bilibili.com/login")

flag = True

print("等待登录...")

while flag:

try:

browser.find_element(By.XPATH,

"//div[@class='user-con signin']|//ul[@class='right-entry']"

"//a[@class='header-entry-avatar']")

flag = False

except NoSuchElementException as e:

time.sleep(3)

print("已登录,现在为您保存cookie...")

with open('cookie.txt', 'w', encoding='u8') as f:

json.dump(browser.get_cookies(), f)

browser.close()

print("cookie保存完成,游览器已自动退出...")

执行以上代码,selenium会控制谷歌游览器打开B站的登录页,等待用户手动登录B站,登录后会自动保存cookie。

那么后续selenium程序启动时如何直接使用该cookie而不需再次登录呢?演示如下:

import json

from selenium import webdriver

browser = webdriver.Chrome()

with open('cookie.txt', 'r', encoding='u8') as f:

cookies = json.load(f)

browser.get("https://www.bilibili.com/")

for cookie in cookies:

browser.add_cookie(cookie)

browser.get("https://www.bilibili.com/")

流程就是先访问要加载cookie的网站,再迅速向其添加cookie,再重新访问一遍该网站加载的cookie即可生效。

selenium无头模式获取非登录cookie

比如抖音这种网站想下载其中的视频,就必须要带有一个初始的cookie,但这个cookie生成的算法比较复杂,纯requests很难模拟,这时我们完全可以借助selenium来加载网页并获取cookie节省分析js的时间。由于我们并不需要进行人工的操作,所以使用无头模式更佳。

下面就演示无头模式获取抖音网站的cookie:

from selenium import webdriver

import time

def selenium_get_cookies(url='https://www.douyin.com'):

"""无头模式提取目标链接对应的cookie,代码作者:小小明-代码实体"""

start_time = time.time()

option = webdriver.ChromeOptions()

option.add_argument("--headless")

option.add_experimental_option('excludeSwitches', ['enable-automation'])

option.add_experimental_option('useAutomationExtension', False)

option.add_argument(

'user-agent=Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36')

option.add_argument("--disable-blink-features=AutomationControlled")

print("打开无头游览器...")

browser = webdriver.Chrome(options=option)

print(f"访问{url} ...")

browser.get(url)

cookie_list = browser.get_cookies()

# 关闭浏览器

browser.close()

cost_time = time.time() - start_time

print(f"无头游览器获取cookie耗时:{cost_time:0.2f} 秒")

return {row["name"]: row["value"] for row in cookie_list}

print(selenium_get_cookies("https://www.douyin.com"))

打印结果如下:

打开无头游览器...

访问https://www.douyin.com ...

无头游览器获取cookie耗时:3.28 秒

{'': 'douyin.com', 'ttwid': '1%7CZn_LJdPjHKdCy4jtBoYWL_yT3NMn7OZVTBStEzoLoQg%7C1642932056%7C80dbf668fd283c71f9aee1a277cb35f597a8453a3159805c92dfee338e70b640', 'AB_LOGIN_GUIDE_TIMESTAMP': '1642932057106', 'MONITOR_WEB_ID': '651d9eca-f155-494b-a945-b8758ae948fb', 'ttcid': 'ea2b5aed3bb349219f7120c53dc844a033', 'home_can_add_dy_2_desktop': '0', '_tea_utm_cache_6383': 'undefined', '__ac_signature': '_02B4Z6wo00f01kI39JwAAIDBnlvrNDKInu5CB.AAAPFv24', 'MONITOR_DEVICE_ID': '25d4799c-1d29-40e9-ab2b-3cc056b09a02', '__ac_nonce': '061ed27580066860ebc87'}

获取本地谷歌游览器中的cookie

我们知道当我们通过selenium直接去控制谷歌游览器时,并没有加载原本谷歌游览器的cookie。有没有办法可以直接获取谷歌游览器已经登录过的cookie呢?

其实很简单,只要我们使用debug远程调试模式运行本地的谷歌游览器,再用selenium控制即可提取之前登录的cookie:

import os

import winreg

from selenium import webdriver

import time

def get_local_ChromeCookies(url, chrome_path=None):

"""提取本地谷歌游览器目标链接对应的cookie,代码作者:小小明-代码实体"""

if chrome_path is None:

key = winreg.OpenKey(winreg.HKEY_CLASSES_ROOT, r"ChromeHTML\Application")

path = winreg.QueryValueEx(key, "ApplicationIcon")[0]

chrome_path = path[:path.rfind(",")]

start_time = time.time()

command = f'"{chrome_path}" --remote-debugging-port=9222'

# print(command)

os.popen(command)

option = webdriver.ChromeOptions()

option.add_experimental_option("debuggerAddress", "127.0.0.1:9222")

browser = webdriver.Chrome(options=option)

print(f"访问{url}...")

browser.get(url)

cookie_list = browser.get_cookies()

# 关闭浏览器

browser.close()

cost_time = time.time() - start_time

print(f"获取谷歌游览器cookie耗时:{cost_time:0.2f} 秒")

return {row["name"]: row["value"] for row in cookie_list}

print(get_local_ChromeCookies("https://www.douyin.com"))

上述代码有能力直接获取之前在谷歌游览器访问过的任何网站的cookie,下面是抖音的结果:

DevTools listening on ws://127.0.0.1:9222/devtools/browser/9a9c19da-21fc-42ba-946d-ff60a91aa9d2

访问https://www.douyin.com...

获取谷歌游览器cookie耗时:4.62 秒

{'THEME_STAY_TIME': '10718', 'home_can_add_dy_2_desktop': '0', '_tea_utm_cache_1300': 'undefined', 'passport_csrf_token': 'c6bda362fba48845a2fe6e79f4d35bc8', 'passport_csrf_token_default': 'c6bda362fba48845a2fe6e79f4d35bc8', 'MONITOR_WEB_ID': 'd6e51b15-5276-41f3-97f5-e14d51242496', 'MONITOR_DEVICE_ID': 'd465b931-3a0e-45ba-ac19-263dd31a76ee', '': 'douyin.com', 'ttwid': '1%7CsXCoN0TQtHpKYiRoZnAKyqNJhOfkdJjNEJIdPPAibJw%7C1642915541%7C8a3308d87c6d2a38632bbfe4dfc0baae75162cedf6d63ace9a9e2ae4a13182d2', '__ac_signature': '_02B4Z6wo00f01I50-sQAAIDADnYAhr3RZZCOUP5AAEJ0f7', 'msToken': 'mUYtlAj8qr_9fuTIekLmAThy9N_ltbh0NJo05ns14o3X5As496_O5n7XT4-I81npZuGrIxt0V3JadDZlznmwgzwxqT6GZdIOBozEPC-WAZawQR-teML5984=', '__ac_nonce': '061ed25850009be132678', '_tea_utm_cache_6383': 'undefined', 'AB_LOGIN_GUIDE_TIMESTAMP': '1642915542503', 'ttcid': '3087b27658f74de9a4dae240e7b3930726'}

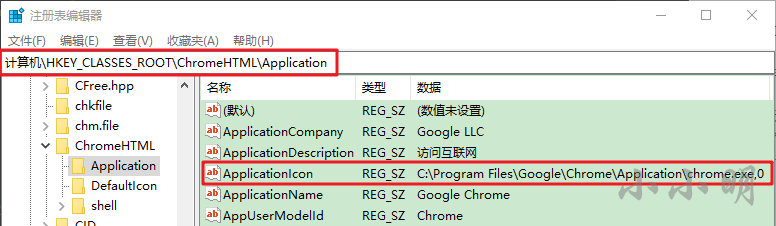

上述代码通过读取注册表的项目获取谷歌游览器的路径:

个人无法确认其他电脑上也能通过该注册表获取谷歌游览器的位置,所以提供了主动传入路径的参数。

谷歌游览器的启动参数加上 --remote-debugging-port=9222即可开启远程debug模式,而selenium则可以通过debuggerAddress参数连接一个现有开启远程debug模式的谷歌游览器。

于是我们可以顺利获取任何之前在谷歌游览器登录过的网站cookie。

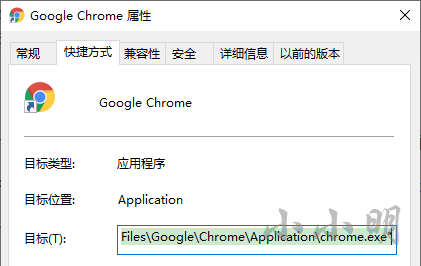

不过注意,如果我们日常运行谷歌游览器的快捷方式带有

--user-data-dir参数,上述代码也应该增加该参数,但是主机上的谷歌游览器并没有:

解析存储谷歌游览器cookie数据的文件并提取

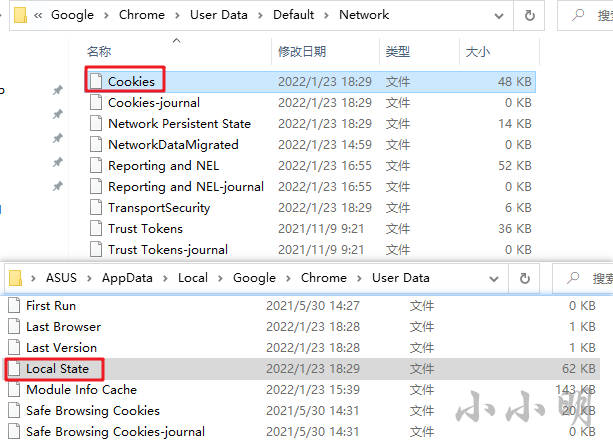

最后我再介绍一个终极绝招,那就是直接解密cookies文件。在97之前版本的谷歌游览器,保存cookie的文件存储在%LOCALAPPDATA%\Google\Chrome\User Data\Default\Cookies,而在97版本后则移动到了%LOCALAPPDATA%\Google\Chrome\User Data\Default\Network\Cookies。

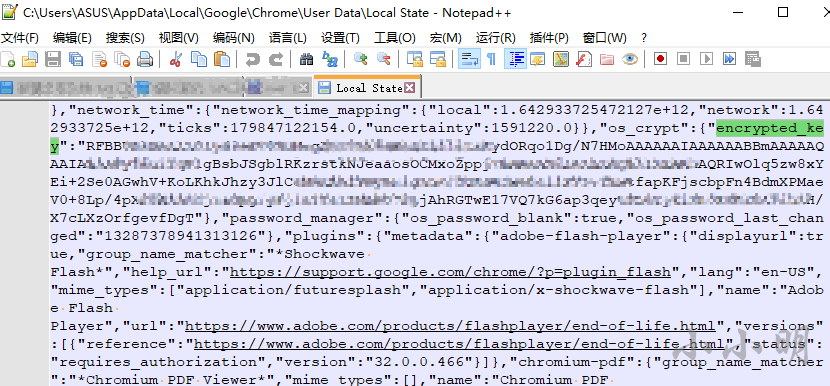

但在未来97以上的版本,存储位置和加密方式是否会继续发生变化还未知。截止目前密钥数据始终都存储在%LOCALAPPDATA%\Google\Chrome\User Data\Local State文件中。(80版本之前,直接使用win32crypt.CryptUnprotectData(encrypted_value_bytes,None,None,None,0)[1]解密,无需密钥)

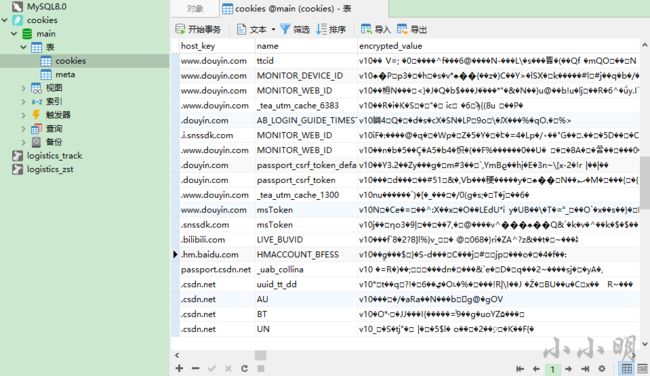

实际上Cookies文件是一个SQLlite数据库,可以直接使用Navicat Premium 15查看:

但值被加密了,80版本之后的加密算法详见:https://github.com/chromium/chromium/blob/master/components/os_crypt/os_crypt_win.cc

涉及解密key存储的文件Local State是一个JSON文件:

完整提取代码如下:

"""

小小明的代码

CSDN主页:https://blog.csdn.net/as604049322

"""

__author__ = '小小明'

__time__ = '2022/1/23'

import base64

import json

import os

import sqlite3

import win32crypt

from cryptography.hazmat.primitives.ciphers.aead import AESGCM

def load_local_key(localStateFilePath):

"读取chrome保存在json文件中的key再进行base64解码和DPAPI解密得到真实的AESGCM key"

with open(localStateFilePath, encoding='u8') as f:

encrypted_key = json.load(f)['os_crypt']['encrypted_key']

encrypted_key_with_header = base64.b64decode(encrypted_key)

encrypted_key = encrypted_key_with_header[5:]

key = win32crypt.CryptUnprotectData(encrypted_key, None, None, None, 0)[1]

return key

def decrypt_value(key, data):

"AESGCM解密"

nonce, cipherbytes = data[3:15], data[15:]

aesgcm = AESGCM(key)

plaintext = aesgcm.decrypt(nonce, cipherbytes, None).decode('u8')

return plaintext

def fetch_host_cookie(host):

"获取指定域名下的所有cookie"

userDataDir = os.environ['LOCALAPPDATA'] + r'\Google\Chrome\User Data'

localStateFilePath = userDataDir + r'\Local State'

cookiepath = userDataDir + r'\Default\Cookies'

# 97版本已经将Cookies移动到Network目录下

if not os.path.exists(cookiepath) or os.stat(cookiepath).st_size == 0:

cookiepath = userDataDir + r'\Default\Network\Cookies'

# print(cookiepath)

sql = f"select name,encrypted_value from cookies where host_key like '%.{host}'"

cookies = {}

key = load_local_key(localStateFilePath)

with sqlite3.connect(cookiepath) as conn:

cu = conn.cursor()

for name, encrypted_value in cu.execute(sql).fetchall():

cookies[name] = decrypt_value(key, encrypted_value)

return cookies

if __name__ == '__main__':

print(fetch_host_cookie("douyin.com"))

结果:

{'ttcid': '3087b27658f74de9a4dae240e7b3930726', 'MONITOR_DEVICE_ID': 'd465b931-3a0e-45ba-ac19-263dd31a76ee', 'MONITOR_WEB_ID': '70892127-f756-4455-bb5e-f8b1bf6b71d0', '_tea_utm_cache_6383': 'undefined', 'AB_LOGIN_GUIDE_TIMESTAMP': '1642915542503', 'passport_csrf_token_default': 'c6bda362fba48845a2fe6e79f4d35bc8', 'passport_csrf_token': 'c6bda362fba48845a2fe6e79f4d35bc8', '_tea_utm_cache_1300': 'undefined', 'msToken': 'e2XPeN9Oe2rvoAwQrIKLvpGYQTF8ymR4MFv6N8dXHhu4To2NlR0uzx-XPqxCWWLlO5Mqr2-3hwSIGO_o__heO0Rv6nxYXaOt6yx2eaBS7vmttb4wQSQcYBo=', 'THEME_STAY_TIME': '13218', '__ac_nonce': '061ed2dee006ff56640fa', '__ac_signature': '_02B4Z6wo00f01rasq3AAAIDCNq5RMzqU2Ya2iK.AAMxSb2', 'home_can_add_dy_2_desktop': '1', 'ttwid': '1%7CsXCoN0TQtHpKYiRoZnAKyqNJhOfkdJjNEJIdPPAibJw%7C1642915541%7C8a3308d87c6d2a38632bbfe4dfc0baae75162cedf6d63ace9a9e2ae4a13182d2'}

可以看到已经完美的从本地文件中提取出了cookie。