- 全面解析Hadoop配置文件:架构、调整与最佳实践

秦道衍

本文还有配套的精品资源,点击获取简介:Hadoop作为一个关键组件在分布式计算中处理和存储大量数据,而其配置文件则是保证系统正常运行和性能优化的核心。文章详细探讨了Hadoop配置文件的作用,包括核心配置文件及其内容,并阐述如何根据实际需求进行适当调整。同时,介绍了针对HDFS、MapReduce和YARN的主要配置文件,并通过实例说明如何细化设置以满足性能和资源管理的需求。最后,文章分享了一些最

- awk处理xml文件&&封装集合变量和调用

itachi-uchiha

shell脚本xmlawkshell

对于Hadoop配置本地存储路径:dfs.datanode.data.dirfile:///dfs/datadfs.datanode.data.dirfile:///mnt/datadir1/data,/mnt/datadir2/data,/mnt/datadir3/data可以严格按照XML换行和缩进格式配置,也可以配置到一行中;可以带file://前缀也可以不带;注:在Hadoop的配置中,d

- Yarn-tool接口

小白的白是白痴的白

大数据spark

(一)需求让自己编写的程序打包之后得到jar包,也可以支持动态参数,例如在指定的队列中运行程序。(二)Tool接口定义org.apache.hadoop.util.Tool是ApacheHadoop框架里的一个接口,其用途是协助开发可通过命令行运行的Hadoop应用程序。该接口能够让程序解析命令行参数,并且以一致的方式和Hadoop配置系统交互。接口定义如下:importorg.apache.ha

- 基于Linux—Hadoop大数据集群搭建(100%成功版!!!)

my_realmy

系统安装指南大数据linuxhadoop

文章目录Hadoop大数据集群搭建一、前置准备二、Hadoop配置Hadoop大数据集群搭建基础条件:VMware+CentOS7(操作简单,在此省略)完成基础条件下打开虚拟机,进行以下操作必读预告:关于复制粘贴功能,可能部分虚拟机很难用,所以可以在MobaXtem_Portable进行后续操作关于地址问题,文章所用地址是在本人亲测可用情况下使用,看自己的适合哪个由于是配置完成后整理,可能部分步骤

- Windows下Hadoop的环境变量的配置以及Hadoop的配置文件修改

drhrht

javajava后端

Hadoop的环境变量的配置1.进入系统变量,右键单击我的电脑–>属性–>高级环境变量配置–>高级选项卡–>环境变量–>单击新建HADOOP_HOME2.在系统变量path里面添加%HADOOP_HOME%in;3.测试:打开命令行cmd,在任意路径下输入hadoop命令,返回一下结果即配置正确修改hadoop配置文件1.编辑并保存“D:ProgramFileshadoop-2.7.2etchad

- Yarn-tool接口

夏天吃哈密瓜

hadoop大数据

Tool接口定义org.apache.hadoop.util.Tool是ApacheHadoop框架里的一个接口,其用途是协助开发可通过命令行运行的Hadoop应用程序。该接口能够让程序解析命令行参数,并且以一致的方式和Hadoop配置系统交互。接口定义如下:importorg.apache.hadoop.conf.Configuration;importorg.apache.hadoop.uti

- Spark(19)Yarn-tool接口

北随琛烬入

spark大数据

(一)需求让自己编写的程序也可以支持动态参数。编写Yarn的Tool接口。(二)Tool接口定义org.apache.hadoop.util.Tool是ApacheHadoop框架里的一个接口,其用途是协助开发可通过命令行运行的Hadoop应用程序。该接口能够让程序解析命令行参数,并且以一致的方式和Hadoop配置系统交互。接口定义如下:importorg.apache.hadoop.conf.C

- Ubuntu从零创建Hadoop集群

爱编程的王小美

大数据专业知识系列ubuntuhadooplinux

目录前言前提准备1.设置网关和网段2.查看虚拟机IP及检查网络3.Ubuntu相关配置镜像源配置下载vim编辑器4.设置静态IP和SSH免密(可选)设置静态IPSSH免密5.JDK环境部署6.Hadoop环境部署7.配置Hadoop配置文件HDFS集群规划HDFS集群配置1.配置works文件2.配置hadoop-env.sh文件3.配置core-site.xml文件4.配置hdfs-site.x

- Hadoop3.3.4伪分布式环境搭建

凡许真

分布式hadoop伪分布式hadoop3.3.4

文章目录前言一、准备1.下载Hadoop2.配置环境变量3.配置免密二、Hadoop配置1.hadoop-env.sh2.hdfs-site.xml3.core-site.xml4.mapred-site.xml5.yarn-site.xml三、格式化四、启动五、访问web页面前言hadoop学习——伪分布式环境——普通用户搭建一、准备1.下载Hadoop2.配置环境变量vi~/.bash_pro

- Hbase的简单使用示例

傲雪凌霜,松柏长青

后端大数据hbase数据库大数据

HBase是基于HadoopHDFS构建的分布式、列式存储的NoSQL数据库,适用于存储和检索超大规模的非结构化数据。它支持随机读写,并且能够处理PB级数据。HBase通常用于实时数据存取场景,与Hadoop生态紧密集成。使用HBase的Java示例前置条件HBase集群:确保HBase集群已经安装并启动。如果没有,你可以通过本地伪分布模式或Docker来运行HBase。Hadoop配置:HBas

- hadoop配置免密登录

我干开发那十年

ssh服务器linux

1.生成密钥ssh-keygen-trsa所有节点都要执行2.所有节点执行ssh-copy-id-i~/.ssh/id_rsa.pub用户名1@主机名1ssh-copy-id-i~/.ssh/id_rsa.pub用户名2@主机名2ssh-copy-id-i~/.ssh/id_rsa.pub用户名3@主机名33.目录授权chmod700~/.sshchmod600~/.ssh/authorized_

- Hadoop手把手逐级搭建 第二阶段: Hadoop完全分布式(full)

郑大能

前置步骤:1).第一阶段:Hadoop单机伪分布(single)0.步骤概述1).克隆4台虚拟机2).为完全分布式配置ssh免密3).将hadoop配置修改为完全分布式4).启动完全分布式集群5).在完全分布式集群上测试wordcount程序1.克隆4台虚拟机1.1使用hadoop0克隆4台虚拟机hadoop1,hadoop2,hadoop3,hadoop41.1.0克隆虚拟机hadoop11.1

- Hadoop单机环境搭建

三暮辰

Hadoophadoop大数据

Hadoop单机环境搭建一、jdk环境二、IP地址和主机名映射三、生成公私钥授权四、下载解压Hadoop五、配置Hadoop环境变量六、修改Hadoop配置文件七、关闭防火墙八、初始化九、启动十、Yarn配置启动一、jdk环境从官方下载jdk,版本1.8及以上即可给个地址:jdk8二、IP地址和主机名映射将主机名与IP地址映射,可以用主机名进行任务分发或文件传输以及其他工作1.查看主机名称//主机

- Iceberg从入门到精通系列之二十一:Spark集成Iceberg

最笨的羊羊

日常分享专栏Iceberg从入门到精通系列之二十一Spark集成Iceberg

Iceberg从入门到精通系列之二十一:Spark集成Iceberg一、在Spark3中使用Iceberg二、添加目录三、创建表四、写五、读六、Catalogs七、目录配置八、使用目录九、替换会话目录十、使用目录特定的Hadoop配置值十一、加载自定义目录十二、SQL扩展十三、运行时配置-读选项十四、运行时配置-写选项十五、SparkProcedures十六、元数据管理Iceberg的最新版本是1

- Ubuntu22.04三台虚拟机Hadoop集群安装和搭建(全面详细的过程)

WuRobb

hadoop大数据分布式java

虚拟机Ubuntu22.04Hadoop集群安装和搭建(全面详细的过程)环境配置安装安装JDK安装Hadoop三台虚拟机设置克隆三台虚拟机设置静态IP修改虚拟机hostssh免密登录关闭防火墙Hadoop配置core-site.xmlhdfs-site.xmlyarn-site.xmlmapred-site.xmlworkers设置hadoop集群用户权限xsync分发给其他虚拟机格式化namen

- hadoop集群规划部署

Snower_2022

hadoophadoopjava大数据

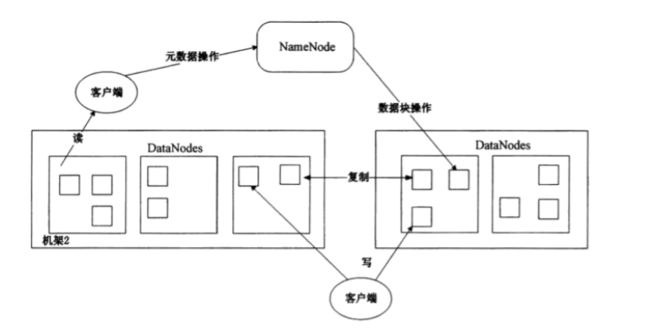

一、集群规划三台硬件资源,部署hadoop版本,hadoop-3.3.5,部署后配置文件。Hadoop配置文件分两类:默认配置文件和自定义配置文件。hadoop102hadoop103hadoop104HDFSNameNodeDataNodeDataNodeSecondaryNameNodeDataNodeYARNNodeManagerResourceManagerNodeManagerNodeM

- 大数据平台组件日常运维操作说明(Hadoop/Zookeeper/Kafa/ES/Mysql/Spark/Flume/Logstash/Tomcat)

love6a6

大数据java-zookeeper运维

Hadoop日常运维操作说明hdfs生产环境hadoop为30台服务器组成的集群,统一安装配置,版本号为2.7.7部署路径:/opt/hadoop启动用户:hadoop配置文件:/opt/hadoop/config/hdfs-site.xml/opt/hadoop/config/core-site.xmlhadoopy运行环境变量配置文件:hadoop-env.shjournalnode.envd

- hadoop-hdfs-API

有七段变化

处理hadoop配置文件及系统环境1.将hadoop所有jar包(除了..以外)添进hadoop/lib文件夹备用。2.将linux的hadoop/bin导出覆盖windows的hadoop/bin。并将bin/hadoop.dll添入windows\system32文件夹内。需重启。3.配置windows系统环境变量HADOOP_HOME=hadoop所在包。HADOOP_USER_NAME=r

- Linux修改hadoop配置文件及启动hadoop集群详细步骤

CatalinaCatherine

Linuxlinuxhadoop运维

目录一、配置Hadoop环境1.查看Hadoop解压位置2.配置环境变量3.编辑环境变量4.重启环境变量5.查看Hadoop版本,查看成功就表示Hadoop安装成功了二、修改配置文件1.检查三台虚拟机:2.切换到配置文件目录3.修改hadoop-env.sh文件4.修改core-site.xml文件5.修改mapred-site.xml文件6.修改hdfs-site.xml文件7.修改yarn-s

- linux上面hadoop配置集群

酷爱码

大数据基础教程linuxhadoop运维

要在Linux上配置Hadoop集群,需要按照以下步骤进行操作:安装JavaDevelopmentKit(JDK):首先,确保您的Linux系统上已经安装了JDK。可以通过运行以下命令来检查是否已经安装了JDK:java-version如果返回了Java的版本信息,则表示已经安装了JDK。如果没有安装,请根据您使用的Linux发行版,安装相应的JDK。下载和解压Hadoop:前往ApacheHad

- Hadoop配置文件加载

sf_www

hadoophadoop大数据hdfs

1.hadoop使用org.apache.hadoop.conf.Configuration类来加载配置文件2.一般我们在写客户端程序等需要连接hadoop集群时,需要自己准备好core-site.xml和hdfs-site.xml文件,然后使用Configuration类的addResource(xxx)方法来加载以上两个配置文件,下面就来解析下,假如自己不主动加载以上两个配置文件时,Confi

- Hive数据导出的四种方法

冬瓜的编程笔记

大数据hivehadoop数据仓库

hive数据仓库有多种数据导出方法,我在本篇文章中介绍下面的四种方法供大家参考:Insert语句导出、Hadoop命令导出、Hiveshell命令导出、Export语句导出。一、Insert语句导出语法格式Hive支持将select查询的结果导出成文件存放在文件系统中。语法格式如下;注意:导出操作是一个OVERWRITE覆盖操作,慎重。目录可以是完整的URI。Hive使用hadoop配置变量fs.

- 任务5:安装并配置Hadoop

Dija-bl

hadoop大数据分布式

任务描述知识点:掌握Hadoop集群的搭建重点:掌握Linux基础命令在Linux系统下使用命令安装Hadoop集群内容:安装配置Hadoop集群配置Hadoop环境变量修改Hadoop配置文件部署Hadoop集群任务指导Hadoop是一个由Apache基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。充分利用集群的威力进行高速运算和存储。任务主要内容:下载

- (十八)大数据学习之HA

Movle

HA专题一.保证服务器时间相同date-s2019-04-21把所有机器时间设置成00:00:00二.HadoopHA1.HDFSHA/usr/local/hadoop-2.8.4/etc/hadoop下是所有hadoop配置文件-------core-site.xml------------------------fs.defaultFShdfs://myclusterha.zookeeper.

- 【spark】基于Spark的电影推荐系统+[详细代码及配置]

BIG*BOSS

Sparkspark

基于Spark的电影推荐系统项目架构组件版本及配置名称版本Hadoop2.8.5Hive2.1.0Spark1.6.3Kafka2.10_0.8.21MariaDB(Mysql)5.5.64Scala2.10.6Java1.8.0_25Zookeeper3.4.12Hadoop配置core-site.xml#配置两个namenode的隔离策略#sshfence方式#使用这种方式,必须实现ssh无密

- 物理机搭建hive

DIY……

hivehadoop数据仓库

一、修改Hadoop配置修改core-site.xml配置yarn-site.xml分发文件,然后重启集群二、Hive解压安装上传文件添加hive环境便量,source生效启动高可用集群,启动hive三、配置mysql元数据库检查当前系统是否安装过Mysql,如果存在就是用下列命令移除,如果不存在则忽略。(一定要做这一步)将MySQL安装包上传到/opt/software目录下,解压MySQL安装

- 【Hadoop】集群配置之主要配置文件(hadoop-env.sh、yarn-env.sh、core-site.xml、hdfs-site.xml、mapred-site.xml...)

不怕娜

hadoopxmlhdfs

Hadoop配置文件模板core-site.xmlhadoop-env.shhdfs-site.xmlyarn-env-shyarn-site.xmlmapred-site.xmlslavesHadoop配置文件模板参考官方配置文档:https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/ClusterSetu

- Docker 学习笔记

IT小学僧

dockerdocker

Docker为什么出现?开发–运维问题,环境配置是十分麻烦,每一个机器都要部署环境(Redis,Es,Hadoop)费时费力发布一个项目(jar+(RedisMysqljdkes))项目能不能都带上环境安装打包之前在服务器配置一个应用的环境RedisMysqljdkESHadoop配置超麻烦了,不能够跨平台Docker给以上的问题,提出了解决方案!Docker的思想就来自集装箱聊聊dockerDo

- 在自己电脑配置cdh 版 hadoop 提交mr job客户端

Helen_Cat

image.png1.首先下载与我们cdhhadoop集群对应的hadoop安装文件hadoop-2.6.0-cdh5.14.2.tar.gz链接:https://pan.baidu.com/s/1iHm5M-gGZRWLKbzVjbYJmA密码:q9nv2.hadoop解压到自己本地电脑上mac/optwindowD盘3.将测试服务器的hadoop的配置文件复制到自己的hadoop配置文件目录4

- Windows下安装hadoop

ElegantCodingWH

#Hadoophadoopjava大数据

文章目录1.第一步:下载安装包2.第二步:解压下载的压缩包3.第三步:为hadoop配置环境变量4.第四步:验证是否安装成功5.如果还不能成功,则看看用户名是否含有空格或特殊符号1.第一步:下载安装包到官网去下载安装包:https://archive.apache.org/dist/hadoop/common/2.第二步:解压下载的压缩包最好是以管理员身份运行cmd,进入到压缩文件所在目录,然后用

- windows下源码安装golang

616050468

golang安装golang环境windows

系统: 64位win7, 开发环境:sublime text 2, go版本: 1.4.1

1. 安装前准备(gcc, gdb, git)

golang在64位系

- redis批量删除带空格的key

bylijinnan

redis

redis批量删除的通常做法:

redis-cli keys "blacklist*" | xargs redis-cli del

上面的命令在key的前后没有空格时是可以的,但有空格就不行了:

$redis-cli keys "blacklist*"

1) "blacklist:12:

[email protected]

- oracle正则表达式的用法

0624chenhong

oracle正则表达式

方括号表达示

方括号表达式

描述

[[:alnum:]]

字母和数字混合的字符

[[:alpha:]]

字母字符

[[:cntrl:]]

控制字符

[[:digit:]]

数字字符

[[:graph:]]

图像字符

[[:lower:]]

小写字母字符

[[:print:]]

打印字符

[[:punct:]]

标点符号字符

[[:space:]]

- 2048源码(核心算法有,缺少几个anctionbar,以后补上)

不懂事的小屁孩

2048

2048游戏基本上有四部分组成,

1:主activity,包含游戏块的16个方格,上面统计分数的模块

2:底下的gridview,监听上下左右的滑动,进行事件处理,

3:每一个卡片,里面的内容很简单,只有一个text,记录显示的数字

4:Actionbar,是游戏用重新开始,设置等功能(这个在底下可以下载的代码里面还没有实现)

写代码的流程

1:设计游戏的布局,基本是两块,上面是分

- jquery内部链式调用机理

换个号韩国红果果

JavaScriptjquery

只需要在调用该对象合适(比如下列的setStyles)的方法后让该方法返回该对象(通过this 因为一旦一个函数称为一个对象方法的话那么在这个方法内部this(结合下面的setStyles)指向这个对象)

function create(type){

var element=document.createElement(type);

//this=element;

- 你订酒店时的每一次点击 背后都是NoSQL和云计算

蓝儿唯美

NoSQL

全球最大的在线旅游公司Expedia旗下的酒店预订公司,它运营着89个网站,跨越68个国家,三年前开始实验公有云,以求让客户在预订网站上查询假期酒店时得到更快的信息获取体验。

云端本身是用于驱动网站的部分小功能的,如搜索框的自动推荐功能,还能保证处理Hotels.com服务的季节性需求高峰整体储能。

Hotels.com的首席技术官Thierry Bedos上个月在伦敦参加“2015 Clou

- java笔记1

a-john

java

1,面向对象程序设计(Object-oriented Propramming,OOP):java就是一种面向对象程序设计。

2,对象:我们将问题空间中的元素及其在解空间中的表示称为“对象”。简单来说,对象是某个类型的实例。比如狗是一个类型,哈士奇可以是狗的一个实例,也就是对象。

3,面向对象程序设计方式的特性:

3.1 万物皆为对象。

- C语言 sizeof和strlen之间的那些事 C/C++软件开发求职面试题 必备考点(一)

aijuans

C/C++求职面试必备考点

找工作在即,以后决定每天至少写一个知识点,主要是记录,逼迫自己动手、总结加深印象。当然如果能有一言半语让他人收益,后学幸运之至也。如有错误,还希望大家帮忙指出来。感激不尽。

后学保证每个写出来的结果都是自己在电脑上亲自跑过的,咱人笨,以前学的也半吊子。很多时候只能靠运行出来的结果再反过来

- 程序员写代码时就不要管需求了吗?

asia007

程序员不能一味跟需求走

编程也有2年了,刚开始不懂的什么都跟需求走,需求是怎样就用代码实现就行,也不管这个需求是否合理,是否为较好的用户体验。当然刚开始编程都会这样,但是如果有了2年以上的工作经验的程序员只知道一味写代码,而不在写的过程中思考一下这个需求是否合理,那么,我想这个程序员就只能一辈写敲敲代码了。

我的技术不是很好,但是就不代

- Activity的四种启动模式

百合不是茶

android栈模式启动Activity的标准模式启动栈顶模式启动单例模式启动

android界面的操作就是很多个activity之间的切换,启动模式决定启动的activity的生命周期 ;

启动模式xml中配置

<activity android:name=".MainActivity" android:launchMode="standard&quo

- Spring中@Autowired标签与@Resource标签的区别

bijian1013

javaspring@Resource@Autowired@Qualifier

Spring不但支持自己定义的@Autowired注解,还支持由JSR-250规范定义的几个注解,如:@Resource、 @PostConstruct及@PreDestroy。

1. @Autowired @Autowired是Spring 提供的,需导入 Package:org.springframewo

- Changes Between SOAP 1.1 and SOAP 1.2

sunjing

ChangesEnableSOAP 1.1SOAP 1.2

JAX-WS

SOAP Version 1.2 Part 0: Primer (Second Edition)

SOAP Version 1.2 Part 1: Messaging Framework (Second Edition)

SOAP Version 1.2 Part 2: Adjuncts (Second Edition)

Which style of WSDL

- 【Hadoop二】Hadoop常用命令

bit1129

hadoop

以Hadoop运行Hadoop自带的wordcount为例,

hadoop脚本位于/home/hadoop/hadoop-2.5.2/bin/hadoop,需要说明的是,这些命令的使用必须在Hadoop已经运行的情况下才能执行

Hadoop HDFS相关命令

hadoop fs -ls

列出HDFS文件系统的第一级文件和第一级

- java异常处理(初级)

白糖_

javaDAOspring虚拟机Ajax

从学习到现在从事java开发一年多了,个人觉得对java只了解皮毛,很多东西都是用到再去慢慢学习,编程真的是一项艺术,要完成一段好的代码,需要懂得很多。

最近项目经理让我负责一个组件开发,框架都由自己搭建,最让我头疼的是异常处理,我看了一些网上的源码,发现他们对异常的处理不是很重视,研究了很久都没有找到很好的解决方案。后来有幸看到一个200W美元的项目部分源码,通过他们对异常处理的解决方案,我终

- 记录整理-工作问题

braveCS

工作

1)那位同学还是CSV文件默认Excel打开看不到全部结果。以为是没写进去。同学甲说文件应该不分大小。后来log一下原来是有写进去。只是Excel有行数限制。那位同学进步好快啊。

2)今天同学说写文件的时候提示jvm的内存溢出。我马上反应说那就改一下jvm的内存大小。同学说改用分批处理了。果然想问题还是有局限性。改jvm内存大小只能暂时地解决问题,以后要是写更大的文件还是得改内存。想问题要长远啊

- org.apache.tools.zip实现文件的压缩和解压,支持中文

bylijinnan

apache

刚开始用java.util.Zip,发现不支持中文(网上有修改的方法,但比较麻烦)

后改用org.apache.tools.zip

org.apache.tools.zip的使用网上有更简单的例子

下面的程序根据实际需求,实现了压缩指定目录下指定文件的方法

import java.io.BufferedReader;

import java.io.BufferedWrit

- 读书笔记-4

chengxuyuancsdn

读书笔记

1、JSTL 核心标签库标签

2、避免SQL注入

3、字符串逆转方法

4、字符串比较compareTo

5、字符串替换replace

6、分拆字符串

1、JSTL 核心标签库标签共有13个,

学习资料:http://www.cnblogs.com/lihuiyy/archive/2012/02/24/2366806.html

功能上分为4类:

(1)表达式控制标签:out

- [物理与电子]半导体教材的一个小问题

comsci

问题

各种模拟电子和数字电子教材中都有这个词汇-空穴

书中对这个词汇的解释是; 当电子脱离共价键的束缚成为自由电子之后,共价键中就留下一个空位,这个空位叫做空穴

我现在回过头翻大学时候的教材,觉得这个

- Flashback Database --闪回数据库

daizj

oracle闪回数据库

Flashback 技术是以Undo segment中的内容为基础的, 因此受限于UNDO_RETENTON参数。要使用flashback 的特性,必须启用自动撤销管理表空间。

在Oracle 10g中, Flash back家族分为以下成员: Flashback Database, Flashback Drop,Flashback Query(分Flashback Query,Flashbac

- 简单排序:插入排序

dieslrae

插入排序

public void insertSort(int[] array){

int temp;

for(int i=1;i<array.length;i++){

temp = array[i];

for(int k=i-1;k>=0;k--)

- C语言学习六指针小示例、一维数组名含义,定义一个函数输出数组的内容

dcj3sjt126com

c

# include <stdio.h>

int main(void)

{

int * p; //等价于 int *p 也等价于 int* p;

int i = 5;

char ch = 'A';

//p = 5; //error

//p = &ch; //error

//p = ch; //error

p = &i; //

- centos下php redis扩展的安装配置3种方法

dcj3sjt126com

redis

方法一

1.下载php redis扩展包 代码如下 复制代码

#wget http://redis.googlecode.com/files/redis-2.4.4.tar.gz

2 tar -zxvf 解压压缩包,cd /扩展包 (进入扩展包然后 运行phpize 一下是我环境中phpize的目录,/usr/local/php/bin/phpize (一定要

- 线程池(Executors)

shuizhaosi888

线程池

在java类库中,任务执行的主要抽象不是Thread,而是Executor,将任务的提交过程和执行过程解耦

public interface Executor {

void execute(Runnable command);

}

public class RunMain implements Executor{

@Override

pub

- openstack 快速安装笔记

haoningabc

openstack

前提是要配置好yum源

版本icehouse,操作系统redhat6.5

最简化安装,不要cinder和swift

三个节点

172 control节点keystone glance horizon

173 compute节点nova

173 network节点neutron

control

/etc/sysctl.conf

net.ipv4.ip_forward =

- 从c面向对象的实现理解c++的对象(二)

jimmee

C++面向对象虚函数

1. 类就可以看作一个struct,类的方法,可以理解为通过函数指针的方式实现的,类对象分配内存时,只分配成员变量的,函数指针并不需要分配额外的内存保存地址。

2. c++中类的构造函数,就是进行内存分配(malloc),调用构造函数

3. c++中类的析构函数,就时回收内存(free)

4. c++是基于栈和全局数据分配内存的,如果是一个方法内创建的对象,就直接在栈上分配内存了。

专门在

- 如何让那个一个div可以拖动

lingfeng520240

html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/1999/xhtml

- 第10章 高级事件(中)

onestopweb

事件

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- 计算两个经纬度之间的距离

roadrunners

计算纬度LBS经度距离

要解决这个问题的时候,到网上查了很多方案,最后计算出来的都与百度计算出来的有出入。下面这个公式计算出来的距离和百度计算出来的距离是一致的。

/**

*

* @param longitudeA

* 经度A点

* @param latitudeA

* 纬度A点

* @param longitudeB

*

- 最具争议的10个Java话题

tomcat_oracle

java

1、Java8已经到来。什么!? Java8 支持lambda。哇哦,RIP Scala! 随着Java8 的发布,出现很多关于新发布的Java8是否有潜力干掉Scala的争论,最终的结论是远远没有那么简单。Java8可能已经在Scala的lambda的包围中突围,但Java并非是函数式编程王位的真正觊觎者。

2、Java 9 即将到来

Oracle早在8月份就发布

- zoj 3826 Hierarchical Notation(模拟)

阿尔萨斯

rar

题目链接:zoj 3826 Hierarchical Notation

题目大意:给定一些结构体,结构体有value值和key值,Q次询问,输出每个key值对应的value值。

解题思路:思路很简单,写个类词法的递归函数,每次将key值映射成一个hash值,用map映射每个key的value起始终止位置,预处理完了查询就很简单了。 这题是最后10分钟出的,因为没有考虑value为{}的情