近期我们在读的那些优质论文,你不了解下?

在碎片化阅读充斥眼球的时代,越来越少的人会去关注每篇论文背后的探索和思考。

在这个栏目里,你会快速 get 每篇精选论文的亮点和痛点,时刻紧跟 AI 前沿成果。

点击本文底部的「阅读原文」即刻加入社区,查看更多最新论文推荐。

这是 PaperDaily 的第 132 篇文章![]()

@xwzhong 推荐

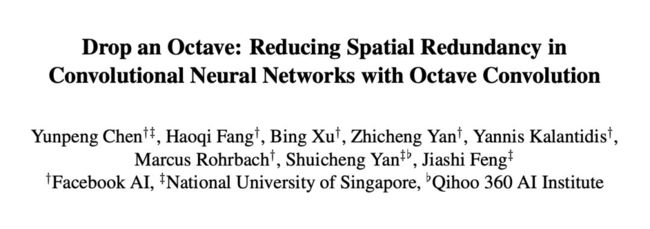

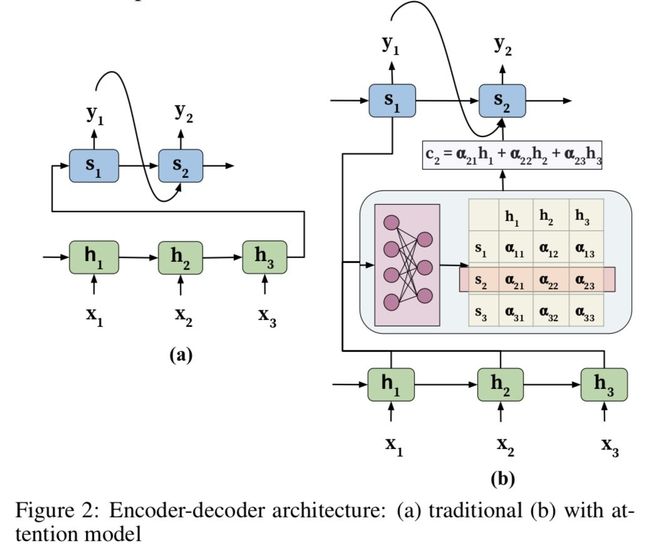

#Attention Mechanism

本文来自 LinkedIn,这是一篇 NLP 领域 Attention model 的综述文章,论文详细介绍了不同架构的网络与 Attention 的结合、Attention如何提高模型的可解释性和 Attention 的应用。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2944

@paperweekly 推荐

#Relation Classification

本文是清华大学刘知远老师组发表于 AAAI 2019 的工作,论文提出文本与图像的一大区别在于其多样性和噪音更大,并提出了一种基于混合注意力的原型网络结构。

具体来说,作者首先使用 instance-level 的 attention 从支撑集中选出和 query 更为贴近的实例,同时降低噪声实例所带来的影响。然后 feature-level 的实例能够衡量特征空间中的哪些维度对分类更为重要,从而为每种不同的关系都生成相适应的距离度量函数,从而使模型能够有效处理特征稀疏的问题。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2926

源码链接

https://github.com/thunlp/HATT-Proto

@paperweekly 推荐

#Contextual Representations

本文是华盛顿大学和 AllenAI 发表于 NAACL 2019 的工作,论文主要研究的问题是预训练词表示的语言知识和可迁移性。作者探索了不同上下文表示的语言知识及其可迁移性,并且还基于 Transformer 模型,将不同层的输出标量加以混合取得了更好的效果。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2956

源码链接

https://github.com/nelson-liu/contextual-repr-analysis

![]()

![]()

@boom 推荐

#Neural Machine Translation

本文是 CMU 发表于 NAACL 2019 的工作。模仿人类从简单的知识学习到复杂知识的学习方式,NMT 方向提出了一个从学习简单的语句翻译到复杂语句翻译的框架,能够在翻译速度上提升百分之 70,BLEU 的得分提高 2.2 个点。

本文提出了学习语句的难度和机器的学习能力两个概念,使得机器只学习难度低于其能力的语句的翻译,然后逐步提升难度;主要应用于数据的预处理上面,所以可以应用于各种 NMT 模型上。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2950

@jingyihiter 推荐

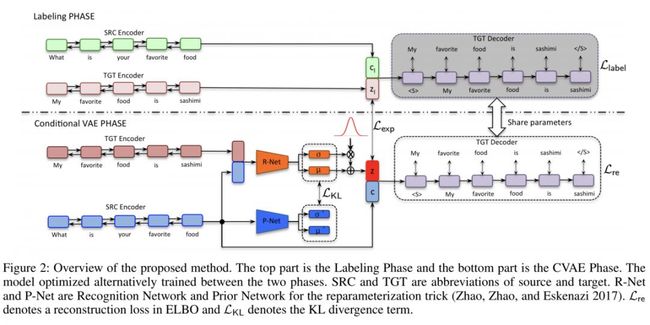

#Text Generation

本文是阿里巴巴发表于 ICASSP 2019 的工作。为了提高生成文本多样性、解决传统 CVAE 中的 KL 散度 vanish 问题,本文提出了一个直接的优化目标,此优化目标指导编码器变成最优编码器增强模型的表达能力。

该方法全称为自标注 CVAE (self labeling CVAE),文中给出了一个“一对多”(生成多种文本)的数据集,实验表明在两个数据集(开放域对话生成和推荐系统句子生成)上与 SOTA 算法相比提高了生成文本的多样性。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2919

![]()

@SRIN 推荐

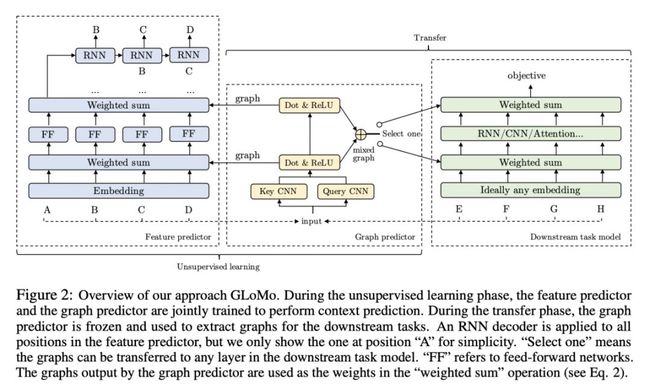

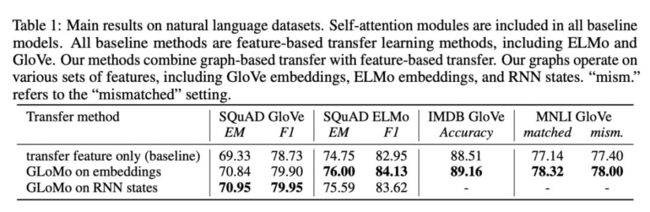

#Graph Embeddings

本文是 CMU、NYU、FAIR 和 Google 发表于 NeurIPS 2018 的工作,论文的主要贡献在于将学习特征之间的关系图作为迁移学习 representation。

作者研究的是迁移学习中的表示问题,学习用表征两个元素之间的关系的图表示,而不是用特征向量表示。作者提出了一种新的无监督隐藏图学习框架,从大规模的未标记数据中训练一个神经网络来输出隐藏图型,并将该网络迁移到提取下游任务的图结构来加强对它的训练。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2911

源码链接

https://github.com/YJHMITWEB/GLoMo-tensorflow

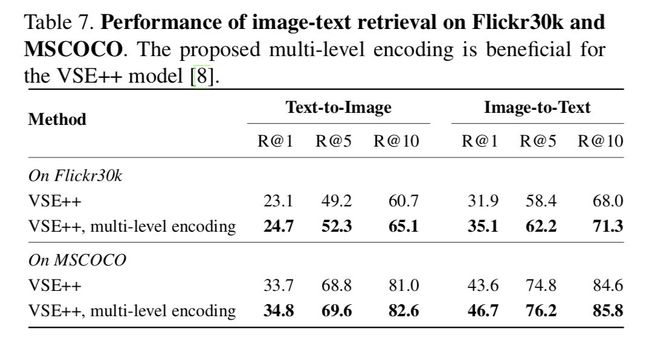

@O3oBigFace 推荐

#Multimodal Machine Learning

本文是 CMU 发表于 TPAMI 2019 的综述性文章,不同于以往对多模态学习的分类,将多模态的近期研究成果按照应用类型划分。对其中的每一种分类进行了详细的描述。本文是近期多模态领域中最详细最完整最新颖的一篇综述,可以看出 CMU 在 multimodal 这方面的造诣很深。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2868

@xiaotian311 推荐

#Object Tracking

本文是林雪平大学、ETH 和起源人工智能研究院发表于 CVPR 2019 的工作,论文着眼于解决目标跟踪过程中的定位精度不够问题。作者将目标跟踪分为目标分类和目标评价两个网络部分,前者分类用于粗定位,后者用于精细定位,即两阶段跟踪。

目标估计网络使用了 ECCV 2018 的 IoUNet 结构,基于大数据集离线训练,训练时最大化与 gt 的 IoU;目标分类网络使用了深度回归网络结构,由两层卷积层构成,在线训练,根据输出的 map 选择候选框交给目标估计网络,并且提出了新的快速在线训练方法。实验表明,本文方法的性能超过了 DaSiamRPN,GPU 下达到 30 fps。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2923

源码链接

https://github.com/visionml/pytracking

@danieljf24 推荐

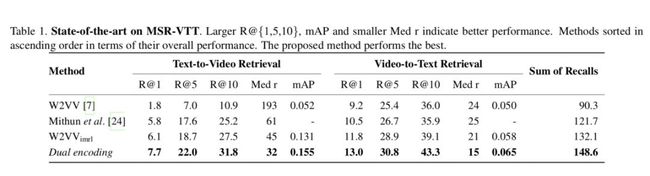

#Video Retrieval

本文是浙江工商大学、人民大学、浙江大学和阿里巴巴发表于 CVPR 2019 的工作,论文主要探讨零示例视频检索。在这种检索范例中,用户在没有示例的情况下,仅通过自然语句描述其即席查询需求。考虑到视频是帧序列而查询是词序列,我们需要建立一个有效的序列到序列的跨模态匹配。

现有方法以基于概念为主,通过分别从查询和视频中提取相关概念,从而建立两种模态之间的关联。相比之下,本文采用了一种无需概念建模的方法,提出对偶深度编码网络,首次使用具有相似架构的多层编码网络同时对句子和视频进行量化编码和表示学习,在多个极具挑战性的评测集(MSR-VTT,TRECVID 2016和2017 Ad-hoc Video Search)上超过了现有结果。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2921

源码链接

https://github.com/danieljf24/dual_encoding

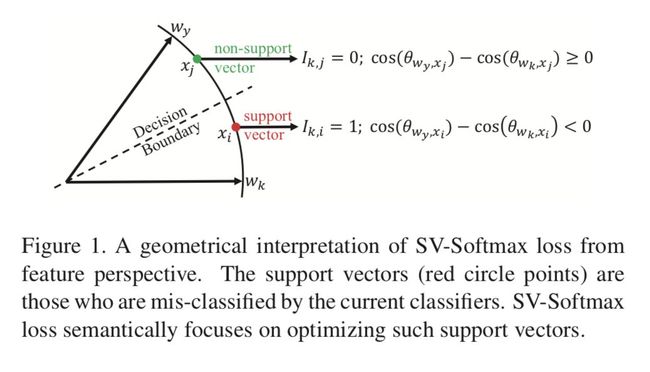

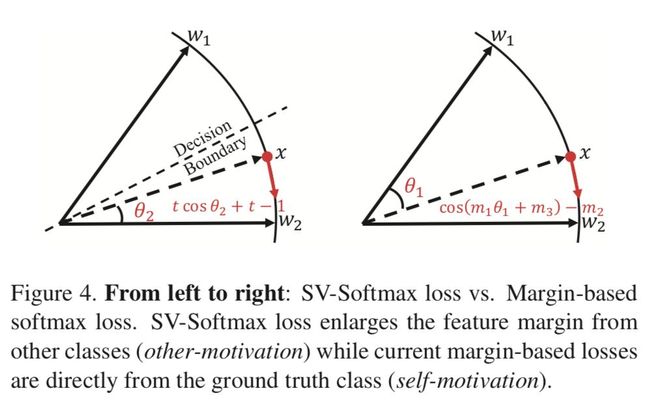

@Kralkatorrik 推荐

#Face Recognition

本文来自京东和中科院自动化所。人脸识别中有两种常见的从 loss 方面促进 feature discriminative 的方法:mining-based 和 margin-based 损失函数,这两种方法都存在其局限性。这篇文章提出了 SV-Softmax loss 能够将两种方法结合,并弥补他们的缺陷,在各个数据集上都取得了 SOTA 的效果。

▲ 论文模型:点击查看大图

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2872

源码链接

https://github.com/tiandunx/SV-X-Softmax

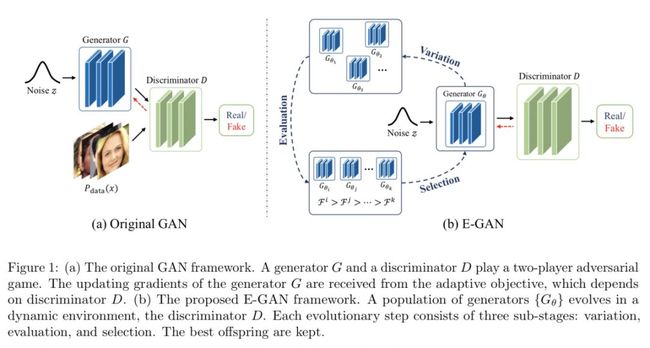

@CLAYxxliu 推荐

#Generative Adversarial Networks

当前现有的很多 GAN 结构在训练的时候并不稳定,很容易就会发生模式崩塌的现象。在本文文中,作者提出一个新颖 GAN 框架称为进化对抗网络(E-GAN)。

该框架摒弃了单一的生成器的设定,将生成器当做一个族群,每个单个的生成器就是一个体,而每个个体的变异的方式是不同的。作者利用一种评价机制来衡量生成的样本的质量和多样性,这样只有性能良好的生成器才能保留下来,并用于进一步的培训。

通过这种方式,E-GAN 克服了个体对抗性训练目标的局限性,始终保留了对 GANs 的进步和成功做出贡献的最佳个体。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2904

源码链接

https://github.com/WANG-Chaoyue/EvolutionaryGAN

@shoujin 推荐

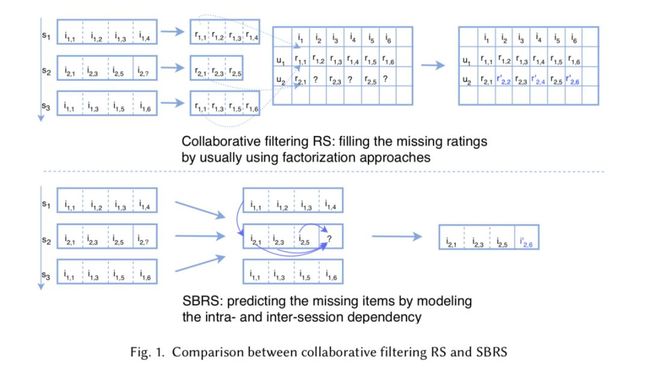

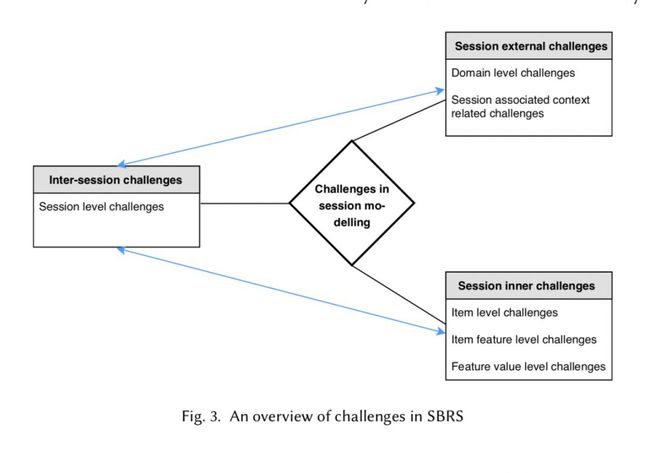

#Recommender Systems

本文是第一篇全面深入总结 session-based recommendations 的综述文章,值得推荐。文章系统总结了目前一种新型推荐范式:session-based recommendations 的特点、挑战和目前取得的进展,对整个推荐系统研究领域和相关的工业界人员提供了一个全面了解推荐系统领域最新研究进展的机会。

该文从问题本质和相关的数据特征入手,为 session-based recommendations 建立了一个层次化模型来深入理解里面存在的各种数据复杂性和潜在挑战,然后采用了两个不同维度对现有研究成果进行了系统分类和总结,最后提出了展望。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2884

![]()

@Xiaoha0607 推荐

#Search Ranking

本文来自 Airbnb,论文主要介绍了 Airbnb 搜索排序系统的演进以及深度学习的应用。文章给出了深度学习在搜索目标问题的实践经验谈,尤其在特征工程、特征重要性分析方面有很多 insight 值得借鉴。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2952

@Glimmer123 推荐

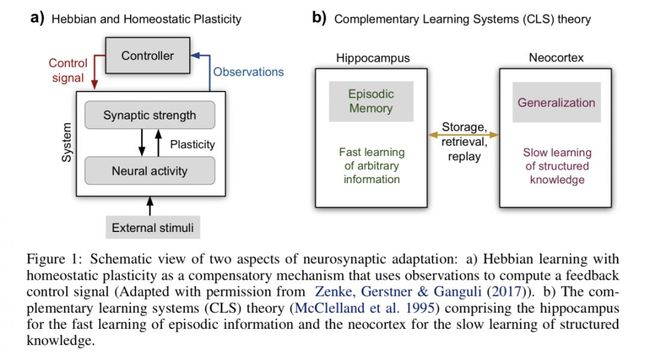

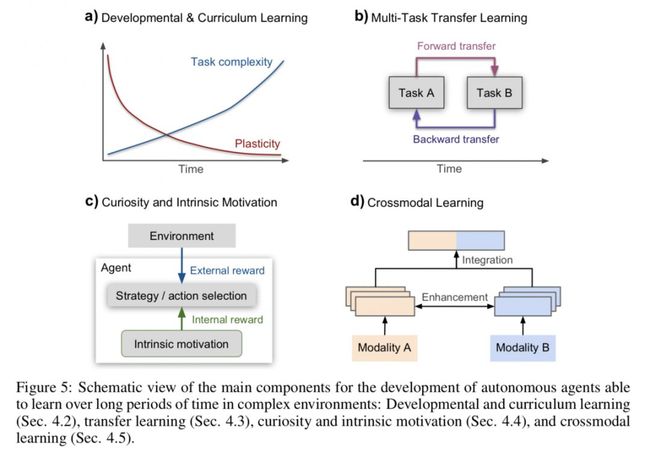

#Continual Lifelong Learning

本文来自汉堡大学、罗彻斯特理工大学和赫瑞-瓦特大学,论文详细介绍了持续终身学习领域相关概念(比如灾难性遗忘),总结三个主要的研究领域,是持续终身学习领域比较好的综述。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2934

@QAQ 推荐

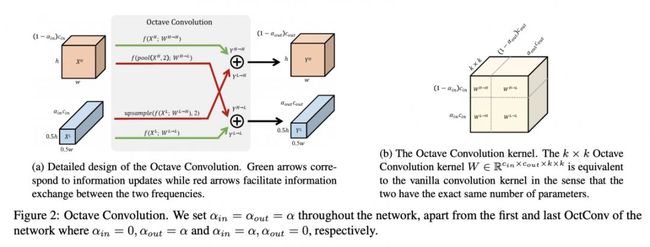

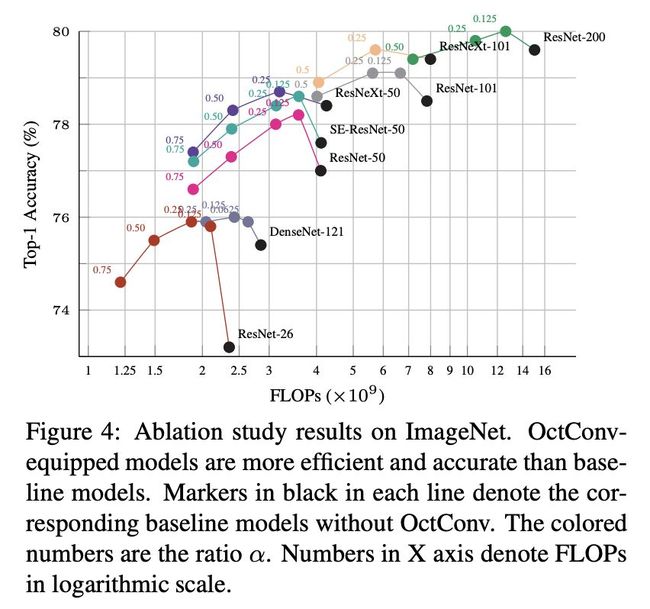

#Convolutional Neural Network

本文来自 Facebook AI、新加坡国立大学和奇虎 360,论文提出 OctConv 用于压缩低频信息,分别处理高低频两个部分的数据,并在二者之间进行信息交换,从而减少卷积运算对存储和计算量的消耗。替代传统卷积,在提升效果的同时,节约计算资源的消耗。即插即用,无需修改原来的网络架构,不用调整超参数。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2954

源码链接

https://github.com/terrychenism/OctaveConv/

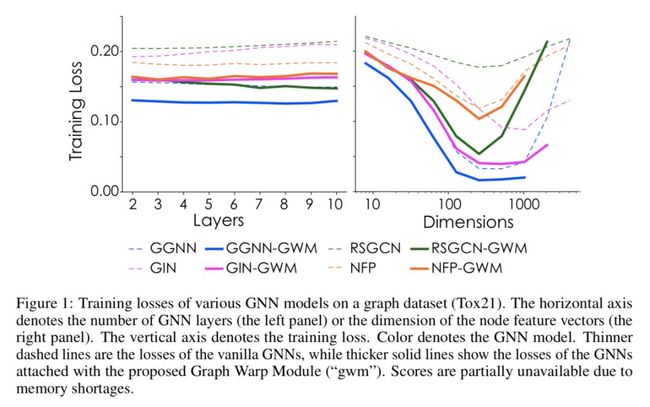

@NeoTheSunshine 推荐

#Graph Embeddings

本文通过实验证明,现有的 GNN 及其相关变体仍然存在对图结构表达能力不足的问题。为了进一步提升模型的表达能力,作者提出一种带有 gating mechanism 的辅助模块 Graph Warp Module,它可以通用使用在 GNN 上而无须改变原有模型结构。通过实验证明了可以使用带有 GWM (Graph Warp Module) 的 GNN 来达到 state-of-the-art generalization performance。

▲ 论文模型:点击查看大图

论文链接

https://www.paperweekly.site/papers/2881

本期所有入选论文的推荐人

均将获得PaperWeekly纪念周边一份

▲ 深度学习主题行李牌/卡套 + 防水贴纸

礼物领取方式

推荐人请根据论文详情页底部留言

添加小助手领取礼物

*每位用户仅限领取一次

想要赢取以上周边好礼?

点击阅读原文即刻推荐论文吧!

![]()

点击以下标题查看往期推荐:

开学综合症有救了!17篇最新AI论文不容错过

NLP、CV、ML方向最新论文清单

本周值得读的15篇AI论文,还有源码搭配服用

近期值得读的10篇GAN进展论文

近期必读的12篇「推荐系统」相关论文

知识图谱合辑:从NeurIPS 2018到AAAI 2019

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

? 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

? 投稿邮箱:

• 投稿邮箱:[email protected]

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

?

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 获取更多论文推荐