【李宏毅2022机器学习】笔记一:ML/DL框架;反向传播;回归;Pytorch使用

B站视频指引:(强推)李宏毅2021/2022春机器学习课程【up在视频下面贴了资料码云nice】

就是顺着看看,之前接触过机器学习(看之前的博客也能发现),现在是回顾加更新阶段,李宏毅老师讲的非常好,但是我觉得还是要一点基础的,不然中音参半啥也听不懂,听完这个说不定就能听全英文了。

目前进度P15Regression

文章目录

- 1 ML/DL框架

-

- 1.1 为什么要用Neuron NetWork,即layer(层)的由来【解释超棒】

- 1.2 Loss一种

- 1.3 用gradient优化参数

- 2 Backpropagation【一种用来使计算Loss更简单的方法】

-

- 2.1 先备:计算中的链式法则

- 2.2 反向传播【有点不太懂】

- 2.3 反向传播的toolkit(工具包)

- 3 Regression

- 0 Pytorch使用

-

- 0.1 导数据

- 0.2 定义神经网络

- 0.3 定义损失函数

- 0.4 优化方案

- 0.5 整个流程

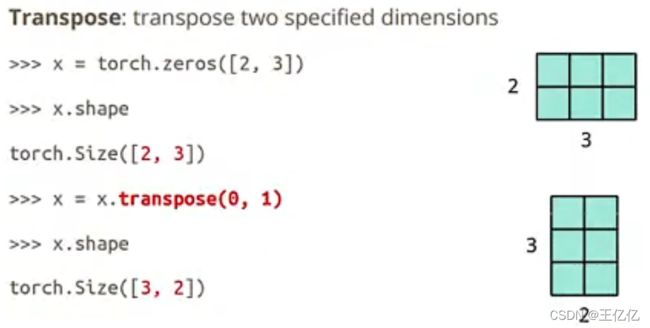

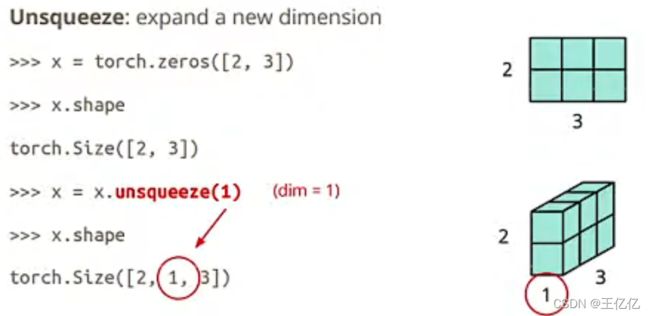

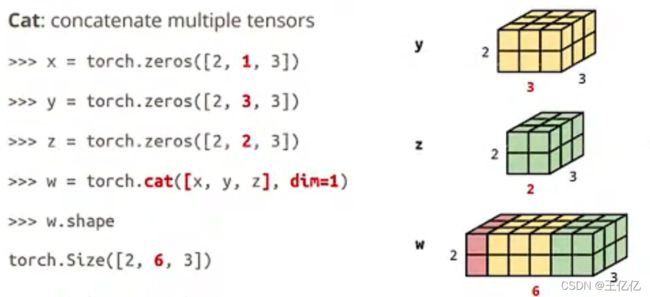

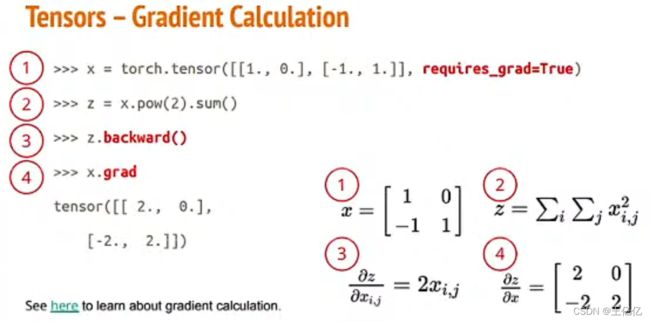

- Tensor

1 ML/DL框架

简单概念:

- 机器学习:使用机器帮助我们写一个人类找不出来的复杂函式

- 深度学习:机器学习的一个分支,机器找出来的这个函式是一个类神经网络。

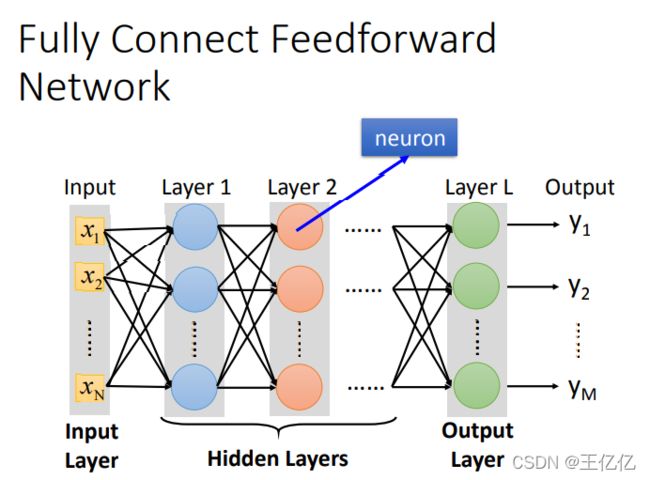

一个Neuron(神经元)=一个激活函数【就是输入x经过function(函数)以后变成输出y】

神经网络=一系列Neuron组成的network

课程主要关注Deep Learning。

例如这个全连接网络模型,目的是找出中间function

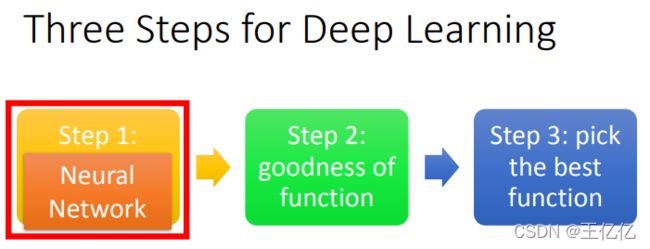

Mechine Learning的三步走:

- 定义未知参数的function。

把拟合训练数据函式设出来,例如:y=wx+b,y=w1x+w2x²+b,… - 定义loss function(损失函数)。

用一个函数来评估训练数据的误差,例如:loss = | y_true - y_predict |. - 借用loss来对function进行优化。

更改初始参数w/b,使整个训练数据的损失朝着减小的方向移动。一般使用gradient(梯度,符号表示∇),即先算导数在沿着导数方向改变。

1.1 为什么要用Neuron NetWork,即layer(层)的由来【解释超棒】

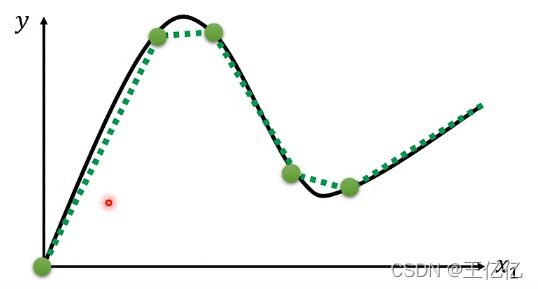

我们常用的function通常都是linear model(线性模型)。

如果我们预期表示一个曲线呢?

(1)只要点取得足够多,就可以把曲线简化为一个类似的折线【求黑色的曲线变为求绿色的折线】

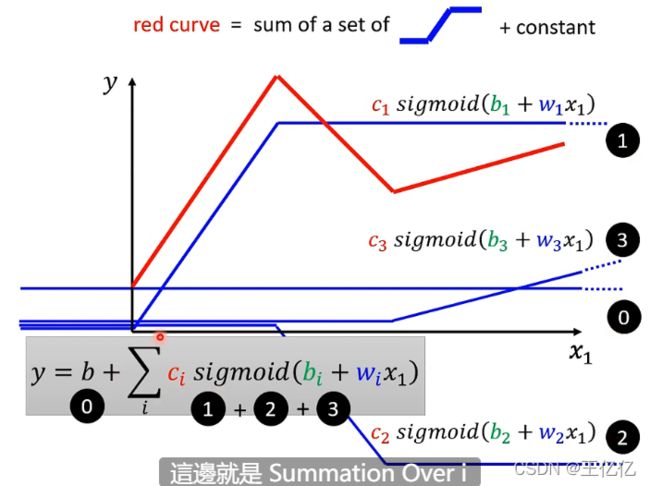

(2)如果不用分段函数怎么表示这样一个折线,可以用一系列已知函式但是参数未知的折线表示(这样可以用求和符号表示它们的组合,使式子更直观,方便求梯度)【红色折线=一系列模板蓝线+常数】

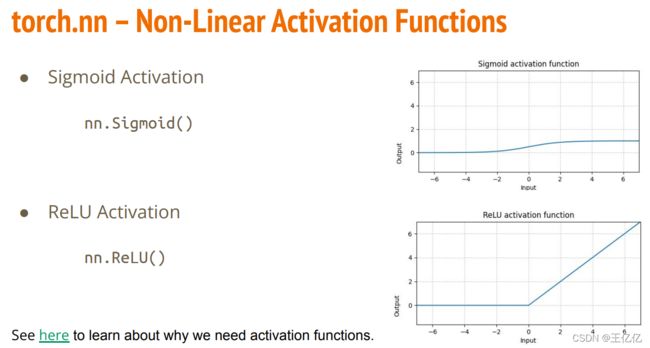

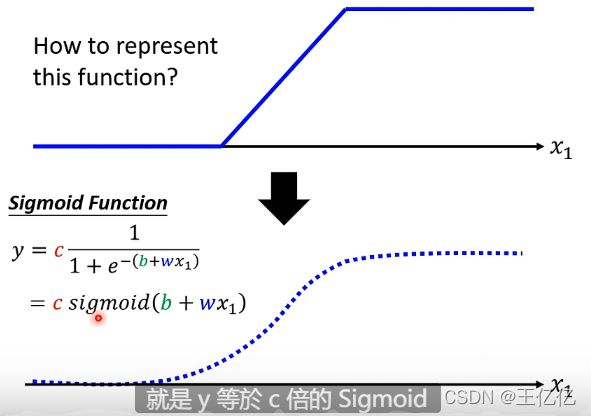

(3)用sigmoid函数近似表示折线。【Sigmoid函数,即f(x)=1/(1+e-x)】

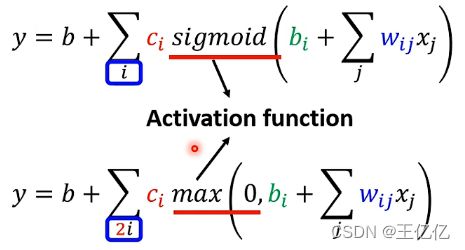

所以现在,我们知道每一个function,都可以用一系列已知式(sigmoid)表示,我们只需要调整参数b,w,c就可以表示不同的function。

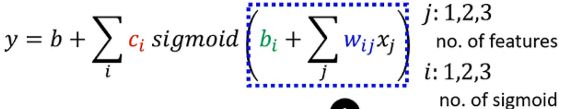

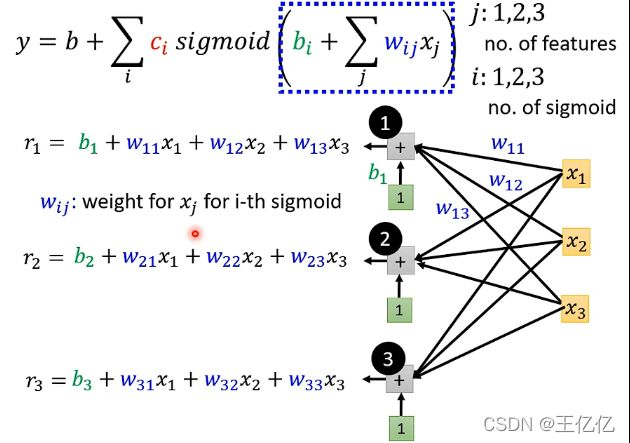

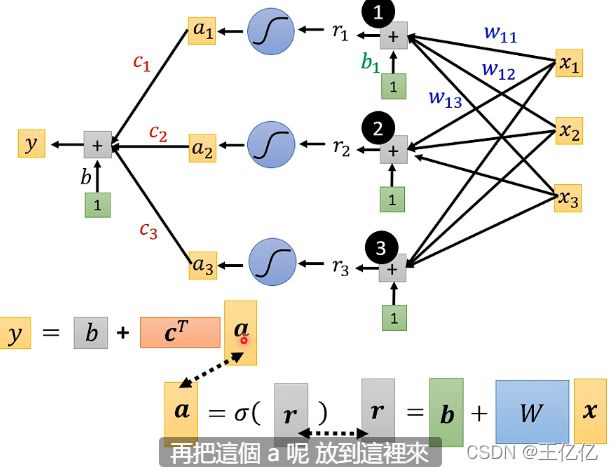

那么我们怎样计算这么一个function呢?

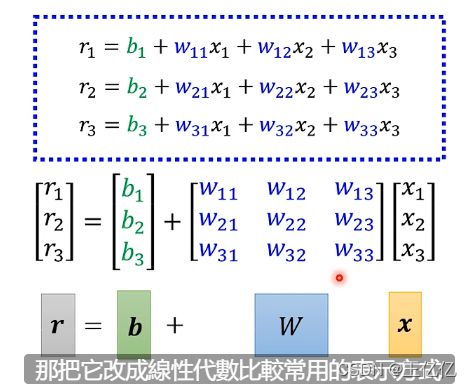

1)首先我们把sigmoid里面展开,透露着熟悉的矩阵运算的样子。

简化成矩阵和向量的乘积

再经过sigmoid函数,用σ()表示【sigma】

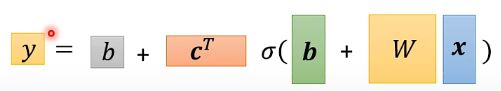

最后这个function就被简化成一个线性代数式子y,我们要求的这个东西就变简单了。

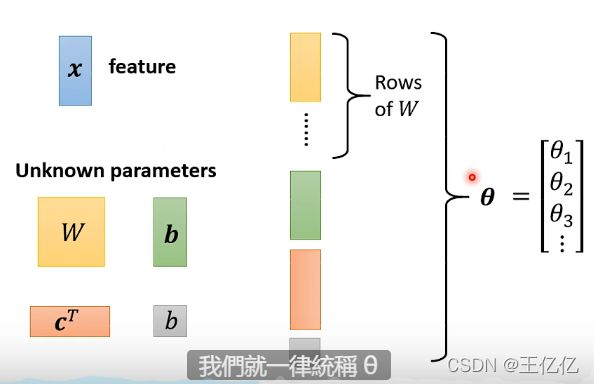

其中x是feature(特征,即输入),其余都是unknown parameters(未知参数),可以统称为θ【theta】,我们随意将它组成一个一维列向量(矩阵w就可以按列拆分)【向量方便运算更新】

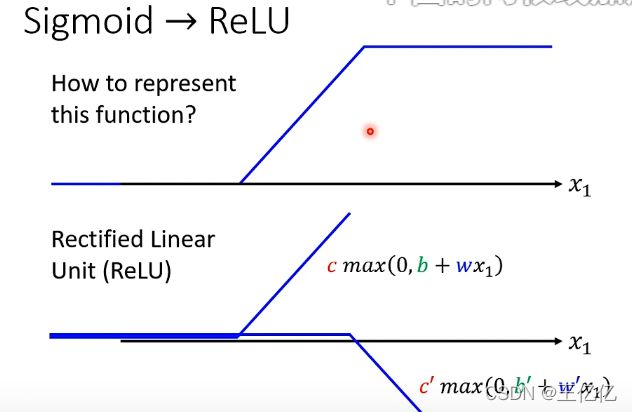

也可以不用Sigmoid,换成Relu,通常有两倍的运算。【但是Relu比较好】

1.2 Loss一种

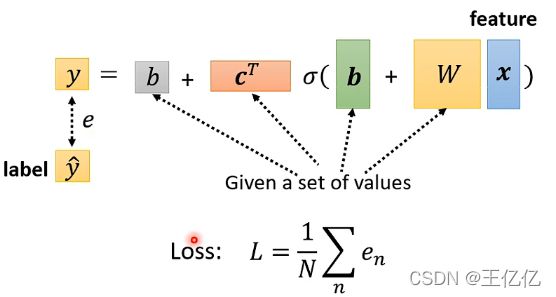

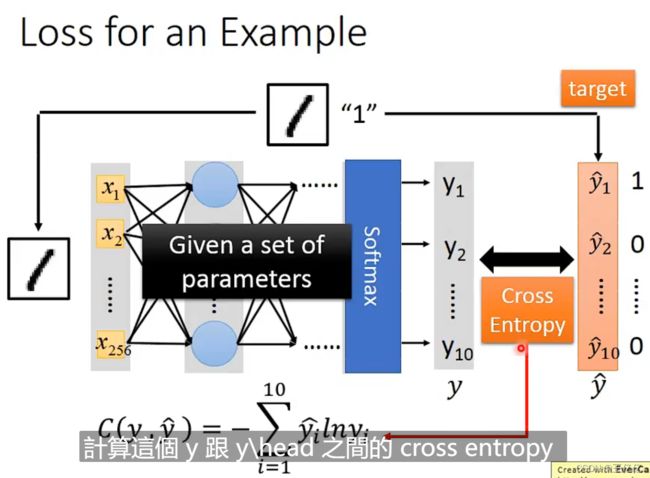

e代表预测结果y与真实label【yhat】距离,这是一个n维向量。

交叉熵

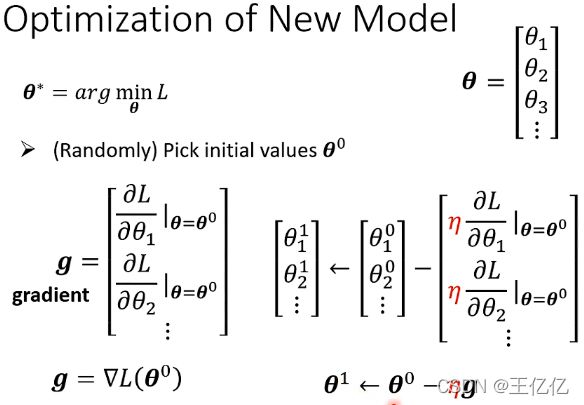

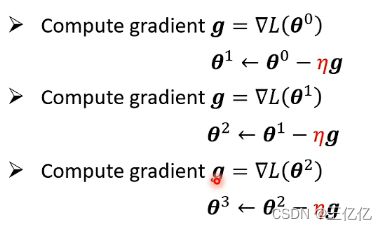

1.3 用gradient优化参数

总的来说就是求导+自定义学习率η【eta】(理解为更新速度/倍数),更新θ。

目的是找一组θ——让我们的Loss越小越好

这组θ叫做θ*【theta的start】

怎么找θ?

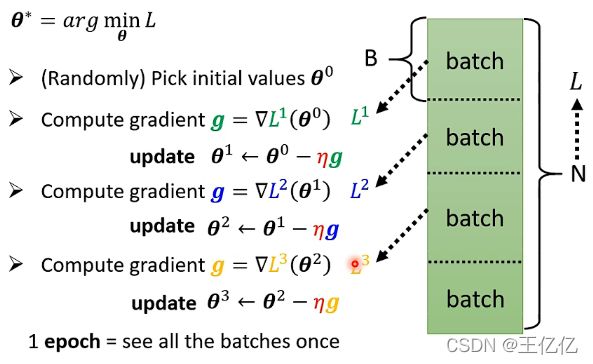

随机选一个初始位置,对每一个参数求初始位置的微分,把这个微分集合称为gradient(梯度)【用▽表示】。算出g以后就可以更新我们的参数。不断迭代,到不再更新为止

实验中,我们将一个大数据N随机分为多个batch(一组),然后用每个B的数据对模型Update(更新)。每个B轮一遍时称为一个Epoch(时期)。

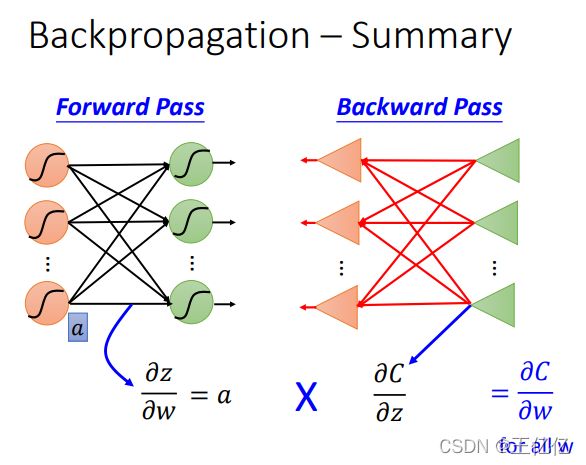

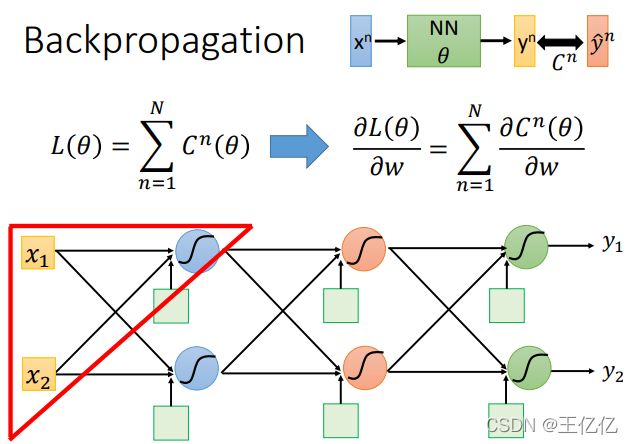

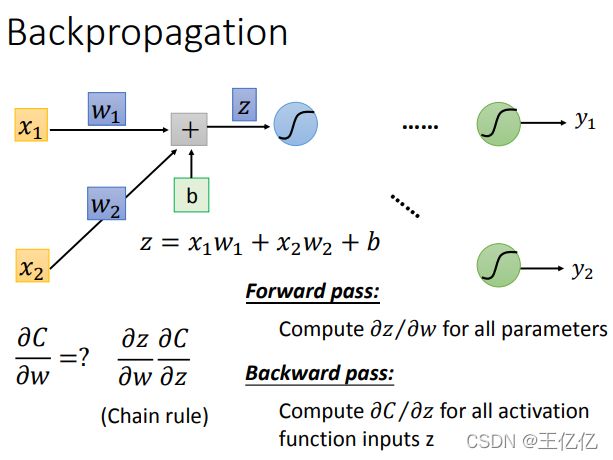

2 Backpropagation【一种用来使计算Loss更简单的方法】

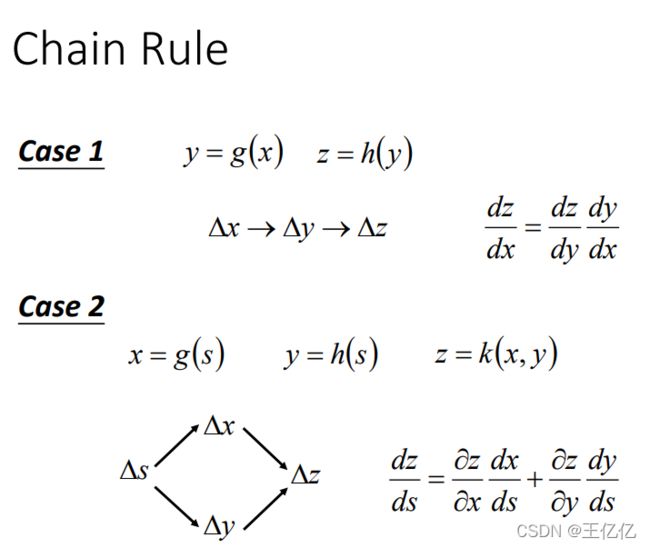

2.1 先备:计算中的链式法则

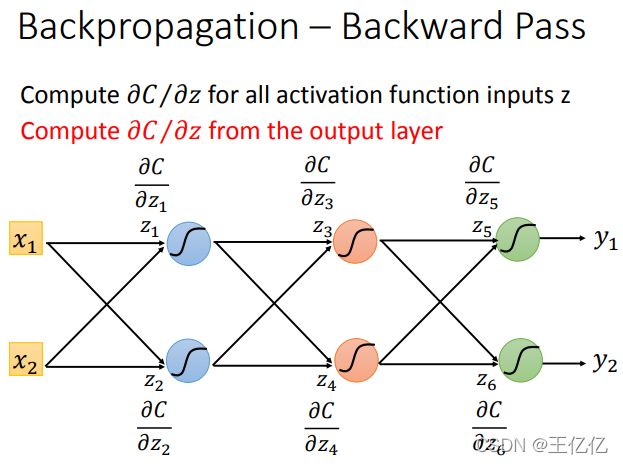

2.2 反向传播【有点不太懂】

(1)对损失函数求微分

求梯度的微分过程是可以提进去的,于是细化为求每一维误差的偏微分。

(2)对一个误差求微分。

我们先从第一个layerZ这里划分一下。

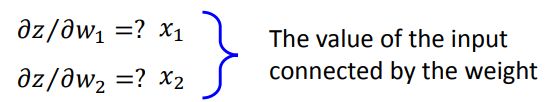

(2.1)forward pass

很简单算出来,为什么叫forward(向前),就是和输入一致。

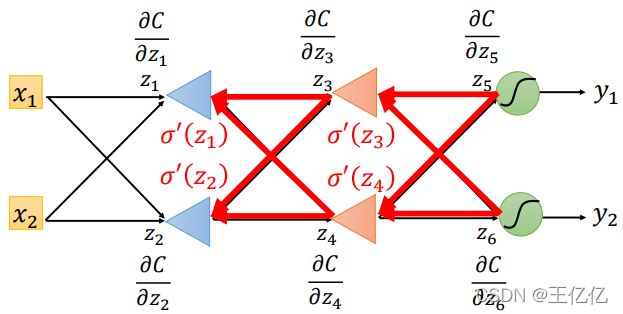

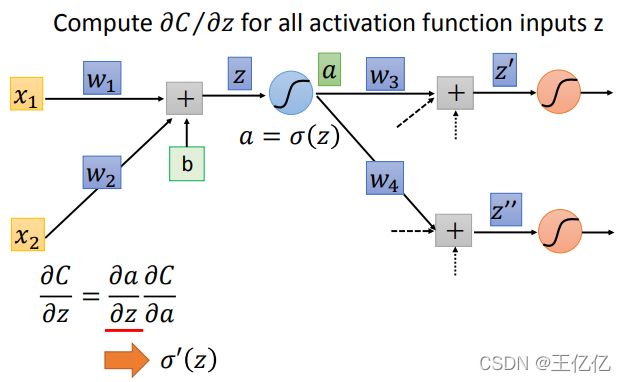

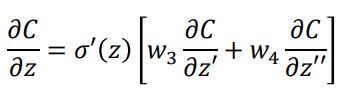

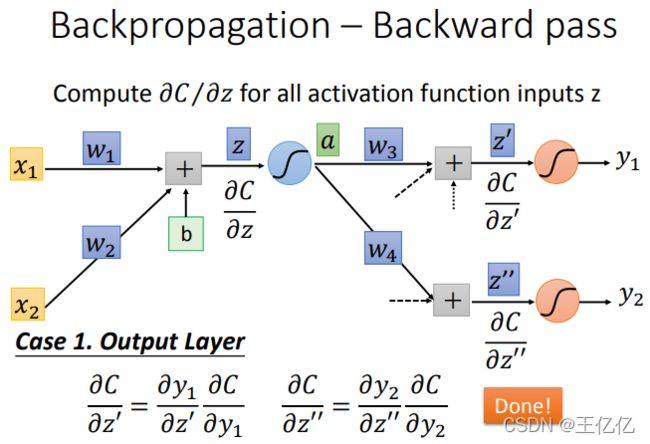

(2.2)backward pass

比较复杂,为啥叫backward,就是你不找到后面的值,算不出来。

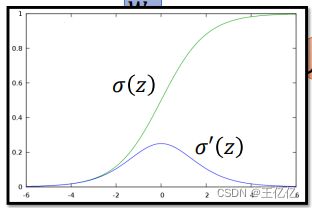

再进行一下微分操作,前面是sigmoid函数的微分(是可以直接算出来的值)

后半部部分未知

所以backward pass演变成

把这两个式子算出来就解决了

怎么算这两个式子,分两种情况:

①这已经是最后一层,直接求

②不是最后一层

这个时候我们假设有一个反方向的function(x⬅…⬅y),从最后一层倒推

2.3 反向传播的toolkit(工具包)

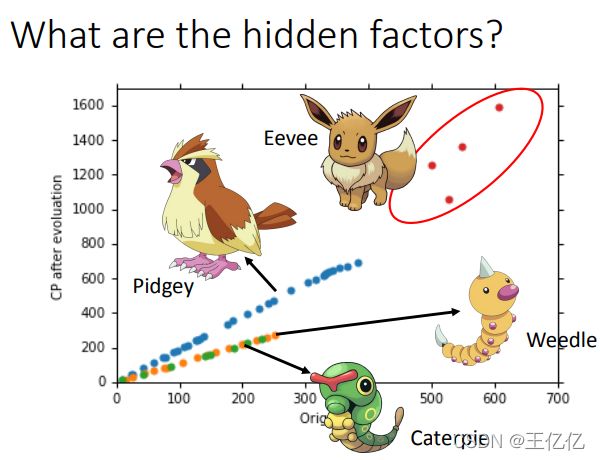

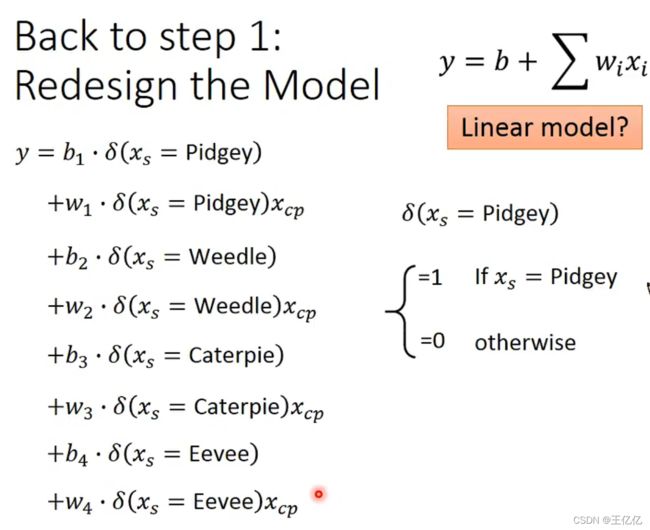

3 Regression

统计学讲回归就是一堆数据画到一个图像上,实际上有一个真实图像,但是你从数据得到的图像和真实的不一样,通过数据越来越多图像就回到真实的图像了,这就是回归。

具体内容参考这篇笔记博客就好:Regression

写的非常完整。

我觉得要注意的就只有两点:

- 训练数据过多会导致模型过拟合,可以删除数据或者设置偏置值来调整模型。

- 考虑其他影响因素,比如物种,对模型适当增加参数。

0 Pytorch使用

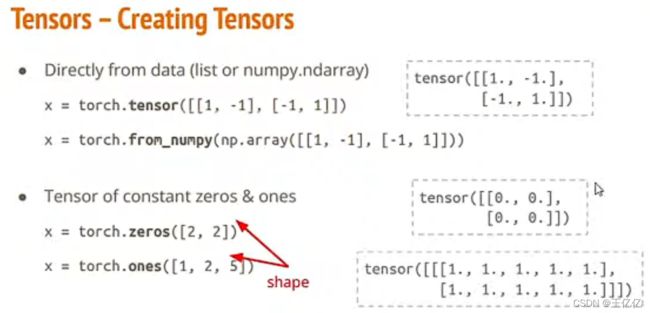

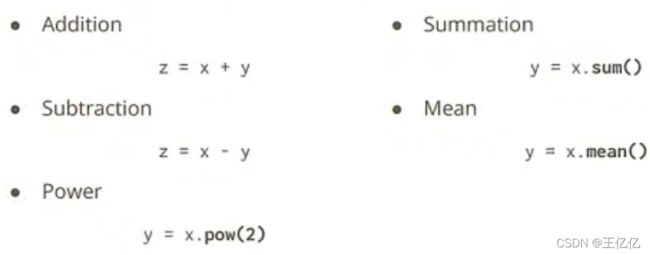

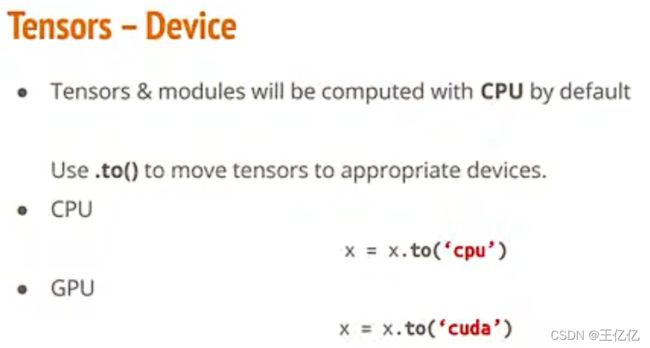

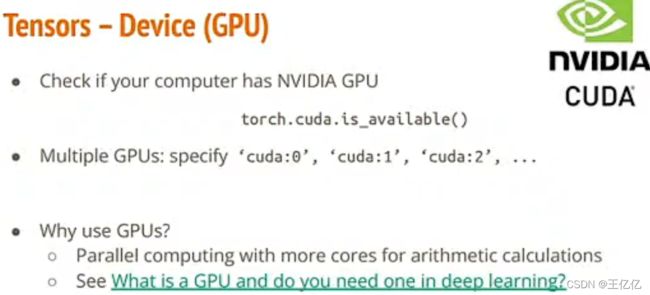

Tensor(张量)就是pytorch中存储数据的主要格式,跟numpy类似。

这个库包中提供了一系列用来做运算的函数。

从DL框架中我们知道了训练数据三步骤,再加上导入数据,所以一共要做的是四件事情:导数据,定义神经网络,定义loss,优化算法。torch都提供了对应方法。

官方文档:PyTorch官方教程中文版

torch.nn: Models, Loss Functions

torch.optim: Optimization

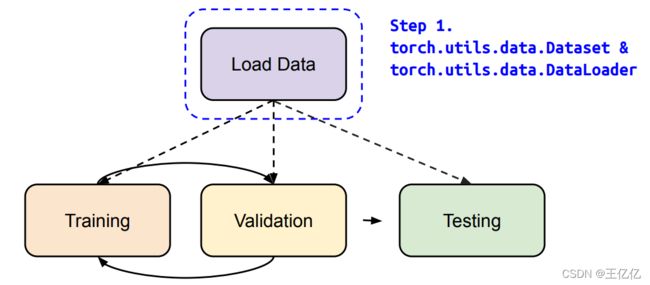

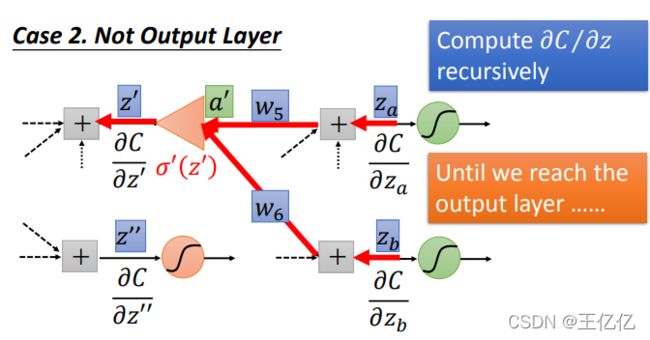

0.1 导数据

Step 1.

torch.utils.data.Dataset

torch.utils.data.DataLoader

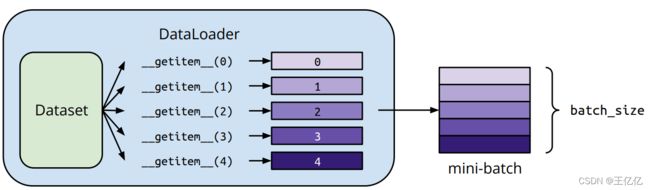

Dataset是一个包装类,用来将数据包装为Dataset类,然后传入DataLoader中,我们再使用DataLoader这个类来更加快捷的对数据进行操作。

DataLoader是一个比较重要的类,它为我们提供的常用操作有:batch_size(每个batch的大小), shuffle(是否进行shuffle操作), num_workers(加载数据的时候使用几个子进程)

怎样自建数据包

定义自己的dataset(三个函数)

init: 用来初始化一些有关操作数据集的参数

getitem:定义数据获取的方式(包括读取数据,对数据进行变换等),该方法支持从 0 到 len(self)-1的索引。obj[index]等价于obj.getitem

len:获取数据集的大小。len(obj)等价于obj.len()

dataset = MyDataset(file)

dataloader = DataLoader(dataset, batch_size=5, shuffle=False)

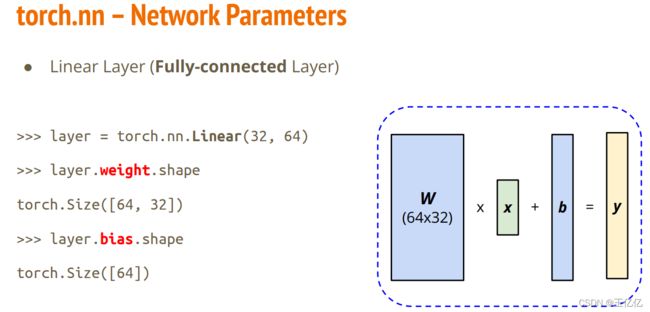

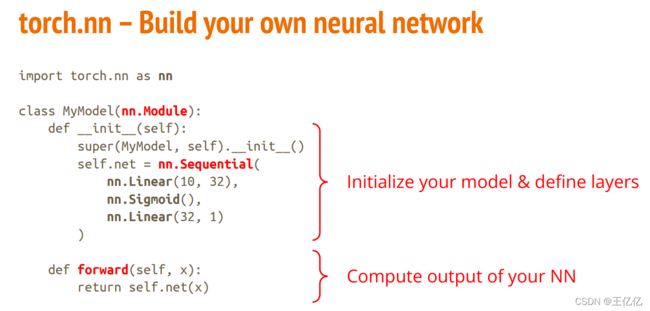

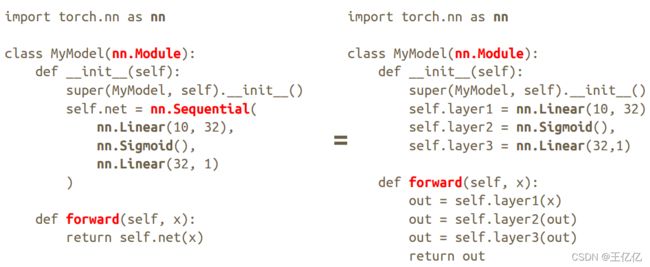

0.2 定义神经网络

Step 2.

torch.nn.Module

0.3 定义损失函数

Step 3.

torch.nn.MSELoss

torch.nn.CrossEntropyLoss etc.

● Mean Squared Error (for regression tasks)

criterion = nn.MSELoss()

● Cross Entropy (for classification tasks)

criterion = nn.CrossEntropyLoss()

● loss = criterion(model_output, expected_value)

0.4 优化方案

Step 4.

torch.optim

● E.g. Stochastic Gradient Descent (SGD)

torch.optim.SGD(model.parameters(), lr, momentum = 0)

● For every batch of data:

1. Call optimizer.zero_grad() to reset gradients of model parameters.

2. Call loss.backward() to backpropagate gradients of prediction loss.

3. Call optimizer.step() to adjust model parameters.

SGD(梯度下降算法)对于每一组数据:

1.前一个计算数据归零

2.结果回推到前面的步骤

3.更新模型参数

0.5 整个流程

# Neural Network Training Setup 训练结构

dataset = MyDataset(file) # 读数据

tr_set = DataLoader(dataset, 16, shuffle=True) # 包装数据(分片)

model = MyModel().to(device) # 运行模式(CPU/G{U)

criterion = nn.MSELoss() # 定义损失函数

optimizer = torch.optim.SGD(model.parameters(), 0.1) # 参数更新策略

# Neural Network Training Loop 循环训练

for epoch in range(n_epochs): # 自定义训练次数

model.train() # 开始训练模式

for x, y in tr_set: # 每一个batch处理

optimizer.zero_grad() # 梯度归零

x, y = x.to(device), y.to(device)

pred = model(x) # 在模型上训练数据

loss = criterion(pred, y) # 计算损失

loss.backward() # 计算梯度

optimizer.step() # 演算法调整模型

# Neural Network Validation Loop 验证

model.eval()

total_loss = 0

for x, y in dv_set:

x, y = x.to(device), y.to(device)

with torch.no_grad():

pred = model(x)

loss = criterion(pred, y)

total_loss += loss.cpu().item() * len(x)

avg_loss = total_loss / len(dv_set.dataset)

# Neural Network Testing Loop 测试

model.eval()

preds = []

for x in tt_set:

x = x.to(device)

with torch.no_grad():

pred = model(x)

preds.append(pred.cpu())

# Save/Load Trained Models

torch.save(model.state_dict(), path)

ckpt = torch.load(path)

model.load_state_dict(ckpt)

验证和测试的时候把梯度计算关掉

防止把测试数据继续训练模型