弱监督目标检测与半监督目标检测

一、监督学习分类

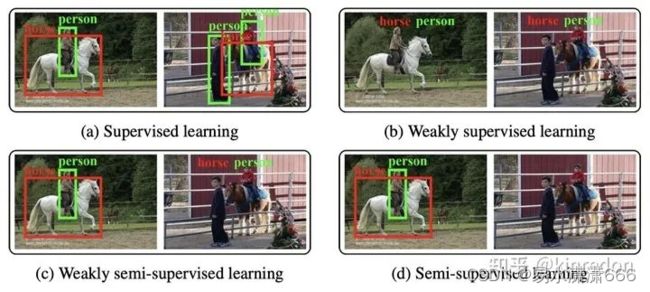

根据数据集的标注情况,分为:监督学习、弱监督学习、弱半监督学习和半监督学习。

监督学习:数据集为带实例级标注的标签,包含坐标和类别信息

弱监督学习:数据集仅带有数据类别的标签,不包含坐标信息

弱半监督学习:数据集中包含少量实例级标注图像,大量数据分类级标注图像,模型期望通过大规模的弱标注数据提升模型的检测能力。

半监督学习:数据集中包含少量实例级标注图像,大量未标注图像,模型期望通过大规模的未标注数据提升模型的检测能力。

二、弱监督目标检测(Weakly Supervised Object Detection,WSOD)

(1)主要思想:

目的:在仅有图像类别的标注情况下,训练一个目标检测器

过程:将图像和proposals丢入目标检测器,训练器根据图像的类别标签来训练(这里的训练loss一般是使用分类的交叉熵,相当于训练一个对proposals分类的分类器);测试时,给定一张图片,目标检测器需要输出图片中的物体的bounding box和对应的类别。

训练步骤:1)产生proposals

2)提取proposals的特征表示

3)使用Multiple instance learning(MIL)给proposals分类

注:可对以上三个步骤进行优化来提升WSOD性能

(2)三大挑战

局部聚焦问题:

由于缺少instance级别的约束,使用class级别的约束造成WSOD仅关注局部区域,因为分类仅需要局部信息,而检测的目标是能够精确定位出物体的最大外界矩阵。

实例却分模棱两可,不容易分辨:

1)丢失实例,由于物体尺度太小与周边环境对比度太小而被忽略

2)一个bounding box框住多个物体,由于物体靠太近,且表现极其相似

大量噪音:

由于没有instances的矩阵标注信息,现阶段的方法都采用大量的object proposals来保证召回率,这样会导致proposals中带大量的噪音(物体的一小部分、背景等),而且训练不稳定还吃GPU。

(3)分类:

基于优化目标函数,我们大致将目前的弱监督目标检测分为两大类:

1)object discovery:

这类方法的目标函数是传统的基于MIL的分类loss。

代表作:Weakly supervised deep detection networks(MIL与CNN结合的开山之作).

2)instance refinement:

此类方法的目标函数除了传统的基于MIL的分类loss,还有使用MIL初步对proposals分类后送到后续的网络做bounding box回归的loss。

代表作:Towards precise End-to-end weakly supervised object detection network.

(4)必读经典论文:

1)Bilen的Weakly supervised deep detection networks

2)Peng Tang的Multiple Instance Detection network with online instance classifier refinement

3)Ke Yang的Towards precise End-to-end Weakly supervised object detection network

三、半监督目标检测(semi-supervised object detection, SSOD)

核心:

充分利用大量未标注、多样性的数据提升模型在测试集上的性能

目前SSOD的两个方向:

1)一致性学习:

利用两个深度卷积神经网络学习同一张unlabeled图像不同干扰(eg水平翻转、不同的对比度、亮度等)之间的一致性,充分利用unlabeled data的信息。

2)伪标签:

利用在labeled data上学习的预训练模型对unlabeled data进行推理,经过NMS后减少大量冗余框后,利用一个阈值去挑选伪标签,最后利用伪标签训练模型。

相关论文:

1)Consistency-based Semi-supervised learning for object detection

2)A Simple Semi-supervised learning Framework for object detection

3)instance-teaching: An End-to-end Semi-supervised object detection Framework

4)Data-Uncertainty Guided Multi-Phase learning for Semi-supervised object detection

5)Unbiased Teacher for Semi-supervised object detection

6)Interactive Self-Training with Mean Teacher for Semi-supervised object detection