基于深度学习的三维语义理解(分割)综述列表

基于深度学习的三维语义理解(分割)综述列表

文章目录

- 基于深度学习的三维语义理解(分割)综述列表

- 前言

- 基于深度学习的三维语义理解(分割)综述列表

-

- 一、 从单一三维模型中进行深度学习

-

- 1.1基于点云的方法

- 1.2基于体素的方法

- 1.3基于mesh的方法

- 二、多模态融合的方法

-

-

-

- Frustum-based Mthods

-

- 2.1紧耦合

- 2.2松耦合

-

- 三、语义SLAM的方式(应该都属于多模态融合的方法)

- 总结

前言

随着2016年pointnet的发表,三维空间中的语音理解逐渐进入了爆发式的增长,本文对至今一些优秀的文章进行部分整理。

注:文中表示的被引次数均为2020年10月3日差得结果

基于深度学习的三维语义理解(分割)综述列表

一、 从单一三维模型中进行深度学习

1.1基于点云的方法

- 基于多视图

(1)MVCNN(Su et al )(2015)(被引121)

(2)MHBN(Yu et al)(2018)

(3)View-GCN(Wei et al)(2020)

(4)SnapNet(Boulch et al)(2017)(可分割)(被引72)

(5)DeepPr3SS(Lawin et al)(2017)(可分割)

(6)TangentConv(Tatarchenko ta al)(2018)(可分割)

(7)MV3D(Chen et al.)(2017)

(8)RT3D(Zeng et al )(2018)

(9)ContFuse(Liang et al)(2018)

(10)AVOD(Ku et al)(2018)

(11)SCANet(Lu et al )(2019)

(12)MMF(Liang et al)(2019)

注:

基于BEV的方法: (且是single shot methods)

(1)PIXOR(Yang et al)(2018) (被引271)(实时)

(2)HDNET(Yang et al)(2018) (被引92)

(3)BirdNet(Beltran et al.)(2018) (被引66)

(4)PointPillars(Lang et al.)(2019) (被引250+)(实时)

工业界的文章,速度极快的提升了 。

作者写作的出发点: 对三维点云进行实时检测的一种方法。

本文贡献:

提出了一种端到端的网络,利用原始的三维点云数据,,在不丢失三维信息的同时,将点云数据转换为pillars,然后通过一种新颖的编码器,将这种数据转换为一种伪二维图像(一种三维张量)然后再这种伪二维数据中,进行大量的CNN,来完成高速,实时的检测任务。

关键点:在三维点云上的BEV转换成的pillars;将pillars转换为伪二维图像;利用CNN进行深度学习;速度极快,可以达到105Hz。

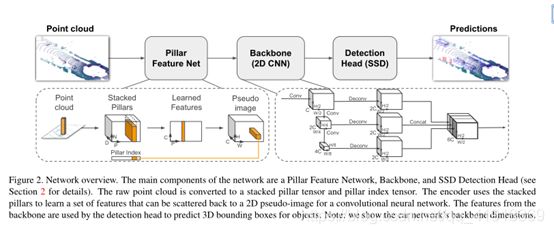

网络架构:

三大步骤:

(1) Pillar Feature Net(生成伪图像)

首先在俯视图的平面上打网格(H x W)的维度;然后对于每个网格所对应的柱子中的每一个点都取(x,y,z,r,x_c,y_c,z_c,x_p,y_p)9个维度。其中前三个为每个点的真实位置坐标,r为反射率,带c下标的是点相对于柱子中心的偏差,带p下标的是对点相对于网格中心的偏差。每个柱子中点多于N的进行采样,少于N的进行填充0。于是就形成了一种三维张量pillars(D,N,P),其中D=9, N为点数(设定值),P为HW。

然后通过本文的编码器,将pillars中的数据,进行数据转换,用一个简化的PointNet将D维转换为C维(学习特征的一个小过程),变成(C,N,P)让对N维方向上进行最大池化操作,使得其变为(C,P)。此时P是HW(BEV的网格分辨率),此时我们又成了一个三维张量(H,W,C)一种伪二维图像。

(2)在伪图像上进行成熟的2维CNN操作,速度比三维卷积快了相当多。

(3)基于SSD的目标检测头进行bbox回归。

(5)Point-GNN(Shi et al )(2020)(被引14)

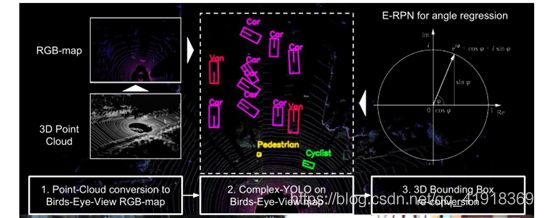

(6)Complex-YOLO: An Euler-Region-Proposal for Real-time 3D Object Detection on Point Clouds(Simon et al)(2018)(被引70+)(实时)

注:本文虽然只有点云数据,但文章中的带RGB的点云数据是如何得来的???文章中并未说清楚,

本文贡献:

1.首次将YOLO结合到实时的三维物体检测中,

2.本文设计了complex-YOLO,该网络引入了新的E-RPN(本文说该论文成功的关键),E-RPN是一种用于借助复数来估计方向的欧拉回归方法。E-RPN为3Dbox估计提供了可靠的角度回归功能。

3.本文是第一篇在自动驾驶检测方面做到实时处理的文章(在嵌入式平台NVDIA TX2中也可以较好的进行实时检测任务。)(精度和前人差不多,但效率上提升了5倍多)

网络结构:

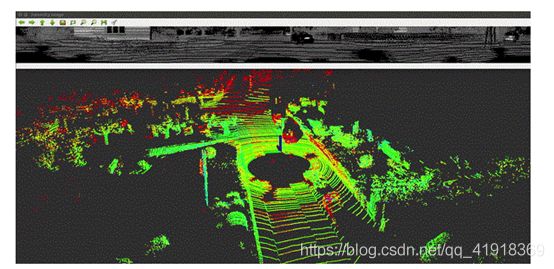

图片上方为球形投影的结果,下方是点云。

上方图像的每一行对应于从激光雷达的每个激光获得的点。在此,图像中的最低行对应于激光雷达中的最低激光,是激光雷达附近最接近的环,如上所示。

投影不是及那个曲面进行简单地展开,而是一个基于坐标系变换的过程。(将三维的点用图片的形式来表示)

具体如何进行球面投影,可以参考https://blog.csdn.net/weixin_43199584/article/details/105260463

(1)SqueezeSeg(wu et al 2017)(可分割)(被引206)

本文的核心贡献,是对三维的点云进行预处理,将点云数据变换成图片的形式来表示,然后利用成熟的二维卷积的方法来完成分割任务。

(2)SqueezeSeg22(Wu et al 2018)(可分割)(被引93)

(3)RangeNet++(Milioto et al 2019)(可分割)(被引48)

RangeNet++是以SqueezeSeg和SqueezeSegV2为基础,都使用了点云的球面投影的方法,可以将点云数据转换为可以支持很多成熟的二维图像处理方法的数据。(用图片的方式来表示点云)(有效的将点云数据进行降维的方法),同时该方案计算量相对较小,适合于自动驾驶等领域进行实时处理。

处理流程:

- 将三维点云数据通过球投影的方式转换为二维的表示方法。

- 在该二维的iamge上进行2D全卷积语义分割。

- 将分割成功的2D信息转换到3D点云上

- 对分割结果进行优化。

- MLP

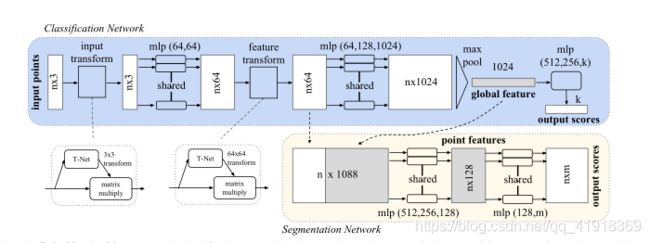

(1)PointNet(Qi et al)(2016)(可分割)(被引3000+)

见https://blog.csdn.net/qq_41918369/article/details/108075239

(2)PointNet++(Qi et al)(2017)(可分割)(被引1800+)

见https://blog.csdn.net/qq_41918369/article/details/108075239

(3)3DContextNet(Zeng et al.)(2017)(可分割)(被引17)

(4)A-SCN(xie et al.)(2018)(可分割)

(5)PointSIFT(Jiang et al )(2018)(可分割)(被引91)

(6)Engelman(Engleman et al)(2018)(可分割)

(7)PAT(Yang et al.)(2019)(可分割)

(8)LSANet(chen et al)(2019)(可分割)(被引8)

(9)PointWeb(Zhao et al)(2019)(可分割)(被引58)

(10)ShellNet(Zhang et al )(2019)(可分割)(被引40)

(11)RandLA-Net(Hu et al)(2019)(可分割)

(12)Mo-Net(Joseph-Rivlin et al)(2018)

(13)SRN(Duan et al)(2019)

(14)JustLookUp(Lin et al)(2019)(被引3)

(15)PointASNL(Yan et al)(2020)(被引7)

(16)PointRCNN(Shi et al)(2019)(被引262)

作者提出了一种三维物体检测器pointRCNN,可以直接从原始的点云中检测三维物体,(该网络为two-stage网络),stage-1直接从点云中生成多个粗略的3Dbox,stage-2,优化一阶段的3Dbox并对每个box中的物体进行class分类。

stage-1:

先通过pointnet++对每个点的特征进行提取,然后通过点的特征,将所有的点分为前景点和背景点,并将背景点删除,同时在前景点上,对每个点都生成一个box,然后通过部分优化,留下,部分得分最高的box。

stage-2:

将stage-1中生成的部分精准的box进行标准化坐标变换,然后再通过局部的pointnet,进行局部特征的学习,得到局部的特征向量,再和全局的特征向量进行拼接,然后优化每个点的特征,然后重新生成一个最优的3D-box,同时完成class任务。

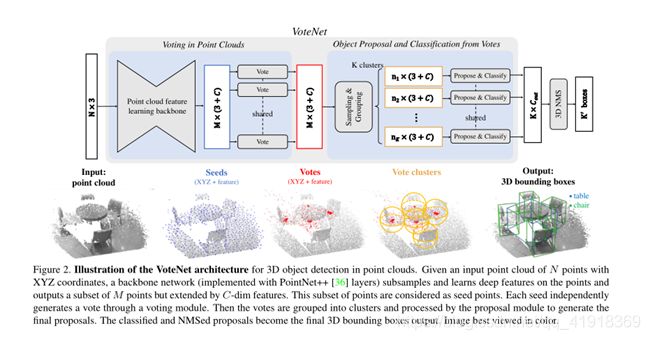

(18)Deep Hough Voting for 3D Object Detection in Point Clouds(Qi,et al. )(2019)(被引用100+)(Charles QI 和何凯明大神)

本文贡献:

1.本文将hough voting引入三维深度学习领域中,并证明了其可行性。

2.本文提出了一种end-to-end的网络,在点云的五条人检测中证明了其可行性。总体思路:

先通过点云来得出一类物体的中心坐标,然后对中心目标一定范围内的物体进pointnet++再得取特征,生成物体的proposal,给物体打好label,完成对物体的detection任务

网络框架:

- 在点云中进行投票:

先用一个pointnet++来对每个点进行特征的学习,同时也会对网络做一个类似于coarsening的操作,得出的点称为Seeds。注:N>M。然后利用一个共享的Vote网络来计算每个点的投票结果,最终计算出vote的中心坐标和中心点的feature。- 生成object proposal和物体的类别 (1) 使用FPS(farthest point sampling)从 M 个投票结果中,采样出 K个投票结果 (2) 对 K个采样点,分别用特定的半径R,找到它的所有邻居点。这样就形成了 K个vote

cluster。 (3) 对于每个vote cluster,把它看作一个小的点云,用一个PointNet网络来处理,最后得出每个vote

cluster的feature。把这个feature里面的数据,分别看作:是否为物体的得分、bounding

box参数、分类得分等信息,用来计算loss。

- 基于图卷积网络的方法

(1)SPG(Landrieu and Simonovski)(2018)(可分割)(被引296)

(2)SSP(Landrieu and Bussaha)(2019)(可分割)(被引28)

(3)DGCNN(Wang et al)(2018)(可分割)(被引700+)

Dynamic Graph CNN for Learning on Point Clouds

本文贡献:(1)EdgeConv在保证置换不变性的同事捕获局部几何信息。

(2)DGCNN可以在动态更新图的同事,在语义上将点聚合起来,

(3)EdgeConv可以迁入多个已有的多个点云处理框架中。

本文提出了一个新的神经网络模块——EdgeConv.

EdgeConv的优点:(1)包含了局部邻域的信息,

(2)可以通过EdgeConv模块的循环使用,提取全局的形状特征。

(3)在多层系统中,特征空间中的相对关系包含了语义特征。

EdgeConv的不足:EdgeConv考虑了点的坐标与领域点的距离,但是忽略了相邻点之间的向量方向,最终还是损失了一部分的局部几何信息。

EdgeConv:

首先提取中心点与临近店之间的边特征,再进行卷积操作。

具体步骤:

(1)先利用MLP对每个点提取一遍特征

(2)再利用多种方式将点和周围点的特征进行融合,本文提出了四种融合方式,此处介绍一种,我个人认为最合理的一种方式:将中心点的特征,与中心点与K个临近点之间的特征差进行串联,然后输入MLP中,这样便融合了点之间的局部关系和点的全局特征。

作者认为PointNet++不足的原因: pointnet++在处理局部区域的点的时候未来保证置换不变性而导致过于独立,这样会忽视了点之间的集合相关信息,导致一部分的信息丢失。

(4)PyramNet(Kang and Liu.)(2019)(可分割)(被引3)

(5)GACNet(Wang et al)(2019)(可分割)(被引64)

(6)SPH3D-GCN(Lei et al)(2019)(可分割)(被引9)

(7)HEPIN(Jiang et al )(2019)(可分割)

(8)DPAM(Liu et al.)(2019)(可分割)

(9)ECC(Simonovsky et al)(2017)

(10)KCNet(Shen et al.)(2017)(被引155)

(11)FoldingNet(Yang et al.)(2017)(被引235)

(12)AGCN(Li et al.)(2018)

(13)LocalSpecGCN(Wang et al )(2018)

(14)RGCNN(Te et al .)(2018)(被引60)

(15)3DTI-Net(Pan et al )(2018)(被引1)

(16)ClusterNet(Chen et al.)(2019)(被引21)

(17)DPAM(Liu et al.)(2019)

(18)Grid-GCN(Xu et al.)(2020)(被引7)

(19)DeepGCNs(2019)(可分割)(被引84)

本文作者认为CNN(完美的应用欧氏距离的数据中)成功的原因在于:CNN可以设计并使用深层的网络结构,,但现在GCN(用来处理拓扑结构的数据)现阶段只能处理2-3层的数据,(由于深层的GCN的Aggregate容易造成over

smooth问题,即节点间的feature难以区分),本文来探究能否也生成一个深层的GCN网络模型。本文解决深度GCN出现的问题的方法,使用residual/dense connections 和DGCNN中的 edge conv

三种方法方法一同来克服了深度GCN中出现的问题。

- 基于点的卷积的方法

(1)PointCNN(Li et al)(2018)(可分割)(被引400+)

本文的主要贡献是:引入了一个新的运算方法X-Conv

本作者想要解决对无序的点云的卷积问题,作者的解决核心思路是:将无序的点云进行有序化变换,然后使用卷积的方法,进行特征提取。

作者的解决方案:使用空间变换网络(STN)从前一层的数据中提取K个点,预测一个K*K大小的转置矩阵(X-transformation),用转置矩阵对前一层的特征做变换,然后对变换后的特征用卷积。此外,同样也在提取出k个近邻后,将各个点转换到局部坐标系。

PointCNN的优点:参数少,训练时间短,比较优美但pointconv作者认为该篇文章没有实现置换不变性

X-Conv的具体过程看见周报笔记。

(2)MCCN(Hermosilla et al)(2018)(可分割)

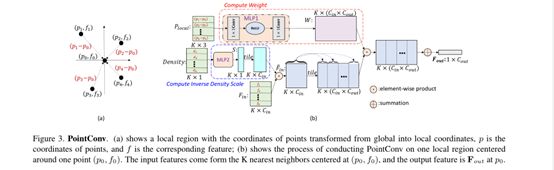

(3)PointConv(Wu et al)(2018)(可分割)(被引150+)

作者的写作出发点:作者通过对一维卷积和二维卷积的理解中,认为卷积主要由两部分组成,(1)将目标点和周围点都考虑进来,(K近邻)(2)不同位置的点的输入权重是不一样的,所以本文是要解决如何得到一个关于不同K近邻点的权重系数问题。(求解权重函数)

本文贡献:

(1) 提出了一种新的三维卷积运算,pointconv。一种考虑密度的不断跟新权重的网络。该网络最重要的创新是:可以有效地计算权重函数。

(2) 该网络能够完全近似任何一组3D点上的3D连续卷积。

(3) 本文还提出了相应的反卷积操作PointDeconv。将特征传播回原始分辨率。像二维空间中一样,使用全卷积网络能够更精确的完成分割任务。

网络架构:

(a) 是将全局坐标系下的全部点的坐标,转换为以P为中心点后,转化为局部坐标的过程,

(b) 中的上部分,是将(a)中转化后的K近邻点的局部坐标当做输入,然后通过局部的多层感知器进行权重的训练;下部分是将点的密度考虑进来,主要是处理点云采样不均的问题.

注:(1)Pointconv中的MLP的权重在所有点之间是共享的,来保证排列不变性。

(2)作者为了证明pointconv是真正的卷积运算,作者还将2D图像中的所有像素转换为具有2D坐标以及RGB值的点云格式,其分类结构可以和正常的图像的CNN媲美。

所以作者认为本篇文章既可以是三维场景中的CNN方法。

(4)ConvPoint(Boulch et al.)(2019)(可分割)(被引10)

(5)A-CNN(Komarichev et al)(2019)(可分割)(被引36)

(6)KPConv(Thomas et al)(2019)(可分割)(被引139)

(7)InterpCNN(Mao et al)(2019)(可分割)(被引35)

(8)DPC(Engelmann et al.)(2019)(可分割)

(9)SphericalCNN(Spherical)(2017)(被引277)

(10)Point wise CNN(Hua et al)(2017)

(11)Tensor field Network(Thomas et al)(2018)(被引90)

(12)Flex-Convolution(Groh et al.)(2018)(被引15)

(13)PCNN(Matan et al.)(2018)

(14)SpiderCNN(Xu et al)(2018)(被引181)

(15)MCCNN(Hermosilla et al)(2018)

(16)Geo-CNN(Lan et al)(2018)(被引32)

(17)Ψ-CNN(Lei et al)(2019)(被引26)

(18)LP-3DCNN(Kumawat et al.)(2019)(被引18)

(19)RS-CNN(Liu et al.)(2019)(被引87)

(20)KPConv(Thomas . Charles R. QI et al )(facebook ai )(2019)(被引150+)

(21)SFCNN(Rao et al.)(2019)

(22)DensePoint(Liu et al)(2019)(被引25)

(23)ConvPoint(Boulch et al.)(2020)(被引10)

-

(24) Associatively Segmenting Instances and Semantics in Point**(被引49)**

(26)4D Spatio-Temporal ConvNets: Minkowski Convolutional Neural Networks(choy et al )(2019)(被引50+)

- 基于RNN的方法

循环神经网络的本质是:像人一样拥有记忆的能力,使得机器能够联系上下文的语句,理解当 前单词或者预语句的意思 现阶段的RNN的各种变形还可以学习二维视频信息和三维视频的信息。

RNN与CNN的本质区别:CNN没有记忆功能,它的输出仅依赖于输入和网络的权重值,但 RNN有记忆功能,他的输出不仅依赖于当前的输入,还依赖当前的记忆。

CNN的输入是单一的图片等单一性质的数据,而RNN的输入是一个序列,一个随时间变化的序列

(1)G+RCU(Engelam et al)(2018)(可分割)

(2)RSNet(Huang et al)(2018)(可分割)(被引153)

(3)3P-RNN(Ye et al )(2018)(可分割)(被引72)

本文的3P(Pointwise Pyramid Pooling)

也是先通过MLP来提取点云的特征,然后设置一个金字塔模型,对不同大小的区域的点云分别提取局部信息(大局部,小局部,等)和全局信息,然后获得每个点的全部信息,(此时每个点的特征为特征向量,)

再将特征向量放入双向的RNN中,进行学习,然后通过全连接层来完成分割任务

(4)DARNet(Zhao et al )(2019)(可分割)(被引2)

(5)PointRNN(Fan et al)(2018)(被引7)

一个用来处理动态点云的深度学习网络。主要贡献:本提出了PointRNN和其两个变体,PointGRU、PointLSTM 都可以应用于移动点云的预测(结合给定点的历史运动轨迹来预测点云的未来轨迹)动态点云学习

注:传统的RNN是以一维向量作为输入的,RNN的一些变体如Cubic

ConvLSTM可以用来对二维视频进行深度学习,本文PointRNN是进一步的变体,可以对三维点云视频(动态三维点云)进行深度学习

- 基于晶格的方法(Lattice)

(1)LatticeNet(Rosu et al.)(2019)(可分割)(被引12)

该网络可以在 (2)中晶格的基础上可以实现大点云的有效处理

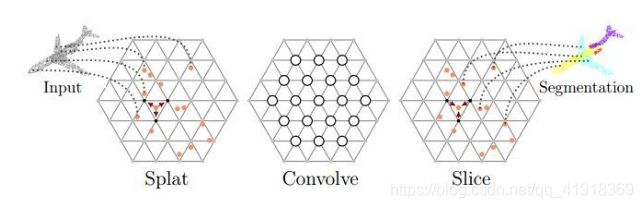

(2)SPLATNet(Su et al.)(2018)(被引272)

本篇文章方法小众,且文章难度

且同时pointNet、pointcnn处理起来复杂了一些,但相比于基于树的点云处理网络相比,(树的网络如OCNN都是讲点云进行高效的组织化,然后再套用成熟的神经网络进行处理,一般不是end-to-end网络)但是本篇文章的方法把对点云的组织者一步骤放到了每一次卷积操作中,实现了end-to-end。

注;本文应用的bilateral convolution lays(BCLs)和permutohedra lattice 并非作者首创,

文章中BCL平滑地将输入点映射到稀疏的格子上,在稀疏的点阵上执行卷积,然后将过滤后的信号平滑地插入到原始的输入点上。主要分为: Splat、Convolve、Slice:

1.Splat: BCL首先将输入特征结合到晶格

2.Convolve: BCL在这些点阵上进行卷积操作,(就像标准CNN一样)

3.Slice:经过卷积后的信号插值(barycentric interpolation)投影回输入信号。

注:该网络可以灵活地联合处理处理多视图图像和点云。

- 有待阅读后进行进一步分类

(1)ShapeContexNet(Xie et al.)(2018)

(2)PVNet(You et al.)(2018)(被引51)

(3)Point2Sequence(Liu et al )(2018)(被引52)

(4)PVRNet(You et al )(2018)(被引12)

(5)3DPointCapsNet(Zhao et al)(2018)

(6)RCNet(Wu et al.)(2019)(被引2)

(7)PointDAN(Qi et al)(2019)(被引6)

(8)3D FCN(Li et al.)(2017)

(9)Vote3Deep(Li et al.)(2017)

(10)VoxelNet(Zhou et al.)(2018)

(11)SECOND(Yan et al.)(2018)

(12)3DBN(Li et al)(2019)

(13)3DSSD(Yang et al.)(2020)

single shot methods(14)LaserNet(Meyer et al)(2019)

(15)3D iou loss(Zhou et al)(2019)

(16)Part-A^2(Shi et al.)(2019)

(17)Fast Point RCNN(Chen et al.)(2019)

(18)VoteNet(QI et al.)(2019)(被引97)

(19)LaserNet++(Mayer et al .)(2019)

(20)PV-RCNN(Shi et al )(2019)(被引20)

(21)OHS(Chen et al.)(2019)

(22)ImVoteNet(Qi et al.)(2020)(被引10)

(23)SA-SSD(He et al.)(2020)

1.2基于体素的方法

SECOND,PointPillar,Part-A^2

1.3基于mesh的方法

点云的表示方法虽然简单并且可以由商业的传感器直接扫描获得,但是在表示高质量的三维模型和部分尖锐形状特征的时候,点云的表示往往并不能精准的进行描述。

同时现实中的三维物体的表述,更像是由连续的表面组成,mesh的表示和现实中看到的物体更加精确,同时和体素相比,这种数据格式只需要用一些点,线,面来表示三维物体,存储空间大大的降低。mesh在对大片的面积描述时,可以使用少量的大多边形,另一方面,在对小和精细的地方进行描述时,可以使用大量的小多变形来描述

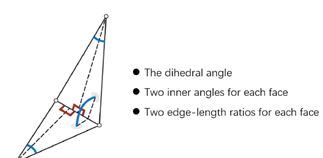

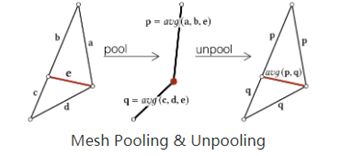

(1)meshCNN(2019)(被引78)

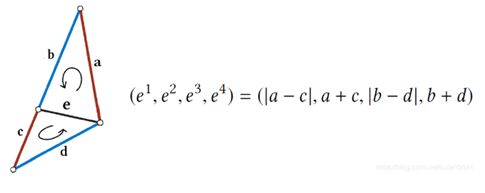

本文是第一篇直接对mesh格式的三维模型进行深度学习的文章,该文章提出了meshCNN网络,该网络以边为中心,进行特殊的卷积和特殊的池化操作。本文同样提出了一种方法,保证了mesh数据具有了变换不变性。设计了对边的表述特征向量(五维:两面角,两个三角形的内角、两个三角形的高边底边的比值)。本文设计了一种特殊的池化层。

特征向量:

变换不变性:(通过如下式子保持变换不变性)

本文设计了特殊的卷积池化:

该网络的池化是由边的折叠过程完成的。本文池化过程中使用的一种特殊的边缘折叠技术,(原本的边缘折叠是在1997年Hoppe提出的),删除的边是该边对整体物体特征贡献最小的边。

作者说:在实践中,通过不断折叠边的简化网络,尽管同一类物体的初始细化不同,但是最终都能收敛到类似的表达。

二、多模态融合的方法

(1)3DMV(Dai and NieBner)(2018)(被引90)

(2)UPB(Chiang et al.)(2018)

(3)MVPNet(Jaritz et al.)(2019)(被引11)

Frustum-based Mthods

(1)F-PointNets(QI et al )(2018)(被引656)

(2)PointFusion(XU et al.)(2018)(被引167)

(3)RoarNet(Shin et al.)(2018)(被引50)

(4)SIFRNet(Zhao et al.)(2019)(被引8)

(5)F-ConvNet(Wang et al.)(2019)

(6)Patch Refinement(Zhao et al )(2019)(被引9)

2.1紧耦合

- voxel-based

(1)CD-CVF( Yoo et al 韩国)(2020)

将雷达的点云体素化后 ,通卷积层进行预处理,生成在BEV下的特征地图,然后对多视角(构成闭合环形)的image进行FPN(CNN的一种网络)进行预处理,生成特征地图,然后用auto-calibrated

feature projection将多幅图进行融合,生成BEV下的feature,再利用adaptive gated fusion

network来融合雷达和image预处理后的BEV图,再进行正常的RPN。

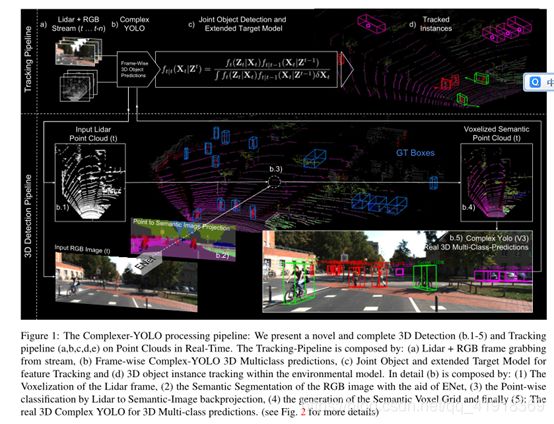

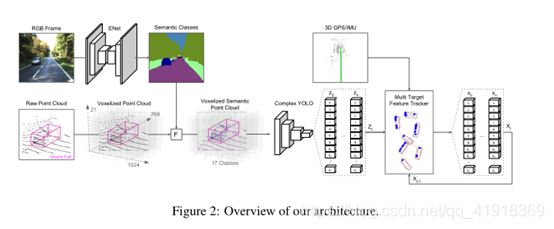

(2) Complexer-YOLO: Real-Time 3D Object Detection and Tracking on Semantic Point Clouds(semon et al)(2019)(被引32)

注:本篇文章的最初始的输入还是点云,但是有对点云进行表面化体素的一个过程。然后进行学习等一系列过程

开源代码位置:https://github.com/maudzung/Complex-YOLOv4-Pytorch

本文贡献: 1. 本文发明了一种可以实时的实现语义分割和object detection任务的网络。具有很强的实时处理能力

2. 视觉:通过相机的快速语义分割,生成的视觉逐点特征。

3. 本文应用了SRT(Scale-Rotation-Translation score):检测出物体的3DoF姿态(偏航角,高度,宽度),同时本文能够实时预测出来物体的走向。(注意此处文章好像结合了GPS/IMU)

网络框架:

(1) 输入lidar点云和RGB信息。

(2) 使用ENet对RGB信息进行实时的语义分割。

(3) 将实时的分割结果结合相机的内外参反向投影到lidar生成的点云图中

(4) 对结合语义信息的点云图进行合适的体素化,

(5) 通过Complex-Yolo,对体素信息进行实时的dectection,并生成相应的proposal和label

(6) 联合多目标模型和物体的检测结果,完成对多目标跟踪的任务(完成对目标box,目标的朝向,和下一时刻的运动方向。

注:(1)本文中的体素化并不是将所有空间都进行一个体素化,只是将有Point的地方进行一定的体素化,其中每个体素的3D空间中至少存在一个点,且对前置摄像头可见,同时每个体素都填充有从范围【1-2】中的语义图提取的归一化类值。Voxel map 。

方便我们将从二维中分割得到的语义信息,反向投影到voxel map中。

(2)本文用的就是一种基于体素化的Complex-YOLO,

- point-based

(1) PI-RCNN(Xie et al)(2019)

point分支和image分支分别做3D目标检测任务和语义分割任务,然后对每个点搜寻K临近点,对这些点结合相机的内外参反向投入二维的语义地图中,得出这几个点对应二维中的像素的语义特征,然后将这几个点的几何特征和语义特征进行联合积分,得到联合特征;最后将几何特征,语义特征,联合特征进行拼接,更新该点的特征,从而完成二次优化的任务,实现点云数据和RGB数据的融合。

(2)PointPainting(cvpr2020)(被引11)

该篇文章的重点是怎么快速把二维语义分割的信息画到点云数据上,使得点云信息也获得得语义的信息。

该工作的fusion方式是采用二维语义分割信息通过lidar信息和image信息的变换矩阵融合到点上,再采用baseline物体检测;可以理解为对于语义分割出的物体多了一些信息作为引导,得到更好的检测精度。和上面的pi-rcnn的不同之处是该融合是一个串联的网络结构,将语义分割后的特征和原始点云一起送入深度学习网络中.

2.2松耦合

(1)CLOCs

该网络经历了三个主要的阶段(1)2D和3D的目标检测器分别提出proposals(2)将两种模态的proposals编码成稀疏张量(3)对于非空的元素采用二维卷积做对应的特征融合。

三、语义SLAM的方式(应该都属于多模态融合的方法)

但是有个疑问???

该方法中的三维模型都是RGB-D通过SLAM的方法建立来得,同时该方法也用了很多RGB的信息进行深度学习。(该方法的多数只用了一种传感器,并不想二中的多模态融合中,用了雷达的信息来捕获三维空间模型)

所以该方向应该属于???同时该方向存在一个问题:引用量整体偏少,

(1)Deep Learning Based Semantic Labelling of 3D Point Cloud in Visual SLAM[C]//IOP Conference Series(IOP-2018)(被引:3)

特点: ORB-SLAM2+YOLO3

(2) Meaningful maps with object-oriented semantic mapping(IROS-2017)(被引95)

特点: ORB-SLAM2+SSD

(3)DynaSLAM: Tracking, mapping, and inpainting in dynamic scenes(IEEE Robotics and Automation Letters-2018)(被引115)

特点: (1)ORB-SLAM2+Mask R-CNN(2)在understanding方向:mask R-CNN和多视几何结合的方法。

本文贡献:在ORB-SLAM的基础上增加了动态对象检测和背景修复的功能。

本文解决方案:注:实线是通过单目或者双目完成该工作的流程

虚线是通过RGB-D来完成该工作的流程 在RGB-D的过程中 不仅使用了maskR-CNN来进行最开始的对常动物体的检测(如人),同时还通过联合多视几何的方法,来优化分割结果,当从静态的物体中进行了相机的定位操作之后,我们便能通过历史的信息来对动态物体遮挡的部分进行重建。

该方案中:(1)利用深度学习的算法,把经常进行移动的物体进行检测(如人,车,动物等)

(2)利用多视几何的方法对原本属于静态的物体,但是在该场景中跟随动态物体来进行移动的物体进行检测。

(4) DA-RNN: Semantic mapping with data associated recurrent neural networks(arXiv-2017)(被引55)

特点: RNN+CNN 语义分割

(5)Ds-slam: A semantic visual slam towards dynamic environments(IROS-2018)(被引83)

特点:SegNet+ORB SLAM2

(6)Maskfusion: Real-time recognition, tracking and reconstruction of multiple moving objects(ISMAR-2018)(被引:83)

特点:MaskFusion + ElasticFusion

(7)Semantc SLAM

(8)Probabilistic data association for semantic slam(IEEE-2017)(被引:199)

(9)Semantic SLAM based on object detection and improved octomap(2018)(IEEE)(被引:25)

(10)A computationally efficient semantic slam solution for dynamic scenes(2019)(被引:10)

(11)SOF-SLAM: A semantic visual SLAM for dynamic environments(2019-IEEE)(被引8)

(12)Hierarchical topic model based object association for semantic SLAM(2019)(被引14)

(13)SLAM++(2013)(被引616)