深度学习(P1机器学习基础 ) 笔记和知识点补充

文章目录

- 第5章 机器学习基础

-

- 5.1 学习算法

- 5.5 最大似然估计

-

- 5.5.1 条件对数似然和均方误差

- 5.5.2 最大似然的性质

- 5.6 贝叶斯统计

- 5.7 监督学习算法

-

- 5.7.2 支持向量机

- 5.7.3 其他简单的监督学习算法

- 5.8 无监督学习算法

- 5.8.1 主成分分析

- 5.11 促使深度学习发展的挑战

-

- 5.11.1 维数灾难

- 5.11.3 流形学习

有的知识点暂时跳过或者没有深究,后续会更新补上的。

第5章 机器学习基础

5.1 学习算法

机器学习任务

-

转录:机器学习系统观测一些相对非结构化表示的数据,并转录信息为离散的文本形式。这里非结构数据最常见的就是语音和图像,我最近在做的验证码识别就是后者,而语音识别就是前者。

-

去噪:在这类任务中,常见的处理方法是预测条件概率分布。

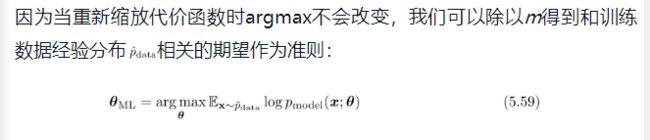

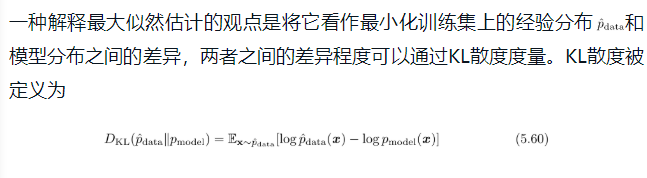

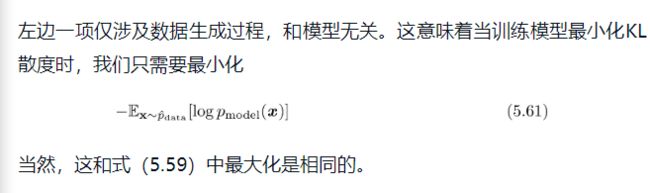

5.5 最大似然估计

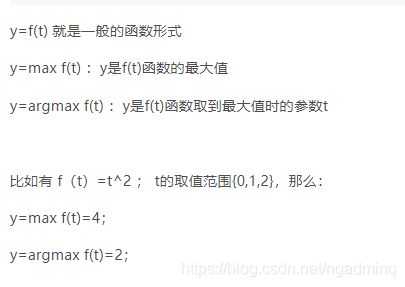

补充:argmax与max区别

作用

解释1:我们可以将最大似然看作使模型分布尽可能地和经验分布[插图]相匹配的尝试。理想情况下,我们希望匹配真实的数据生成分布pdata,但我们无法直接知道这个分布。

解释2:以让我们从不同模型中得到特定函数作为好的估计,而不是猜测某些函数可能是好的估计,然后分析其偏差和方差。

解释3:简而言之,就是利用已知的样本结果信息,反推最具有可能(最大概率)导致这些样本结果出现的模型参数值!换句话说,极大似然估计提供了一种给定观察数据来评估模型参数的方法,即:“模型已定,参数未知”。more

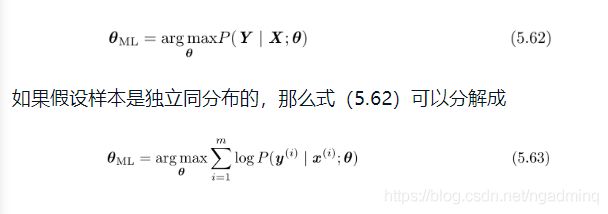

极大似然估计一种算法:最优theta

最大似然估计就是观察其结果,利用试验结果得到某个参数值能够使样本出现的概率为最大,则称为极大似然估计。将这句话转换为数学公式就得到以下结果了。这里的theta和x都是一族,所以下一个等式就是将X拆成多个数相乘。

常见的,将乘变成对数和

5.5.1 条件对数似然和均方误差

监督学习中常常将最大似然估计拓展到条件概率,从而给定x预测y.

例子:线性回归

在机器学习中所学的线性回归目标是输入一串X,学习得出一个y。

现在希望模型能够得到条件概率p(y|x),而不只是得到一个单独的预测y。

上升到数学思维,这种做法就是将预测目标由MSE变为了条件概率

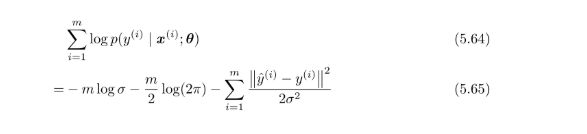

现在将p(y|x)的模型假设成一个高斯模型(这个模型其实可以是任意,但为了得到相同的线性回归算法做了这个假设)。对其极大似然估计且化解后。

5.5.2 最大似然的性质

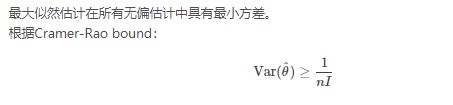

最大似然估计最吸引人的地方在于,它被证明当样本数目m→∞时,就收敛率而言是最好的渐近估计。

一致性:样本数目趋向于无穷大时,参数的最大似然估计会收敛到参数的真实值。

统计效率:

5.6 贝叶斯统计

频率派和贝叶斯派探讨不确定的区别

频率学派认为世界是确定的,有一个本体,这个本体的真值是不变的,我们的目标就是要找到这个真值或真值所在的范围;频率派是直接从事件本身建模。

贝叶斯学派认为世界是不确定的,人们对世界先有一个预判,而后通过观测数据对这个预判做调整,我们的目标是要找到最优的描述这个世界的概率分布。贝叶斯派是从观察者知识不完备推导。

more

与最大似然的区别

查阅了一下资料,这里简单的说就是:

似然,即 p(x|θ) ,是假设 θ已知后我们观察到的数据应该是什么样子的;

贝叶斯·,即 p(θ|x) , 是最终的参数分布。

在使用上的区别

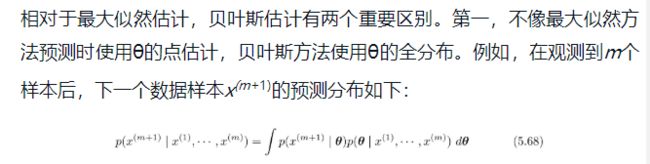

这里,每个具有正概率密度的θ的值有助于下一个样本的预测,其中贡献由后验密度本身加权。在观测到数据集{x(1), ···,x(m)}之后,如果我们仍然非常不确定θ的值,那么这个不确定性会直接包含在我们所做的任何预测中。

贝叶斯方法和最大似然方法的第二个最大区别是由贝叶斯先验分布造成的。先验能够影响概率质量密度朝参数空间中偏好先验的区域偏移。实践中,先验通常表现为偏好更简单或更光滑的模型。对贝叶斯方法的批判认为,先验是人为主观判断影响预测的来源。

适用情况

当训练数据很有限时,贝叶斯方法通常泛化得更好,但是当训练样本数目很大时,通常会有很大的计算代价。

5.7 监督学习算法

什么是监督学习算法

有训练目标。这里的训练目标可以是已经给定的,也可以是自动收集的。

逻辑回归

将线性回归扩展到分类中。比如是在二分类,就要求每次预测两者的概率之和为1。

拓展方法就是通过sigmoid将函数压缩在0-1区间

5.7.2 支持向量机

与逻辑回归区别

与逻辑回归不同,它不输出概率只输出类别。

svm创新点

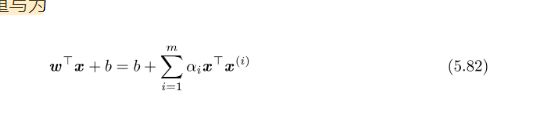

在svm中创新是将线性函数重写为样本间的点积形式。

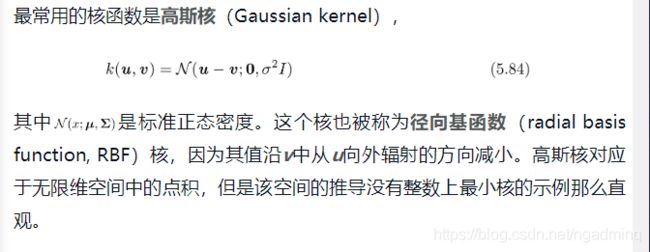

而点积又常常替换为核函数

核技巧十分强大有两个原因:其一,它使我们能够使用保证有效收敛的凸优化技术来学习非线性模型(关于x的函数)。这是可能的,因为我们可以认为φ是固定的,仅优化α,即优化算法可以将决策函数视为不同空间中的线性函数。其二,核函数k的实现方法通常比直接构建φ(x)再算点积高效很多。

常见的核函数

5.7.3 其他简单的监督学习算法

KNN局限

在此设定中,当训练样本数目趋向于无穷大时,1-最近邻收敛到两倍贝叶斯误差。超出贝叶斯误差的原因是它会随机从等距离的临近点中随机挑一个。如果我们使用所有这些临近点投票的决策方式,而不是随机挑选一个,那么该过程将会收敛到贝叶斯错误率。

k-最近邻的一个弱点是它不能学习出哪一个特征比其他更具识别力。例如,假设我们要处理一个回归任务,其中[插图]是从各向同性的高斯分布中抽取的,但是只有一个变量x1和结果相关。进一步假设该特征直接决定了输出,即在所有情况中y=x1。最近邻回归不能检测到这个简单模式。大多数点x的最近邻将取决于x2到x100的大多数特征,而不是单独取决于特征x1。因此,小训练集上的输出将会非常随机。

什么是贝叶斯误差

上面提到了贝叶斯误差,more

从例子可以看到贝叶斯误差是在已知道真实分布情况下,知道真实分布还做什么机器学习呀。因此业界并不会真正将该指标作为评价指标,这个指标只用于学术探讨中;

适用情况

最近邻预测和决策树都有很多的局限性。尽管如此,在计算资源受限制时,它们都是很有用的学习算法。

5.8 无监督学习算法

3种表示数据的方法

低维表示:压缩数据

稀疏表示:将数据无损的表示出来。通常用于需要增加表示维数的情况,使得大部分为零的表示不会丢失很多信息。这会使得表示的整体结构倾向于将数据分布在表示空间的坐标轴上。

独立表示:分开数据分布中变化的来源,使得表示的维度是统计独立的

5.8.1 主成分分析

用处

压缩数据

学习数据表示的无监督算法

数据噪音消除

5.11 促使深度学习发展的挑战

机器学习在很多不同的简单的数据集上效果都很好,但一旦数据集复杂了就很难学习到样本特征。

5.11.1 维数灾难

维度的增加在机器学习中可以认为就是特征数的增加,以线性回归为例就是增加了特征数。

深度学习为了区分样本时,喜欢将样本映射到高维空间上,值得肯定的是维度越高,训练样本的分类结果越好。但这样做的缺点就是会导致过拟合。导致过拟合的现象就叫做维度灾难。

维度灾难需要更多的数据,正如过拟合需要更多的数据一样。

5.11.3 流形学习

什么是流形

指连接在一起的区域。数学上,它是指一组点,且每个点都有其邻域。给定一个任意的点,其流形局部看起来像是欧几里得空间。