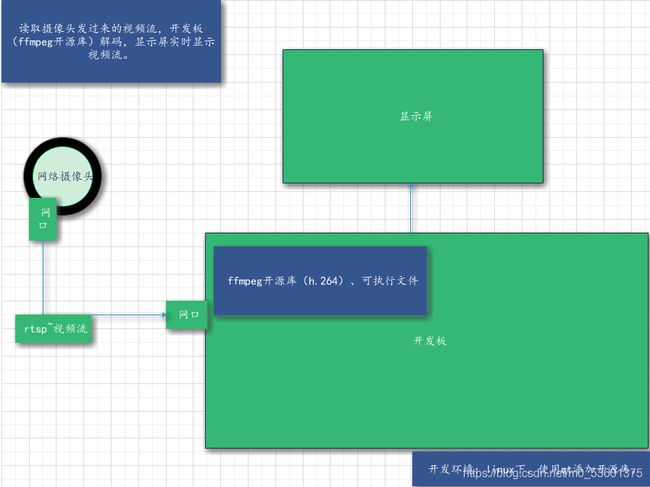

FFmpeg+Qt实现摄像头(rtsp)实时显示视频

由于项目需要实时显示摄像头的图像,就学习了FFmpeg的相关知识。

执行run()函数

打开tcp或udp地址

能否读取流

查找解码器

打开解码器

将解码后数据转换成RGB32

在Qwidget中显示

释放内存

结束程序

网络摄像机rtsp地址详解。

流程框架

程序源代码

/*.CPP*/

/****************************************

* File name:Camera_page

* 爱捣蛋的小仙儿。

*****************************************/

#include "Camera_page.h"

#include /*.h*/

/****************************************

* File name:Camera_page.h

* 爱捣蛋的小仙儿。

*****************************************/

#ifndef VIDEOPLAYER_H

#define VIDEOPLAYER_H

#include