【20210423期AI简报】RT-Thread AI 套件开源、X86架构大师“游向”RISC-V

导读:本期为 AI 简报 20210423 期,将为您带来 8 条相关新闻,今日世界读书日~但使书种多,会有岁稔时~

RT-Thread AI Kit已经开源,RT-Thread 又一开源力作~

本文一共 2300 字,通篇阅读结束需要 5~8 分钟

1. RT-Thread AI Kit开源:轻松实现一键部署AI模型至 RT-Thread

开源链接:

https://github.com/RT-Thread/RT-AK

RT-AK 是 RT-Thread 团队为 RT-Thread 实时操作系统所开发的 AI 套件,能够一键将 AI 模型部署到 RT-Thread 项目中,让用户可以 在统一的 API 之上进行业务代码开发,又能在目标平台上获得极致优化的性能,从而更简单方便地开发端侧 AI 应用程序。

在 RT-AK 支持下,仅需要一行命令,python aitools.py --model xxx...,即可将 AI 模型部署到 RT-Thread 系统中:

详细的命令请查阅本文相关内容,

目前已有的两个 Demo:

Mnist Demo:

https://github.com/EdgeAIWithRTT/Project3-Mnist_Cube_RTT

(2020 开发者大会)人形检测 Demo:

https://github.com/QiwenLi0729/RT-AK_demo_art-pi_aicam

2. 把《我的世界》马赛克变成逼真大片!这项AI研究令人想入非非???? | AI科技评论

论文链接:

https://arxiv.org/abs/2104.07659

项目主页:

https://nvlabs.github.io/GANcraft/

《我的世界》真是太好玩了!

能不能把《我的世界》中的像素块场景世界转换成真实世界的逼真图案呢?

能!

这就是来自NVIDIA和康奈尔大学的新研究GANcraft,最近刚在GTC 2021主题演讲中进行过展示。

GANcraft是一个无监督3D神经渲染框架,它可以将游戏《我的世界/Minecraft》方块世界转换为与视图一致的逼真的世界!

该方法通过使用GAN预训练网络生成“伪ground truths”,可以学习在没有成对的《我的世界》真实数据的情况下执行此转换。

转换之后的海岛细节清晰可见:

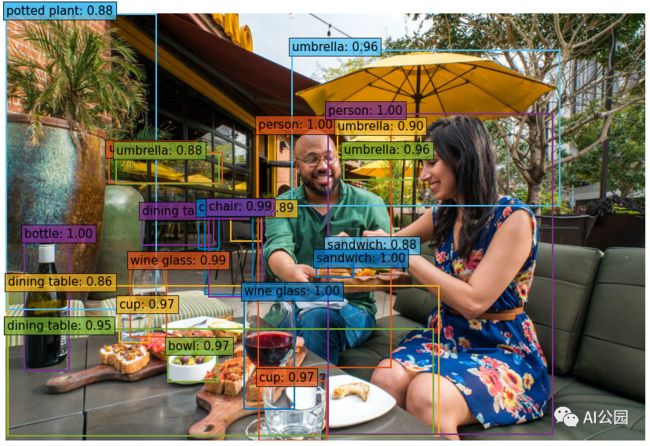

3. 使用Transformer来做物体检测 | 完整版指南 | AI 公园

Github:

https://github.com/facebookresearch/detr

英文原文:

https://medium.com/swlh/object-detection-with-transformers-437217a3d62e

这是一个Facebook的目标检测Transformer (DETR)的完整指南。

DEtection TRansformer (DETR)是Facebook研究团队巧妙地利用了Transformer 架构开发的一个目标检测模型。在这篇文章中,我将通过分析DETR架构的内部工作方式来帮助提供一些关于它的直觉。

本文主要分为以下几个方面:

架构

CNN主干

The Transformer

目标查询

使用PyTorch实现简单的DETR

二分匹配损失 (Optional)

为目标检测使用DETR

4. 突破置换模块计算瓶颈,MSRA开源轻量版HRNet,超越主流轻量化网络!|CVPR2021 | 极市平台

Image

Image

paper:

https://arxiv.org/abs/2104.06403

code:

https://github.com/HRNet/Lite-HRNet

本文提出一种针对人体姿态估计的高效高分辨率网络:Lite-HRNet。

我们通过简单的将ShuffleNet中的高效置换模块嵌入到HRNet即可比主流轻量化网络(比如MobileNet、ShuffleNet、Small HRNet)更强的性能。

我们发现:置换模块中重度使用的1x1卷积是其计算瓶颈。

我们引入一种轻量化单元(条件通道加权)替换置换模块中计算代价昂贵的1x1卷积。

所提通道加权的复杂度与通道数成线性关系,低于1x1卷积的二次时间复杂度关系(比如,在64x64x40与32x32x80多分辨率特征方面,所提单元可以减少置换模块总体计算量的80%)。该方案从多个并行分支的所有通道、所有分辨率学习加权值,采用该权值进行通道、分辨率之间的信息交换,补偿1x1卷积所扮演的角色。

实验表明:在人体姿态估计应用方面,相比主流轻量化网络,所提Lite-HR具有更强的性能;更重要的是,所提Lite-HRNet可以以相同方式轻易嵌入到语义分割任务中。

5. YOLO在升级 | PP-YOLO v2开源致敬YOLOV4携带Tricks又准又快地归来(附论文与源码) | AI人工智能初学者

Image

Image

Paper:

https://arxiv.org/pdf/2104.10419

Gihub:

https://github.com/PaddlePaddle/PaddleDetection

为了解决效率和性能这两个问题,本文全面评估了一系列现有改进,以提高PP-YOLO的性能,同时几乎保持推理时间不变。

本文将分析一系列改进,并通过增量消融研究从经验上评估它们对最终模型性能的影响。

通过结合多项有效的改进,在COCO2017上将PP-YOLO的性能从45.9%mAP提升到49.5%mAP。称之为PP-YOLOv2。

在速度方面,PP-YOLOv2在640x640输入尺寸下以68.9FPS的速度运行。

具有TensorRT,FP16精度和Batch=1的Paddle推理引擎进一步提高了PP-YOLOv2的推理速度,达到了106.5 FPS。这样的性能超过了具有大致相同数量的参数(即YOLOv4-CSP,YOLOv5l)的现有目标检测器。此外,带有ResNet101的PP-YOLOv2在COCO2017测试开发上达到了50.3%的mAP。

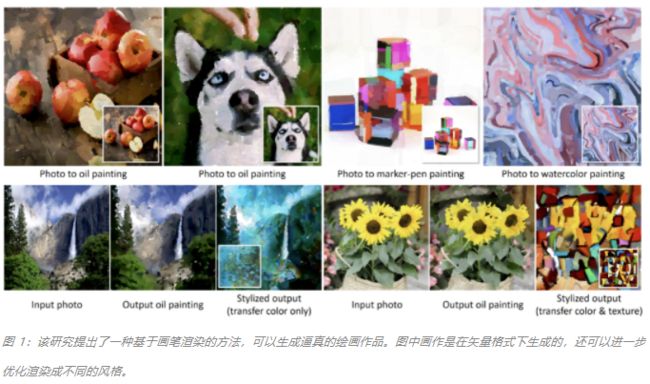

6. 有了这支矢量神经风格画笔,无需GAN也可生成精美绘画 | 机器之心

image-20210423150111834

image-20210423150111834

论文地址:

https://arxiv.org/abs/2011.08114

Github 地址:

https://github.com/jiupinjia/stylized-neural-painting

在 CVPR 2021 的一篇论文中,来自网易伏羲和密歇根大学的研究者提出了一种图像到绘画的转换方法,可以生成生动逼真且风格可控的画作。

目前该方法的实现代码已开源。

不同于此前风格迁移方法在逐像素预测框架下生成绘画,该方法在矢量空间下生成具有物理意义的序列画笔参数,且该参数可以进一步用于渲染。

于画笔本身是不可微的,该研究设计了一种新的神经渲染器,以模拟画笔的行为,并将画笔预测问题转化成参数空间内的搜索问题,从而最大化渲染输出和输入图像之间的相似度。

该研究揭示了搜索过程中的零梯度问题并提出从最优搬运的角度解决这一问题。

此外,该研究还揭示了此前神经渲染器存在参数耦合的问题,并重新设计了渲染网络。

另外,该方法还可以在神经风格迁移框架下联合优化以进一步迁移其他画作的视觉效果。

7. 我用24小时、8块GPU、400美元在云上完成训练BERT!特拉维夫大学新研究 | 量子位

Paper:

https://arxiv.org/abs/2104.07705

Github: (假的,还没有开源)

https://github.com/peteriz/academic-budget-bert

大型语言模型BERT,熟悉NLP领域的同学没人不知道它的名气吧?

只可惜它太太太贵了!

之前有做过统计,使用谷歌云TPU或英伟达GPU训练完整个模型需要虽然只需1个小时,但是上千块TPU/GPU均需耗价上万美元。

只有少数“富贵人家”的行业实验室才能够负担得起。

为了降低成本,来自以色列的科学家们结合已有的技术对BERT做了多方面优化,只需24小时、8个12GB内存的云GPU,一次几百美元就能在加快训练过程的同时,还能保证准确性几乎不损失。

终于,“普通家庭”也不怕“囊中羞涩”了。

24小时、8个云GPU(12GB内存)、$300-400

五点优化:将训练时间缩短了1/3

超参数调优:MLM损耗更低

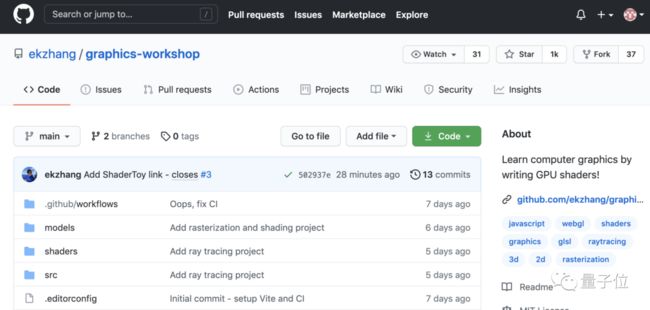

8. 华人小哥开发“CG工坊”,帮你快速入门计算机图形学 | GitHub热榜 | 量子位

CG新手们,你们的福音来了~

为了让初学者更好地学习计算机图形学基础知识,一位哈佛小哥创建了graphics-workshop,一周左右的时间,已经在GitHub上获得1K星。

其中包含5个子项目:被子块图案、过程纹理生成、栅格化和着色、风格化渲染,以及光线追踪。

用户需要用npm进行安装,通过运行下面的代码,安装依赖项和启动开发服务器。

1$ npm install

2$ npm run dev

具体使用请看原文

其他

![]()

论文·CVPR 2021 | 自适应激活函数ACON: 统一ReLU和Swish的新范式

论文·动作识别最新高效利器 ACTION-Net:通用的多路径激活模块 | CVPR 2021

论文·位置蒸馏:针对目标检测提高定位精度的知识蒸馏

新闻·Docker现已加入苹果M1“豪华午餐”,程序员换新Mac的理由又多了一条

新闻·X86架构大师、处理器游侠-吉姆·凯勒“游向”RISC-V

新闻·270亿参数、刷榜CLUE,阿里达摩院发布最大中文预训练语言模型PLUG(开放测试)

你可以添加微信17775982065为好友,注明:公司+姓名,拉进 RT-Thread 官方微信交流群!

???????????? 点击阅读原文进入官网