【AI视野·今日CV 计算机视觉论文速览 第187期 part1】Fri, 18 Dec 2020

AI视野·今日CS.CV 计算机视觉论文速览 part1

Fri, 18 Dec 2020

Totally 73 papers

上期速览✈更多精彩请移步主页

Interesting:

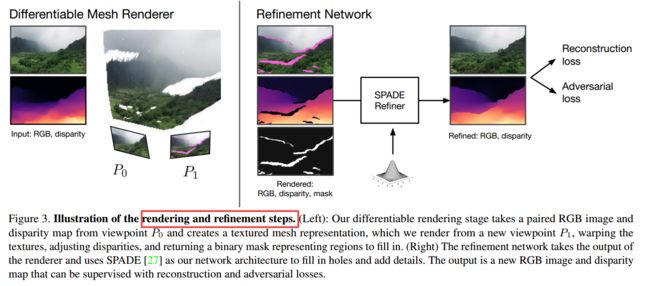

***Worldsheet: Wrapping the World in a 3D Sheetfor View Synthesis from a Single Image, 单张RGB输入,首先获取深度图,而后得到带纹理和深度处理的网格,实现新视角下图像的合成。(from facebook CMU)

code:https://worldsheet.github.io/

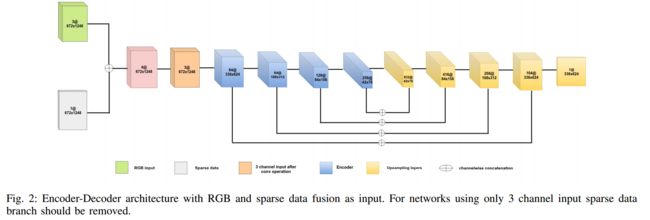

****基于RGB和稀疏点云的多模态深度估计, (from TU Kaiserslautern)

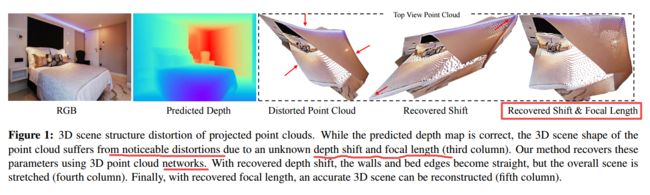

***** Learning to Recover 3D Scene Shape from a Single Image, 精确的、带尺度的三维重建过程。通过三维点云编码器来预测深度偏移和焦距,可从深度图恢复出正确的三维点云。(from 阿德莱德大学 adobe)

code:https://git.io/Depth

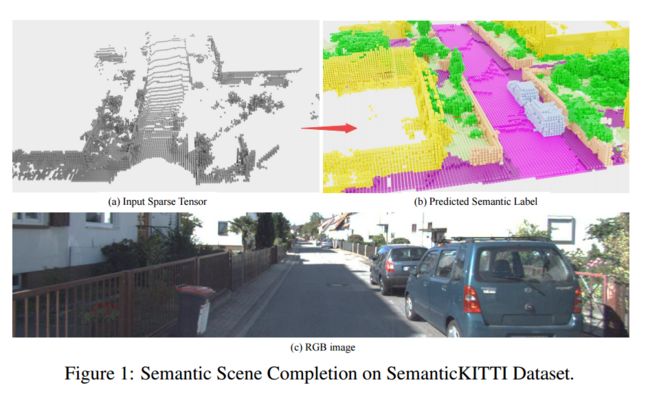

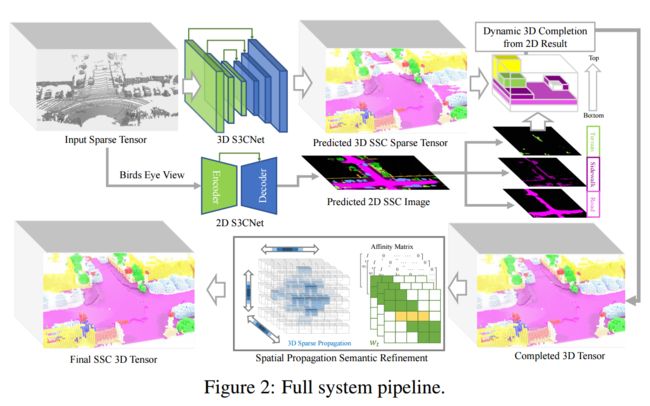

**S3CNet, 激光点云语义补全网络。(from 华为 多伦多大学)

ask:点云可视化方法

from:Conference on Robot Learning

**:books:[Zoom-to-Inpaint](https://arxiv.org/pdf/2012.09401.pdf), 通过超分辨方法来补全优化,而后又下采样得到原尺寸的输出图。(from KAIST Google Research )

****Infinite Nature基于单张图像生成多张自然图像, (from Google Research)

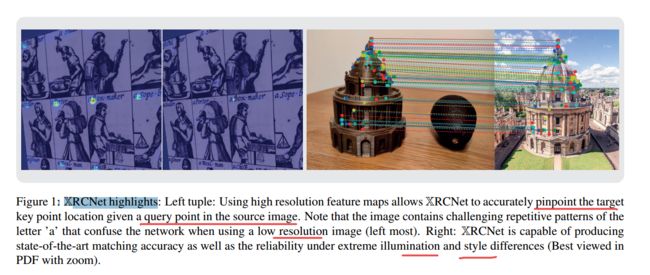

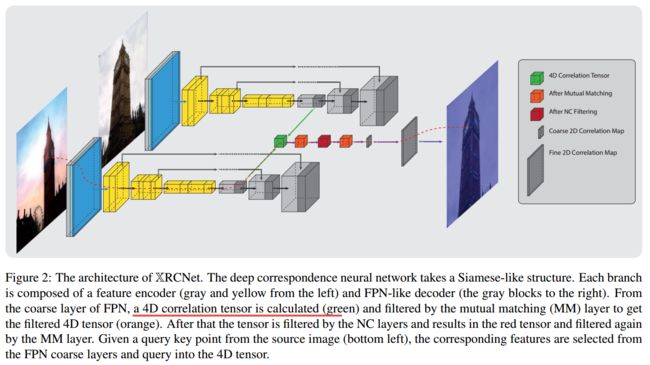

XResolution Correspondence Networks, 为完全不同(分辨率、光照、材质等)的两张图像建立起相关关系,找到图中对应点。(from Oxford robotics xyzreality)

code:https://xyz-r-d.github.io/xrcnet

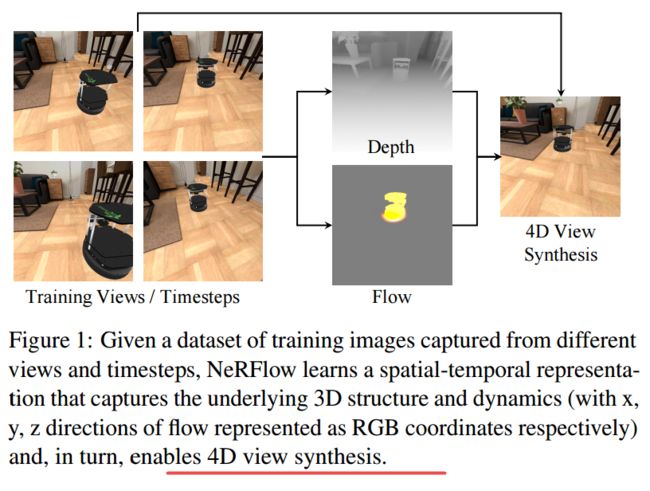

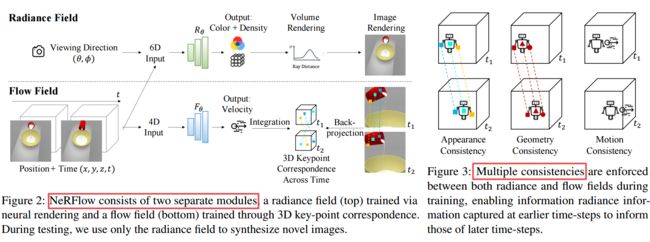

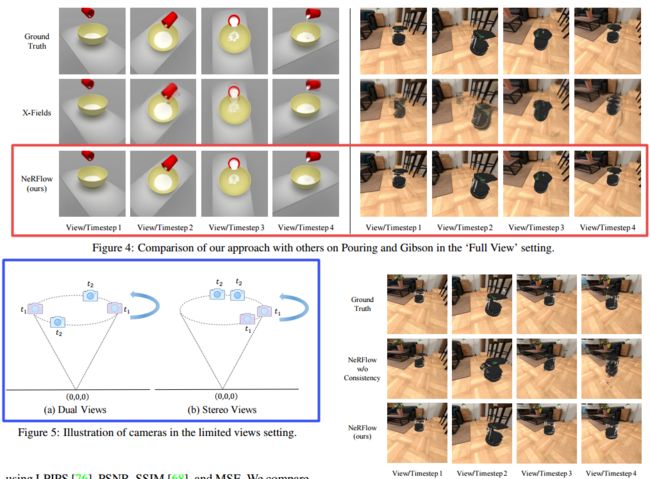

NeRFlow), 基于RGB序列的动态场景4D空时表示的场景合成方法。(from MIT Stanford)

code: yilundu.github.io/nerflow

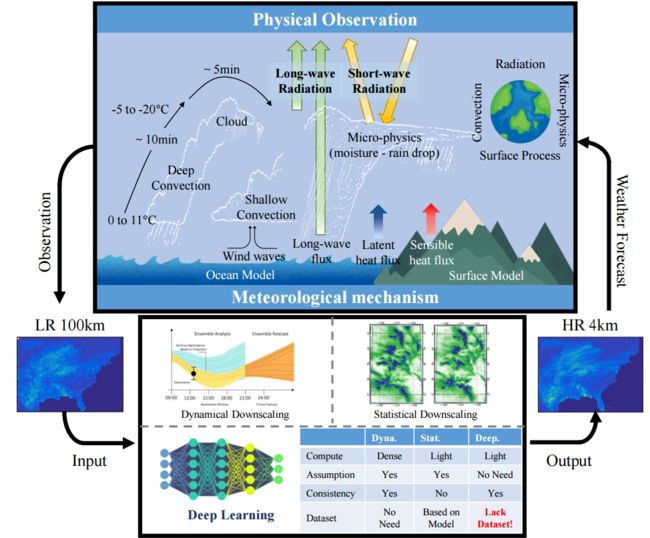

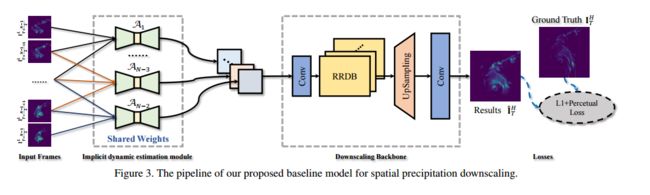

RainNet, 大规模的空间降水降尺度数据集,包含了62,424 对高低分辨的降水图,以及Temporal Misalignment, Temporal Sparse and Fluid Properties等特性。(from Shanghai Jiao Tong University, Princeton University, University of Technology Sydney)

https://neuralchen.github.io/RainNet/

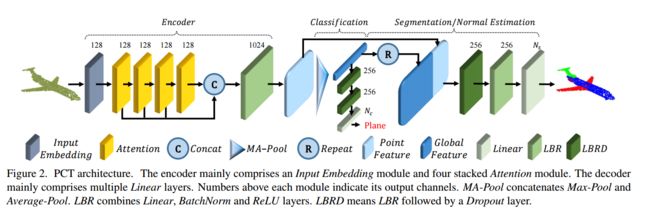

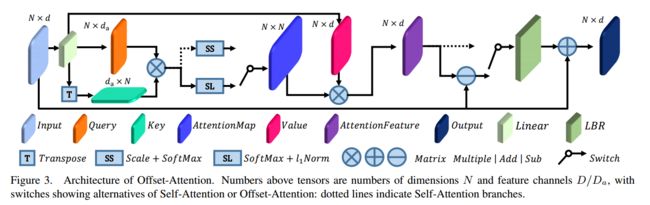

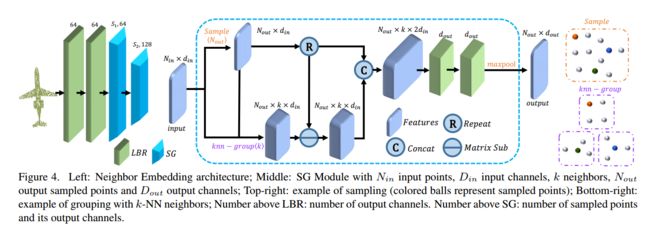

PCT: Point Cloud Transformer, 基于transformer的点云学习方法。(from 清华 卡迪夫大学)

ASK:绘图方法~

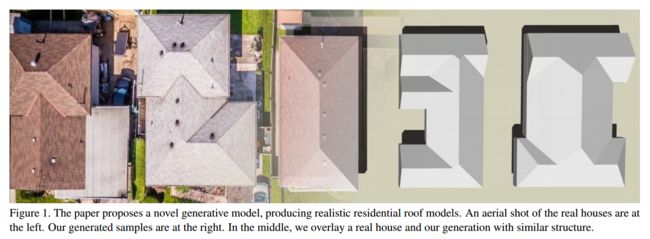

Roof-GAN:, 基于航空图像重建屋顶形状。(from Simon Fraser University西蒙弗雷泽大学)

Daily Computer Vision Papers

| Reconstructing Hand-Object Interactions in the Wild Authors Zhe Cao, Ilija Radosavovic, Angjoo Kanazawa, Jitendra Malik 在这项工作中,我们探索了在野外重建手与物体的相互作用。此问题的核心挑战是缺少适当的3D标签数据。为了克服这个问题,我们提出了一种基于优化的过程,不需要直接的3D监督。我们采用的一般策略是在实验室MoCap中利用所有可用的相关数据2D边界框,2D手关键点,2D实例蒙版,3D对象模型,3D为3D重建提供约束。与其单独优化手和对象,不如对它们进行联合优化,这使我们可以基于手对象的接触,碰撞和遮挡施加其他约束。我们的方法可针对各种对象类别,针对EPIC Kitchens和100天之手数据集的野生数据中的挑战性产生令人信服的重构。从数量上讲,我们证明了我们的方法与实验室设置中可以使用地面真实3D注释的现有方法相比具有优势。 |

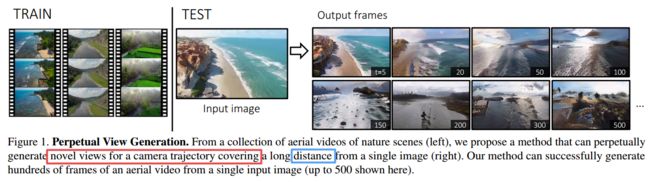

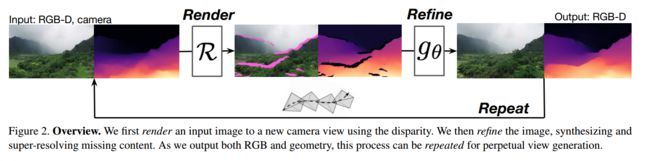

| Infinite Nature: Perpetual View Generation of Natural Scenes from a Single Image Authors Andrew Liu, Richard Tucker, Varun Jampani, Ameesh Makadia, Noah Snavely, Angjoo Kanazawa 我们介绍了永久视图生成问题,即与给定单个图像的任意较长的相机轨迹相对应的新颖视图的远距离生成。这是一个具有挑战性的问题,远远超出了当前视图合成方法的能力,该方法只能在有限的视点范围内工作,并且在出现较大的相机运动时会迅速退化。为视频生成而设计的方法还不能产生较长的视频序列,并且通常与场景几何无关。我们采用了一种混合方法,该方法在迭代渲染,优化和重复框架中集成了几何和图像合成功能,可以进行长距离生成,覆盖数百帧后的较大距离。我们的方法可以从一组单眼视频序列中进行训练,而无需任何人工注释。我们提出了一个自然沿海场景的航拍数据集,并将我们的方法与最近的视图合成和有条件的视频生成基准进行了比较,表明与现有方法相比,它可以在更长的时间范围内在大型摄像机轨迹上生成合理的场景。 |

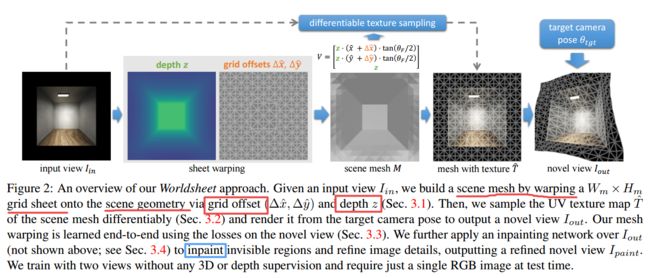

| Worldsheet: Wrapping the World in a 3D Sheet for View Synthesis from a Single Image Authors Ronghang Hu, Deepak Pathak 我们介绍了Worldsheet,一种仅使用单个RGB图像作为输入的新颖视图合成方法。这是一个具有挑战性的问题,因为它需要了解场景的3D几何形状以及纹理映射以从新的视点生成可见区域和遮挡区域。我们的主要见解是,只需将平面网格片收缩包装到输入图像上即可,与学习到的中间深度相一致,可以捕获足以生成具有真实大视点变化且照片级逼真的看不见视图的基本几何形状。为了实现这一点,我们提出了一种新颖的可微分纹理采样器,该采样器可以对包裹的网格板进行纹理处理,然后通过可微分渲染将其转换为目标图像。我们的方法与类别无关,无需任何3D监督即可进行端到端训练,并且在测试时仅需要一张图像。在多个数据集中的单幅图像视图合成方面,Worldsheet始终优于现有技术。此外,这种简单的想法在将野外图像转换为可导航的3D弹出窗口时,在各种高分辨率的野外图像中都能很好地捕获新颖的视图。视频结果和代码位于 |

| Human Mesh Recovery from Multiple Shots Authors Georgios Pavlakos, Jitendra Malik, Angjoo Kanazawa 来自电影等编辑媒体的视频是有用的,但仍在探索中。这些影片在较大的时间范围内描绘的人与人之间的外观和互动的丰富变化,可能是有价值的数据来源。但是,数据的丰富性是以根本性的挑战为代价的,这些挑战包括突然的镜头变化和严重被截断的演员的特写镜头,这限制了现有人类3D理解方法的适用性。在本文中,我们以洞察力解决了这些局限性,即尽管同一场景的镜头更改会导致帧之间的不连续,但场景的3D结构仍会平滑变化。这使我们能够在镜头切换之前和之后将帧作为多视图信号来处理,这些信号提供了强有力的线索来恢复演员的3D状态。我们提出了一个多镜头优化框架,该框架可改进3D重建并利用伪地面实况3D人网格对长序列进行挖掘。我们证明了所得的数据对于训练单个图像的各种人体网格恢复模型是有益的,我们为视频实现了更高的鲁棒性,我们提出了一种基于纯变压器的时间编码器,该编码器可以自然地处理由于输入帧中镜头变化而导致的缺失观测。我们通过广泛的实验证明了洞察力和提出的模型的重要性。我们开发的工具打开了处理和分析来自大型已编辑媒体库的3D内容的大门,这可能对许多下游应用程序有所帮助。项目页面 |

| $\mathbb{X}$Resolution Correspondence Networks Authors Georgi Tinchev, Shuda Li, Kai Han, David Mitchell, Rigas Kouskouridas 在本文中,我们旨在在具有挑战性的照明变化,视点变化和样式差异下,在具有重叠视场的一对图像之间建立精确的密集对应关系。通过对先进的通信网络进行广泛的消融研究,我们惊奇地发现,可以对广泛采用的4D相关张量及其相关的学习和处理模块进行参数化,并从训练中删除它们,而对最终匹配精度的影响很小。禁用一些最消耗内存和计算量最大的模块,可以极大地加快训练过程,并允许使用4倍大的批处理大小,从而弥补了精度下降的麻烦。结合多GPU推理阶段,我们的方法有助于系统地研究从720p到4K的原始测试图像的匹配精度与上采样分辨率之间的关系。这导致找到最佳分辨率mathbb X,该分辨率可以产生精确的匹配性能,尤其是在拟议的网络和评估数据集的较低误差带上,可以超越现有技术的方法。 |

| Taming Transformers for High-Resolution Image Synthesis Authors Patrick Esser, Robin Rombach, Bj rn Ommer 旨在学习顺序数据上的远程交互作用的互感器,在各种任务上继续展现出最新的技术成果。与CNN相比,它们不包含优先考虑局部相互作用的归纳偏置。这使它们表现出来,但对于长序列(例如高分辨率图像)在计算上是不可行的。我们演示了如何将CNN的感应偏置的有效性与变压器的表达能力相结合,从而使它们能够建模并由此合成高分辨率图像。我们展示了如何使用CNN来学习图像成分的上下文相关词汇,然后使用变压器来高效地对高分辨率图像中的成分进行建模。我们的方法很容易应用于条件合成任务,其中非空间信息(例如对象类)和空间信息(例如分割)都可以控制生成的图像。特别是,我们介绍了使用转换器在语义上指导兆像素图像合成的第一个结果。项目页面位于 |

| Transformer Interpretability Beyond Attention Visualization Authors Hila Chefer, Shir Gur, Lior Wolf 自我关注技术,尤其是“变形金刚”,在文本处理领域占据主导地位,并且在计算机视觉分类任务中变得越来越流行。为了可视化导致某种分类的图像部分,现有方法要么依赖于获得的注意力图,要么采用沿注意力图的启发式传播。在这项工作中,我们提出了一种计算变压器网络相关性的新颖方法。该方法基于深度泰勒分解原理分配局部相关性,然后将这些相关性分数传播到各层。这种传播涉及注意层和跳过连接,这挑战了现有方法。我们的解决方案基于一种特定的配方,该配方被证明可以保持各层之间的整体相关性。我们在最近的可视化Transformer网络以及文本分类问题上对我们的方法进行了基准测试,并证明了相对于现有可解释性方法的明显优势。 |

| SceneFormer: Indoor Scene Generation with Transformers Authors Xinpeng Wang, Chandan Yeshwanth, Matthias Nie ner 室内场景生成的任务是生成一系列对象,它们的位置和方向取决于房间的形状和大小。大型室内场景数据集使我们能够从用户设计的室内场景中提取图案,然后根据这些图案生成新的场景。现有方法除了对象位置之外还依赖于这些场景的2D或3D外观,并假设对象之间的可能关系。相反,我们不使用任何外观信息,而是使用变压器的自注意机制来学习对象之间的关系。我们证明,与具有相同或更好水平真实感的现有方法相比,这可以更快地生成场景。我们仅根据变压器的交叉注意机制,建立基于房间形状和房间文字描述的简单有效的生成模型。我们进行了一项用户研究,结果显示生成的场景比DeepSynth场景在卧室场景中占57.7倍,在客厅场景中占63.3倍。此外,我们平均可以在1.48秒内生成一个场景,比最先进的快速灵活方法快20倍,从而可以生成交互式场景。 |

| Neural Radiance Flow for 4D View Synthesis and Video Processing Authors Yilun Du, Yinan Zhang, Hong Xing Yu, Joshua B. Tenenbaum, Jiajun Wu 我们提出了一种神经辐射流NeRFlow方法,以从一组RGB图像中学习动态场景的4D空间时间表示。我们方法的关键是使用神经隐式表示,该隐式表示学会捕获场景的3D占用率,辐射度和动态。通过在不同模式之间实现一致性,我们的表示可以在各种动态场景中实现多视图渲染,包括注水,机器人互动和真实图像,其性能优于用于空间时空视图合成的最新方法。即使仅使用一台摄像机捕获输入图像,我们的方法仍然有效。我们进一步证明,学习到的表示可以充当隐式场景的先验,无需任何额外的监督就可以实现视频处理任务,例如图像超分辨率和降噪。 |

| End-to-end Deep Object Tracking with Circular Loss Function for Rotated Bounding Box Authors Vladislav Belyaev, Aleksandra Malysheva, Aleksei Shpilman 任务对象跟踪在自动驾驶,智能监控,机器人技术等众多应用中至关重要。此任务需要为视频流中的对象分配边界框,仅在第一帧上为其指定边界框。 2015年,创建了一种新型的视频对象跟踪VOT数据集,该数据集引入了旋转边界框作为轴对齐边界框的扩展。在这项工作中,我们介绍了一种基于Transformer Multi Head Attention架构的新颖的端到端深度学习方法。我们还提出了一种新型的损失函数,该函数考虑了边界框的重叠和方向。 |

| End-to-End Human Pose and Mesh Reconstruction with Transformers Authors Kevin Lin, Lijuan Wang, Zicheng Liu 我们提出了一种称为MEsh TRansfOrmer METRO的新方法,可以从单个图像重建3D人类姿势和网格顶点。我们的方法使用变压器编码器对顶点顶点和顶点关节相互作用进行联合建模,并同时输出3D关节坐标和网格顶点。与回归姿态和形状参数的现有技术相比,METRO不依赖任何参数网格模型(例如SMPL),因此可以轻松扩展到其他对象(例如手)。我们进一步放松了网格拓扑,并允许变压器的自关注机制自由地参与任意两个顶点之间,从而有可能学习网格顶点和关节之间的非局部关系。借助提出的蒙版顶点建模,我们的方法在处理诸如局部遮挡等挑战性情况时更加健壮和有效。 METRO在公共Human3.6M和3DPW数据集上生成了用于人类网格重建的最新技术成果。此外,我们证明了METRO在野外进行3D手重建的通用性,优于FreiHAND数据集上现有的现有方法。 |

| Interpretable Image Clustering via Diffeomorphism-Aware K-Means Authors Romain Cosentino, Randall Balestriero, Yanis Bahroun, Anirvan Sengupta, Richard Baraniuk, Behnaam Aazhang 我们设计了一种可理解的聚类算法,该算法可了解图像流形的非线性结构。我们的方法利用了在图像空间中应用的K均值的可解释性,同时解决了其聚类性能问题。具体来说,我们开发了一种图像和形心之间的相似性度量,该度量包含变形微分形的一般类,从而使聚类对其不变。我们的工作利用薄板样条插值技术有效地学习了能最好地表征图像流形的衍射。大量的数值模拟表明,我们的方法可以与各种数据集上的最新方法相抗衡。 |

| AutoCaption: Image Captioning with Neural Architecture Search Authors Xinxin Zhu, Weining Wang, Longteng Guo, Jing Liu 图像字幕将复杂的视觉信息转换为抽象的自然语言来表示,可以帮助计算机快速理解世界。但是,由于实际环境的复杂性,它需要识别关键对象并实现它们的连接,并进一步生成自然语言。整个过程涉及视觉理解模块和语言生成模块,这给深度神经网络的设计带来了比其他任务更多的挑战。神经体系结构搜索NAS已显示出其在各种图像识别任务中的重要作用。此外,RNN在图像字幕任务中起着至关重要的作用。我们介绍了一种AutoCaption方法来更好地设计图像字幕的解码器模块,其中我们使用NAS自动设计称为AutoRNN的解码器模块。我们使用基于共享参数的强化学习方法来有效地自动设计AutoRNN。 AutoCaption的搜索空间包括各层之间的连接以及各层中的操作,这可以使AutoRNN表达更多的体系结构。特别是,RNN相当于我们搜索空间的一个子集。在MSCOCO数据集上进行的实验表明,与传统的手工设计方法相比,我们的AutoCaption模型可以实现更好的性能。我们的自动字幕在COCO Karpathy测试拆分中获得了135.8的最佳发布CIDEr性能。进一步使用集成技术时,CIDEr会提高到139.5。 |

| Robust Image Captioning Authors Daniel Yarnell, Xian Wang 自动为照片添加字幕是一项任务,其中包含了照片分析和文本生成的困难。字幕的一个基本特征是注意的概念,即如何确定要指定的内容和顺序。在这项研究中,我们利用对抗性鲁棒割算法来利用对象关系,该算法通过专门嵌入有关通过图形表示的输入数据之间的空间关联的知识,在这种方法的基础上发展起来。我们的实验研究代表了我们提出的图像字幕方法的有希望的性能。 |

| Efficient CNN-LSTM based Image Captioning using Neural Network Compression Authors Harshit Rampal, Aman Mohanty 现代神经网络在计算机视觉,自然语言处理和相关垂直领域下的任务中实现最先进的性能方面举世闻名。但是,它们以其巨大的内存和计算需求而臭名昭著,这进一步阻碍了它们在资源受限的边缘设备上的部署。为了实现边缘部署,研究人员开发了修剪和量化算法以压缩此类网络,而不会影响其效率。此类压缩算法在独立的CNN和RNN架构上进行了广泛的实验,而在这项工作中,我们提出了基于CNN LSTM的图像字幕模型的非常规端到端压缩流水线。使用VGG16或ResNet50作为flickr8k数据集上的编码器和LSTM解码器来训练模型。然后,我们检查了不同压缩体系结构对模型的影响,并设计了一种压缩体系结构,与未压缩的压缩体系结构相比,该模型实现了模型大小减少73.1,推理时间减少71.3和BLEU得分增加7.7。 |

| RainNet: A Large-Scale Dataset for Spatial Precipitation Downscaling Authors Xuanhong Chen, Kairui Feng, Naiyuan Liu, Naiyuan Liu, Zhengyan Tong, Bingbing Ni, Ziang Liu, Ning Lin 空间降水缩减是地球科学界最重要的问题之一。但是,它仍然是一个未解决的问题。深度学习是缩小规模的有希望的潜在解决方案。为了促进深度学习降水降尺度的研究,我们提出了第一个textbf REAL非模拟大型空间降水降尺度数据集textbf RainNet,其中包含textbf 62,424对低分辨率和高分辨率降水图,共17年。与模拟数据相反,该真实数据集涵盖了各种类型的真实气象现象,例如飓风,急风等,并显示了挑战降尺度算法的物理字符textbf时间未对准,textbf时间稀疏和textbf流体性质。为了充分探索潜在的降尺度解决方案,我们提出了一个隐式的物理估算框架来学习上述特征。提出了专门考虑数据集物理属性的八个指标,同时在提议的数据集上评估了十四个模型。最后,我们分析了这些模型对降水缩减任务的有效性和可行性。数据集和代码将在url上提供 |

| PCT: Point Cloud Transformer Authors Meng Hao Guo, Jun Xiong Cai, Zheng Ning Liu, Tai Jiang Mu, Ralph R. Martin, Shi Min Hu 规则域的不规则和缺乏顺序使设计用于点云处理的深度神经网络具有挑战性。本文提出了一种新颖的名为Point Cloud Transformer PCT的框架,用于点云学习。 PCT基于Transformer,在自然语言处理方面取得了巨大成功,并在图像处理方面显示出巨大潜力。它本质上是置换不变的,可以处理一系列点,使其非常适合点云学习。为了更好地捕获点云中的本地上下文,我们在最远点采样和最近邻居搜索的支持下增强了输入嵌入。大量实验表明,PCT在形状分类,零件分割和法线估算任务方面达到了最先进的性能。 |

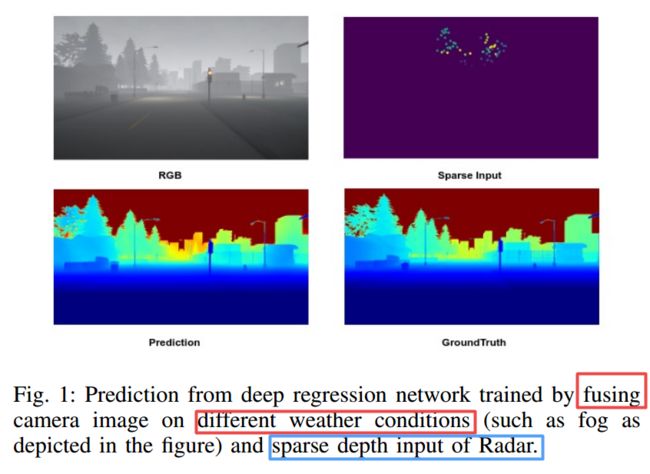

| Multi-Modal Depth Estimation Using Convolutional Neural Networks Authors Sadique Adnan Siddiqui, Axel Vierling, Karsten Berns 本文解决了在恶劣天气条件下根据稀疏距离传感器数据和单个摄像机图像进行密集深度预测的问题。这项工作探索了不同的传感器模式(如相机,雷达和激光雷达)通过应用深度学习方法来估计深度的重要性。尽管Lidar具有比Radar更高的深度感测能力,并且在许多先前的工作中已与摄像头图像集成在一起,但对于将鲁棒的雷达距离数据与摄像头图像融合使用CNN进行深度估计的研究还很少。在这项工作中,提出了一种深度递归网络,该网络利用了一种转移学习方法,该方法包括一个编码器和一个解码器,其中编码器使用高性能的预训练模型对其进行初始化,以提取密集特征;解码器用于上采样和预测所需深度。结果显示在Nuscenes,KITTI和使用CARLA模拟器创建的Synthetic数据集上。同样,将从建筑工地上的起重机捕获的顶视图变焦摄像机图像进行评估,以估计从地面搬运重物的起重机吊臂的距离,以显示在安全关键型应用中的可用性。 |

| A fully pipelined FPGA accelerator for scale invariant feature transform keypoint descriptor matching, Authors Luka Daoud, Muhammad Kamran Latif, H S. Jacinto, Nader Rafla 尺度不变特征变换SIFT算法被认为是计算机视觉领域的经典特征提取算法。由于消耗的数据量,SIFT关键点描述符匹配是一个计算密集型过程。在这项工作中,我们为SIFT关键点描述符匹配设计了一种新颖的全流水线硬件加速器体系结构。加速器内核是在现场可编程门阵列FPGA上实现和测试的。所提出的硬件体系结构能够正确处理完全流水线实施所需的内存带宽,并且达到了屋顶性能模型,从而实现了潜在的最大吞吐量。基于余弦角距离法设计了全流水线匹配架构。我们的架构针对16位定点操作进行了优化,并使用基于Xilinx Zynq的FPGA开发板在硬件上实现。与文献中的对应结构相比,我们提出的体系结构显示出区域资源显着减少,同时通过减轻内存带宽限制来保持高吞吐量。结果表明,LUT和BRAM的消耗设备资源减少了多达91%。我们的硬件实现比同类软件方法快15.7倍。 |

| Firearm Detection via Convolutional Neural Networks: Comparing a Semantic Segmentation Model Against End-to-End Solutions Authors Alexander Egiazarov, Fabio Massimo Zennaro, Vasileios Mavroeidis 通过实时视频对武器和攻击行为进行威胁检测可用于快速检测和预防潜在的致命事件,例如恐怖主义,一般性刑事犯罪甚至家庭暴力。实现这一目标的一种方法是使用人工智能,尤其是使用机器学习进行图像分析。在本文中,我们将传统的整体式端到端深度学习模型与先前提出的模型进行了比较,该模型基于通过语义分割来检测火器的更简单神经网络的集成。我们从不同的角度评估了这两个模型,包括准确性,计算和数据复杂性,灵活性和可靠性。我们的结果表明,与传统的深度模型模型相比,语义分割模型在低数据环境中提供了大量的灵活性和弹性,尽管其配置和调整对实现与端到端模型相同的准确性水平提出了挑战。 |

| Detection and Prediction of Nutrient Deficiency Stress using Longitudinal Aerial Imagery Authors Saba Dadsetan, Gisele Rose, Naira Hovakimyan, Jennifer Hobbs 早期,精确地检测养分缺乏压力NDS具有关键的经济和环境影响,精确的化学物质代替覆盖物施用可以降低种植者的运营成本,同时减少不必要地进入环境的化学物质的量。此外,较早的处理减少了损失的数量,因此在给定季节内提高了作物产量。考虑到这一点,我们收集高分辨率航空影像序列,并构建语义分割模型以检测和预测整个领域的NDS。我们的工作位于农业,遥感与现代计算机视觉和深度学习的交汇处。首先,我们为NDS的全场检测建立基线,并量化预训练,骨干架构,输入表示和采样策略的影响。然后,通过基于UNet构建单个时间戳模型,我们可以量化季节不同时间点可用的信息量。接下来,我们构建建议的时空架构,该架构将UNet与卷积LSTM层相结合,以准确检测显示NDS的区域,这种方法的IOU得分为0.53。最后,我们证明了可以训练这种体系结构来预测预期在以后的飞行中显示NDS的区域,未来可能超过三周,其IOU得分将保持在0.47 0.51,这取决于预测的提前程度。制作。我们还将发布一个数据集,我们相信它将有助于计算机视觉,遥感以及农业领域。这项工作为遥感和农业深度学习的最新发展做出了贡献,同时解决了对经济和可持续性具有影响的关键社会挑战。 |

| Trajectory saliency detection using consistency-oriented latent codes from a recurrent auto-encoder Authors L. Maczyta, P. Bouthemy, O. Le Meur 在本文中,我们关注视频序列中渐进动态显着性的检测。更确切地说,我们对与运动有关的显着性感兴趣,并且随着时间的流逝会逐渐出现。它可能与触发警报,专用于其他处理或检测特定事件有关。轨迹代表了支持渐进式动态显着性检测的最佳方法。因此,我们将讨论轨迹显着性。如果一条轨迹偏离共享与给定上下文相关的公共运动模式的正常轨迹,则该轨迹将被视为显着轨迹。首先,我们需要一个紧凑而有区别的轨迹表示。我们采用一种几乎无监督的基于学习的方法。由循环自动编码器估算的潜码可提供所需的表示。此外,我们通过自动编码器损失功能对正常相似轨迹实施一致性。轨迹代码与考虑正态性的原型代码之间的距离是检测显着轨迹的手段。我们在合成和真实轨迹数据集上验证了轨迹显着性检测方法,并强调了其不同组成部分的贡献。我们显示,在从Alahi 2014火车站获取的行人轨迹的公开数据集中得出的几种情况下,我们的方法优于现有方法。 |

| Incremental Learning from Low-labelled Stream Data in Open-Set Video Face Recognition Authors Eric Lopez Lopez, Carlos V. Regueiro, Xose M. Pardo 深度学习方法为一般分类问题带来了令人印象深刻的解决方案,这些分类问题为训练提供了丰富的带注释数据。相反,主要在将非平稳类应用于流数据的无监督问题时,在持续学习一组非平稳类方面取得的进展较小。 |

| Weakly-Supervised Action Localization and Action Recognition using Global-Local Attention of 3D CNN Authors Novanto Yudistira, Muthu Subash Kavitha, Takio Kurita 3D卷积神经网络3D CNN捕获有关3D数据(例如视频序列)的时空信息。但是,由于卷积和池化机制,信息丢失似乎是不可避免的。为了改善3D CNN的视觉解释和分类,我们提出了两种方法:使用训练有素的3DResNext网络将逐层全局全局聚合到局部全局局部离散梯度,以及实施注意门控网络以提高动作识别的准确性。拟议的方法旨在通过视觉归因,弱监督的动作定位和动作识别来显示称为3D CNN的全球局部注意的每一层的有用性。首先,对3DResNext进行训练,并使用涉及最大预测类别的反向传播将其应用于动作分类。然后向上采样每层的梯度和激活。后来,聚合被用来引起更多细微的关注,指出了预测班级输入视频中最关键的部分。我们使用最终关注的轮廓阈值进行最终定位。我们通过3DCam使用精细的视觉解释来评估修剪后的视频中的空间和时间动作定位。实验结果表明,该方法产生了有益的视觉解释和辨别力。此外,通过注意门控对每一层的动作识别比基线模型产生更好的分类结果。 |

| Embodied Visual Active Learning for Semantic Segmentation Authors David Nilsson, Aleksis Pirinen, Erik G rtner, Cristian Sminchisescu 我们研究了体现式视觉主动学习的任务,其中设置了一个代理来探索3d环境,目标是通过主动选择请求注释的视图来获取视觉场景理解。尽管在某些基准上很准确,但当今的深层视觉识别管道在某些真实世界的场景中或对于不寻常的观点往往无法很好地概括。反过来,机器人感知需要具有针对移动系统运行条件(包括混乱的室内环境或照明不佳)的识别能力的能力。这激发了提出的任务,其中将代理放置在新颖的环境中,目的是提高其视觉识别能力。为了研究具体的视觉主动学习,我们开发了一系列的代理,既可以学习也可以预先指定,并且具有不同级别的环境知识。代理配备了语义分割网络,并试图获取信息视图,移动和探索以便在这些视图的邻域中传播注释,然后通过在线重新训练来完善基础的分割网络。这种可训练的方法使用具有强化功能的深度强化学习,该功能平衡了两个相互竞争的目标任务的表现,即表现为视觉识别的准确性,这需要探索环境,以及在主动探索期间需要的必要数量的带注释数据。我们使用逼真的Matterport3D模拟器对提议的模型进行了广泛的评估,结果表明,即使请求的注释较少,完全学习的方法也可以胜过类似的预先指定的对应方法。 |

| A Hierarchical Feature Constraint to Camouflage Medical Adversarial Attacks Authors Qingsong Yao, Zecheng He, Yi Lin, Kai Ma, Yefeng Zheng, S. Kevin Zhou 用于医学图像的深度神经网络DNN极易受到对抗性示例AE的攻击,这对临床决策提出了安全性问题。幸运的是,根据我们在本文中的研究,医学AE也很容易在分层特征空间中检测到。为了更好地理解这种现象,我们彻底调查了特征空间中医学AE的内在特征,为为什么医学对抗性攻击易于检测的问题提供了经验证据和理论解释,我们首先进行压力测试以揭示深层表征的脆弱性与自然图像形成对比的医学图像。然后,我们从理论上证明,对二进制疾病诊断网络的典型对抗攻击是通过在固定方向上连续优化易受攻击的表示来操纵预测的,从而导致异常特征使医疗AE易于检测。但是,也可以利用此漏洞在特征空间中隐藏AE。我们提出了一种新颖的分层特征约束HFC,作为对现有对抗攻击的补充,它鼓励在常规特征分布内隐藏对抗表示。我们在两个公共医学图像数据集,即Fundoscopy和Chest X Ray上评估了该方法。实验结果证明了我们的对抗性攻击方法的优越性,因为它比竞争性攻击方法更容易绕过最先进的对抗性检测器,支持医疗功能的巨大脆弱性使攻击者有更多空间来操纵对抗性表示形式。 |

| Exploiting Learnable Joint Groups for Hand Pose Estimation Authors Moran Li, Yuan Gao, Nong Sang 在本文中,我们建议通过以组方式恢复关节的3D坐标来估计3D手势,在这种情况下,较少相关的关节会自动归类为不同的组并表现出不同的特征。这与以前的方法不同,以前的方法是整体考虑所有关节并具有相同特征。通过多任务学习MTL的原理说明了我们方法的好处,即通过将较少相关的关节作为不同的任务分成不同的组,我们的方法为每个关节学习了不同的特征,因此有效地避免了较少相关的任务之间的负迁移组关节。我们方法的关键是新颖的二进制选择器,该选择器会自动将相关关节选择到同一组中。我们使用从Concrete分布中随机采样的二进制值来实现这样的选择器,它是使用Gumbel softmax构造可训练参数而构造的。这使我们能够保留整个网络的差异性。我们通过在它们之间执行附加的特征融合方案,进一步从那些关系不太密切的组中挖掘特征,以学习更多区分特征。这是通过在级联特征上执行多个1x1卷积来实现的,其中每个关节组包含一个用于特征融合的唯一1x1卷积。详细的消融分析和在几个基准数据集上的广泛实验证明了该方法在最先进的SOTA方法方面的前景广阔。此外,在提交日期最新发布的FreiHAND竞赛中,我们的方法在未利用密集3D形状标签的所有方法中均排名第一。源代码和模型在以下位置可用 |

| CT Film Recovery via Disentangling Geometric Deformation and Illumination Variation: Simulated Datasets and Deep Models Authors Quan Quan, Qiyuan Wang, Liu Li, Yuanqi Du, S. Kevin Zhou 尽管计算机断层扫描CT等医学图像以DICOM格式存储在医院PACS中,但在许多国家还是很常见的做法是将胶片作为可转移的介质进行打印,以进行自我存储和二次咨询。此外,由于手机相机的普及,拍摄CT胶片的照片非常普遍,而CT胶片却遭受几何变形和照明变化的困扰。在这项工作中,我们尽我们所能研究了恢复CT胶片的问题,这是文献中的首次尝试。我们首先使用广泛使用的计算机图形软件Blender建立大型的头部CT胶片数据库CTFilm20K,该数据库包含大约20,000张照片。我们还将记录与几何变形有关的所有附带信息,例如3D坐标,深度,法线和UV贴图以及照明变化(例如反照率贴图)。然后,我们提出了一个深层框架,使用从CT胶片中提取的多个贴图来解开几何变形和照明变化,从而共同指导恢复过程。在模拟和真实图像上进行的大量实验证明了我们的方法优于以前的方法。我们计划开源模拟图像和深层模型,以促进CT胶片恢复的研究https://匿名。4open.science r e6b1f6e3 9b36 423f a225 55b7d0b55523。 |

| Learning to Share: A Multitasking Genetic Programming Approach to Image Feature Learning Authors Ying Bi, Bing Xue, Mengjie Zhang 进化多任务处理是一种有前途的方法,可以通过知识共享来同时解决多个任务。图像特征学习可以解决为多任务问题,因为不同的任务可能具有相似的特征空间。遗传编程GP已成功地应用于图像特征学习以进行分类。但是,大多数现有的GP方法都使用足够的训练数据来独立解决一项任务。尚未开发用于图像特征学习的多任务GP方法。因此,本文开发了一种用于图像特征学习的多任务GP方法,用于训练数据有限的分类。由于GP的灵活表示,因此开发了基于新的个人表示的新知识共享机制,以使GP可以自动学习要在两个任务之间共享的内容。共享知识被编码为公共树,它可以表示两个任务的共同一般特征。利用新的个体表示,可以使用从公共树和代表任务特定特征的任务特定树中提取的特征来解决每个任务。为了学习最佳的通用树和特定于任务的树,开发了新的进化过程和新的适应度函数。该方法的性能在训练数据有限的12个图像分类数据集中的6个多任务问题上进行了检验,并与3个基于GP和14个基于非GP的竞争方法进行了比较。实验结果表明,新方法几乎在所有比较中均优于这些比较方法。进一步的分析表明,该新方法可以学习简单而有效的常见树,并且具有很高的有效性和可移植性。 |

| FG-Net: Fast Large-Scale LiDAR Point CloudsUnderstanding Network Leveraging CorrelatedFeature Mining and Geometric-Aware Modelling Authors Kangcheng Liu, Zhi Gao, Feng Lin, Ben M. Chen 这项工作展示了FG Net,这是一个通用的深度学习框架,可用于无需像素化即可理解大规模点云,该框架可通过单个NVIDIA GTX 1080 GPU来实现准确和实时的性能。首先,设计了一种新颖的噪声和异常值滤波方法来促进后续的高级任务。为了有效理解,我们提出了一种深度卷积神经网络,利用相关特征挖掘和基于可变形卷积的几何感知建模,可以充分利用局部特征关系和几何图案。对于效率问题,我们提出了一种逆密度采样操作和一种基于特征金字塔的残差学习策略,以分别节省计算成本和内存消耗。在现实世界中具有挑战性的数据集上进行的大量实验表明,在准确性和效率方面,我们的方法优于最新方法。此外,还进行了弱监督的迁移学习来证明我们方法的泛化能力。 |

| Multi-shot Temporal Event Localization: a Benchmark Authors Xiaolong Liu 1 , Yao Hu 2 , Song Bai 2,3 , Fei Ding 2 , Xiang Bai 1 , Philip H.S. Torr 3 1 Huazhong University of Science and Technology, 2 Alibaba Group, 3 University of Oxford 时间事件或动作本地化的当前发展通常以单个摄像机捕获的动作为目标。但是,野外发生的大量事件或动作可能会被不同位置的多个摄像机捕获为一系列镜头。 |

| PanoNet3D: Combining Semantic and Geometric Understanding for LiDARPoint Cloud Detection Authors Xia Chen, Jianren Wang, David Held, Martial Hebert 自主驾驶感知中的视觉数据(例如相机图像和LiDAR点云)可以解释为语义特征和几何结构这两个方面的混合。语义来自对象到传感器的外观和上下文,而几何结构是点云的实际3D形状。 LiDAR点云上的大多数检测器仅专注于分析真实3D空间中对象的几何结构。与以前的作品不同,我们建议通过统一的多视图框架学习语义特征和几何结构。我们的方法利用了LiDAR扫描2D距离图像的性质,并应用了经过深入研究的2D卷积来提取语义特征。通过融合语义和几何特征,我们的方法在所有类别上的性能均优于最新方法。结合语义和几何特征的方法为观察现实世界中3D点云检测中的问题提供了独特的视角。 |

| Computation-Efficient Knowledge Distillation via Uncertainty-Aware Mixup Authors Guodong Xu, Ziwei Liu, Chen Change Loy 知识提炼涉及从教师网络中提取暗知识以指导学生网络的学习,它已成为模型压缩和转移学习的基本技术。与以前的工作着重于学生网络的准确性不同,我们在这里研究了一些探索但重要的问题,即知识提炼效率。我们的目标是在训练过程中以较低的计算成本实现与传统知识蒸馏相当的性能。我们证明不确定性的mIXup UNIX可以作为一种干净而有效的解决方案。不确定性抽样策略用于评估每个训练样本的信息量。自适应混合应用于不确定样本以压缩知识。我们进一步表明,传统知识蒸馏的冗余在于对简单样本的过度学习。通过结合不确定性和混淆,我们的方法减少了冗余,并更好地利用了对教师网络的每个查询。我们在CIFAR100和ImageNet上验证了我们的方法。值得注意的是,我们仅用79的计算成本就在CIFAR100上优于传统知识提炼,并在ImageNet上获得了可比的结果。 |

| Temporal LiDAR Frame Prediction for Autonomous Driving Authors David Deng, Avideh Zakhor 对于自动驾驶和机器人等许多领域而言,在动态场景中预见未来至关重要。在本文中,我们提出了一类新颖的神经网络架构,以根据先前的框架预测未来的LiDAR框架。由于此应用程序中的基本事实只是序列中的下一帧,因此我们可以以自我监督的方式训练模型。我们提出的架构基于FlowNet3D和动态图CNN。我们使用倒角距离CD和推土机的距离EMD作为损失函数和评估指标。我们使用新发布的nuScenes数据集训练和评估我们的模型,并使用几个基准来表征它们的性能和复杂性。与直接使用FlowNet3D相比,我们提出的体系结构实现的CD和EMD降低了近一个数量级。此外,我们证明了我们的预测无需使用任何标记的监督即可生成合理的场景流近似值。 |

| LIGHTEN: Learning Interactions with Graph and Hierarchical TEmporal Networks for HOI in videos Authors Sai Praneeth Reddy Sunkesula, Rishabh Dabral, Ganesh Ramakrishnan 分析视频中人与物体之间的交互包括识别人与视频中存在的物体之间的关系。可以将其视为视觉关系检测的专用版本,其中对象之一必须是人类。尽管传统方法将问题表达为对视频片段序列的推断,但我们提出了一种分层方法LIGHTEN,以学习视觉特征以有效地捕获视频中多个粒度的时空提示。与当前方法不同,LIGHTEN避免使用地面真实数据,例如深度图或3D人体姿态,因此也增加了跨非RGBD数据集的概括性。此外,我们仅使用视觉特征,而不是通常使用的手工制作的空间特征即可达到相同的效果。我们在人与物体的交互检测88.9和92.6以及CAD 120的预期任务以及V COCO数据集中基于图像的HOI检测方面的竞争结果中获得了最先进的结果,为基于视觉特征的方法设定了新的基准。 LIGHTEN的代码可在以下位置获得 |

| Zoom-to-Inpaint: Image Inpainting with High Frequency Details Authors Soo Ye Kim, Kfir Aberman, Nori Kanazawa, Rahul Garg, Neal Wadhwa, Huiwen Chang, Nikhil Karnad, Munchurl Kim, Orly Liba 尽管深度学习已使图像修补取得了巨大的飞跃,但当前的方法通常无法合成逼真的高频细节。在本文中,我们提议将超分辨率应用于粗略重构的输出,以高分辨率对其进行细化,然后将输出缩减为原始分辨率。通过将高分辨率图像引入细化网络,我们的框架能够重建更细小的细节,这些细节通常由于频谱偏差而平滑,因为神经网络比低频更好地重建低频。为了帮助在较大的高档孔上训练细化网络,我们提出了一种渐进式学习技术,其中随着训练的进行,缺失区域的大小会增加。我们的放大,细化和缩小策略,结合高分辨率的监督和渐进式学习,构成了一种框架不可知论的方法,用于增强可用于其他修复方法的高频细节。我们提供了定性和定量评估以及烧蚀分析,以显示我们方法的有效性,其性能优于最新的修补方法。 |

| Invariant Teacher and Equivariant Student for Unsupervised 3D Human Pose Estimation Authors Chenxin Xu, Siheng Chen, Maosen Li, Ya Zhang 我们提出了一种基于师生学习框架的新颖方法,无需任何3D注释或辅助信息即可进行3D人体姿势估计。为了解决这一无监督的学习问题,教师网络采用基于姿势字典的建模方法进行正则化,以估算物理上可行的3D姿势。为了处理教师网络中的分解歧义,我们提出了一种循环一致的体系结构,该体系结构可促进3D旋转不变性来训练教师网络。为了进一步提高估计精度,学生网络采用新颖的图卷积网络以灵活地直接估计3D坐标。采用另一种促进3D旋转等变特性的循环一致性架构,以利用几何一致性,并结合来自教师网络的知识提炼,以改善姿态估计性能。我们对Human3.6M和MPI INF 3DHP进行了广泛的实验。与最先进的无监督方法相比,我们的方法将3D联合预测误差降低了11.4,并且比在Human3.6M上使用辅助信息的许多弱监督方法要好。代码将在以下位置提供 |

| Efficient Golf Ball Detection and Tracking Based on Convolutional Neural Networks and Kalman Filter Authors Tianxiao Zhang, Xiaohan Zhang, Yiju Yang, Zongbo Wang, Guanghui Wang 本文着重研究在线高尔夫球从图像序列进行检测和跟踪的问题。通过利用基于卷积神经网络CNN的目标检测和基于Kalman滤波器的预测,提出了一种有效的实时方法。实现并评估了五个基于经典深度学习的对象检测网络以进行球检测,包括YOLO v3及其微型版本YOLO v4,Faster R CNN,SSD和RefineDet。该检测是在小图像小块而不是整个图像上执行的,以提高小球检测的性能。在跟踪阶段,采用离散卡尔曼滤波器来预测球的位置,并根据该预测裁剪一个小的图像块。然后,利用物体检测器来细化球的位置并更新卡尔曼滤波器的参数。为了训练检测模型并测试跟踪算法,创建并标注了高尔夫球数据集。进行了广泛的比较实验,以证明所提出方案的有效性和出色的跟踪性能。 |

| Event Camera Calibration of Per-pixel Biased Contrast Threshold Authors Ziwei Wang, Yonhon Ng, Pieter van Goor, Robert Mahony 即使在极端的照明条件下,事件摄像机也会输出异步事件来以高的时间分辨率表示强度变化。当前,大多数现有作品使用单个对比度阈值来估计所有像素的强度变化。但是,复杂的电路偏置和制造缺陷会导致像素偏置以及像素之间的对比度阈值不匹配,这可能会导致不良输出。在本文中,我们提出了一种新的事件摄像机模型和两种校准方法,它们涵盖了仅事件摄像机和混合图像事件摄像机。当同时提供强度图像和事件时,我们还提出了一种有效的在线方法来校准事件摄影机,以适应随时间变化的事件发生率。与几种不同的事件摄像机数据集上的最新技术相比,我们证明了我们提出的方法的优势。 |

| Unlabeled Data Guided Semi-supervised Histopathology Image Segmentation Authors Hongxiao Wang, Hao Zheng, Jianxu Chen, Lin Yang, Yizhe Zhang, Danny Z. Chen 自动组织病理学图像分割对疾病分析至关重要。有限的可用标签数据阻碍了在完全监督的环境下训练模型的推广。基于生成方法的半监督学习SSL已被证明可有效利用各种图像特征。但是,尚未很好地探索哪种类型的生成图像对于模型训练以及如何使用此类图像更有用。在本文中,我们提出了一种利用未标记的数据分布进行组织病理学图像分割的新的数据指导的生成方法。首先,我们设计一个图像生成模块。图像内容和样式被解开并嵌入在群集友好的空间中以利用它们的分布。通过采样并交叉组合内容和样式来合成新图像。其次,我们设计了一种有效的数据选择策略,以明智地对生成的图像进行采样1,以使生成的训练集更好地覆盖数据集,原始训练集中代表不足的聚类被覆盖2,以使训练过程更加有效,在可能缺少注释的训练数据的数据中,识别并重采样困难病例的图像。我们的方法在腺体和细胞核数据集上进行了评估。我们表明,在归纳和转导设置下,我们的SSL方法始终如一地提高了常见细分模型的性能,并获得了最先进的结果。 |

| Semi-Global Shape-aware Network Authors Pengju Zhang, Yihong Wu, Jiagang Zhu 非本地操作通常用于通过将全局上下文最近聚合到每个位置来捕获远程依赖关系。但是,大多数方法无法保留对象形状,因为它们仅关注特征相似性,却忽略了中心位置和其他位置之间的接近性以捕获远距离依赖关系,而形状意识对于许多计算机视觉任务很有帮助。在本文中,我们提出了一种半全局形状感知网络SGSNet,该模型同时考虑了特征相似性和邻近性,以便在对远程依赖性进行建模时保留对象形状。采用分层方式来聚合全局上下文。在第一级中,整个特征图中的每个位置仅根据相似度和邻近度在垂直和水平方向上聚合上下文信息。然后将结果输入到第二级以执行相同的操作。通过这种分层方式,每个中心位置获得来自所有其他位置的支持,而相似性和接近性的组合使得每个位置获得的支持大部分来自同一语义对象。此外,我们还提出了一种用于上下文信息聚合的线性时间算法,其中将特征图中的行和列中的每一行都视为二叉树,以减少相似度计算成本。语义分割和图像检索的实验表明,将SGSNet添加到现有网络中可以在准确性和效率上取得实质性的提高。 |

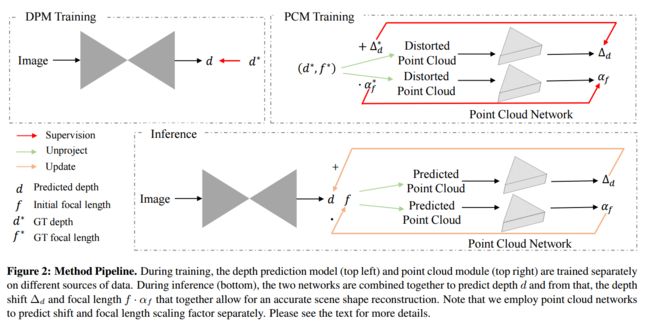

| Learning to Recover 3D Scene Shape from a Single Image Authors Wei Yin, Jianming Zhang, Oliver Wang, Simon Niklaus, Long Mai, Simon Chen, Chunhua Shen 尽管在野外单眼深度估计方面取得了重大进展,但由于混合数据深度预测训练中使用的平移不变重建损失引起的未知深度偏移以及可能的未知摄像头,因此无法使用最新的技术来恢复准确的3D场景形状焦距。我们将详细研究此问题,并提出一个两阶段框架,该框架首先预测到未知比例的深度并从单个单眼图像进行偏移,然后使用3D点云编码器预测丢失的深度偏移和焦距,从而使我们能够恢复逼真的3D场景形状。此外,我们提出了图像级归一化回归损失和基于法线的几何损失,以增强在混合数据集上训练的深度预测模型。我们在9个看不见的数据集上测试了深度模型,并在零镜头数据集泛化方面达到了最先进的性能。代码位于 |

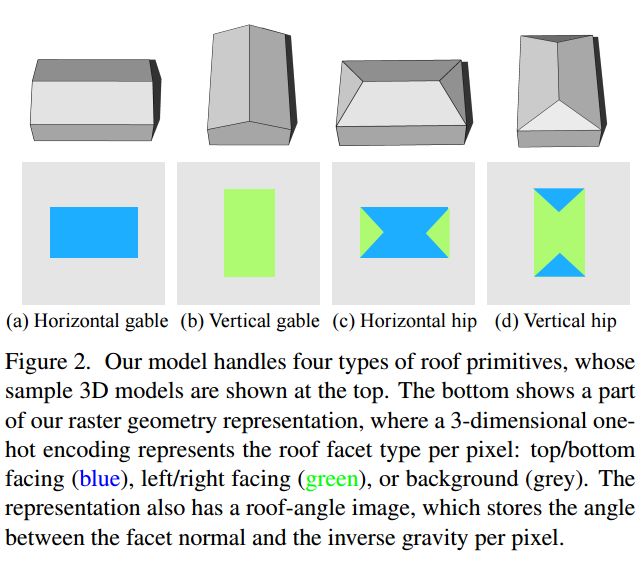

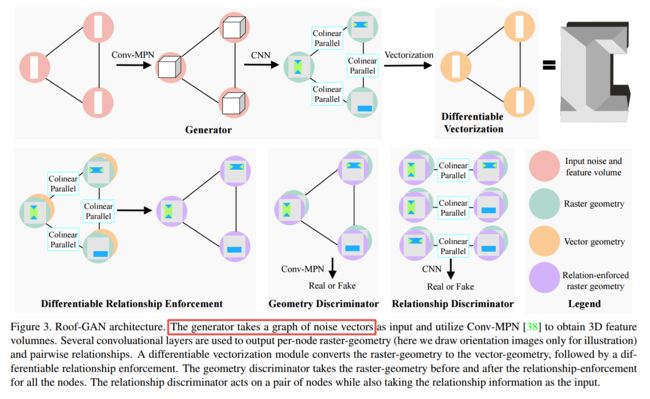

| Roof-GAN: Learning to Generate Roof Geometry and Relations for Residential Houses Authors Yiming Qian, Hao Zhang, Yasutaka Furukawa 本文介绍了Roof GAN,这是一种新型的生成对抗网络,可生成住宅屋顶结构的结构化几何图形,作为一组屋顶图元及其关系。给定图元的数量,生成器将生成一个结构化的屋顶模型作为图形,该模型由1个图元几何作为每个节点上的光栅图像,对小平面分割和角度进行编码,在每个边上2个图元共线性共面关系和3个图元几何。每个节点的向量格式,由新型可微分向量器在执行关系时生成。鉴别器经过训练,可以评估完整端到端架构中的原始栅格几何,原始关系和原始矢量几何。定性和定量评估证明了我们的方法在竞争方法上生成多样化和逼真的屋顶模型的有效性,本文提出了针对结构化几何生成任务的新颖指标。我们将共享我们的代码和数据。 |

| Unsupervised Learning of Local Discriminative Representation for Medical Images Authors Huai Chen, Jieyu Li, Renzhen Wang, Yijie Huang, Fanrui Meng, Deyu Meng, Qing Peng, Lisheng Wang 在许多医学图像分析任务中,例如通过测量局部图像区域的相似性来识别病变的亚型或分割解剖结构的详细组成部分,都需要进行局部区分。但是,通常采用的监督式表示学习方法需要大量的注释数据,无监督的判别式表示学习通过学习全局特征来区分不同的图像。为了避免这两种方法的局限性并适合于局部医学图像分析任务,我们在这项工作中将局部区分引入无监督的表示学习中。该模型包含两个分支,一个是嵌入分支,其学习嵌入函数以在低维超球体上分散相异的像素,另一个是聚类分支,其学习聚类函数以将相似像素分类到同一聚类中。这两个分支以互利的模式同时进行训练,并且学习到的局部判别表示能够很好地测量局部图像区域的相似性。可以传输这些表示以增强各种下游任务。同时,它们也可以在模拟的拓扑先验或具有类似拓扑特征的其他结构的指导下,将未标记医学图像的解剖结构聚类。通过增强各种下游任务并在视网膜图像和胸部X射线图像中聚集解剖结构,证明了该方法的有效性和实用性。相应的代码位于 |

| Polyblur: Removing mild blur by polynomial reblurring Authors Mauricio Delbracio, Ignacio Garcia Dorado, Sungjoon Choi, Damien Kelly, Peyman Milanfar 我们提出了一种高效的盲目复原方法,以消除自然图像中的轻微模糊。与主流相反,我们专注于消除经常出现的轻微模糊,这会损害图像质量,并且通常由少量的失焦,镜头模糊或轻微的相机运动产生。所提出的算法首先估计图像模糊,然后以有原则的方式通过组合估计模糊的多种应用来对其进行补偿。为了估计模糊,我们基于经验观察引入了一种简单而鲁棒的算法,该经验是关于清晰自然图像中梯度的分布。我们的实验表明,在温和模糊的情况下,所提出的方法优于传统和现代的盲去模糊方法,并且运行时间仅占一小部分。我们的方法可用于在应用现成的超分辨率方法之前盲目校正模糊,从而获得比其他高度复杂且计算要求高的技术更好的结果。提出的方法可以在一秒钟内估算并消除现代手机上的12MP图像中的轻微模糊。 |

| Learning to Recognize Patch-Wise Consistency for Deepfake Detection Authors Tianchen Zhao, Xiang Xu, Mingze Xu, Hui Ding, Yuanjun Xiong, Wei Xia 我们建议基于面部表情的基本特征之一检测由人脸操作生成的Deepfake,这些图像被来自多个来源的补丁混合而成,并带有不同且持久的来源特征。特别是,我们针对此任务提出了一种新颖的表示学习方法,称为逐块明智一致性学习PCL。它通过测量图像源特征的一致性来学习,从而获得对多种伪造方法具有良好解释性和鲁棒性的表示形式。我们开发了一个不一致的图像生成器I2G,以生成PCL的训练数据并增强其鲁棒性。我们在七个流行的Deepfake检测数据集上评估了我们的方法。我们的模型实现了卓越的检测精度,并很好地推广到了看不见的生成方法。平均而言,在内部数据集和交叉数据集评估中,我们的模型在AUC方面的表现优于现有技术,分别为2和8。 |

| Self-Supervised Sketch-to-Image Synthesis Authors Bingchen Liu, Yizhe Zhu, Kunpeng Song, Ahmed Elgammal 从任意绘制的草图中想象出彩色逼真的图像是我们渴望机器模仿的人类能力之一。与以前的需要素描图像对或利用少量检测到的边缘作为素描的方法不同,我们以自我监督的学习方式研究了基于示例的素描到图像s2i合成任务,从而消除了配对素描数据的必要性。为此,我们首先提出了一种无监督方法,可以有效地合成仅适用于RGB的通用数据集的线草图。利用合成的配对数据,我们然后提供一个自我监督的自动编码器AE,以将内容样式特征与草图和RGB图像解耦,并合成内容忠实于草图和样式与RGB图像一致的图像。尽管先前的工作采用了循环一致性损失或专用的注意模块来增强内容样式的保真度,但我们通过纯自我监督展示了AE的卓越性能。为了进一步提高高分辨率的合成质量,我们还利用对抗网络来细化合成图像的细节。在1024 1024分辨率上的广泛实验证明了CelebA HQ和Wiki Art数据集上所提出模型的最新艺术表现。此外,通过提出的草图生成器,该模型在样式混合和样式转移方面显示出令人鼓舞的性能,这要求合成图像既具有样式一致性又具有语义上的意义。我们的代码可在 |

| Projected Distribution Loss for Image Enhancement Authors Mauricio Delbracio, Hossein Talebi, Peyman Milanfar 从物体识别CNN获得的特征已被广泛用于测量图像之间的感知相似度。这种可区分的度量可以用作感知学习损失来训练图像增强模型。但是,输入特征和目标特征之间距离函数的选择可能会对训练模型的性能产生相应影响。虽然使用提取的特征之间的差异的范数导致细节产生有限的幻觉,但测量特征分布之间的距离可能会生成更多纹理,但还会生成更多不真实的细节和伪像。在本文中,我们证明了聚合CNN激活之间的一维Wasserstein距离比现有方法更可靠,并且可以显着改善增强模型的感知性能。更明确地,我们表明,在诸如降噪,超分辨率,去马赛克,去模糊和JPEG伪像去除之类的成像应用中,建议的学习损失优于基于参考的感知损失的当前技术水平。这意味着可以将建议的学习损失插入不同的成像框架中,并产生可感知的逼真的结果。 |

| Sparse Signal Models for Data Augmentation in Deep Learning ATR Authors Tushar Agarwal, Nithin Sugavanam, Emre Ertin 自动目标识别ATR算法使用一组可用于每个类别的训练图像,将给定的合成孔径雷达SAR图像分类为一个已知的目标类别。最近,如果有足够的训练数据可用,学习方法可以达到最先进的分类精度,这些训练数据可以在类及其姿势上统一采样。在本文中,我们以一组有限的训练图像来考虑ATR的任务。我们提出了一种数据增强方法,以融合领域知识并提高数据密集型学习算法(例如卷积神经网络CNN)的泛化能力。所提出的数据增强方法利用有限的持久性稀疏建模方法,充分利用了广角合成孔径雷达SAR图像的常见特征。具体来说,我们利用空间域中散射中心的稀疏性和方位角域中散射系数的平滑变化结构来解决过参数化模型拟合的不适定问题。使用这个估计的模型,我们合成了给定数据中不可用的姿势和子像素转换处的新图像,以增强CNN的训练数据。实验结果表明,对于训练数据匮乏的区域,该方法在所得的ATR算法的泛化性能上具有显着的提高。 |

| ISD: Self-Supervised Learning by Iterative Similarity Distillation Authors Ajinkya Tejankar, Soroush Abbasi Koohpayegani, Vipin Pillai, Paolo Favaro, Hamed Pirsiavash 最近,对比学习在自我监督学习中取得了很大的成就,其主要思想是与其他随机图像负对相比,将图像正对的两个增强推近。我们认为并非所有随机图像都是相等的。因此,我们引入了一种自我监督的学习算法,该算法对负图像使用软相似性,而不是对正负对之间使用二进制区分。通过捕获查询图像与一些随机图像的相似性并将该知识传递给学生,我们迭代地将缓慢发展的教师模型提炼为学生模型。我们认为,与最近的对比学习方法相比,我们的方法的约束较少,因此可以学习更好的功能。具体来说,我们的方法应比现有的对比学习方法更好地处理不平衡和未标记的数据,因为随机选择的负数集可能包含语义上与查询图像相似的许多样本。在这种情况下,我们的方法将它们标记为高度相似,而标准对比法将它们标记为负对。与现有技术模型(例如BYOL和MoCo)相比,我们的方法在转移学习设置上可获得更好的结果。我们还表明,在未标记数据不平衡的设置中,我们的方法性能更好。我们的代码在这里 |

| Neural Pruning via Growing Regularization Authors Huan Wang, Can Qin, Yulun Zhang, Yun Fu 长期以来,正则化一直被用来学习深度神经网络修剪中的稀疏性。但是,其作用主要是在小罚强度体系中进行的。在这项工作中,我们将其应用扩展到正则化逐渐变大的新场景,以解决修剪修剪计划和权重重要性评分这两个核心问题。 1前一个主题是这项工作中新提出的,我们发现它对修剪性能至关重要,而很少受到研究关注。具体来说,我们提出了一个L2正则化变体,其罚因子增加,并且表明即使与相同的权重相比,它也能比单次射击带来更大的准确性。 2不断增长的惩罚方案还为我们提供了一种方法,可以在不知道其具体值的情况下利用Hessian信息进行更精确的修剪,因此不会受到常见的Hessian近似问题的困扰。根据经验,所提出的算法易于实现,并且可以在结构化和非结构化修剪中扩展到大型数据集和网络。 CIFAR和ImageNet数据集上的现代深度神经网络证明了它们的有效性,与许多先进的算法相比,它们具有竞争优势。我们的代码和训练有素的模型可在以下位置公开获得 |

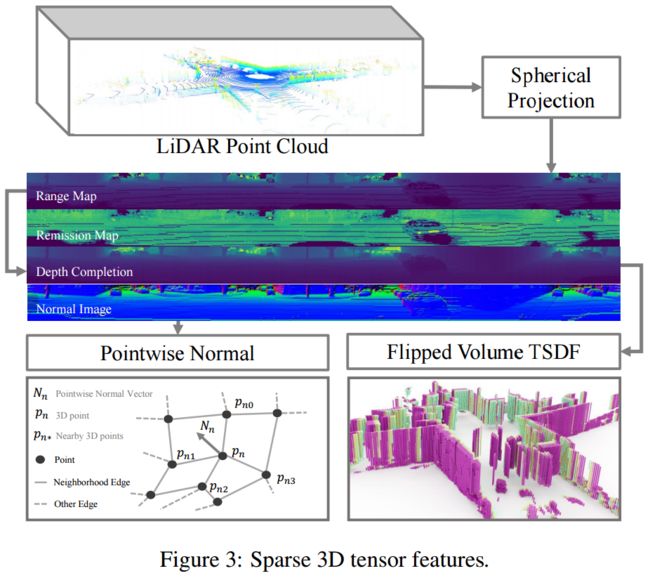

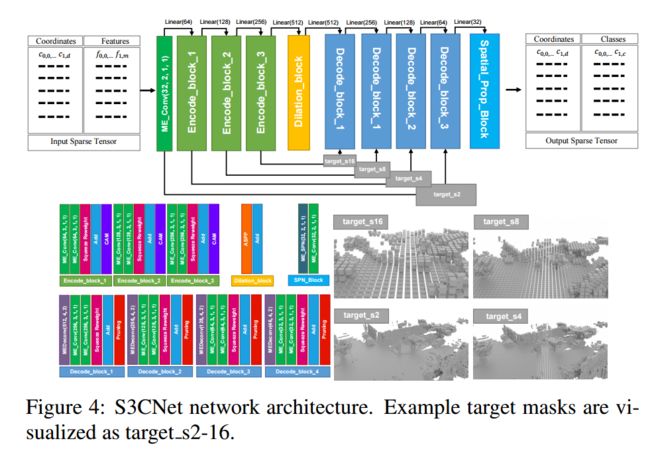

| S3CNet: A Sparse Semantic Scene Completion Network for LiDAR Point Clouds Authors Ran Cheng, Christopher Agia, Yuan Ren, Xinhai Li, Liu Bingbing 随着越来越多的自动驾驶和类似的机器人系统对强大的3D视觉的依赖,使用深度卷积神经网络处理LiDAR扫描已成为学术界和行业的趋势。先前针对具有挑战性的语义场景完成任务的尝试(其中包含从稀疏表示中推断出密集的3D结构和相关的语义标签)在一定程度上在小型室内场景中获得了成功,当提供密集的点云或通常与语义融合的密集深度图时RGB图像的图像分割图。但是,当将这些系统应用于以动态和指数稀疏条件为特征的大型室外场景时,这些系统的性能将急剧下降。同样,由于内存限制,处理整个稀疏卷变得不可行,并且由于从业人员被迫将整个卷分成多个相等的段并分别进行推断,因此变通方法会导致计算效率低下,从而无法实现实时性能。在这项工作中,我们制定了一种包含大型环境稀疏性的方法,并提出了S3CNet,这是一种基于稀疏卷积的神经网络,可以从单个统一的LiDAR点云中预测语义上完整的场景。我们表明,我们提出的方法在3D任务上胜过所有同类方法,并在SemanticKITTI基准上达到了最先进的结果。此外,我们提出了一种S3CNet的2D变体,它采用了多视图融合策略来补充我们的3D网络,从而为远距离遮挡和极端稀疏性提供了鲁棒性。我们针对2D语义场景完成任务进行实验,并将稀疏2D网络的结果与适用于两个开源数据集的鸟瞰图分割的几种领先的LiDAR分割模型进行比较。 |

| uBAM: Unsupervised Behavior Analysis and Magnification using Deep Learning Authors Biagio Brattoli, Uta Buechler, Michael Dorkenwald, Philipp Reiser, Linard Filli, Fritjof Helmchen, Anna Sophia Wahl, Bjoern Ommer 运动行为分析对生物医学研究和临床诊断至关重要,因为它提供了一种非侵入性策略来识别运动障碍及其由干预引起的变化。先进的仪器化运动分析需要大量时间和成本,因为它需要放置物理或虚拟标记。除了标记训练或微调检测器所需的关键点或注释所需的工作之外,用户还需要事先知道有趣的行为以提供有意义的关键点。我们介绍了uBAM,这是一种通过发现和放大偏差来进行行为分析的新颖的自动深度学习算法。我们提出了一种无监督的姿势和行为表示学习方法,可以对受试者进行客观的行为比较。具有新颖的外观和行为解析能力的生成模型可以直接在视频中放大跨主体的细微行为差异,而无需通过关键点或注释绕行。对啮齿动物和人类神经系统疾病患者的评估证明了我们方法的广泛适用性。 |

| Shape My Face: Registering 3D Face Scans by Surface-to-Surface Translation Authors Mehdi Bahri, Eimear O Sullivan, Shunwang Gong, Feng Liu, Xiaoming Liu, Michael M. Bronstein, Stefanos Zafeiriou 现有的表面配准方法专注于几乎没有泛化能力的样本数据拟合,并且需要大量的预处理和仔细的手工调整。在本文中,我们将注册任务转换为表面到表面的平移问题,并设计了一个模型来直接从原始3D面部扫描中可靠地捕获潜在的几何信息。我们介绍了Shape My Face SMF,这是一种功能强大的编码器解码器体系结构,它基于改进的点云编码器,新颖的视觉注意力机制,具有跳过连接的图卷积解码器以及可以与网格卷积平滑集成的专用嘴模型。与以前的非刚性人脸扫描配准的现有学习算法相比,SMF仅要求原始数据与使用预先定义的人脸模板进行缩放而严格对齐。此外,我们的模型提供了拓扑上合理的网格,且监督最少,提供了更快的训练时间,可训练参数减少了几个数量级,对噪声更鲁棒,并且可以推广到以前看不见的数据集。我们对各种数据的注册质量进行了广泛的评估。我们在不同模式,传感器类型和分辨率的野脸扫描中展示了我们模型的鲁棒性和通用性。最后,我们表明,通过学习注册扫描,SMF产生了混合线性和非线性可变形模型,可通过操纵潜在空间(包括在野外)将其用于生成,形状变形和表达传递。我们在包含9个大型商品硬件数据库的人脸数据集上训练SMF。 |

| On Episodes, Prototypical Networks, and Few-shot Learning Authors Steinar Laenen, Luca Bertinetto 间歇式学习是对少量射击学习感兴趣的研究人员和从业者的流行实践。它包括针对一系列学习问题组织培训,每个学习问题都依靠小规模的支持和查询集来模拟评估过程中遇到的一些枪击情况。在本文中,我们研究了原型网络和匹配网络中的情境学习的有用性,这是利用这种实践的两种最流行的算法。出乎意料的是,在我们的实验中,我们发现,对于原型网络和匹配网络,使用间歇式学习策略在支持集和查询集之间分离训练样本是有害的,因为这是一种利用训练批次的数据效率低下的方式。这些与经典邻域成分分析密切相关的非情节变体,在多个数据集中可靠地改进了它们的情节变体,尽管原型网络非常简单,但仍可达到与原型网络竞争的准确性。 |

| Learning Cross-Domain Correspondence for Control with Dynamics Cycle-Consistency Authors Qiang Zhang, Tete Xiao, Alexei A. Efros, Lerrel Pinto, Xiaolong Wang 许多机器人技术问题的核心是跨域学习通信的挑战。例如,模仿学习需要获得人与机器人之间的对应关系,而仿真需要与物理模拟器之间的对应关系,而现实世界中的转移学习需要不同机器人环境之间的对应关系。本文旨在学习在表征视觉与内部状态,物理参数质量和摩擦力以及肢体形态数量不同的领域之间的对应关系。重要的是,使用来自两个域的未配对和随机收集的数据来学习对应关系。我们建议使用循环一致性约束,在两个域之间对齐动态机器人行为的文本动态循环。找到此对应关系后,我们可以将在一个域上训练的策略直接转移到另一个域,而无需在第二个域上进行任何其他的微调。我们在仿真和实际机器人上跨各种问题领域进行实验。我们的框架能够将真实机器人手臂的未经校准的单眼视频与模拟手臂的动态状态动作轨迹对齐,而无需配对数据。我们的结果的视频演示可在以下位置获得: |

| Deep Learning Techniques for Super-Resolution in Video Games Authors Alexander Watson 视频游戏图形的计算成本正在增加,并且用于处理图形的硬件也难以跟上。这意味着计算机科学家需要开发创新的方法来提高图形处理硬件的性能。用于视频超分辨率的深度学习技术可以使视频游戏具有高质量的图形,同时抵消很多计算成本。这些新兴技术使消费者能够提高视频游戏的性能和娱乐性,并有可能成为游戏开发行业的标准配置。 |

| Describing the Structural Phenotype of the Glaucomatous Optic Nerve Head Using Artificial Intelligence Authors Satish K. Panda, Haris Cheong, Tin A. Tun, Sripad K. Devella, Ramaswami Krishnadas, Martin L. Buist, Shamira Perera, Ching Yu Cheng, Tin Aung, Alexandre H. Thi ry, Micha l J. A. Girard 视神经乳头ONH通常会随着青光眼的发生和发展而经历复杂的神经和结缔组织结构变化,因此监测这些变化对于改善青光眼诊所的诊断和预后至关重要。临床上评估ONH结构变化的金标准技术是光学相干断层扫描OCT。但是,OCT仅限于测量一些手工设计的参数,例如视网膜神经纤维层RNFL的厚度,并且尚未被鉴定为可用于青光眼诊断和预后的独立设备。我们认为这是因为尚未对ONH的3D OCT扫描中可用的大量信息进行充分利用。在这项研究中,我们提出了一种深度学习方法,该方法可以使textbf 1充分利用来自ONH的OCT扫描的信息textbf 2描述青光眼ONH的结构表型,并且可以将textbf 3用作可靠的青光眼诊断工具。具体来说,我们的算法确定的结构特征被发现与青光眼的临床观察有关。这些结构特征的诊断准确性为92.0 pm 2.3,在95特异性下的灵敏度为90.0 pm 2.4。通过逐步改变其大小,我们能够揭示出从非青光眼到青光眼的过渡过程中,ONH的形态如何变化。我们认为我们的工作可能对理解青光眼的发病机制具有强烈的临床意义,并且在将来可以改善以预测未来的视力丧失。 |

| Image-Based Jet Analysis Authors Michael Kagan 基于图像的射流分析是建立在射流的射流图像表示之上的,它使高能物理与计算机视觉和深度学习领域之间具有直接联系。通过这种联系,出现了许多新的射流分析技术。在本文中,我们调查了主要基于卷积神经网络的基于喷气图像的分类模型,研究了了解这些模型学到的方法以及它们对不确定性的敏感性的方法,并回顾了将这些模型从现象学研究在LHC的实验中在现实世界中的应用。除了射流分类之外,还讨论了基于射流图像的技术的其他几种应用,包括能量估计,降低堆积噪声,数据生成和异常检测。 |

| Combating Mode Collapse in GAN training: An Empirical Analysis using Hessian Eigenvalues Authors Ricard Durall, Avraam Chatzimichailidis, Peter Labus, Janis Keuper 生成的对抗网络GAN在图像生成中提供了最先进的结果。但是,尽管功能如此强大,但培训仍然非常困难。这尤其是由于其高度非凸的优化空间导致了许多不稳定性。其中,模式崩溃是最令人生畏的模式之一。当模型仅适合少数几种数据分发模式,而忽略了大多数模式时,就会发生此不良事件。在这项工作中,我们使用二阶梯度信息来对抗模式崩溃。为此,我们通过其Hessian特征值分析了损失表面,并表明模式崩溃与朝着锐利极小点的收敛有关。特别是,我们观察到G的特征值如何与模式崩溃的发生直接相关。最后,受这些发现的启发,我们设计了一种新的优化算法,称为轻推的Adam NuGAN,该算法使用光谱信息来克服模式崩溃,从而从经验上得出更稳定的收敛特性。 |

| Kernelized Classification in Deep Networks Authors Sadeep Jayasumana, Srikumar Ramalingam, Sanjiv Kumar 在本文中,我们提出了针对深度网络的内核分类层。尽管常规的深度网络为表示特征学习引入了大量的非线性,但它们几乎普遍在学习的特征向量上使用线性分类器。我们通过在训练过程中使用softmax交叉熵损失函数和在测试过程中使用评分器函数的核技巧来引入非线性分类层。此外,我们研究了可以在该框架中使用的内核函数的选择,并表明可以使用常规的反向传播和梯度下降方法在深度网络内部自动学习针对给定问题的最佳内核函数。为此,我们利用嵌入在n 1维欧几里得空间中的单位n球面上的正定核上的经典数学结果。我们在几个视觉数据集和任务上展示了提出的非线性分类层的有用性。 |

| Learned Block-based Hybrid Image Compression Authors Yaojun Wu, Xin Li, Zhizheng Zhang, Xin Jin, Zhibo Chen 基于神经网络的学习图像压缩由于其在通过非线性变换学习更好的表示方面的优势而取得了巨大的进步。与通常基于块的传统混合编码框架不同,现有的学习图像编解码器通常以全分辨率方式处理图像,因此不支持通过并行性和显式预测进行加速。与学习的图像编解码器相比,传统的混合编码框架通常是手工制作的,缺乏根据异构指标进行优化的适应性。因此,为了收集它们的优良品质并弥补它们的弱点,我们探索了一种基于学习块的混合图像压缩LBHIC框架,该框架在编码性能和效率之间实现了双赢。具体来说,我们将块分区和显式学习预测编码引入学习图像压缩框架。与通过传统编解码器中相邻像素的线性加权进行预测相比,我们的上下文预测模块CPM通过利用条带池提取相邻潜在空间中最相关的信息来更好地捕获远距离相关性。此外,为了减轻阻塞伪影,我们进一步提出了考虑边缘重要性的边界感知后处理模块BPM。大量实验表明,在PSNR和MS SSIM指标方面,所提出的LBHIC编解码器均优于最新的图像压缩方法,并有望节省大量时间。 |

| A new semi-supervised self-training method for lung cancer prediction Authors Kelvin Shak, Mundher Al Shabi, Andrea Liew, Boon Leong Lan, Wai Yee Chan, Kwan Hoong Ng, Maxine Tan 背景与目的肺癌的早期发现至关重要,因为对于处于3期及以上阶段的患者,肺癌的死亡率很高。从计算机断层扫描CT扫描中同时检测和分类结节的方法相对较少。此外,很少有研究将半监督学习用于预测肺癌。这项研究提出了一个完整的端到端方案,该方案使用最先进的“噪声学生”自学训练方法对肺结节进行检测和分类,该方法在大约4,000个CT扫描的综合CT肺部筛查数据集中。 |

| Joint Search of Data Augmentation Policies and Network Architectures Authors Taiga Kashima, Yoshihiro Yamada, Shunta Saito 训练深度神经网络的通用管道包括几个构建块,例如数据增强和网络体系结构选择。 AutoML是一个旨在自动设计这些零件的研究领域,但是大多数方法都是独立地探索每个零件,因为同时搜索所有零件更具挑战性。在本文中,我们提出了一种针对数据扩充策略和网络架构的联合优化方法,以为训练流水线的设计带来更多的自动化。我们方法的核心思想是使整个部分具有差异性。所提出的方法结合了用于扩充策略搜索和网络体系结构搜索的不同方法,以端到端的方式共同优化它们。实验结果表明我们的方法比独立搜索的结果具有竞争性或优越的性能。 |

| A Contrast Synthesized Thalamic Nuclei Segmentation Scheme using Convolutional Neural Networks Authors Lavanya Umapathy, Mahesh Bharath Keerthivasan, Natalie M. Zahr, Ali Bilgin, Manojkumar Saranathan 丘脑核与几种神经系统疾病有关。与传统的MPRAGE图像相比,已显示WMn MPRAGE图像可提供更好的丘脑内核对比度,但额外的采集结果会增加检查时间。在这项工作中,我们研究了基于3D卷积神经网络CNN的技术,用于从常规MPRAGE图像中获取丘脑核。开发了两个3D CNN,并使用MPRAGE图像(自然对比度分割NCS和b使用从MPRAGE图像合成的WMn MPRAGE图像合成的对比度分割SCS)比较丘脑核。我们使用基于多图集的分割技术在WMn MPRAGE图像上生成的MPRAGE图像n 35和丘脑核标记训练了两个分割框架。在包括健康受试者和酒精使用障碍患者AUD n 45的队列中评估了分割的准确性和临床效用。与NCS网络相比,SCS网络在内侧膝状核P .003和中心ome核P .01产生更高的Dice评分,而腹侧前P .001和腹侧后外侧P .01核的体积差异较小。布兰德·奥特曼(Bland Altman)的分析显示,一致的限制更加严格,实际交易量与SCS网络预测的交易量之间的变异系数更低。与健康年龄相匹配的对照组相比,SCS网络显示出AUD患者腹侧后核明显萎缩,P <0.01,与酒精中毒丘脑萎缩的先前研究一致,而NCS网络显示腹侧后核假性萎缩。分割之前基于CNN的对比合成可以从常规MPRAGE图像提供快速准确的丘脑核分割。 |

| On the Limitations of Denoising Strategies as Adversarial Defenses Authors Zhonghan Niu, Zhaoxi Chen, Linyi Li, Yubin Yang, Bo Li, Jinfeng Yi 随着针对机器学习模型的对抗攻击日益引起人们的关注,已经提出了许多基于降噪的防御方法。在本文中,我们通过数据降噪和重构(称为F反F,F IF框架)以对称变换的形式总结和分析防御策略。特别地,我们从三个方面对这些去噪策略进行分类,即分别在空间域,频域和潜在空间中进行去噪。通常,防御是在整个对抗示例中进行的,图像和扰动都被修改,这使得很难说出如何防御扰动。为了直观地评估这些去噪策略的鲁棒性,我们假设已获得所有噪声,则将它们直接应用于防御对抗性噪声本身,这使我们不必牺牲良性准确性。令人惊讶的是,我们的实验结果表明,即使消除了每个维度上的大多数扰动,仍然很难获得令人满意的鲁棒性。基于以上发现和分析,我们提出了针对特征域中不同频段的自适应压缩策略,以提高鲁棒性。我们的实验结果表明,与现有的降噪策略相比,自适应压缩策略可使模型更好地抑制对抗性扰动,并提高鲁棒性。 |

| Clique: Spatiotemporal Object Re-identification at the City Scale Authors Tiantu Xu, Kaiwen Shen, Yang Fu, Humphrey Shi, Felix Xiaozhu Lin 对象重新识别ReID是城市规模摄像机的关键应用。虽然经典的ReID任务通常被视为图像检索,但我们将它们视为对目标对象出现的位置和时间的时空查询。时空reID受到计算机视觉算法的精度限制和城市摄像机的巨大视频的挑战。我们介绍一种实用的ReID引擎Clique,它基于两种新技术1 Clique通过对ReID算法提取的模糊对象特征进行聚类来评估目标出现,每个聚类表示要与输入2进行匹配的独特对象的总体印象,以便在其中搜索视频中,Clique对摄像机进行采样以最大程度地提高时空覆盖范围,并逐步添加摄像机以进行按需处理。通过对来自25个摄像机的25小时视频进行评估,Clique在70个查询中的5个查询中达到了0.87的高召回率,并以830倍的视频实时性运行,以实现高精度。 |

| Simultaneous View and Feature Selection for Collaborative Multi-Robot Recognition Authors Brian Reily, Hao Zhang 协作式多机器人感知可提供环境的多种视图,即使个体机器人的视点较差或障碍物造成遮挡,也可以提供不同的视角来协作理解环境。必须智能地融合这些多个观测值以进行准确识别,并且需要选择相关的观测值,以允许不必要的机器人继续观察其他目标。该研究问题尚未在文献中得到很好的研究。在本文中,我们提出了一种新颖的多机器人协作感知方法,该方法将视图选择,特征选择和对象识别同时集成到统一的规则化优化公式中,该公式使用稀疏性归纳准则来识别具有最具代表性的视图和方式的机器人具有最具区别性的功能由于引入的非光滑范数导致我们的优化公式难以求解,因此我们实现了一种新的迭代优化算法,该算法可确保收敛到最优解。我们在多视图基准数据集,模拟案例研究以及物理多机器人系统上评估我们的方法。实验结果表明,我们的方法能够实现准确的对象识别和有效的视图选择,而这些视图是由互信息定义的。 |

| StarcNet: Machine Learning for Star Cluster Identification Authors Gustavo Perez, Matteo Messa, Daniela Calzetti, Subhransu Maji, Dooseok Jung, Angela Adamo, Mattia Siressi 我们提出了一种机器学习ML管道,以从哈勃太空望远镜获得的观测结果中识别附近星系的多色图像中的星团,这是美国国库计划LEGUS Legacy ExtraGalactic紫外线调查的一部分。 StarcNet STAR聚类分类网络NETwork是一种多尺度卷积神经网络CNN,在LEGUS星系图像中对星团分类的精度达到68.6 4类86.0 2类聚类非聚类。我们通过对训练集中未包含的星系应用预先训练的CNN模型来测试StarcNet的性能,发现其准确性与参考系相似。通过比较StarcNet产生的目录中的多色光度函数和质量年龄图以及人类标记的星光团的亮度,颜色和物理特征分布,我们通过比较人类和ML的星光团的亮度,颜色和物理特征来测试StarcNet预测对推断星团性质的影响分类的样本。 ML方法有两个优点:1分类的可重复性ML算法的偏差是固定的,可以测量以进行后续分析; 2分类的速度对于人类需要数周到数月才能执行的任务需要几分钟。通过达到与人类分类器相当的准确性,StarcNet将能够将分类扩展到比当前可用的更大数量的候选样本,从而显着增加聚类研究的统计数据。 |

| Spatial Context-Aware Self-Attention Model For Multi-Organ Segmentation Authors Hao Tang, Xingwei Liu, Kun Han, Shanlin Sun, Narisu Bai, Xuming Chen, Huang Qian, Yong Liu, Xiaohui Xie 多器官分割是深度学习在医学图像分析中最成功的应用之一。深度卷积神经网络CNN在实现CT或MRI图像的临床可应用图像分割性能方面显示出巨大希望。最新的CNN分割模型在输入图像上应用2D或3D卷积,每种方法都有优缺点2D卷积速度快,内存占用少,但不足以从体积图像中提取3D上下文信息,而相反的情况适用3D卷积。为了使3D CNN模型适合商品GPU上的CT或MRI图像,通常必须对输入图像进行下采样或使用裁剪的局部区域作为输入,这限制了3D模型在多器官分割中的用途。在这项工作中,我们提出了一个将3D和2D模型相结合的新框架,其中通过高分辨率2D卷积实现分割,但要以从低分辨率3D模型中提取的空间上下文信息为指导。我们实现了一种自我关注机制,以控制应使用哪些3D特征来指导2D细分。我们的模型只考虑内存使用情况,但设备齐全,可以考虑3D上下文信息。在多个器官分割数据集上进行的实验表明,通过利用2D和3D模型,我们的方法在器官分割精度上始终优于现有的2D和3D模型,同时能够直接将原始的完整体积图像数据作为输入。 |

| Reduction in the complexity of 1D 1H-NMR spectra by the use of Frequency to Information Transformation Authors Homayoun Valafar, Faramarz Valafar 1H NMR光谱的分析通常会因收集这些光谱时发生的大变化而受阻。这些变化中有一些是较大的溶剂峰和标准峰,基线漂移和由于不正确的定相引起的负峰。此外,某些与仪器有关的变更,例如不正确的匀场,也嵌入到已记录的频谱中。这些信号变化的不可预测的性质使得对这些频谱的自动且独立于仪器的计算机分析变得不可靠。本文提出了一种提取信号信息内容的新方法,即频域1H NMR谱,称为频率信息变换FIT,并将其与以前使用的SPUTNIK方法进行了比较。 FIT可以成功地将相关信息提取到信号中存在的模式匹配任务,同时通过将傅立叶变换后的信号变换为信息频谱IS来丢弃信号的其余部分。该技术表现出减小类别间相关系数而同时增加类别内相关系数的能力。换句话说,同一分子的不同光谱彼此之间的相似度更高,而不同分子的光谱彼此之间的外观看起来相差更大。此功能使使用计算机算法根据分子的光谱特征更容易地自动识别和分析分子。 |

| Transfer Learning Through Weighted Loss Function and Group Normalization for Vessel Segmentation from Retinal Images Authors Abdullah Sarhan, Jon Rokne, Reda Alhajj, Andrew Crichton 血管的血管结构在诊断诸如青光眼和糖尿病性视网膜病的视网膜疾病中很重要。这些血管的正确分割可以帮助检测视网膜对象,例如视盘和视杯,从而确定这些区域是否受损。此外,血管的结构可以帮助诊断青光眼。数字成像和计算机视觉技术的迅速发展增加了开发用于分割视网膜血管的方法的潜力。在本文中,我们提出了一种分割视网膜血管的方法,该方法将深度学习与转移学习一起使用。我们调整了U Net结构,以使用定制的InceptionV3作为编码器,并使用多个跳过连接来形成解码器。此外,我们使用加权损失函数来处理视网膜图像中类别不平衡的问题。此外,我们为此字段贡献了一个新的数据集。我们在六个公开可用的数据集和一个新创建的数据集上测试了我们的方法。我们达到了95.60的平均准确度和80.98的骰子系数。从综合实验获得的结果证明了我们从不同来源获得的视网膜图像中血管分割方法的鲁棒性。与其他方法相比,我们的方法可实现更高的细分精度。 |

| MELINDA: A Multimodal Dataset for Biomedical Experiment Method Classification Authors Te Lin Wu, Shikhar Singh, Sayan Paul, Gully Burns, Nanyun Peng 我们为多峰生物医学方法分类引入了一个新的数据集MELINDA。以全自动的远程监管方式收集数据集,其中标签是从现有的策划数据库中获取的,而实际内容是从与数据库中每个记录相关联的论文中提取的。我们对各种先进的NLP和计算机视觉模型进行基准测试,包括仅将字幕文本或图像作为输入的单峰模型以及多峰模型。大量的实验和分析表明,尽管多峰模型的性能优于单峰模型,但仍需要改进,尤其是在以语言为基础的可视化概念较少监督的方式上,以及向低资源域的更好转移性方面。我们发布了数据集和基准,以促进未来多模式学习的研究,尤其是针对科学领域中的应用激励有针对性的改进。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页