- 使用Jupyter Notebook进行深度学习编程 - 深度学习教程

shandianfk_com

ChatGPTAIjupyter深度学习ide

大家好,今天我们要聊聊如何使用JupyterNotebook进行深度学习编程。深度学习是人工智能领域中的一项重要技术,通过模仿人脑神经网络的方式进行学习和分析。JupyterNotebook作为一个强大的工具,可以帮助我们轻松地进行深度学习编程,尤其适合初学者和研究人员。本文将带领大家一步步了解如何在JupyterNotebook中开展深度学习项目。一、什么是JupyterNotebook?Jup

- 英伟达常用GPU参数速查表,含B300.....

Ai17316391579

深度学习服务器人工智能机器学习服务器电脑计算机视觉深度学习神经网络

英伟达常用GPU参数速查表,收藏备用:含RTX5090、RTX4090D、L40、L20、A100、A800、H100、H800、H20、H200、B200、B300、GB300.....专注于高性能计算人工智能细分领域kyfwq001#5090##4090##英伟达“新核弹”B200发布##英伟达##英伟达B300##GPU##服务器##显卡##英伟达H800/A800芯片将禁售#

- 深度学习 Deep Learning 第8章 深度学习优化

odoo中国

AI编程人工智能深度学习人工智能优化

深度学习第8章深度学习的优化章节概述本章深入探讨了深度学习中的优化技术,旨在解决模型训练过程中面临的各种挑战。优化是深度学习的核心环节,直接关系到模型的训练效率和最终性能。本章首先介绍了优化在深度学习中的特殊性,然后详细讨论了多种优化算法,包括随机梯度下降(SGD)、动量法、Nesterov动量法、AdaGrad、RMSProp和Adam等。此外,还探讨了参数初始化策略、自适应学习率方法以及二阶优

- 景联文科技提供高质量文本标注服务,驱动AI技术发展

景联文科技

科技人工智能

文本标注是指在原始文本数据上添加标签的过程,这些标签可以用来指示特定的实体、关系、事件等信息,以帮助计算机理解和处理这些数据。文本标注是自然语言处理(NLP)领域的一个重要环节,它通过为文本的不同部分提供具体的含义和上下文信息,增强机器学习和深度学习模型对文本内容的理解能力。标注类型情感分析情感极性:确定文本表达的情感倾向,如正面、负面或中立。强度评估:衡量情感的强烈程度,从轻微到极端不等。命名实

- 打造金融数据新引擎,看永洪科技助力头部农信社搭建一站式分析平台

永洪科技

金融数据可视化BI数据分析大数据

在数字化转型的浪潮中,金融行业作为经济发展的核心引擎,正加速探索数字化、智能化的新路径。永洪科技,近日成功助力某省农村信用社联合社(简称:Z企业)完成了其数字化转型的重要一步,通过部署先进的商业智能解决方案,为Z企业的业务升级与效能提升注入了强劲动力。随着智能金融时代的来临,以大数据、人工智能、移动互联等新兴技术为核心的金融科技持续赋能银行金融业务数字化、智能化、开放化的发展,为金融机构营销体系的

- 景联文科技:以高质量数据标注推动人工智能领域创新与发展

景联文科技

科技人工智能数据标注

在当今这个由数据驱动的时代,高质量的数据标注对于推动机器学习、自然语言处理(NLP)、计算机视觉等领域的发展具有不可替代的重要性。数据标注过程涉及对原始数据进行加工,通过标注特定对象的特征来生成能够被机器学习模型识别和使用的编码格式,从而使数据更具有意义和可解读性。数据标注的主要类型包括:图像标注:指在图片中标识出目标物体的位置、形状或类别等信息,如自动驾驶技术中的行人、车辆及交通标志的识别。文本

- 人工智能与网络信息技术的深度融合

鸭鸭鸭进京赶烤

学术会议人工智能AI编程ai机器人计算机视觉网络计算机网络

在当今时代,人工智能(AI)和网络信息技术正以前所未有的速度推动着社会变革。从通用人工智能(AGI)到具身智能的普及,AI不仅实现了技术上的飞跃,也在各个行业展现出巨大的应用潜力。随着技术的不断迭代,我们迎来了许多创新应用,例如AI在电子信息技术中的应用,通过算法优化与升级,显著提高了处理效率和准确性。网络信息技术同样在飞速发展。面向2030年的未来网络发展趋势表明,网络将支撑万亿级、人机物、全时

- 深度学习篇---对角矩阵&矩阵的秩&奇异矩阵

Ronin-Lotus

程序代码篇深度学习篇深度学习矩阵人工智能线性代数

文章目录前言一、对角矩阵(DiagonalMatrix)1.1定义1.2特性行列式运算简化1.3应用领域深度学习信号处理量子力学经济学二、矩阵的秩(RankofaMatrix)2.1定义2.2特性满秩降秩影响2.3应用领域深度学习图像压缩推荐系统控制理论三、奇异矩阵(SingularMatrix)3.1定义3.2特性秩不足行列式为零3.3应用领域深度学习正则化损失函数结构工程统计学数值计算四、跨领

- DeepSeek、Grok 与 ChatGPT 三巨头:技术架构与应用场景的全方位解析

云策量化

Deepseekchatgptdeepseekgrok

前言在当今人工智能领域,DeepSeek、Grok和ChatGPT作为语言模型的三巨头,各自凭借独特的技术架构和广泛的应用场景,在自然语言处理领域占据着重要地位。本文将对这三款模型的技术架构和应用场景进行全方位解析,以期为读者提供深入的了解和有价值的参考。一、技术架构(一)DeepSeekDeepSeek是由DeepSeek团队开发的一款大型语言模型,其技术架构基于深度学习中的Transforme

- 探索AI模型的巅峰之战:ChatGPT、DeepSeek与Grok 3,谁才是最强?

温暖阳光阿斌

人工智能chatgpt

近年来,人工智能领域正处于一场高速迭代的革命中。大型语言模型(LLMs)如ChatGPT、DeepSeek和Grok3纷纷亮相,各展所长,为人们带来了前所未有的体验。在这场"谁是最强"的竞争中,每一方都展现出了令人惊叹的能力和独特的优势。然而,这些模型之间的差异和特点,究竟是什么?它们各自的优势在哪里?又有哪些隐藏的短板?本文将带您深入了解这三位AI巨头的亮点与争议,共同探讨它们在AI领域的位置,

- OpenCV 4.2.0与扩展模块安装与应用指南

土城三富

本文还有配套的精品资源,点击获取简介:OpenCV4.2.0是一个先进的计算机视觉库,包含了图像处理、计算机视觉和机器学习算法。本压缩包包含OpenCV核心库和扩展模块(opencv_contrib),版本均为4.2.0。该版本引入了性能增强、API优化以及对深度学习框架和硬件加速技术的更新支持。扩展模块提供了额外的实验性算法和功能,有助于研究和开发新算法。指南详细介绍了如何安装和配置这些库,并提

- OpenCV ML 模块使用指南

ice_junjun

OpenCVopencv人工智能计算机视觉

一、模块概述OpenCV的ML模块提供了丰富的机器学习算法,可用于解决各种计算机视觉和数据分析问题。本指南将详细介绍该模块中主要的机器学习算法,包括支持向量机(SVM)、K均值聚类(K-Means)和神经网络(ANN),并结合图像分类和聚类分析这两个典型应用场景进行代码实现与解释。二、主要函数及类详解(一)支持向量机(SVM):cv.ml.SVM_create()功能支持向量机(SVM)是一种强大

- 强化学习中策略网络模型设计与优化技巧

数字扫地僧

计算机视觉深度学习

I.引言强化学习(ReinforcementLearning,RL)是一种通过与环境交互,学习如何采取行动以最大化累积奖励的机器学习方法。策略网络(PolicyNetwork)是强化学习中一种重要的模型,它直接输出动作的概率分布或具体的动作。本篇博客将深入探讨策略网络的设计原则、优化技巧,并结合具体实例展示其应用。II.策略网络的基本概念A.策略网络的定义策略网络是一种神经网络,它接受当前状态作为

- 介于YOLOv5的裂缝识别系统

程序员~小强

YOLO

介于YOLOv5的裂缝识别系统在现代工业中,裂缝监测是的保障设施安全的重要环节。我们公司的新项目——基于YOLOv5的裂缝识别系统,将为您提供高效、精准的解决方案,助力各类工程项目的质量管理。系统优势我们的裂缝识别系统借助YOLOv5进行深度学习,经过精心训练,拥有强大的图像识别能力。只需简单的步骤,您就能将复杂的裂缝检测转化为轻松的操作,让分析变得更加简单、高效。核心功能图片上传与场景选择用户可

- 使用DeepSeek R1大模型编写迅投 QMT 的量化交易 Python 代码

wtsolutions

qmt量化交易pythonqmtdeepseek量化交易代码生成

随着人工智能技术的迅猛发展,利用AI工具提升工作效率已成为现代开发者的重要手段。在使用deepseek官方网页生成迅投QMT代码的时候,deepseek给出的代码是xtquant代码,也就是miniqmt代码,并不是我们传统意义上说的大QMT可用的代码。因此,我们需要自建一个知识库,让deepseek根据我的知识库里面的知识,去帮我生成大QMT可用的交易代码。一、建立迅投QMT的知识库建立迅投QM

- GPU架构分类

大明者省

架构

一、NVIDIA的GPU架构NVIDIA是全球领先的GPU生产商,其GPU架构在图形渲染、高性能计算和人工智能等领域具有广泛应用。NVIDIA的GPU架构经历了多次迭代,以下是一些重要的架构:1.Tesla(特斯拉)架构(2006年发布)特点:NVIDIA推出的首个通用GPU计算架构,支持使用C语言进行GPU编程,标志着GPU开始从专用图形处理器转变为通用数据并行处理器。性能:具有128个流处理器

- 芯片的未来发展趋势

iccnewer

2024年,该行业将专注于AI/ML、RISC-V、量子、安全等发展趋势。今年年初,大多数人从未听说过生成式人工智能。现在整个世界都在竞相利用它,而这仅仅是个开始。量子计算、6G、智能基础设施等新市场领域专用处理正在加速对更快、更高效、更多数据的需求。与每隔几年等待下一个工艺节点的日子相比,未来几年的事件将与电话或汽车的引入一样重要。但可能不会只有一种创新技术,将会有很多技术一起以一种将让科技界惊

- Python程序设计(入门)

xyyykx

python开发语言

目录一丶Python概述二丶Python数据类型三丶常用的进制四丶字符串型五丶程序控制结构六丶组合数据类型一丶Python概述Python是一种高级编程语言,由GuidovanRossum于1991年开发并发布。它具有简洁、易读、易学的语法特点,被广泛应用于多个领域,包括软件开发、数据科学、人工智能、网络编程等。以下是Python的一些主要特点和优势:简单易学:Python的语法简洁明了,易于理解

- LLM:软件测试的颠覆性力量

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型AI大模型企业级应用开发实战计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

LLM:软件测试的颠覆性力量关键词:大语言模型(LLM)、软件测试、人工智能、测试自动化、测试效率、质量保证、测试革新1.背景介绍在当今快速发展的软件行业中,测试一直是确保产品质量的关键环节。随着人工智能技术的飞速进步,特别是大语言模型(LargeLanguageModels,简称LLM)的出现,软件测试领域正经历着前所未有的变革。LLM凭借其强大的自然语言处理能力和广泛的知识储备,正在重塑我们对

- 卷积神经网络Batch Normalization的作用

arron8899

cnnbatch人工智能

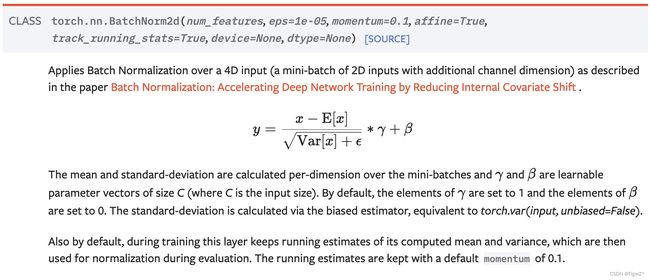

BatchNormalization的作用(通俗版)1.像“稳定器”一样校准每层输入想象你在烤多层蛋糕,每层蛋糕的烘烤温度不同(相当于神经网络的每一层数据分布不同)。没有BN时,烤箱温度忽高忽低,导致有的层烤焦(梯度爆炸),有的层不熟(梯度消失)。BN的作用相当于给每一层装了一个自动温度调节器,实时将输入数据调整到标准温度(均值为0,方差为1),保证每层都能均匀受热,训练更稳定。2.让模型训练“少

- 使用Dall-E生成图像:文本到图像的魔力

shuoac

计算机视觉人工智能python

使用Dall-E生成图像:文本到图像的魔力技术背景介绍Dall-E是OpenAI开发的一个强大的文本到图像生成模型,它能够根据自然语言描述创造出全新的数字图像。这一技术基于深度学习的方法,使得创意与AI图像生成的结合更具可能性。本文将介绍如何调用Dall-EAPI来生成图像,从而使开发者能够将这一技术应用到自己的项目中。核心原理解析Dall-E利用大型语言模型(LLM)从用户提供的文本描述中提取详

- 深入了解盘古大模型:技术、应用与未来

Hardess-god

Literaturereview人工智能

随着人工智能技术的迅猛发展,预训练大模型已成为AI领域最前沿、最热门的研究方向之一。近年来,中国自主研发的大模型之一——盘古模型(PanGuModel)逐渐进入公众视野,凭借其强大的性能和广泛的应用前景,引发了行业内外的广泛关注。什么是盘古大模型?盘古大模型是华为公司联合多家科研机构共同研发的超大规模预训练语言模型。该模型以中文数据为主进行训练,旨在推动中文自然语言处理(NLP)以及跨模态应用的技

- 【深度学习|地学应用】滑坡灾害早期隐患的概念、特征及识别方法,同时解释其与人工边坡、滑坡易发性之间的联系与区别。

985小水博一枚呀

深度学习人工智能

【深度学习|地学应用】滑坡灾害早期隐患的概念、特征及识别方法,同时解释其与人工边坡、滑坡易发性之间的联系与区别。【深度学习|地学应用】滑坡灾害早期隐患的概念、特征及识别方法,同时解释其与人工边坡、滑坡易发性之间的联系与区别。文章目录【深度学习|地学应用】滑坡灾害早期隐患的概念、特征及识别方法,同时解释其与人工边坡、滑坡易发性之间的联系与区别。1.滑坡灾害早期隐患的概念与特征概念主要特征2.通过光学

- 【人工智能之大模型】阐述生成式语言模型的工作机理...(二)

985小水博一枚呀

大大大模型知识点人工智能语言模型自然语言处理机器学习神经网络

【人工智能之大模型】阐述生成式语言模型的工作机理…(二)【人工智能之大模型】阐述生成式语言模型的工作机理…(二)文章目录【人工智能之大模型】阐述生成式语言模型的工作机理...(二)前言4.代码逐行解释TransformerBlock类初始化前向传播GenerativeLM类初始化前向传播推理示例测试生成5.总结欢迎宝子们点赞、关注、收藏!欢迎宝子们批评指正!祝所有的硕博生都能遇到好的导师!好的审稿

- 人工智能 - 通用 AI Agent 之 LangManus、Manus、OpenManus 和 OWL 技术选型

天机️灵韵

具身智能人工智能人工智能具身智能智能体

一、核心项目概览1.Manus(闭源通用AIAgent)定位:全球首个全流程自动化通用AIAgent,GAIA基准测试SOTA水平。核心能力:全流程自动化:从任务规划(如撰写报告)到执行(代码生成、表格制作)的端到端处理。智能纠错机制:基于沙箱环境的实时错误反思与调整(类似CodeAct技术)。云端依赖:需联网运行,集成浏览器操作、信息检索等工具。局限性:闭源且采用邀请制,二手市场邀请码溢价至数万

- 一切皆是映射:实现神经网络的硬件加速技术:GPU、ASIC(专用集成电路)和FPGA(现场可编程门阵列)

AI天才研究院

AI大模型企业级应用开发实战DeepSeekR1&大数据AI人工智能大模型计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

文章目录一切皆是映射:实现神经网络的硬件加速技术:GPU、ASIC(专用集成电路)和FPGA(现场可编程门阵列)1.背景介绍2.核心概念与联系3.核心算法原理&具体操作步骤3.1算法原理概述3.2算法步骤详解3.2.1GPU加速3.2.2ASIC加速3.2.3FPGA加速3.3算法优缺点GPUASICFPGA3.4算法应用领域4.数学模型和公式&详细讲解&举例说明4.1数学模型构建4.2公式推导过

- 知识图谱中NLP新技术

魔王阿卡纳兹

知识图谱入门大数据治理与分析知识图谱自然语言处理人工智能

知识图谱与自然语言处理(NLP)的结合是当前人工智能领域的前沿方向,其技术发展呈现多维度融合与场景深化的特点。以下从核心技术突破、应用场景创新及未来趋势三个层面,系统梳理知识图谱中NLP的最新进展:一、核心技术突破基于预训练模型的图谱构建与增强预训练语言模型与知识嵌入融合:以BERT、KEPLER为代表的模型通过联合优化知识嵌入(KE)和语言建模目标,将知识图谱中的结构化知识融入预训练过程,显著提

- 掌握ChatGPT写代码的秘诀:开发者的完整指南

酷酷的崽798

机器学习chatgpt

文章目录前言:如何利用ChatGPT来写代码:一个深度指南1.ChatGPT的基本功能概述2.利用ChatGPT辅助代码编写的好处3.ChatGPT支持的编程语言4.如何向ChatGPT提问以获取最佳结果5.实际应用案例6.ChatGPT的局限性及其解决方法7.关于隐私和安全性的注意事项8.未来展望结论前言:如何利用ChatGPT来写代码:一个深度指南近年来,人工智能技术取得了飞跃性的进展,尤其是

- 给普通人看的深度学习说明书:用快递系统理解AI如何思考

嵌入式Jerry

PythonAI人工智能深度学习

第一章:理解AI的思维方式(快递版)1.1快递分拣站的故事假设你管理一个快递分拣站:传统方法:手动制定规则(比如根据邮编分拣)机器学习:观察老员工的分拣记录,总结规律深度学习:搭建自动分拣流水线,自主发现隐藏规则1.2神经网络就像智能分拣机传送带(输入层):接收包裹信息(图片像素/文字等)#就像扫描快递单input_data=[0.2,0.7,0.1]#归一化后的特征数据分拣工人(隐藏层):每个工

- 使用PyTorch搭建Transformer神经网络:入门篇

DASA13

pytorchtransformer神经网络

1.简介Transformer是一种强大的神经网络架构,在自然语言处理等多个领域取得了巨大成功。本教程将指导您使用PyTorch框架从头开始构建一个Transformer模型。我们将逐步解释每个组件,并提供详细的代码实现。2.环境设置首先,确保您的系统中已安装Python(推荐3.7+版本)。然后,安装PyTorch和其他必要的库:pipinstalltorchnumpymatplotlib3.P

- 辗转相处求最大公约数

沐刃青蛟

C++漏洞

无言面对”江东父老“了,接触编程一年了,今天发现还不会辗转相除法求最大公约数。惭愧惭愧!

为此,总结一下以方便日后忘了好查找。

1.输入要比较的两个数a,b

忽略:2.比较大小(因为后面要的是大的数对小的数做%操作)

3.辗转相除(用循环不停的取余,如a%b,直至b=0)

4.最后的a为两数的最大公约数

&

- F5负载均衡会话保持技术及原理技术白皮书

bijian1013

F5负载均衡

一.什么是会话保持? 在大多数电子商务的应用系统或者需要进行用户身份认证的在线系统中,一个客户与服务器经常经过好几次的交互过程才能完成一笔交易或者是一个请求的完成。由于这几次交互过程是密切相关的,服务器在进行这些交互过程的某一个交互步骤时,往往需要了解上一次交互过程的处理结果,或者上几步的交互过程结果,服务器进行下

- Object.equals方法:重载还是覆盖

Cwind

javagenericsoverrideoverload

本文译自StackOverflow上对此问题的讨论。

原问题链接

在阅读Joshua Bloch的《Effective Java(第二版)》第8条“覆盖equals时请遵守通用约定”时对如下论述有疑问:

“不要将equals声明中的Object对象替换为其他的类型。程序员编写出下面这样的equals方法并不鲜见,这会使程序员花上数个小时都搞不清它为什么不能正常工作:”

pu

- 初始线程

15700786134

暑假学习的第一课是讲线程,任务是是界面上的一条线运动起来。

既然是在界面上,那必定得先有一个界面,所以第一步就是,自己的类继承JAVA中的JFrame,在新建的类中写一个界面,代码如下:

public class ShapeFr

- Linux的tcpdump

被触发

tcpdump

用简单的话来定义tcpdump,就是:dump the traffic on a network,根据使用者的定义对网络上的数据包进行截获的包分析工具。 tcpdump可以将网络中传送的数据包的“头”完全截获下来提供分析。它支 持针对网络层、协议、主机、网络或端口的过滤,并提供and、or、not等逻辑语句来帮助你去掉无用的信息。

实用命令实例

默认启动

tcpdump

普通情况下,直

- 安卓程序listview优化后还是卡顿

肆无忌惮_

ListView

最近用eclipse开发一个安卓app,listview使用baseadapter,里面有一个ImageView和两个TextView。使用了Holder内部类进行优化了还是很卡顿。后来发现是图片资源的问题。把一张分辨率高的图片放在了drawable-mdpi文件夹下,当我在每个item中显示,他都要进行缩放,导致很卡顿。解决办法是把这个高分辨率图片放到drawable-xxhdpi下。

&nb

- 扩展easyUI tab控件,添加加载遮罩效果

知了ing

jquery

(function () {

$.extend($.fn.tabs.methods, {

//显示遮罩

loading: function (jq, msg) {

return jq.each(function () {

var panel = $(this).tabs(&

- gradle上传jar到nexus

矮蛋蛋

gradle

原文地址:

https://docs.gradle.org/current/userguide/maven_plugin.html

configurations {

deployerJars

}

dependencies {

deployerJars "org.apache.maven.wagon

- 千万条数据外网导入数据库的解决方案。

alleni123

sqlmysql

从某网上爬了数千万的数据,存在文本中。

然后要导入mysql数据库。

悲剧的是数据库和我存数据的服务器不在一个内网里面。。

ping了一下, 19ms的延迟。

于是下面的代码是没用的。

ps = con.prepareStatement(sql);

ps.setString(1, info.getYear())............;

ps.exec

- JAVA IO InputStreamReader和OutputStreamReader

百合不是茶

JAVA.io操作 字符流

这是第三篇关于java.io的文章了,从开始对io的不了解-->熟悉--->模糊,是这几天来对文件操作中最大的感受,本来自己认为的熟悉了的,刚刚在回想起前面学的好像又不是很清晰了,模糊对我现在或许是最好的鼓励 我会更加的去学 加油!:

JAVA的API提供了另外一种数据保存途径,使用字符流来保存的,字符流只能保存字符形式的流

字节流和字符的难点:a,怎么将读到的数据

- MO、MT解读

bijian1013

GSM

MO= Mobile originate,上行,即用户上发给SP的信息。MT= Mobile Terminate,下行,即SP端下发给用户的信息;

上行:mo提交短信到短信中心下行:mt短信中心向特定的用户转发短信,你的短信是这样的,你所提交的短信,投递的地址是短信中心。短信中心收到你的短信后,存储转发,转发的时候就会根据你填写的接收方号码寻找路由,下发。在彩信领域是一样的道理。下行业务:由SP

- 五个JavaScript基础问题

bijian1013

JavaScriptcallapplythisHoisting

下面是五个关于前端相关的基础问题,但却很能体现JavaScript的基本功底。

问题1:Scope作用范围

考虑下面的代码:

(function() {

var a = b = 5;

})();

console.log(b);

什么会被打印在控制台上?

回答:

上面的代码会打印 5。

&nbs

- 【Thrift二】Thrift Hello World

bit1129

Hello world

本篇,不考虑细节问题和为什么,先照葫芦画瓢写一个Thrift版本的Hello World,了解Thrift RPC服务开发的基本流程

1. 在Intellij中创建一个Maven模块,加入对Thrift的依赖,同时还要加上slf4j依赖,如果不加slf4j依赖,在后面启动Thrift Server时会报错

<dependency>

- 【Avro一】Avro入门

bit1129

入门

本文的目的主要是总结下基于Avro Schema代码生成,然后进行序列化和反序列化开发的基本流程。需要指出的是,Avro并不要求一定得根据Schema文件生成代码,这对于动态类型语言很有用。

1. 添加Maven依赖

<?xml version="1.0" encoding="UTF-8"?>

<proj

- 安装nginx+ngx_lua支持WAF防护功能

ronin47

需要的软件:LuaJIT-2.0.0.tar.gz nginx-1.4.4.tar.gz &nb

- java-5.查找最小的K个元素-使用最大堆

bylijinnan

java

import java.util.Arrays;

import java.util.Random;

public class MinKElement {

/**

* 5.最小的K个元素

* I would like to use MaxHeap.

* using QuickSort is also OK

*/

public static void

- TCP的TIME-WAIT

bylijinnan

socket

原文连接:

http://vincent.bernat.im/en/blog/2014-tcp-time-wait-state-linux.html

以下为对原文的阅读笔记

说明:

主动关闭的一方称为local end,被动关闭的一方称为remote end

本地IP、本地端口、远端IP、远端端口这一“四元组”称为quadruplet,也称为socket

1、TIME_WA

- jquery ajax 序列化表单

coder_xpf

Jquery ajax 序列化

checkbox 如果不设定值,默认选中值为on;设定值之后,选中则为设定的值

<input type="checkbox" name="favor" id="favor" checked="checked"/>

$("#favor&quo

- Apache集群乱码和最高并发控制

cuisuqiang

apachetomcat并发集群乱码

都知道如果使用Http访问,那么在Connector中增加URIEncoding即可,其实使用AJP时也一样,增加useBodyEncodingForURI和URIEncoding即可。

最大连接数也是一样的,增加maxThreads属性即可,如下,配置如下:

<Connector maxThreads="300" port="8019" prot

- websocket

dalan_123

websocket

一、低延迟的客户端-服务器 和 服务器-客户端的连接

很多时候所谓的http的请求、响应的模式,都是客户端加载一个网页,直到用户在进行下一次点击的时候,什么都不会发生。并且所有的http的通信都是客户端控制的,这时候就需要用户的互动或定期轮训的,以便从服务器端加载新的数据。

通常采用的技术比如推送和comet(使用http长连接、无需安装浏览器安装插件的两种方式:基于ajax的长

- 菜鸟分析网络执法官

dcj3sjt126com

网络

最近在论坛上看到很多贴子在讨论网络执法官的问题。菜鸟我正好知道这回事情.人道"人之患好为人师" 手里忍不住,就写点东西吧. 我也很忙.又没有MM,又没有MONEY....晕倒有点跑题.

OK,闲话少说,切如正题. 要了解网络执法官的原理. 就要先了解局域网的通信的原理.

前面我们看到了.在以太网上传输的都是具有以太网头的数据包.

- Android相对布局属性全集

dcj3sjt126com

android

RelativeLayout布局android:layout_marginTop="25dip" //顶部距离android:gravity="left" //空间布局位置android:layout_marginLeft="15dip //距离左边距

// 相对于给定ID控件android:layout_above 将该控件的底部置于给定ID的

- Tomcat内存设置详解

eksliang

jvmtomcattomcat内存设置

Java内存溢出详解

一、常见的Java内存溢出有以下三种:

1. java.lang.OutOfMemoryError: Java heap space ----JVM Heap(堆)溢出JVM在启动的时候会自动设置JVM Heap的值,其初始空间(即-Xms)是物理内存的1/64,最大空间(-Xmx)不可超过物理内存。

可以利用JVM提

- Java6 JVM参数选项

greatwqs

javaHotSpotjvmjvm参数JVM Options

Java 6 JVM参数选项大全(中文版)

作者:Ken Wu

Email:

[email protected]

转载本文档请注明原文链接 http://kenwublog.com/docs/java6-jvm-options-chinese-edition.htm!

本文是基于最新的SUN官方文档Java SE 6 Hotspot VM Opt

- weblogic创建JMC

i5land

weblogicjms

进入 weblogic控制太

1.创建持久化存储

--Services--Persistant Stores--new--Create FileStores--name随便起--target默认--Directory写入在本机建立的文件夹的路径--ok

2.创建JMS服务器

--Services--Messaging--JMS Servers--new--name随便起--Pers

- 基于 DHT 网络的磁力链接和BT种子的搜索引擎架构

justjavac

DHT

上周开发了一个磁力链接和 BT 种子的搜索引擎 {Magnet & Torrent},本文简单介绍一下主要的系统功能和用到的技术。

系统包括几个独立的部分:

使用 Python 的 Scrapy 框架开发的网络爬虫,用来爬取磁力链接和种子;

使用 PHP CI 框架开发的简易网站;

搜索引擎目前直接使用的 MySQL,将来可以考虑使

- sql添加、删除表中的列

macroli

sql

添加没有默认值:alter table Test add BazaarType char(1)

有默认值的添加列:alter table Test add BazaarType char(1) default(0)

删除没有默认值的列:alter table Test drop COLUMN BazaarType

删除有默认值的列:先删除约束(默认值)alter table Test DRO

- PHP中二维数组的排序方法

abc123456789cba

排序二维数组PHP

<?php/*** @package BugFree* @version $Id: FunctionsMain.inc.php,v 1.32 2005/09/24 11:38:37 wwccss Exp $*** Sort an two-dimension array by some level

- hive优化之------控制hive任务中的map数和reduce数

superlxw1234

hivehive优化

一、 控制hive任务中的map数: 1. 通常情况下,作业会通过input的目录产生一个或者多个map任务。 主要的决定因素有: input的文件总个数,input的文件大小,集群设置的文件块大小(目前为128M, 可在hive中通过set dfs.block.size;命令查看到,该参数不能自定义修改);2.

- Spring Boot 1.2.4 发布

wiselyman

spring boot

Spring Boot 1.2.4已于6.4日发布,repo.spring.io and Maven Central可以下载(推荐使用maven或者gradle构建下载)。

这是一个维护版本,包含了一些修复small number of fixes,建议所有的用户升级。

Spring Boot 1.3的第一个里程碑版本将在几天后发布,包含许多